1.算法描述

1.1全卷积神经网络

全卷积神经网络(Fully Convolutional Networks,FCN)是Jonathan Long等人于2015年在Fully Convolutional Networks for Semantic Segmentation一文中提出的用于图像语义分割的一种框架,是深度学习用于语义分割领域的开山之作。我们知道,对于一个各层参数结构都设计好的神经网络来说,输入的图片大小是要求固定的,比如AlexNet,VGGNet, GoogleNet等网络,都要求输入固定大小的图片才能正常工作。而 F C N 的 精 髓 就 是 让 一 个 已 经 设 计 好 的 网 络 可 以 输 入 任 意 大 小 的 图 片 \color{blue}{而FCN的精髓就是让一个已经设计好的网络可以输入任意大小的图片}而FCN的精髓就是让一个已经设计好的网络可以输入任意大小的图片。

FCN网络结构主要分为两个部分:全卷积部分和反卷积部分。其中全卷积部分为一些经典的CNN网络(如VGG,ResNet等),用于提取特征;反卷积部分则是通过上采样得到原尺寸的语义分割图像。FCN的输入可以为任意尺寸的彩色图像,输出与输入尺寸相同,通道数为n(目标类别数)+1(背景)。

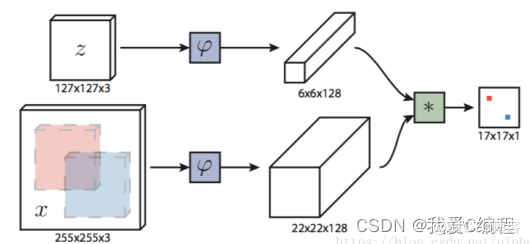

SiameseFC网络如下所示:

Siamese RPN网络如下所示:

考虑多尺度目标检测方法,最后Siamese FPN的主要是用来修正FC网络尺度变化的性能差的问题,在目标发生交叉的时候,通过多层次多尺度上的检测,可以根据目标的细节差异性来解决相似目标交叉带来的错误跟踪问题。

1.2kalman滤波

卡尔曼滤波(Kalman filtering)是一种利用线性系统状态方程,通过系统输入输出观测数据,对系统状态进行最优估计的算法。由于观测数据中包括系统中的噪声和干扰的影响,所以最优估计也可看作是滤波过程。数据滤波是去除噪声还原真实数据的一种数据处理技术,Kalman滤波在测量方差已知的情况下能够从一系列存在测量噪声的数据中,估计动态系统的状态。由于它便于计算机编程实现,并能够对现场采集的数据进行实时的更新和处理,Kalman滤波是目前应用最为广泛的滤波方法,在通信,导航,制导与控制等多领域得到了较好的应用。

1.3matconvnet-1.0-beta20工具箱

MatConvNet是实现用于计算机视觉领域的卷积神经网络(CNN)的MATLAB工具箱。自从取得突破性工作以来,CNN在计算机视觉领域有一个重大影响,特别是图像理解,基本上取代了传统图像表示。有许多其他机器学习、深度学习和CNN开源库的存在。一些最受欢迎的:CudaConvNet ,Torch, Theano,Caffe等。MatConvNet通过深入集成在MATLAB环境中实现了这一点,该环境是计算机视觉研究中最流行的开发环境之一,和其他许多领域一样。特别是,MatConvNet公开了简单的MATLAB命令CNN构建块,如卷积,规范化和池化;这些可以随后进行组合和扩展,轻松创建CNN结构。尽管许多这样的模块使用了用C ++和CUDA编写的优化的CPU和GPU实现(1.4节),但对GPU计算的MATLAB原生支持意味着通常可以在MATLAB中直接编写新模块,同时保持计算效率。与使用低级语言编写新的CNN组件相比,这是一个重要的简化,可以显着加速测试新想法。使用MATLAB还提供了一个通往其他领域的桥梁;例如,MatConvNet最近被亚利桑那大学用于行星科学,正如本NVIDIA博客文章所总结的那样。

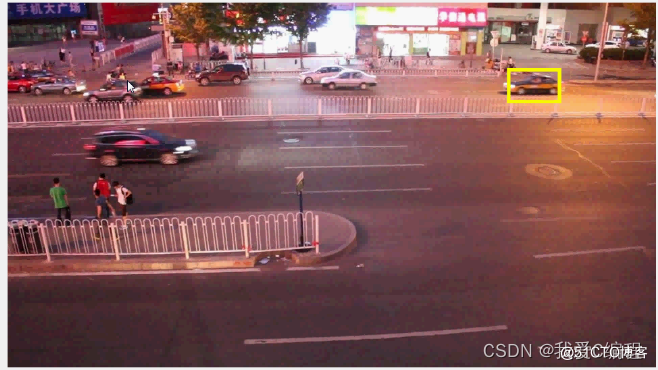

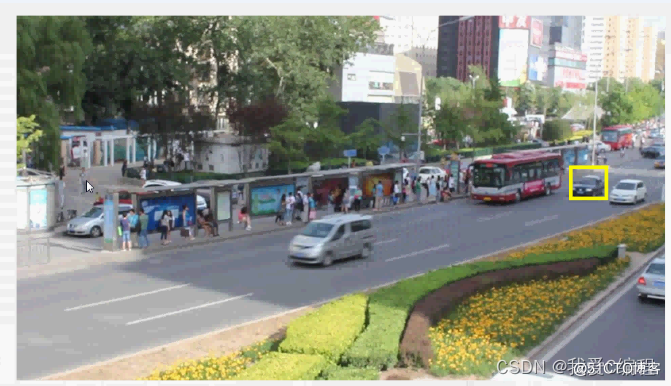

2.仿真效果预览

版本组合:Matlab R2015b+CUDA7.5+vs2013

3.MATLAB核心程序

%卡尔曼滤波参数

% R =[[0.2845,0.0045]',[0.0045,0.0455]'];

% R2 = R;

% H =[[1,0]',[0,1]',[0,0]',[0,0]'];

% Q =0.01*eye(4);

% Q2 = Q;

% P = 100*eye(4);

% P2 = P;

% dt =1/18;

% A =[[1,0,0,0]',[0,1,0,0]',[dt,0,1,0]',[0,dt,0,1]'];

rectPosition = [targetPosition([2,1]) - targetSize([2,1])/2, targetSize([2,1])];

data0 = [rectPosition(1);rectPosition(2)];

kalman_state = 0;

dist=0;

X0_new=rectPosition(1);

Y0_new=rectPosition(2);

kalman_start=0;

kalman_start2=0;

kalman_start3=0;

C=960;

R=540;

rc=R/C;

Virx2_=0;

Viry2_=0;

%初始变量大小

S0 = rectPosition(3)*rectPosition(4);

S1 = R*C;

div= S0/S1;

div2=1;

speed=0;

flag = 0;

bw=110;

for i = startFrame:nImgs

if i>startFrame

% load new frame on GPU

im = gpuArray(single(imgFiles{i}));

bw = mean2(mean(double(im)));

% if grayscale repeat one channel to match filters size

if(size(im, 3)==1)

im = repmat(im, [1 1 3]);

end

scaledInstance = s_x .* scales;

scaledTarget = [targetSize(1) .* scales; targetSize(2) .* scales];

% extract scaled crops for search region x at previous target position

x_crops = make_scale_pyramid(im, targetPosition, scaledInstance, p.instanceSize, avgChans, stats, p);

% evaluate the offline-trained network for exemplar x features

[newTargetPosition, newScale] = tracker_eval(net_x, round(s_x), scoreId, z_features, x_crops, targetPosition, window, p);

targetPosition = gather(newTargetPosition);

% scale damping and saturation

s_x = max(min_s_x, min(max_s_x, (1-p.scaleLR)*s_x + p.scaleLR*scaledInstance(newScale)));

targetSize = (1-p.scaleLR)*targetSize + p.scaleLR*[scaledTarget(1,newScale) scaledTarget(2,newScale)];

%分析黄色方框内的图像信息

x0 = round(rectPosition(1));

y0 = round(rectPosition(2));

w = round(rectPosition(3));

h = round(rectPosition(4));

imsub{i} = imgFiles{i}(max(y0,1):min(y0+h,R),max(x0,1):min(x0+w,C),:);

else

% at the first frame output position and size passed as input (ground truth)

end

rectPosition = [targetPosition([2,1]) - targetSize([2,1])/2, targetSize([2,1])];

if i == 1

div0 = targetSize(1)*targetSize(2);

else

div = sqrt(targetSize(1)*targetSize(2)/div0); %放大倍数,用来修正预测速度和坐标

end

%计算跟踪目标的几何中心位置

Xcenter(i) = rectPosition(1);

Ycenter(i) = rectPosition(2);

if i > 1

dist = sqrt((Xcenter(i)-Xcenter(i-1))^2 + (Ycenter(i)-Ycenter(i-1))^2);

if kalman_start == 0

Virx2(i) = dist;

else

Virx2_ = mean(Virx2);

end

end

if i > 1

dist = sqrt((Xcenter(i)-Xcenter(i-1))^2 + (Ycenter(i)-Ycenter(i-1))^2);

dist2(i)= dist;

end

%遮挡判决条件,进行改进,取消原来距离的判决,改为距离和目标大小收缩参数结合的判决方式。

...............................................................................

%状态切换

if i<=10;%前十帧强制进行训练,作为卡尔曼的输入,不管有没有遮挡,否则效果会变差

X1(i) = rectPosition(1);

Y1(i) = rectPosition(2);

Tt(i) = i;

rectPosition(1:2) = [Xcenter(i);Ycenter(i)];

W = rectPosition(3);

H = rectPosition(4);

end

if i>10;%大于10的时候,进行遮挡判决,没遮挡的时候,继续输入卡尔曼作为训练数据

if kalman_start == 1

[Xnew(i),Xnew2(i)] = func_kalman_predict([X1],Tt,1);

[Ynew(i),Ynew2(i)] = func_kalman_predict([Y1],Tt,1);

%启动卡尔曼滤波进行预测估计

rectPosition(1:2) = [Xnew(i);Ynew(i)];

rectPosition(3:4) = [W;H];

%记忆特性保存间隔

X1=[X1(1:end),rectPosition(1)];

Y1=[Y1(1:end),rectPosition(2)];

Tt(i) = i;

else

X1(i) = rectPosition(1);

Y1(i) = rectPosition(2);

Tt(i) = i;

rectPosition(1:2) = [X1(i);Y1(i)];

W = rectPosition(3);

H = rectPosition(4);

end

end