Squeeze-and-Excitation Networks

* Authors: [[Jie Hu]], [[Li Shen]], [[Samuel Albanie]], [[Gang Sun]], [[Enhua Wu]]

初读印象

comment:: (SENet)以前的工作都是在提高CNN的空间编码能力。这篇论文提出了“Squeeze-and-Excitation”块,研究通道之间的关系。

Why

- 以前的工作都是依赖卷积层融合感受野内的空间和各通道的信息

- 在网络中加入更多可学习层

- VGG,ResNet(1×1卷积、BN),Highway networks。

- 改变各层网络的连接关系。

- 更改网络的计算函数(多尺度信息融合、空间变换)

- 搜索网络架构

- 注意力和门控机制

- 在网络中加入更多可学习层

卷积虽然也关注了通道间的相关性,但是这种相关性是和局部的空间信息相关性是混合在一起的,是局部和隐含的。

What

提出“Squeeze-and-Excitation”块,显式建模其卷积特征的信道之间的相互依赖性来提高网络产生的表示质量。

###How

###How

-

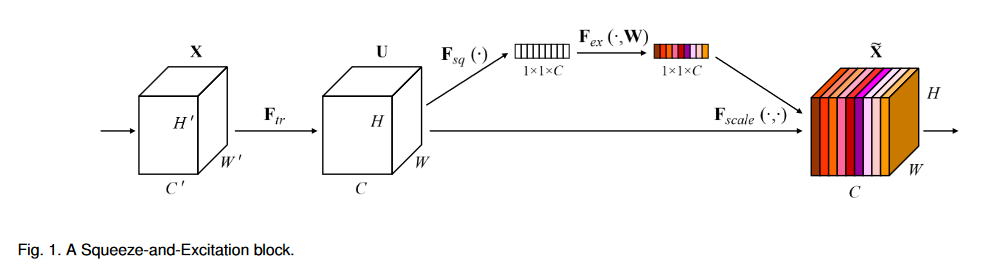

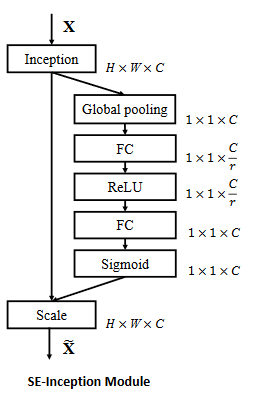

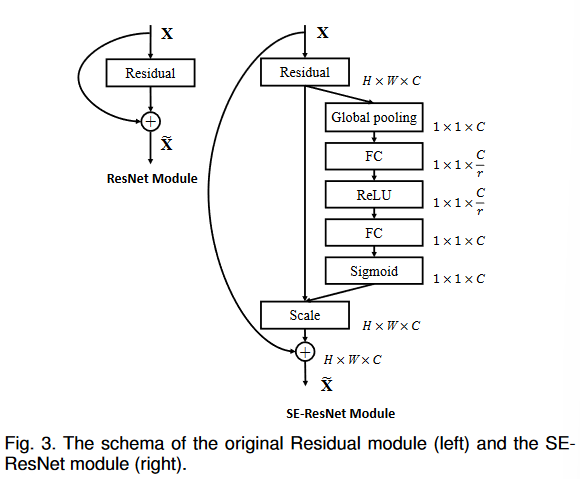

Squeeze-and-Excitation block

- \(X\)为网络输入;\(F_{tr}\)是任意变换操作,如卷积;\(U\)是被操作的特征图

- 挤压(squeeze): 对每个通道做全局平均池化

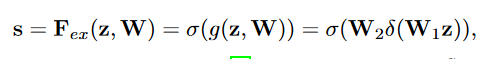

- 激发(excitation)

-

\(\delta\)是ReLU;\(W_1\)是\(\frac{C}{r}\)行\(C\)列矩阵,\(W_2\)是\(C\)行\(\frac{C}{r}\)列矩阵,它们是两个全连接层的参数;z是挤压的结果,为C行1列。得到scaler--\(s\)

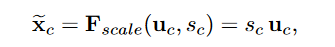

-

\(s\)中的每个数对应每个通道的乘数:

有残差的SENet

有残差的SENet

-

Experiment

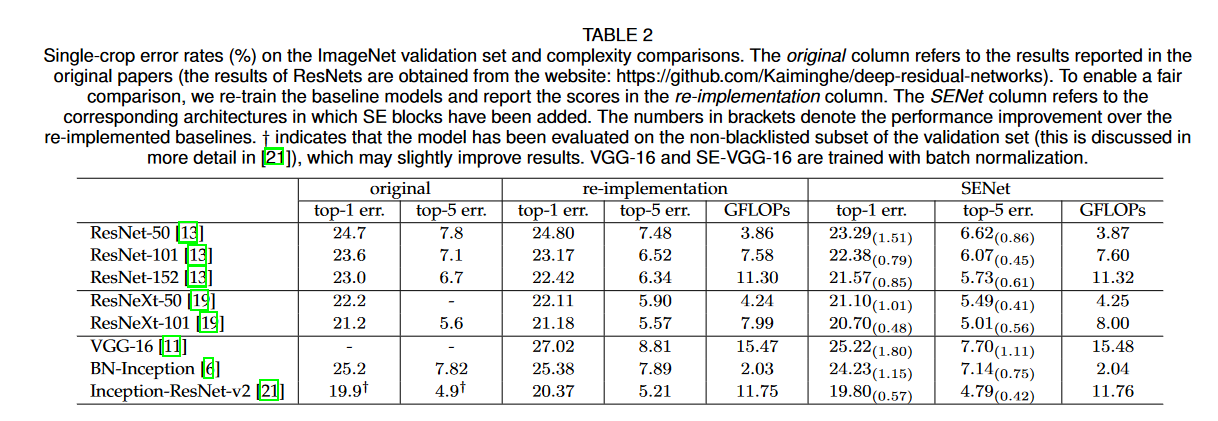

准确率和计算量对比:增加了SEblock的网络,准确度提升很大,相对的计算复杂度和参数!量增加不多

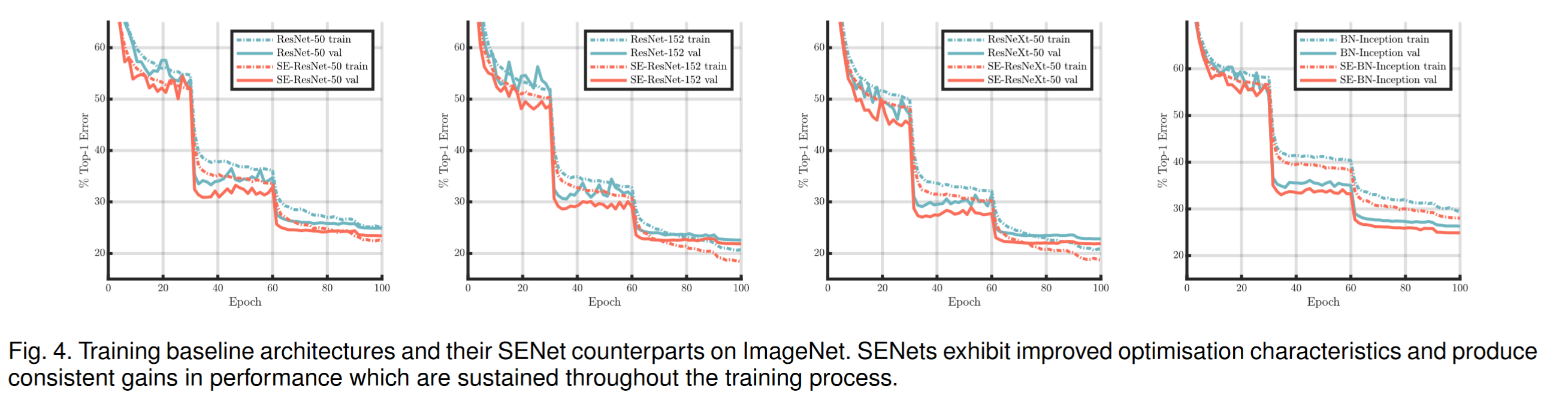

加入SEBlock能让模型更快收敛

加入SEBlock能让模型更快收敛

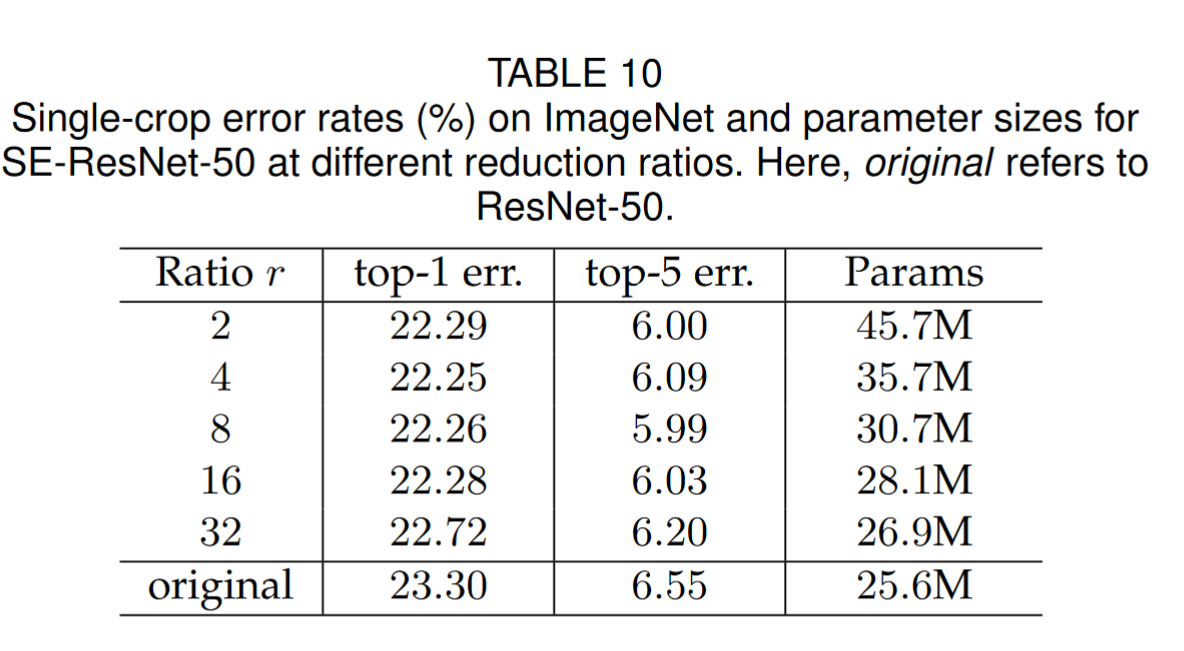

不同的压缩比例r:压缩比例对准确率的影响比较小

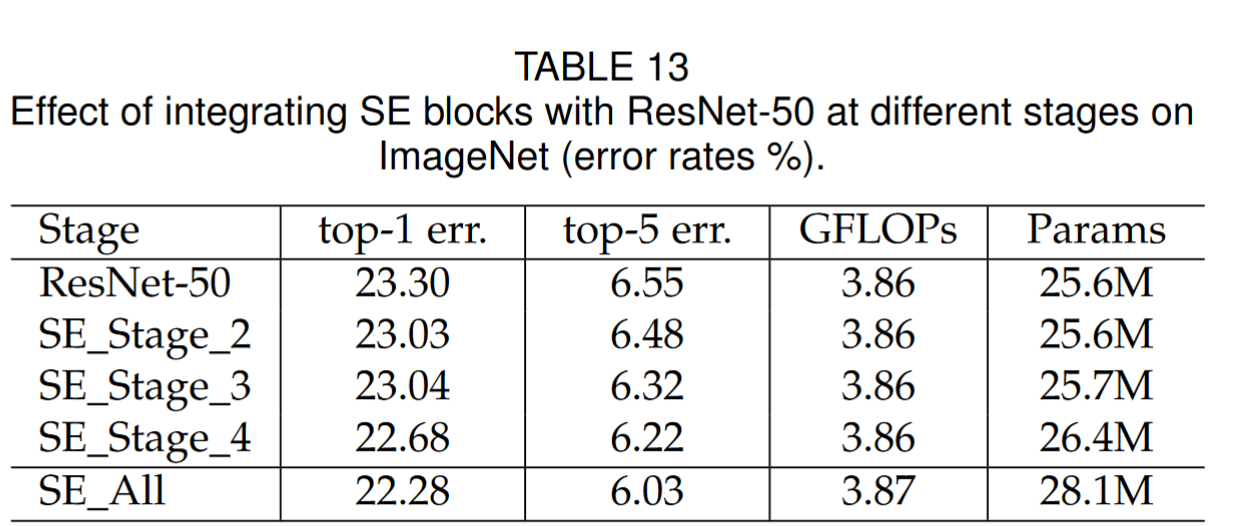

以Resnet50为例,分别在不同阶段加入SEBlock的效果

以Resnet50为例,分别在不同阶段加入SEBlock的效果

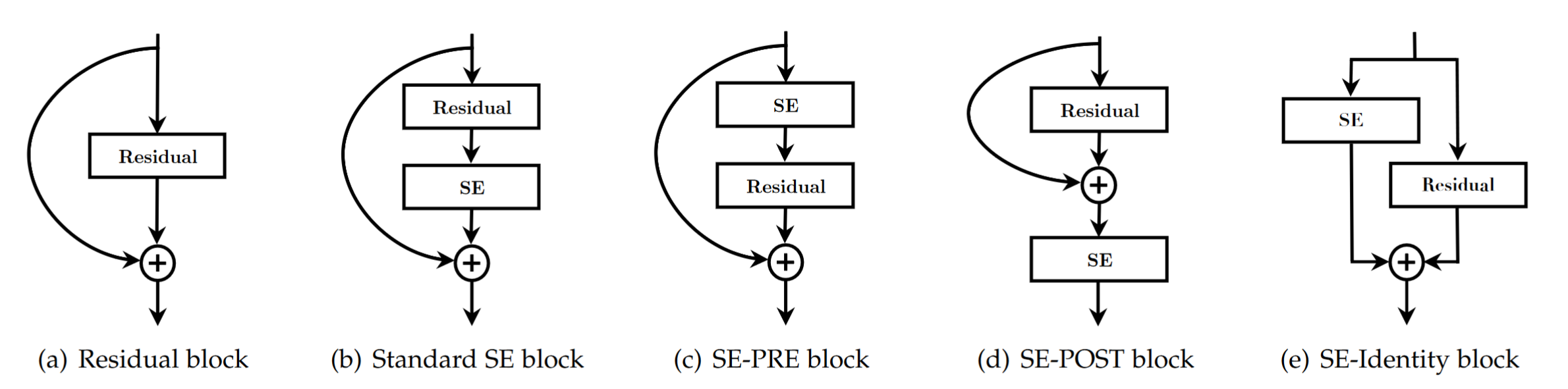

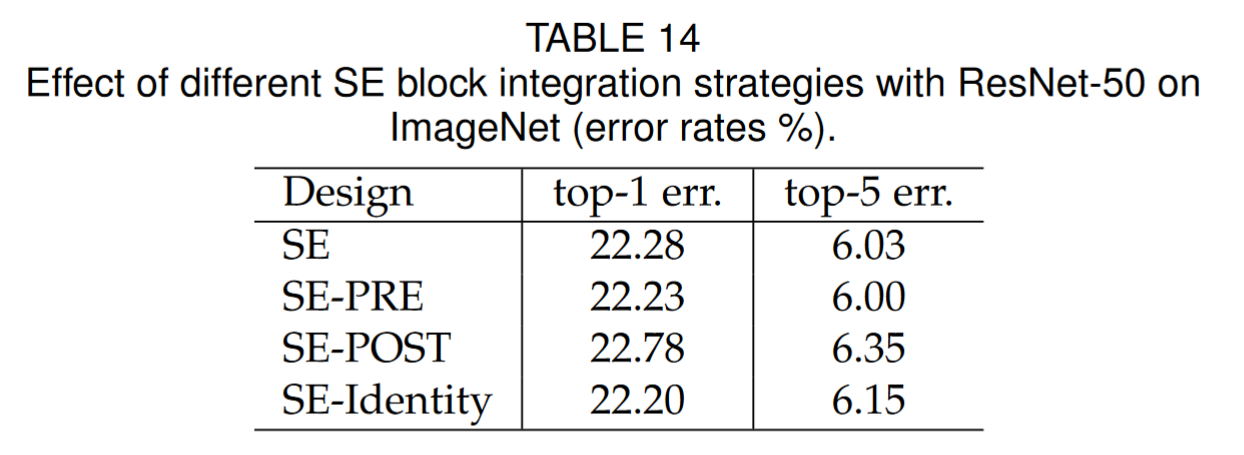

不同SEBlock位置的影响:b,c,e区别不大,d的效果比较差

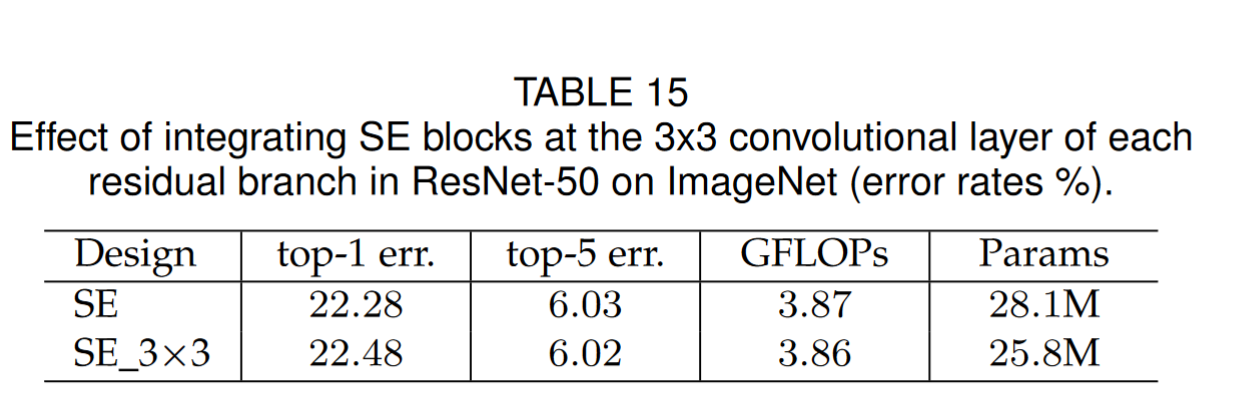

直接在resnet的3×3卷积后用SEBlock,因为此时通道数较少,计算量变小,但是准确率跟之前差不多

Conclusion

通过学习通道间的相互关系,重新分配各个通道的重要程度,来达到提高精确度的目的。

- Squeeze-and-Excitation 注意力 Excitation Networks Squeezesqueeze-and-excitation excitation networks squeeze squeeze-and-excitation注意力excitation squeeze-and-excitation 注意力non-local networks第一次 excitation squeeze sys_squeeze squeeze-enhanced squeeze-enhanced segmentation transformer seaformer sys_squeeze kingbasees squeeze v8r6