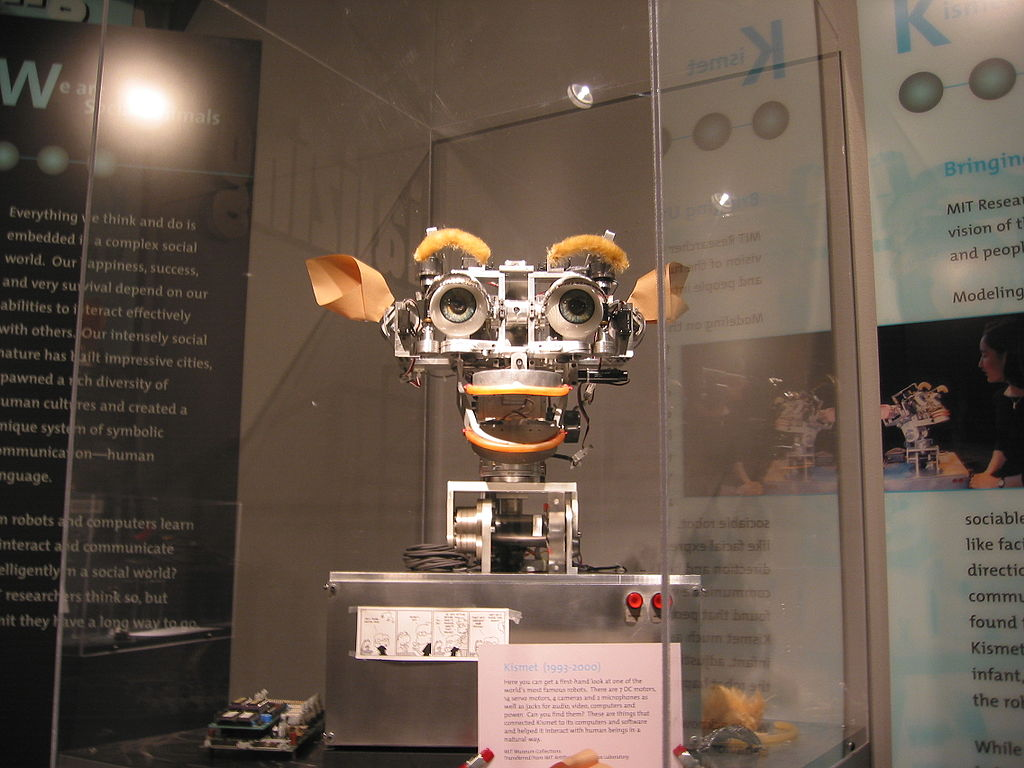

(图片来源:维基百科,Kismet robot。)

人工智慧(AI)系统可以应用到很多方面,帮人类解决很多问题。但不论AI的原始目的是什么,万一AI发展出自己的功能或意识,做出预料之外的事,这可能会造成很多严重的后果,例如在很多电影里面变坏的机器人,试图控制人类的电脑等等。所以如何确保AI只做人类希望它做的事,这就是AI的一致性问题(AI Alignment Problem)。在传统软体系统中,一致性并不是什么大问题,因为人类订定他们希望软体完成的工作,并编写了一个非常具体的指令集或程式来执行,程式详细说明了为解决问题所应该采取的每一步,如果软体在此过程中做错了什么,那是因为原始的程式就有问题。

但在AI系统,人类也是有希望要完成的工作,但程式本身要学会如何最快速有效地完成这个工作。例如下围棋程式AlphaGo,我们无法对每个棋盘的状况预先编写指令,只能靠程式自己思考如何下每一步棋。所以AI系统如何做决定,软体决策背后的逻辑通常都是不透明的,即使对开发这个软体的人来说也是如此。AI系统越聪明越有能力,这个一致性问题就越具有挑战性。

尤其当人类希望AI进步成AGI(Artificial General Intelligence),亦即AI可以像人类一样,在碰到未遇到过的(就AI而言就是未被类似的资料训练过)问题时,可以发挥创意利用过去的经验应用到新的状况,进而解决问题,但这种AGI系统是否就违反了AI的一致性问题呢?

随着AI系统不仅越来越普及而且越来越强大,我们会发现自己越来越经常处于「魔法师的学徒」(无法控制自己所制造的情况、事件或过程的人)的位置。AI是我们召唤出的力量,一开始自主但完全顺从,我们给它一套资料去训练,一旦我们意识到我们的资料不准确或不完整,而AI开始表现出非常可怕的异常或聪明,我们反而必须疯狂地去阻止它。正是「许愿需谨慎,梦想会成真」。

很多科学家、哲学家和科幻作家都想知道如何防止潜在的超人类的AI摧毁我们所有人,虽然「如果它试图杀死你,请拔掉电源」的明显答案有很多支持者,但不难想像一台足够先进的机器能够阻止你这样做。或者AI可能做出的决策或动作太快,以至于人类根本无法及时审查其道德正确性来避免它们造成的损害。

AI一致性的研究试图将人类的价值观、目标和道德标准让AI学习,然而魔鬼就在细节中。我们应该教机器什么样的道德规范,我们可以让机器遵循什么样的道德规范,以及谁来回答这些问题?

AI系统的进步表示我们已经朝着创造会思考的机器的目标走了很远,但一致性问题的挑战也提醒我们,在创造人类水准的智慧之前,我们还有很多需要学习的东西。

Read more: https://www.npf.org.tw/1/24810