好了终于到这里了,强化学习这个小山坡我算是终于到了最上面,但是还有更高的山峰让我去远眺,现在也只是敲开了我科研之路的大门,而演员评论家就是我要去学习的第一个前沿算法,先通俗点讲,就是有个演员,他就是演戏,会有一个经纪人,根据观众们的反馈以及票房数据(环境reward),给他打分,演员再根据这些分数,去更新他的演技,接着继续演,经纪人继续打分,这样子迭代下去。。。。。

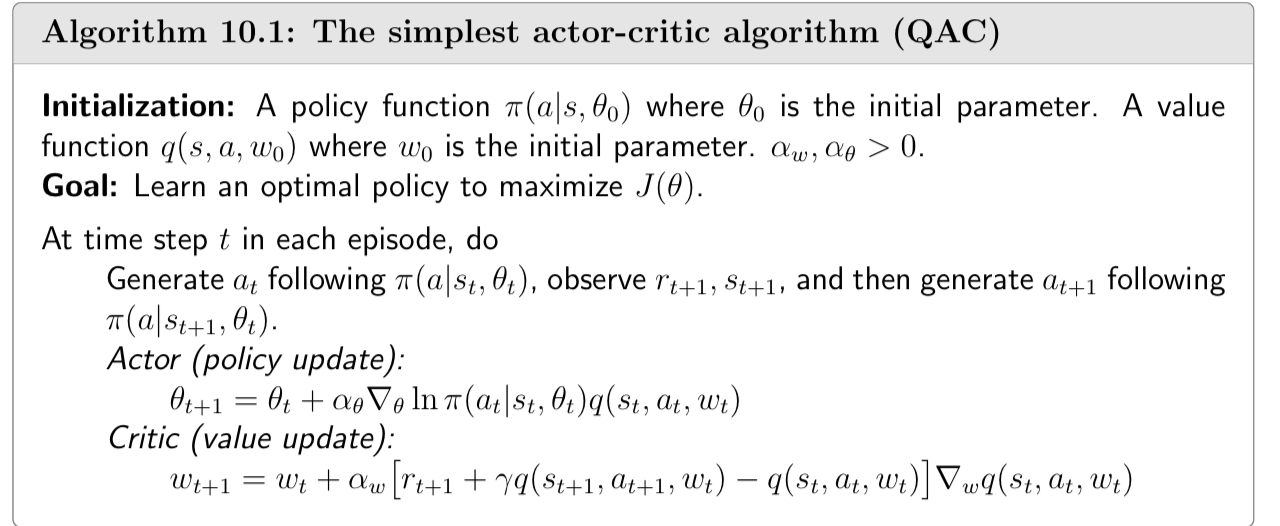

接下来细讲,就是Actor那边就是用策略迭代,梯度上升,去更新策略(通过更新策略的变量θ),但是里面有个参数q(s,a,w),就来自评论家那边的更新,通过更新变量w来更新q(s,a,w),进而更新θ最后更新策略,而评论家那边就运用一个时序差分去更新w,就是演员演戏产生的动作值作为参数,并对其求梯度,然后更新w进而更新q(s,a,t)(想要更新状态值或者动作值,可以通过更新其变量,更新变量当然是采取梯度方法),然后这样子循环迭代下去

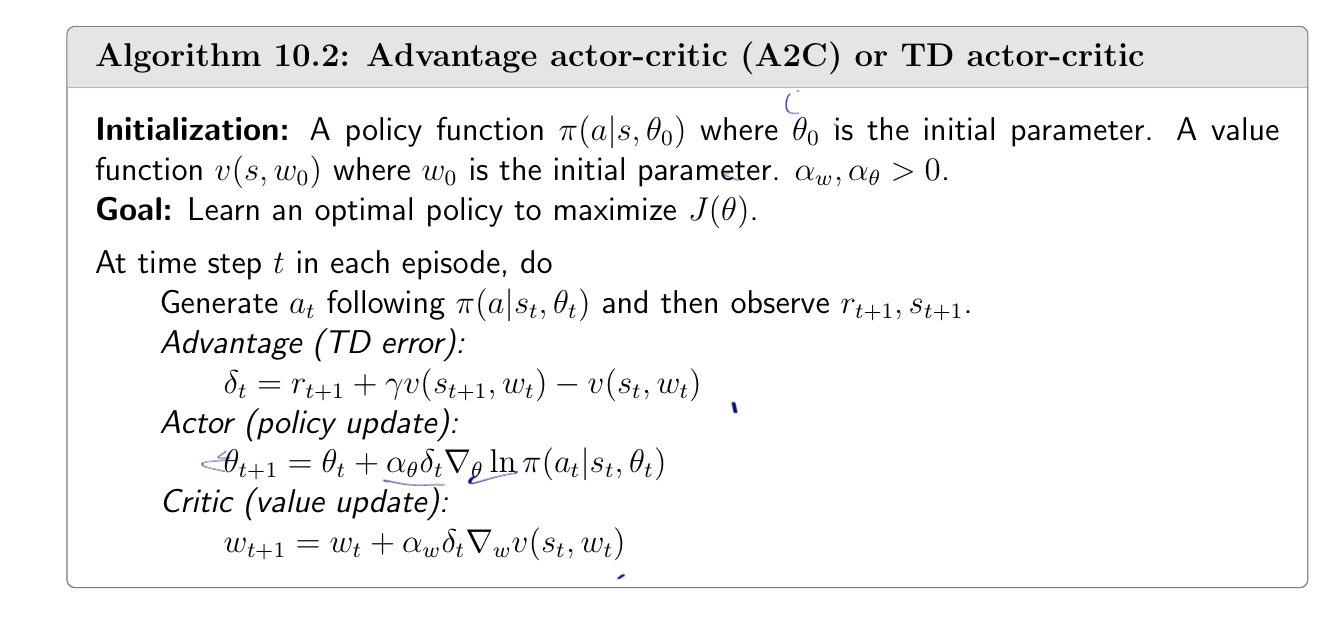

接下来是A2C Advantage Actor-Critic

A2C的讲解

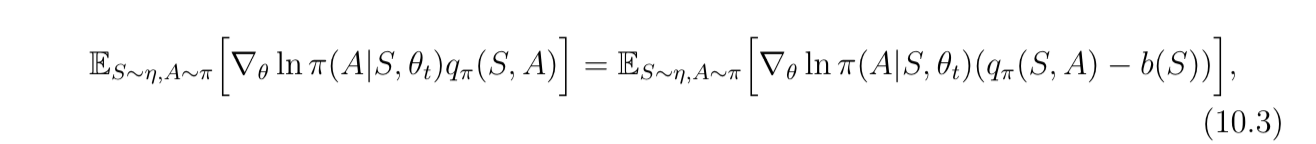

A2C就是,一个小小的改动,比如说,我想要设定一个基准值,比如它是对状态值求期望或者对动作值求期望,为什么要有这个基准值呢,没有这个基准值的话,我每次更新时候,比如说有个不好的动作,它的q值不高,低于基准值,但毕竟他是正数,还是得尊重一下,因此最后的结果只是,q值不好的动作下次出现概率增长的速率低于好动作,那还是都增长呀,那效率就会比较低,那要怎么办呢,既然你q值不高,那我就让你减去平均值,直接让你成为负数,打入18层地狱难以超生,这样它在更新的时候,更新自变量的时候,就会是一个梯度下降的方法,被选中的概率就下降了

如图所示,会有一个TDerror,正数梯度上升,负数梯度下降

重要性采样放着和确定性一起更新吧,这个。。再说了好累,然后放几张图吧,就是一些我对于强化学习学到现在的一些感想

我觉得虽然我的学习停留在表层,但明白了什么是真正的细思极恐:女娲可以造人,生物克隆可以造人,算法也可以造人。。。。。而且是比女娲和生物克隆强几万倍的,然后就开始多愁善感思考人类的未来。。

热爱强化学习