由于动作和状态是随机的,又ut依赖于状态和动作,故ut也是随机的

最佳动作价值函数能给我们作出动作给予指导

我们利用神经网络来近似最佳动作价值函数

利用DQN进行动作价值函数的计算,例如我们可以将图片通过卷积层转换为特征向量,

再利用全连接层转换为对应的输出向量即为各个动作的打分。通过打分即可选择动作。

此图为用DQN玩游戏的流程。

用梯度下降法调整参数w降低误差,梯度下降法原理如下

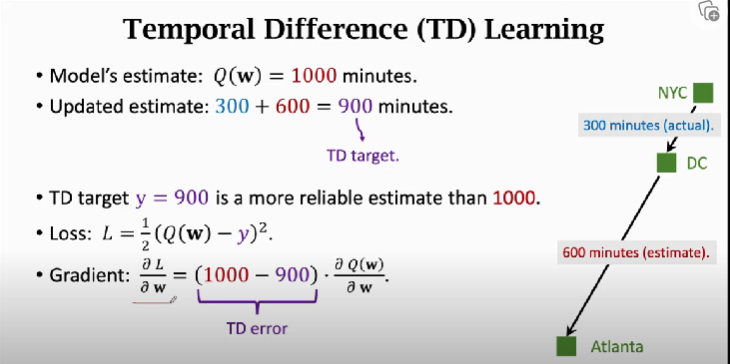

若只在dc就停车了,怎么利用nyc到dc的旅程改进模型

我们可以利用时间差分学习TD Learning,利用现在预估的时间以及原来预估的时间做梯度下降,更新参数。

TD Learning 的原理就是尽量使TD error小。

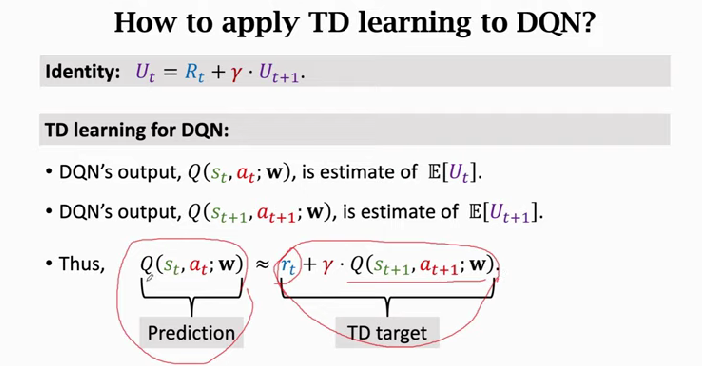

我们可以利用TD Learning 应用于速度强化学习中。

DQN利用神经网络近似最佳动作价值函数,输入为状态,输出为对动作的打分。

TD算法的一个迭代过程:

首先利用初始状态和动作预测动作价值函数,计算出动作价值函数对w的导数

然后执行动作,环境会给出新的状态和奖励。据此利用TD计算出新的动作价值函数

最后利用梯度下降法调整参数优化模型