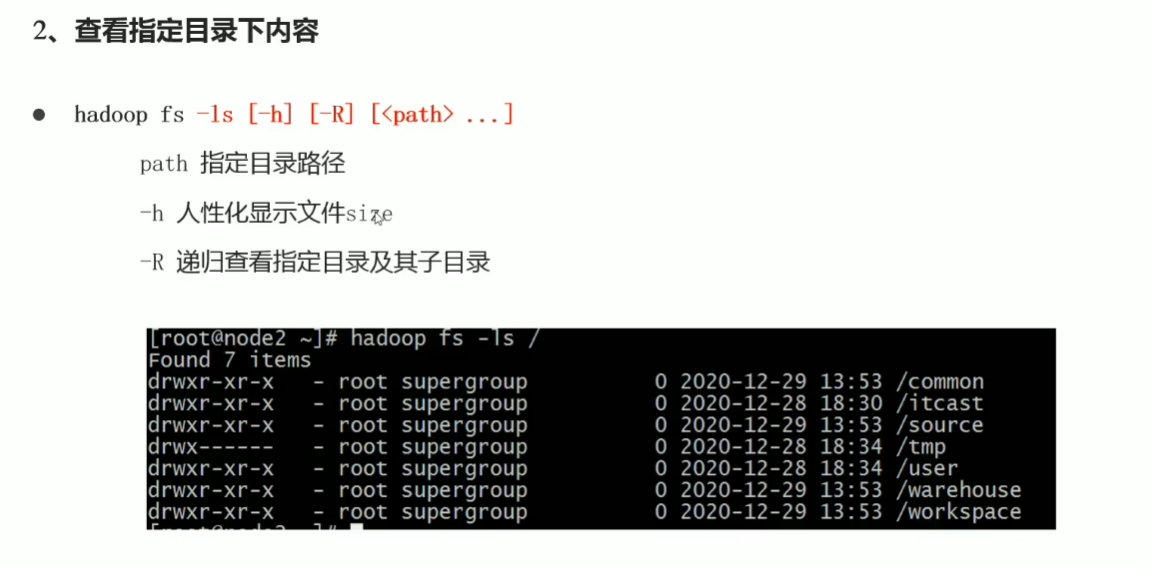

hadoop fs -ls file:/// 操作linux本地文件系统 hadoop fs -ls hdfs://node1:8020/ 操作HDFS分布式文件系统 hadoop fs -ls / 直接根目录,没有指定协议 将加载读取fs.defaultFS值

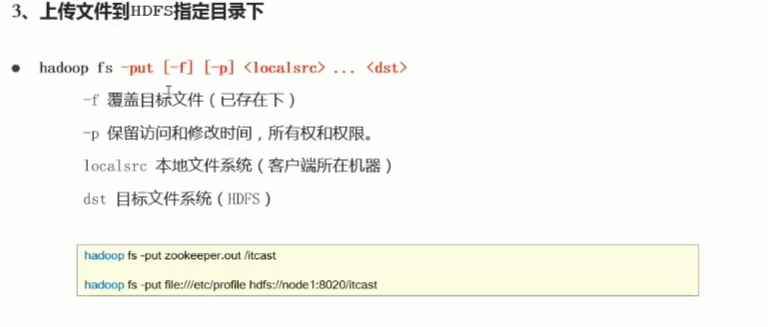

标准的hadoop上传文件命令:

hadoop fs -put file:///root/2.txt hdfs://node1:8020/itheima

示例:

1.:[root@node2 ~]# hadoop fs -cat /itheima/2.txt

2222

2.:[root@node2 ~]# hadoop fs -tail /itheima/2.txt

2222

您在 /var/spool/mail/root 中有新邮件

s示例:

[root@node2 ~]# hadoop fs -get hdfs://node1:8020/itheima/2.txt file:///root/

get: `/root/2.txt': File exists

您在 /var/spool/mail/root 中有新邮件

实际用例:

[root@node2 ~]# hadoop fs -get /itheima/2.txt ./666.txt

您在 /var/spool/mail/root 中有新邮件

[root@node2 ~]# ll

总用量 12

-rw-r--r-- 1 root root 5 8月 29 16:54 2.txt

-rw-r--r-- 1 root root 5 8月 29 17:08 666.txt

-rw-------. 1 root root 1340 9月 11 2020 anaconda-ks.cfg

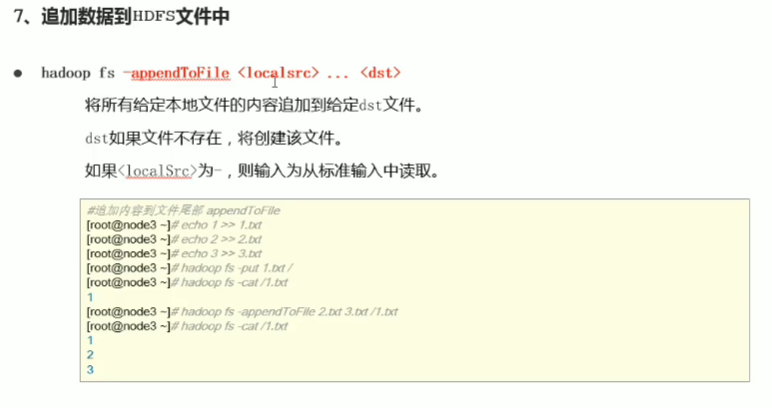

hadoop fs -appendToFile 2.txt 3.txt /1.txt

[root@node2 ~]# hadoop fs -cat /1.txt

1

2

3