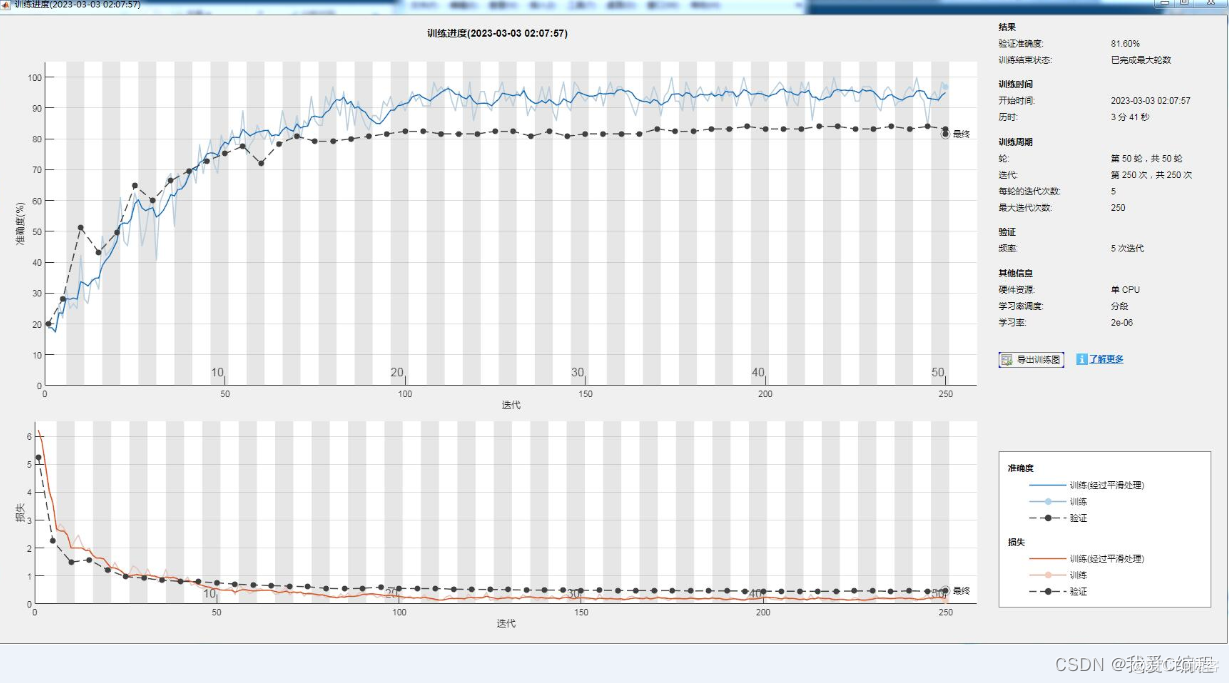

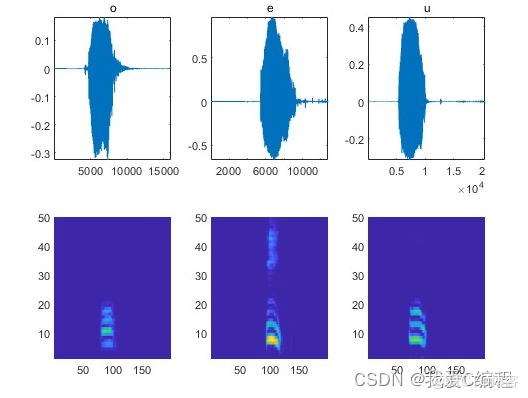

1.算法仿真效果

matlab2022a仿真结果如下:

2.算法涉及理论知识概要

人工智能的应用中,语音识别在今年来取得显著进步,不管是英文、中文或者其他语种,机器的语音识别准确率在不断上升。其中,语音听写技术的发展最为迅速,目前已广泛在语音输入、语音搜索、语音助手等产品中得到应用并日臻成熟。但是,语音应用的另一层面,即语音转写,目前仍存在一定的难点,由于在产生录音文件的过程中使用者并没有预计到该录音会被用于语音识别,因而与语音听写相比,语音转写将面临说话风格、口音、录音质量等诸多挑战。

语音转写的典型场景包括,记者采访、电视节目、课堂及交谈式会议等等,甚至包括任何人在日常的工作生活中产生的任何录音文件。 语音转写的市场及想象空间是巨大的,想象一下,如果人类可以征服语音转写,电视节目可以自动生动字幕、正式会议可以自动形成记要、记者采访的录音可以自动成稿……人的一生中说的话要比我们写过的字多的多,如果有一个软件能记录我们所说过的所有的话并进行高效的管理,这个世界将会多么的让人难以置信。

卷积神经网络整体架构: 卷积神经网络是一种多层的监督学习神经网络,隐含层的卷积层和池采样层是实现卷积神经网络特征提取功能的核心模块。该网络模型通过采用梯度下降法最小化损失函数对网络中的权重参数逐层反向调节,通过频繁的迭代训练提高网络的精度。卷积神经网络的低隐层是由卷积层和最大池采样层交替组成,高层是全连接层对应传统多层感知器的隐含层和逻辑回归分类器。第一个全连接层的输入是由卷积层和子采样层进行特征提取得到的特征图像。最后一层输出层是一个分类器,可以采用逻辑回归,Softmax回归甚至是支持向量机对输入图像进行分类。

CNN卷积神经网络一共有5个层次结构:

输入层

卷积层

激励层

池化层

全连接FC层

1、 输入层:对原始图像数据进行预处理

1)原理:直接接收二维视觉模式,不再需要人工参与提取合适的特征作为输入,它自动地从原始图像数据提取特征、学习分类器,可大大减少开发的复杂性,有助于学习与当前分类任务最为有效的视觉特征。

2)与传统神经网络/机器学习一样,模型需要输入的进行预处理操作,常见的输入层中对图像预处理方式有:

去均值:把输入数据各个维度都中心化为0,即将样本的中心拉回到坐标系原点

归一化:幅度归一化到同样的范围

PCA/白化:用PCA降维,白化即将各个特征轴上的幅度进行归一化

2、 卷积层:通过在原始图像上平移来提取特征

1) 卷积(convolution):是透过两个函数f和g生成第三个函数的一种数学算子,表征函数f与经过翻转和平移的g的乘积函数

2) 卷积层(Convolutional layer),卷积神经网络中每层卷积层由若干卷积单元组成,每个卷积单元的参数都是通过反向传播算法最佳化得到的。卷积运算的目的是提取输入的不同特征,第一层卷积层可能只能提取一些低级的特征如边缘、线条和角等层级,更多层的网路能从低级特征中迭代提取更复杂的特征。

3)局部感知:网络部分连通,每个神经元只与上一层的部分神经元相连,只感知局部,而不是整幅图像

4、 池化层

1) 池化层夹在连续的卷积层中间,用于压缩数据和参数的量,减少过拟合。即输入的是图像的话,池化层的最主要作用就是压缩图像。(过拟合:过拟合其中一个可能的成因就是模型的vc维过高,使用了过强的模型复杂度(model complexity)的能力(参数多并且过训练)。还有一个原因是数据中的噪声,造成了如果完全拟合的话,也许与真实情景的偏差更大。最后还有一个原因是数据量有限,这使得模型无法真正了解整个数据的真实分布。权值学习迭代次数足够多(Overtraining),拟合了训练数据中的噪声和训练样例中没有代表性的特征。)

2) 具体作用:

1.特征不变性:即图像压缩时去掉的信息只是一些无关紧要的信息,留下最能表达图像的特征

2.特征降维:即将最重要的特征抽取出来,将一些冗余信息去。

3.MATLAB核心程序

commands = categorical(["a","e","u","o","ye"]);

[adsTrain,adsValidation] = splitEachLabel(ads,0.75);

mysplit;

parameters;

randsels;

%Convolutional neural network

classWeights = 1./countcats(YTrain);

classWeights = classWeights'/mean(classWeights);

numClasses = numel(categories(YTrain));

timePoolSize = ceil(numHops/8);

dropoutProb = 0.2;

numF = 12;

layers = [

imageInputLayer([numHops numBands])

convolution2dLayer(3,numF,'Padding','same')

batchNormalizationLayer

reluLayer

maxPooling2dLayer(3,'Stride',2,'Padding','same')

convolution2dLayer(3,2*numF,'Padding','same')

batchNormalizationLayer

reluLayer

maxPooling2dLayer(3,'Stride',2,'Padding','same')

convolution2dLayer(3,4*numF,'Padding','same')

batchNormalizationLayer

reluLayer

maxPooling2dLayer(3,'Stride',2,'Padding','same')

convolution2dLayer(3,4*numF,'Padding','same')

batchNormalizationLayer

reluLayer

convolution2dLayer(3,4*numF,'Padding','same')

batchNormalizationLayer

reluLayer

maxPooling2dLayer([timePoolSize,1])

dropoutLayer(dropoutProb)

fullyConnectedLayer(numClasses)

softmaxLayer

weightedClassificationLayer(classWeights)

];

miniBatchSize = 64;

validationFrequency = floor(numel(YTrain)/miniBatchSize);

options = trainingOptions('adam', ...

'InitialLearnRate',2e-4, ...

'MaxEpochs',50, ...

'MiniBatchSize',miniBatchSize, ...

'Shuffle','every-epoch', ...

'Plots','training-progress', ...

'Verbose',false, ...

'ValidationData',{XValidation,YValidation}, ...

'ValidationFrequency',validationFrequency, ...

'LearnRateSchedule','piecewise', ...

'LearnRateDropFactor',0.1, ...

'LearnRateDropPeriod',20);

trainedNet = trainNetwork(XTrain,YTrain,layers,options);

save R.mat