Pyramid Scene Parsing Network

* Authors: [[Hengshuang Zhao]], [[Jianping Shi]], [[Xiaojuan Qi]], [[Xiaogang Wang]], [[Jiaya Jia]]

初读印象

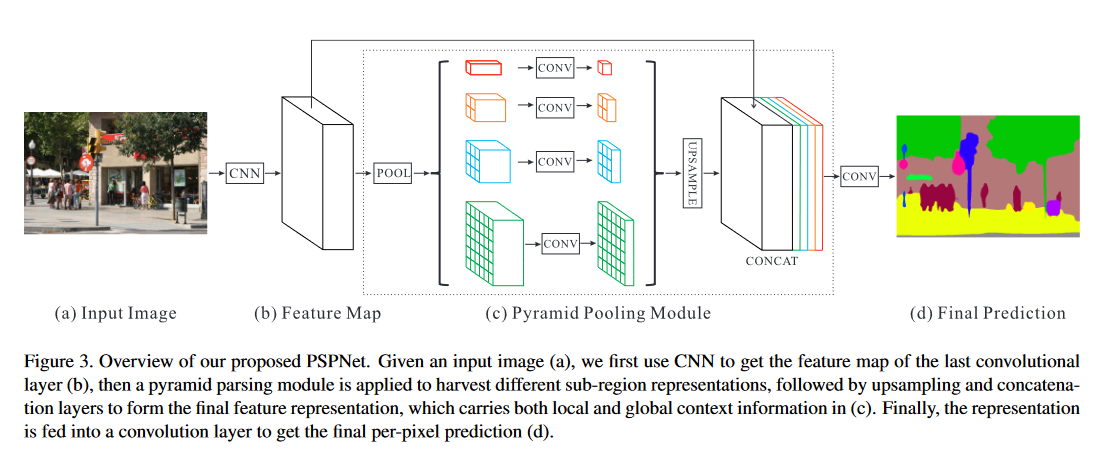

comment:: (PspNet)用金字塔池化模块和金字塔场景解析([[cv不同方向]])网络来聚合不同层的上下文以利用全局上下文信息。

Why

提出一种聚合不同区域的上下文以利用全局上下文信息以产生pixel-wise预测的框架。

复杂多样的场景下需要解决的问题:

- 语境不符:语境下不能出现错误的词汇(车不应出现在河上)

- 类别混淆:同一对象不能预测为不同的相似类别(一个对象同时预测为建筑和摩天大厦)

- 类别不显眼:太小的类别容易被忽略。太大的类别容易超出感受野导致非连续预测。

过去的方法:

- 把全连接层换成卷积层(FCN等)

- 使用膨胀卷积或带有反卷积的[[coarse-to-fine]]扩大感受野

- 使用CRF来调整语义分割结果

- 用带FCN的全局平均池化能够加强语义分割的结果,但是在复杂数据集上不适用。

What

用金字塔池化模块提取多尺寸的局部上下文并融合为全局场景先验,

How

-

金字塔池化模块:融合四种来自不同金字塔规模的特征(pdf) 得到全局先验(比全局池化更有代表性)

- 经过CNN得到的feature map,每层将原始输入分成不同子区域(区域大小可变,汇聚层大小根据区域大小改变,论文中使用如下配置),子区域做平均池化。

- 全局池:最粗糙,大小为生成(1×1×N)输出

- 剩下几层分别输出(2×2×N)(3×3×N)(6×6×N)

- 对每层的结果分别做(1×1×1)的卷积并用双线性插值上采样,所有结果与CNN得到的feature做拼接。

- 经过CNN得到的feature map,每层将原始输入分成不同子区域(区域大小可变,汇聚层大小根据区域大小改变,论文中使用如下配置),子区域做平均池化。

-

金字塔场景解析网络 (PSPNet)

- 预训练的ResNet(使用膨胀卷积),得到原图\(\frac{1}{8}\)大小的feature map。

- 用金字塔池化模块得到全局先验并与(1)中得到的feature map拼接。

- 经过卷积层、上采样得到预测结果。

-

实现细节

- “poly”学习率:“Inspired by [4], we use the “poly” learning rate policy where current learning rate equals to the base one multiplying (1 − iter maxiter )power.” (Zhao 等。, 2017, p. 5) 学习率

- 动量和权重衰退“Momentum and weight decay are set to 0.9 and 0.0001 respectively.” (Zhao 等。, 2017, p. 5) (pdf)

- 数据增强:镜像,缩放,旋转,高斯模糊

- 使用辅助损失函数训练

-

消融实验的结论:

- 平均池化表现优于最大池化

- 金字塔池化由于全局池化

- 池化后有卷积优于没有卷积

- 辅助损失函数为0.4时效果最好

- resnet越深效果越好

Conclusion

本文亮点:

- 加入金字塔池化模块得到的全局上下文信息后,有效减少了类别混淆、忽略不显眼的类的情况出现。

- 消融实验里可以看到,实现细节中用的一些方法也调高了global acc和iou。

References

- This reference does not have DOI

- This reference does not have DOI

- This reference does not have DOI

- 10.1007/978-3-319-46478-7_29

- 10.1109/ICCV.2015.203

- 10.1109/ICCV.2015.178

- This reference does not have DOI

- 10.1109/CVPR.2016.351

- This reference does not have DOI

- 10.1109/CVPR.2015.7298594

- 10.1109/ICCV.2011.6126343

- This reference does not have DOI

- 10.1109/CVPR.2015.7298642

- This reference does not have DOI

- [@He2016]

- This reference does not have DOI

- 10.1145/2647868.2654889

- This reference does not have DOI

- This reference does not have DOI

- 10.1109/CVPR.2006.68

- This reference does not have DOI

- 10.1109/CVPR.2015.7298959

- This reference does not have DOI

- 10.1109/ICCV.2011.6126219

- This reference does not have DOI

- 10.1109/CVPR.2016.350

- 10.1109/CVPR.2014.119

- 10.1109/CVPR.2016.396

- 10.1007/s11263-009-0275-4

- 10.1109/ICCV.2015.191

- This reference does not have DOI

- 10.1007/978-3-319-46487-9_32

- This reference does not have DOI

- 10.1109/CVPR.2016.348

- This reference does not have DOI

- This reference does not have DOI

- This reference does not have DOI

- This reference does not have DOI

- 10.1109/ICCV.2015.179

- This reference does not have DOI

- [@Long2015]

- This reference does not have DOI

- 10.1109/ICCV.2015.162

Currently 2 references inside library! @2022-08-08