1.算法描述

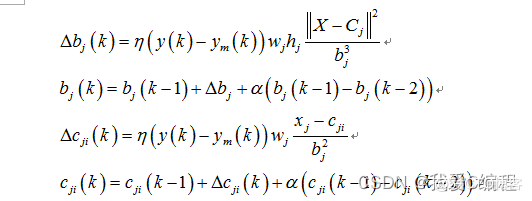

1985年,Powell提出了多变量插值的径向基函数(RBF)方法。径向基函数是一个取值仅仅依赖于离原点距离的实值函数,也可以是到任意一点c的距离,c点称为中心点。任意满足上述特性的函数,都可以叫做径向基函数。一般使用欧氏距离计算距离中心点的距离(欧式径向基函数)。最常用的径向基函数是高斯核函数。RBF神经网络只有三层,即输入层、隐藏层、输出层。RBF网络的基本思想是:用RBF作为隐单元的“基”构成隐含层空间,这样就可以将输入矢量直接映射到隐空间,而不需要通过权连接。当RBF的中心点确定以后,这种映射关系也就确定了。而隐含层空间到输出空间的映射是线性的,即网络的输出是隐单元输出的线性加权和,此处的权即为网络可调参数。其中,隐含层的作用是把向量从低维度的p映射到高维度的h,这样低维度线性不可分的情况到高维度就可以变得线性可分了,主要就是核函数的思想。这样,网络由输入到输出的映射是非线性的,而网络输出对可调参数而言却又是线性的。网络的权就可由线性方程组直接解出,从而大大加快学习速度并避免局部极小问题。RBF神经网络的隐节点采用输入模式与中心向量的距离(如欧式距离)作为函数的自变量,并使用径向基函数(如Gaussian函数)作为激活函数。神经元的输入离径向基函数中心越远,神经元的激活程度就越低(高斯函数)。RBF网络的输出与部分调参数有关,譬如,一个wij值只影响一个yi的输出,RBF神经网络因此具有“局部映射”特性。

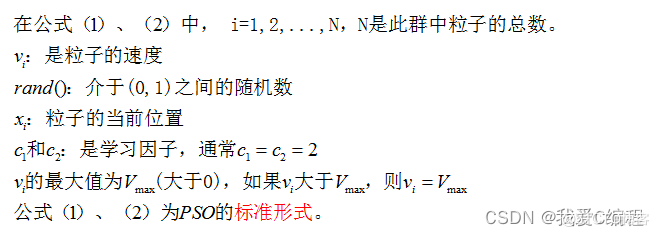

PSO中,每个优化问题的解都是搜索空间的一只鸟,我们称之为“粒子”。所有的粒子都有一个被优化的函数决定的适应值,每个粒子还有一个速度决定他们飞翔的方向和距离。然后粒子们就追随当前的最优粒子在解空间中搜索。

PSO初始化为一群随机粒子(随机解)。然后通过迭代找到最优解,在每一次迭代中,粒子通过跟踪两个“极值”来更新自己。第一个就是粒子本身所找到的最优解,这个解叫做个体极值。另一个极值是整个种群目前找到的最优解,这个极值是全局机制。另外也可以不用整个种群而只是用其中一部分作为粒子的邻居,那么在所有邻居中的极值就是局部极值。

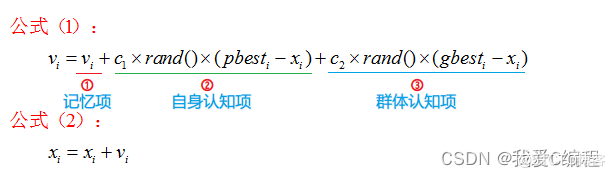

PSO初始化为一群随机粒子(随机解)。然后通过迭代找到最优解。在每一次迭代中,粒子通过跟踪两个“极值(pbest和gbest)”来更新自己。在找到这两个最优值后,粒子通过下面的公式来更新自己的速度和位置。

对于公式(1):

公式(1)中的第一部分称为记忆项,表示上次速度大小和方向的影响;

公式(1)中的第二部分称为自身认知项,是从当前点指向粒子自身最好点的一个矢量,表示粒子的动作来源于自己经验的部分;

公式(1)中的第三部分称为群体认知项,是一个从当前点指向种群最好点的矢量,反映了粒子间的协调合作和知识共享。粒子就是通过自己的经验和同伴中最好的经验来决定下一步的运动。

综上所述,标准PSO算法流程:

初始化一群微粒(群体规模为N),包括随机位置和速度;

评价每个微粒的适应度;

对每个微粒,将其适应值与其经过的最好位置pbest作比较,如果较好,则将其作为当前的最好位置pbest;

对每个微粒,将其适应值与其经过的最好位置gbest作比较,如果较好,则将其作为当前的最好位置gbest;

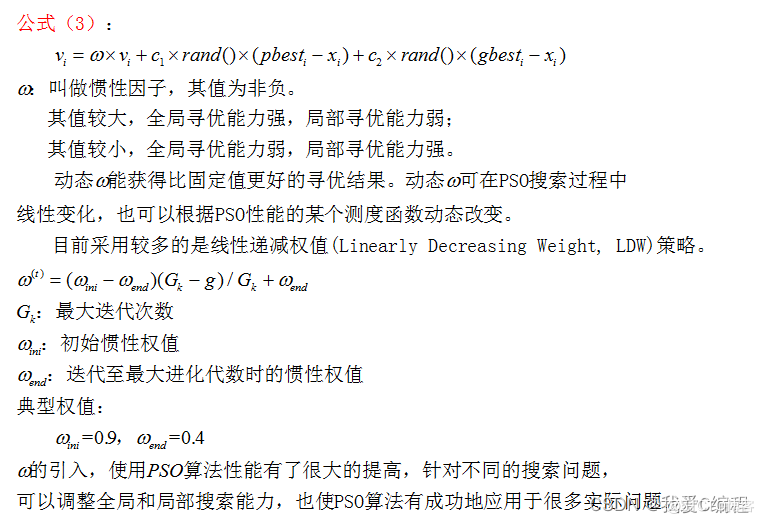

根据公式(2)、(3)调整微粒的速度和位置;

未达到结束条件则转到第二步。

迭代终止条件根据具体问题一般选为最大迭代次数Gk或微粒群迄今为止搜索到的最优位置满足预定最小适应阈值。

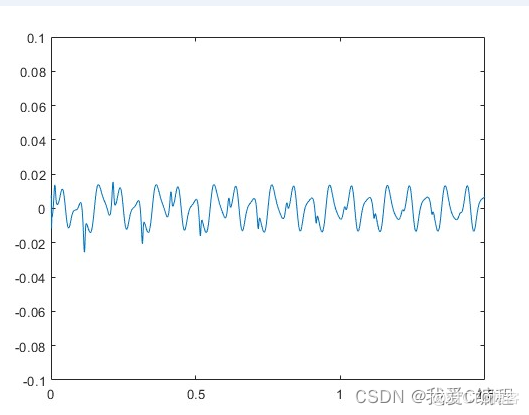

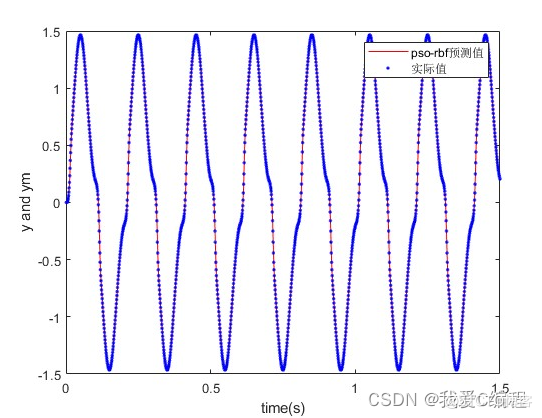

2.仿真效果预览

matlab2022a仿真结果如下:

3.MATLAB核心程序

V = 0.1*rands(m,n);

BsJ = 0;

%根据初始化的种群计算个体好坏,找出群体最优和个体最优

for s = 1:m

indivi = pop(s,:);

[indivi,BsJ] = func_obj(indivi,BsJ);

Error(s) = BsJ;

end

[OderEr,IndexEr] = sort(Error);

Error;

Errorleast = OderEr(1);

for i = 1:m

if Errorleast == Error(i)

gbest = pop(i,:);

break;

end

end

ibest = pop;

for kg = 1:G

kg

for s = 1:m;

%个体有4%的变异概率

for j = 1:n

for i = 1:m

if rand(1)<0.04

pop(i,j) = rands(1);

end

end

end

%r1,r2为粒子群算法参数

r1 = rand(1);

r2 = rand(1);

%个体和速度更新

V(s,:) = w*V(s,:) + c1*r1*(ibest(s,:)-pop(s,:)) + c2*r2*(gbest-pop(s,:));

pop(s,:) = pop(s,:) + 0.3*V(s,:);

for j = 1:3

if pop(s,j) < MinX(j)

pop(s,j) = MinX(j);

end

if pop(s,j) > MaxX(j)

pop(s,j) = MaxX(j);

end

end

for j = 4:9

if pop(s,j) < MinX(j)

pop(s,j) = MinX(j);

end

if pop(s,j) > MaxX(j)

pop(s,j) = MaxX(j);

end

end

for j = 10:12

if pop(s,j) < MinX(j)

pop(s,j) = MinX(j);

end

if pop(s,j) > MaxX(j)

pop(s,j) = MaxX(j);

end

end

%求更新后的每个个体适应度值

[pop(s,:),BsJ] = func_obj(pop(s,:),BsJ);

error(s) = BsJ;

%根据适应度值对个体最优和群体最优进行更新

if error(s)<Error(s)

ibest(s,:) = pop(s,:);

Error(s) = error(s);

end

if error(s)<Errorleast

gbest = pop(s,:);

Errorleast = error(s);

end

end

Best(kg) = Errorleast;

end

plot(Best,'-bs',...

'LineWidth',2,...

'MarkerSize',6,...

'MarkerEdgeColor','r',...

'MarkerFaceColor',[0.7,0.7,0.4]);

save net.mat gbest;