# reason why dropout could resolve overfitting

## the first: smaller neural network seems like it should have a regularizing effect(P52)

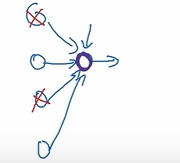

## the second: the perspective of a single unit

* the units' job 利用输入单元生成有意义的输出

* 因为有些输入神经元会被随机抛弃,所以,上图中紫色的神经元不可以依赖任何一个特征,因为每个特征都会被随机丢弃

* 所以,不会希望将太多权重放到任何一个特征上,因此,会得到较小的权重

## 留存率

* 对于不同的层可以设置不同的留存率

* 如果某层可能容易发声过拟合,可以设置一个较低的留存率

* 不容易发生过拟合的层可以设置较高的留存率或者设为1

* 缺点:交叉验证时参数很多

* 改进:某些层使用Dropout(相同的留存率),另一些层不使用

## 缺点

*代价函数不太明确,因为每次迭代都有一些神经元随机失活

* 因此,不能使用绘图(随着迭代次数增加错误率降低)的方法调错误了