转自:https://mp.weixin.qq.com/s/p9p3Gjf0avQH0UKsHoR_Zw

都今天了

你还不会用Stable Diffusion?

上一期为大家介绍了Midjourney,今天为大家带来AI绘画界的另外一个扛把子Stable Diffusion,本期内容攻略妹保姆级喂饭教程,适合零基础、小白还有各种安装懒人,看完让你轻松上手!

本期目录:Stable Diffusion

1-配置要求

2-安装教程

3-关于版本及更新

4-启动打开

5-界面说明及绘制

1-配置要求

1、硬件要求:最好使用N卡(NVIDIA显卡),显卡的显存至少需要4GB以上显存才能在本地运行。

最低配置需要4GB显存,基本配置6GB显存,推荐配置12GB显存或者以上。(stable diffusion Ai 绘画主要是运行显卡,算力越强,出图越快。显存越大,所设置图片的分辨率越高)

2、网络要求:无特殊要求,也就是正常安装好就可以用。

3、系统要求:Win10或者Win11系统即可。

4、是否收费:开源免费,无需任何付费直接使用。

2-安装教程

Stable Diffusion最初安装较为繁琐,因此有众多UP主、博主对安装步骤进行封装制作为整合包(基于开源项目制作),一键解压即可完成部署进行使用,此处我们以B站UP主秋葉aaaki(UID12566101)制作的整合包为例进行教程。

Stable Diffusion一键整合包可在文末查看获取

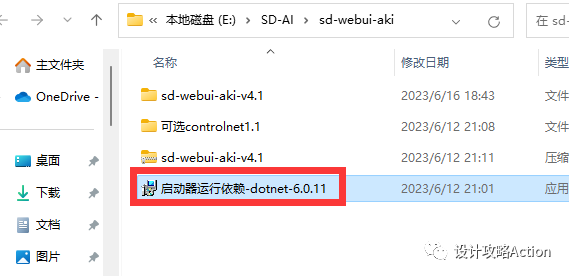

1、首先鼠标双击打开启动器运行依赖。

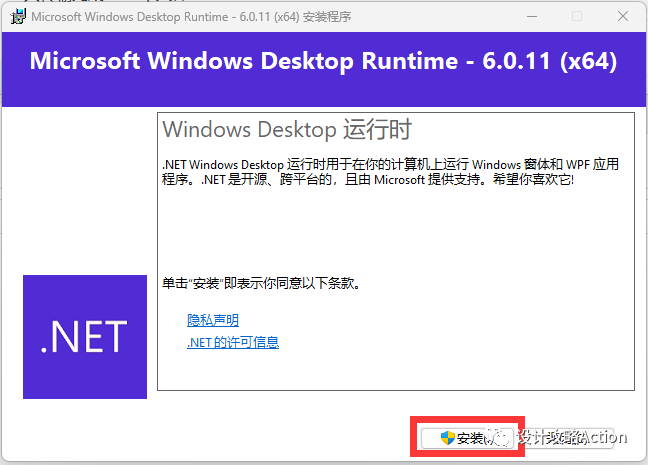

2、点击安装。

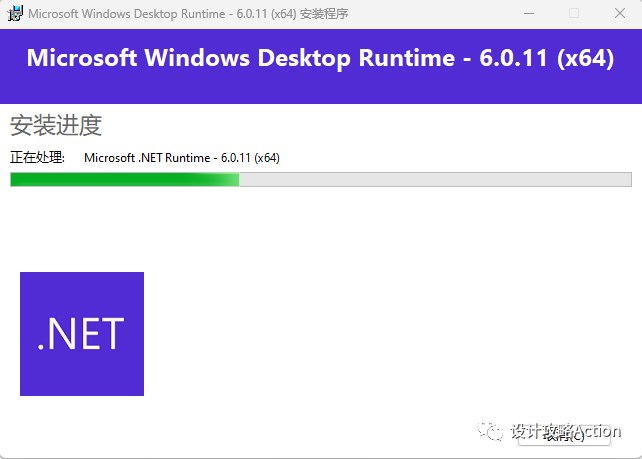

3、等待安装。

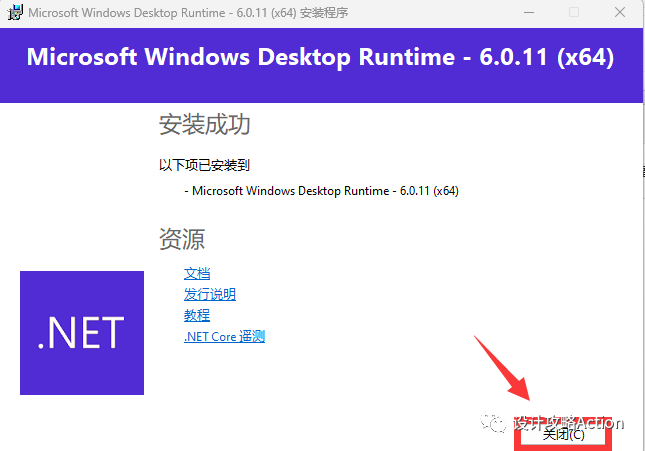

4、点击关闭。

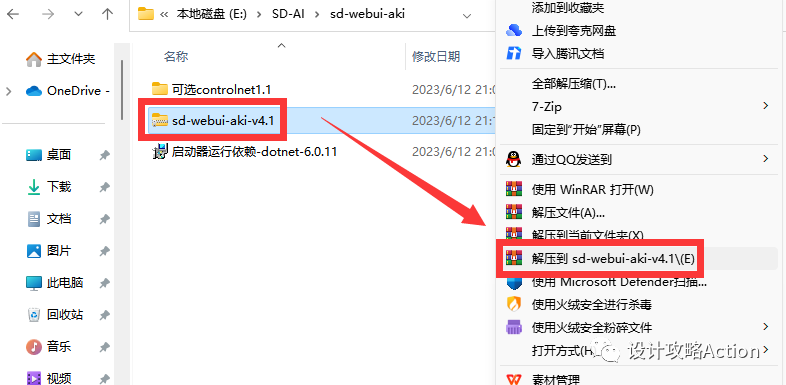

5、回到文件夹,解压图示压缩包。

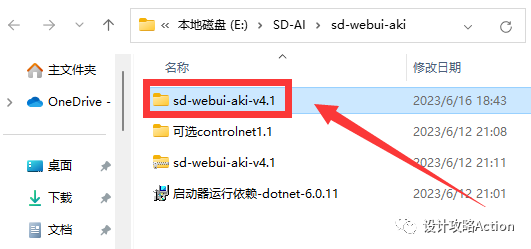

6、打开解压好的文件夹。

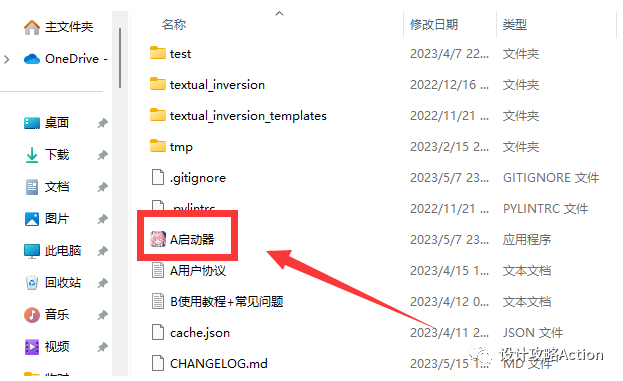

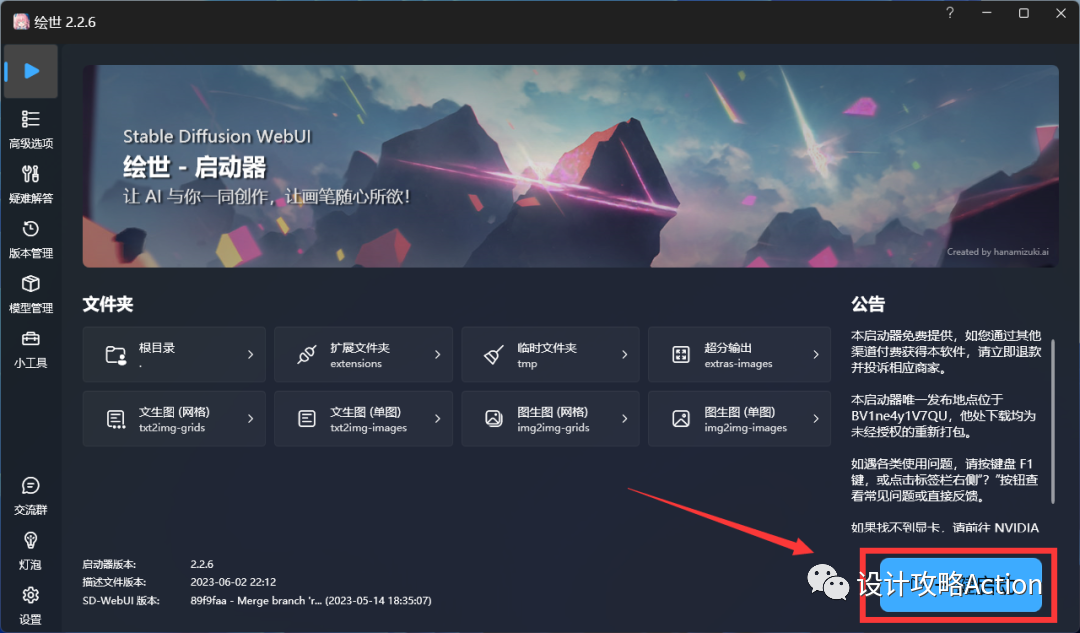

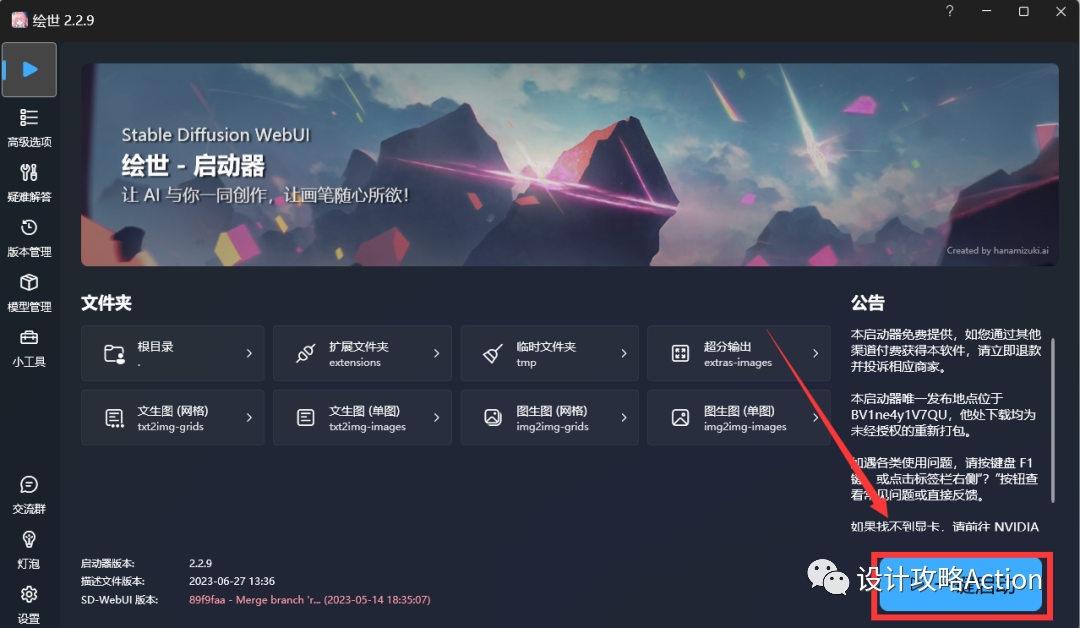

7、找到名为A启动器的应用程序,双击打开。

8、点击一键启动。

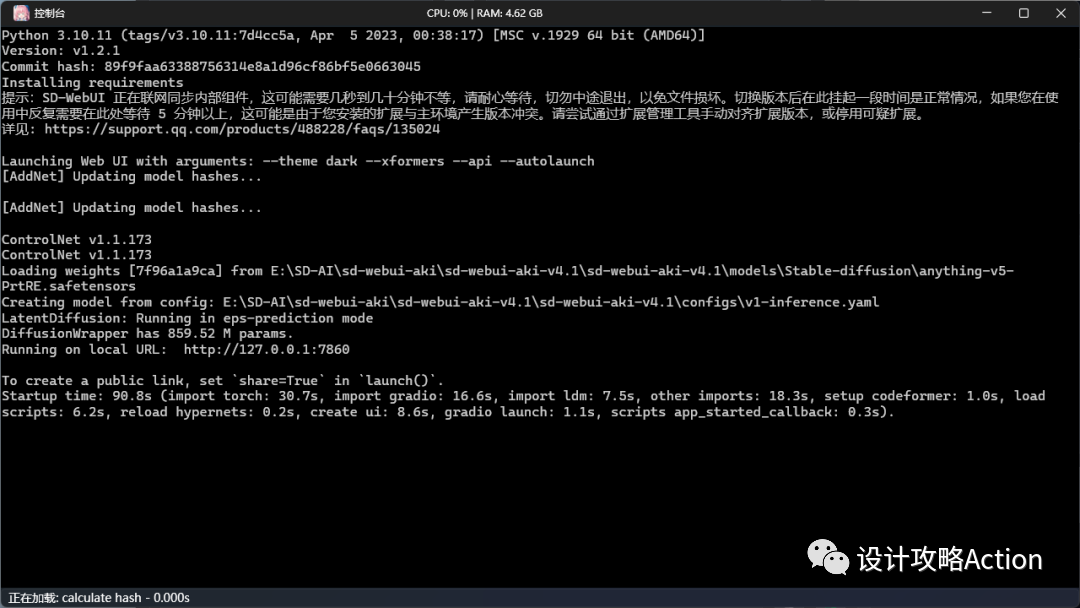

9、弹出黑框运行(耐心等待,切勿关闭)。

10、自动打开浏览器运行Stable Diffusion,可以开始使用。

3-关于版本及更新

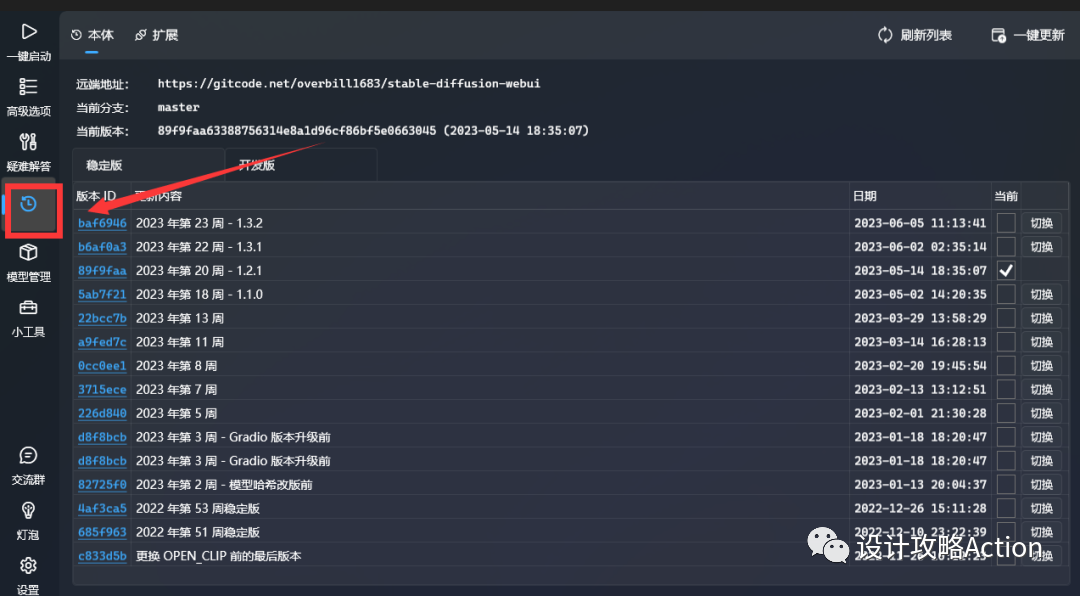

Stable Diffusion webui/绘世等各类整合包的更新比较频繁,可以在对应的启动器的版本管理功能内进行更新,当然一般不更新也不影响正常使用:

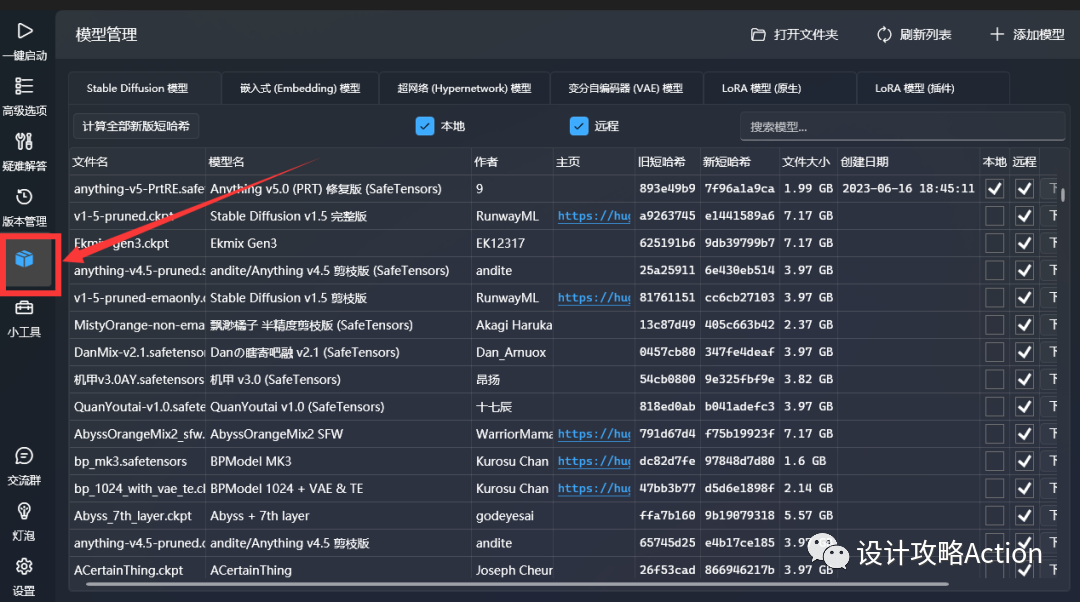

同样也可以在功能模块下载更新或者添加各类模型:

4-启动打开

每次使用前都是先打开启动器,然后通过启动器一键启动。

启动后会弹出运行框,等待运行完毕会自动打开Stable Diffusion。

5-界面说明及绘制

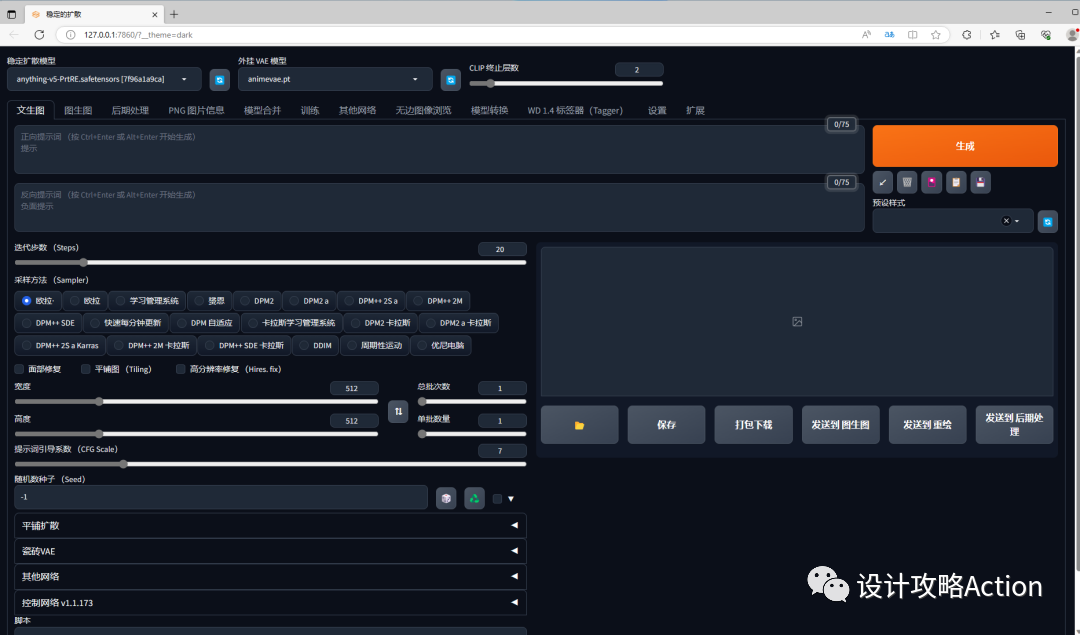

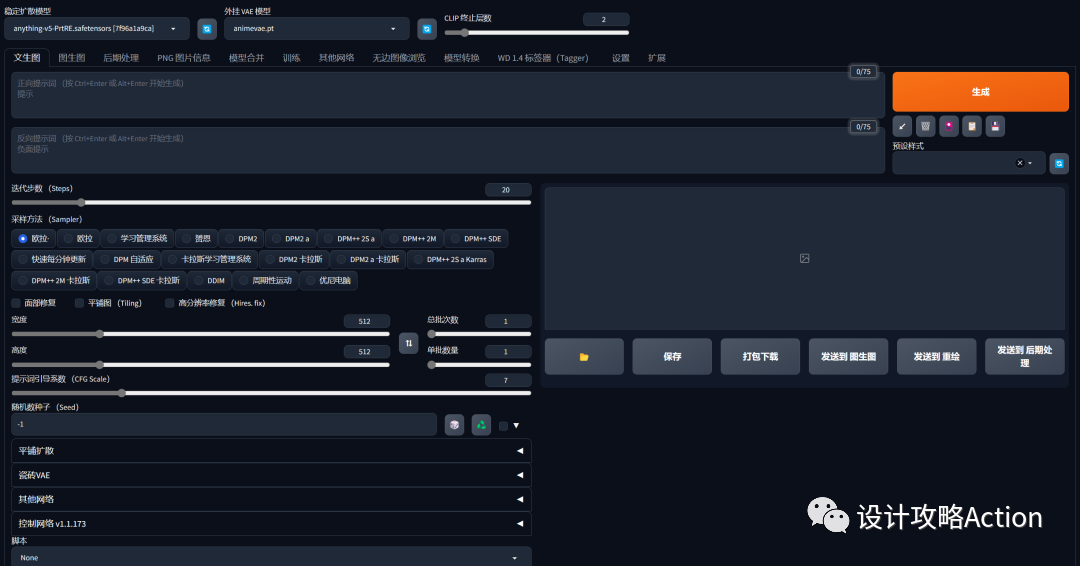

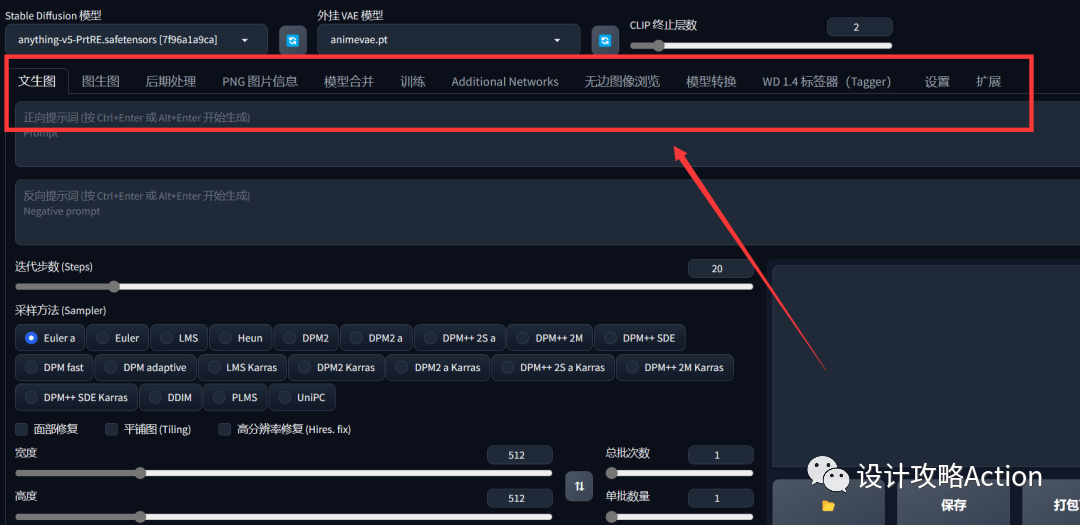

在Stable Diffusion界面最左上角就是主模型的切换,初始只有一个基础通用的anything模型。

可能有些小伙伴对模型的概念不太清楚,Checkpoint模型是SD能够绘图的基础模型,因此被称为大模型、底模型或者主模型,Web UI上就叫它Stable Diffusion模型。

安装完SD软件后,必须搭配主模型才能使用。

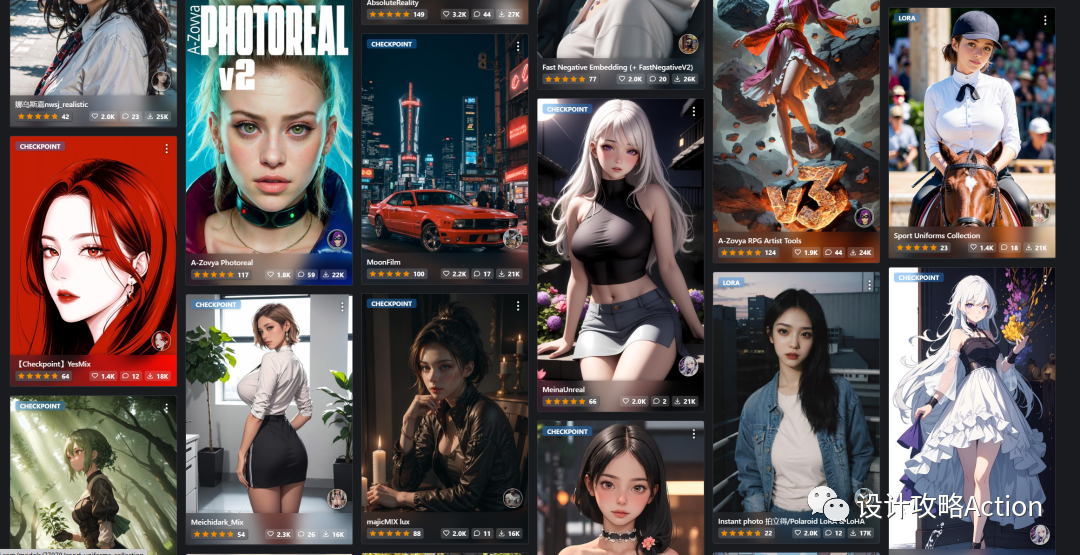

不同的主模型,其画风和擅长的领域会有侧重,例如卡通风、国风、水墨风、现实真人、赛博朋克、武侠、科幻风等。

相比于Midjourney,Stable Diffusion最大的优势就是开源。Midjourney靠开发人员开发的少数模型进行输出,SD则每时每刻都有人在世界各地训练自己的模型并免费公开共享给全世界的使用者。

因此,学会使用各类模型对于学习使用Stable Diffusion非常重要。

在启动器的模型管理中已经有大佬们上传的各类模型,可以直接下载添加到本地,但下载添加后要注意需重新启动。

在大家也可以到civitai.com/上查看下载各类模型,大部分模型都有作者分享的提示词、参数等,支持直接下载。

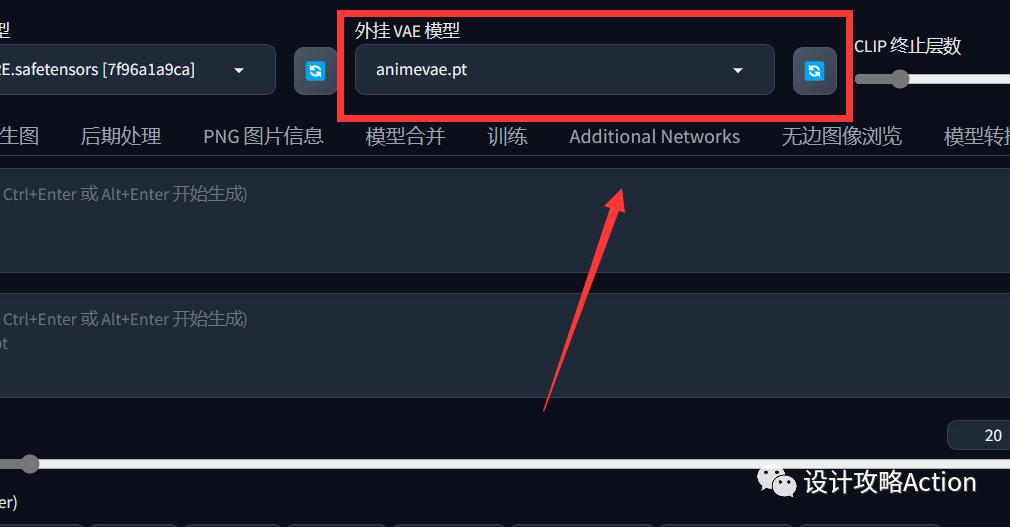

相与主模型挨着的就是VAE模型:

VAE,全名Variational autoenconder,中文叫变分自编码器。作用是:滤镜+微调。

有的大模型是会自带VAE的,比如Chilloutmix。如果再加VAE则可能画面效果不会更好,甚至适得其反。

CLIP 终止层数,值越大丢失的提示词越多,例如:提示词为“拿着火柴的女孩”,当Clip skip调大,出来的结果可能只有女孩。

文生图:根据文本提示生成图像

图生图:根据提供的图像作为范本、结合文本提示生成图像

后期处理:对生成的图进行后期加工,如放大、修复、去除背景、蒙版等

图片信息:显示图像基本信息,包含提示词和模型信息(除非信息被隐藏)

模型合并:把已有的模型按不同比例进行合并生成新模型

训练:根据提供的图片训练具有某种图像风格的模型

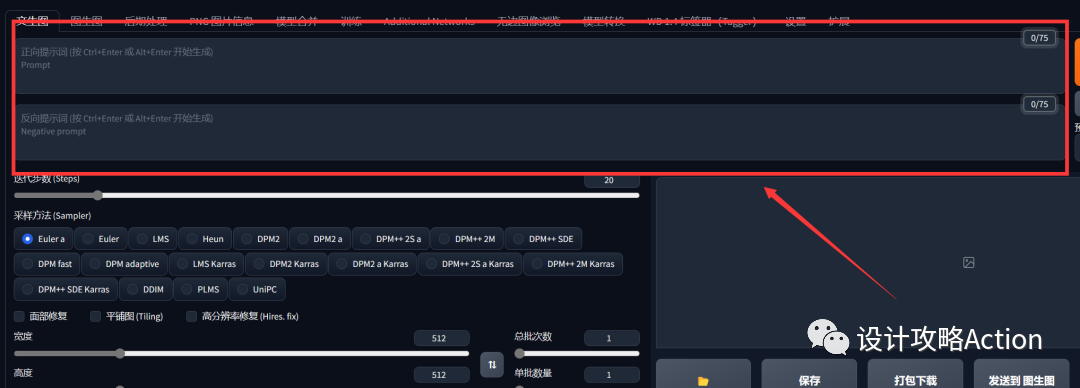

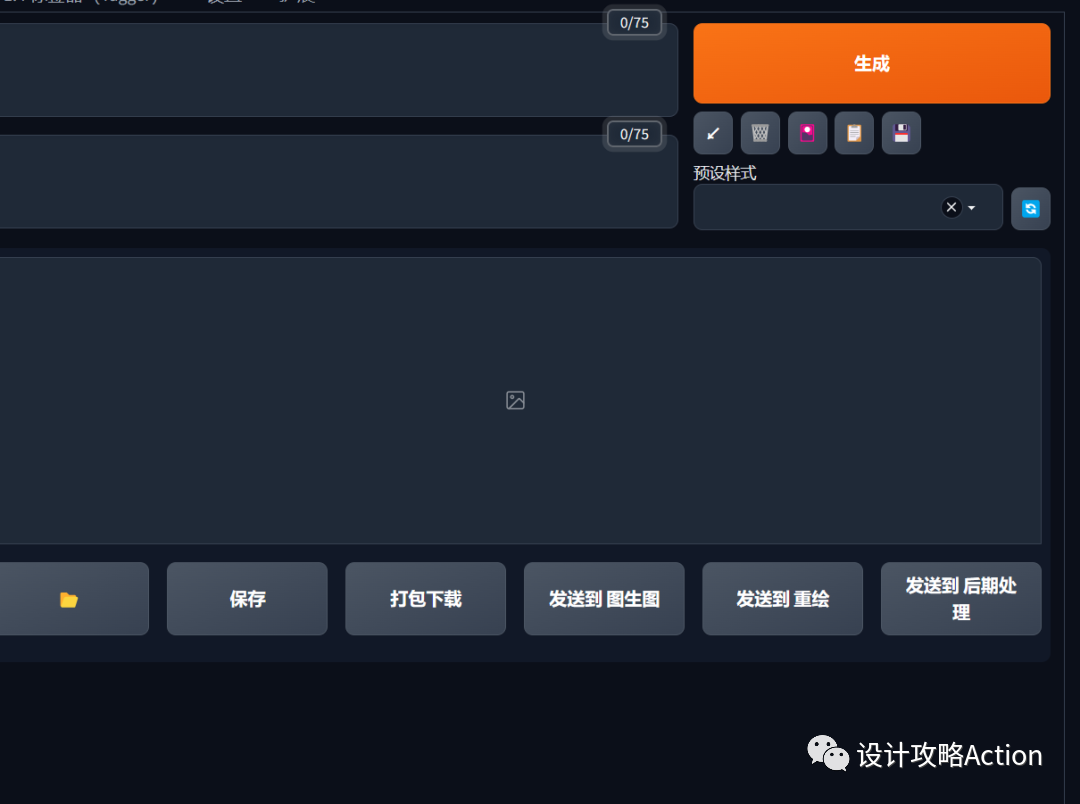

描述语分为正向/负向描述,它们也叫tag(标签)或prompt(提示词)

正面提示词:相比Midjourney需要写得更精准和细致,描述少就给AI更多自由发挥空间。

负面提示词:不想让SD生成的内容。

生成下面的5个小图标(从左到右依次分别是)

复原上次生成图片的提示词(自动记录)

清空当前所有提示词

打开模型选择界面

应用选择的风格模板到当前的提示词

存档当前的正反向提示词

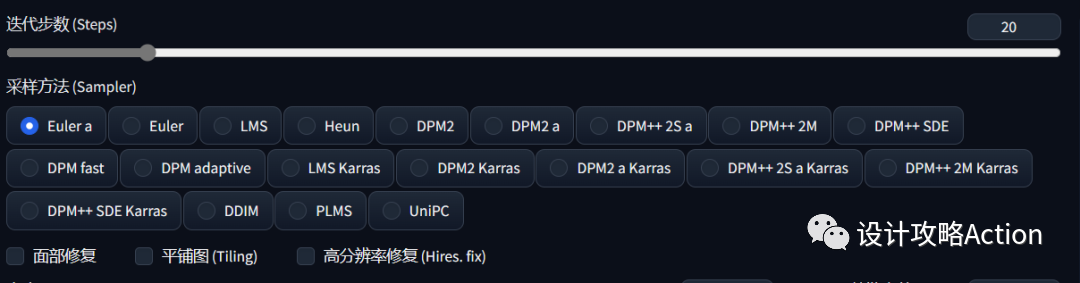

采样方法

Stable Diffusion中提供了19种采样方法(Sampler)可以选择,看着名字就觉得比较头晕,当然他们背后都是有科学的解释,但是想要都搞明白原理并不是很切合实际。还不如直接看看实际效果来感受一下,然后选觉得最合适的来用就好了。

采样步数

简单理解就是生成的细节程度,快速粗略测试10-15就可以,如果对出的图比较满意就25,细化例如是有毛皮的动物或有纹理的主题,生成的图像缺少一些细节,就提高到40

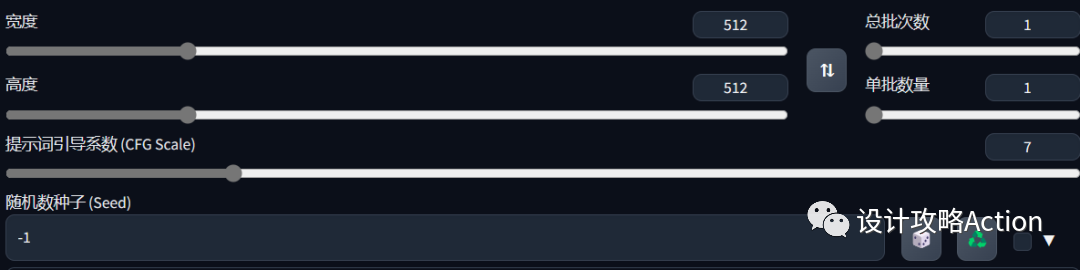

长宽尺寸(分辨率):即生成图的长宽尺寸

总批次数:每次生成图像的组数。一次运行生成图像的数量为生成批次 * 每批数量。

单批数量:同时生成多少个图像。

点击生成后,输出的图片都会出现在图示下方,可选择保存位置、保存、打包下载,或者直接发送到图生图、重绘以及后期处理。

以上即为攻略妹的简单介绍及教程,目前SD并不存在通行可靠的使用规范,每个人的电脑配置、需求都不尽相同,再到模型、插件、提示词、参数调整等组合牵一发则动全身,需要大家耐心查看说明文档及各种学习,现在就快来下载使用吧~

资源获取

下方公众号对话框内

回复 SD

即可直接获取

高效设计,创意分享

致力于生产收藏级干货

?查看攻略妹往期高效攻略 ?