1.逻辑回归的定位

机器学习分有监督和无监督以及半监督学习三种,

其中有监督学习主要分为分类问题和回归问题;

无监督主要是聚类的算法

-

其中逻辑回归是属于分类问题

跟上次讲的线性回归有不同,从字面上确实容易混淆

2.逻辑回归的概念

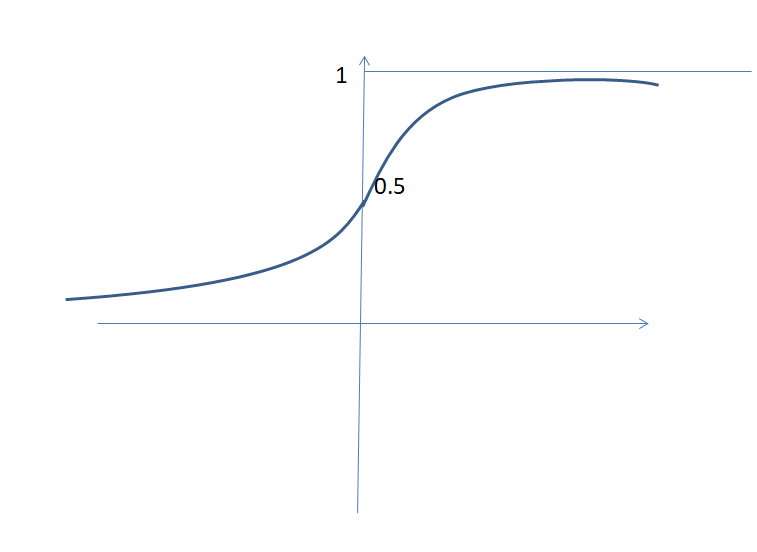

逻辑回归是在线性回归的基础上加上一个非线性的因素(sigmoid函数)(它是一个激活函数),并且设置了阈值,其实就是防止数据过大,给它进行压缩。

3.逻辑回归的模型函数:

- P(Y=1|x)=e(w*x+b)/(1+e(w*x+b))

- P(Y=0|x)=1/(1+e^(wx+b))

其中w 是特征的权重,b是偏置,已经说过不再详细解释,其中wx+b可看成对x的线性函数。

对比上面两个概率值,哪个大就是x要分到的那个类。

这就是分类的一个过程,通过这两个函数去筛选。

sigmoid函数,它是-∞,无限趋于0,+∞,无限趋于1,所以可以把数据压缩在0,1之间,导数在0处最大。

投影到那个线上,A点下和上各为一类

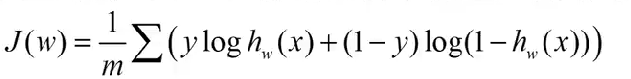

4.损失函数

利用最大似然估计计算出逻辑回归的损失函数是:

y是真实值,可以通过算法来求所有w的值。

5.多分类问题

从上可知,我们只分两类的原因在于激活函数的选取,因为利用sigmoid函数只能由1和0两个值,所以我们可引进更多函数,比如softmax函数,f(x)=e^zi/Σezk;

它的求和等于1,一共k个类,每一个都进行分类提取特征。

6.最后,总结

-

逻辑回归是在线性回归的基础上加上一个非线性的因素(sigmoid函数)(这是二分类)

-

sigmoid函数,它是-∞,无限趋于0,+∞,无限趋于1,所以可以把数据压缩在0,1之间,导数在0处最大。

- 回归模型:

- P(Y=1|x)=e(w*x+b)/(1+e(w*x+b))

- P(Y=0|x)=1/(1+e^(w*x+b))

-

多分类问题:sigmoid函数换成softmax函数,f(x)=e^zi/Σezk,其它操作都是一样的,只不过取的时候,是取最高的概率的那一类分到那一类。