安装anaconda

1.首先安装spark,在安装spark之前需要安装anaconda

可以到清华大学镜像源下载:

https://mirrors.tuna.tsinghua.edu.cn/anaconda/archive/

以镜像源为例:

由于使用python3.8,anaconda下载的版本是:Anaconda3-2021.05-Linux-x86_64.sh

2.下载完成后上传到linux服务器上

#然后通过sh Anaconda3-2021.05-Linux-x86_64.sh来进行安装

sh Anaconda3-2021.05-Linux-x86_64.sh

#安装完成后创建pyspark环境:

conda create -n pyspark python=3.8

#然后可以通过conda activate pyspark激活当前环境

conda activate pyspark

#然后需要在虚拟环境中安装jieba包:

pip install pyhive pyspark jieba -i https://pypi.tuna.tsinghua.edu.cn/simple

#jieba包是Python中一个常用的中文分词库,它的作用是将中文文本进行分词处理

3.常用的conda指令如下:

禁止激活默认base环境:

conda config --set auto_activate_base false

#创建环境:

conda create -n env_name

#查看所有环境:

conda info --envs

#查看当前环境中安装的所有包:

conda list

#查看当前环境中安装的某一个包的信息:

conda list --show <package_name>

#删除一个环境:

conda remove -n env_name --all

激活环境:conda activate airflow

退出当前环境:conda deactivate

4.安装完anaconda之后,进行spark的安装:

下载安装包(3.2版本):https://mirrors.tuna.tsinghua.edu.cn/apache/spark/spark-3.3.3/

#解压安装包到对应的路径:

tar -zxvf spark-3.2.0-bin-hadoop3.2.tgz -C /opt/module/

#安装路径名太长,可以通过mv来改名:

mv spark-3.2.0-bin-hadoop3.2 spark

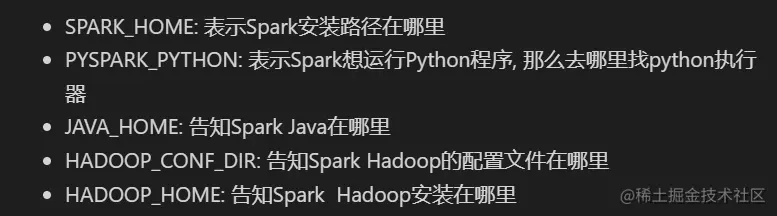

配置环境变量:还是在spark-env.sh中:

PYSPARK_PYTHON配置python的执行器,即我们安装的anaconda环境

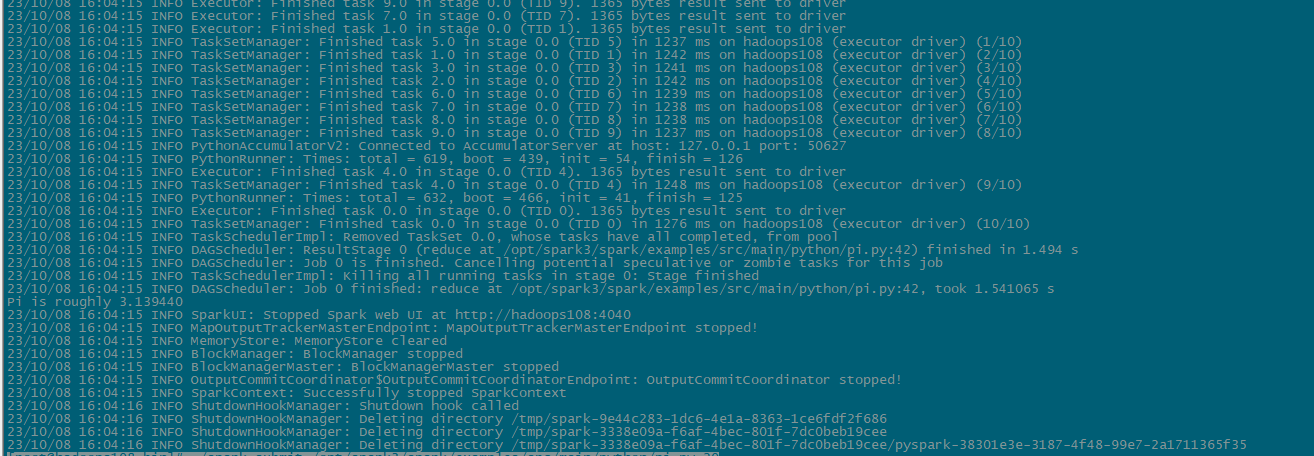

5.local模式

[root@hadoops108 bin]# ./spark-submit /opt/spark3/spark/examples/src/main/python/pi.py 20

参考大神链接:

https://juejin.cn/post/7228162548901904440?searchId=20231008110017F1EDC30501E137403A1A