由于课程上的需要,所以自己需要整理一下这几个Relu函数相关的含义,想来写到word也是写,写到博客也是写,挂博客上能多留点回忆。

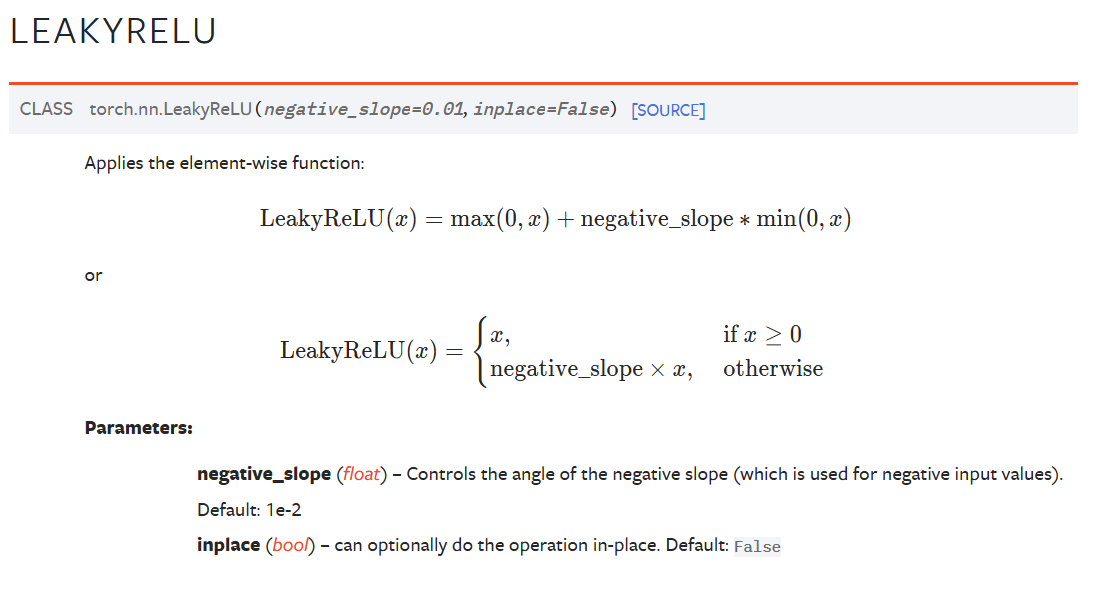

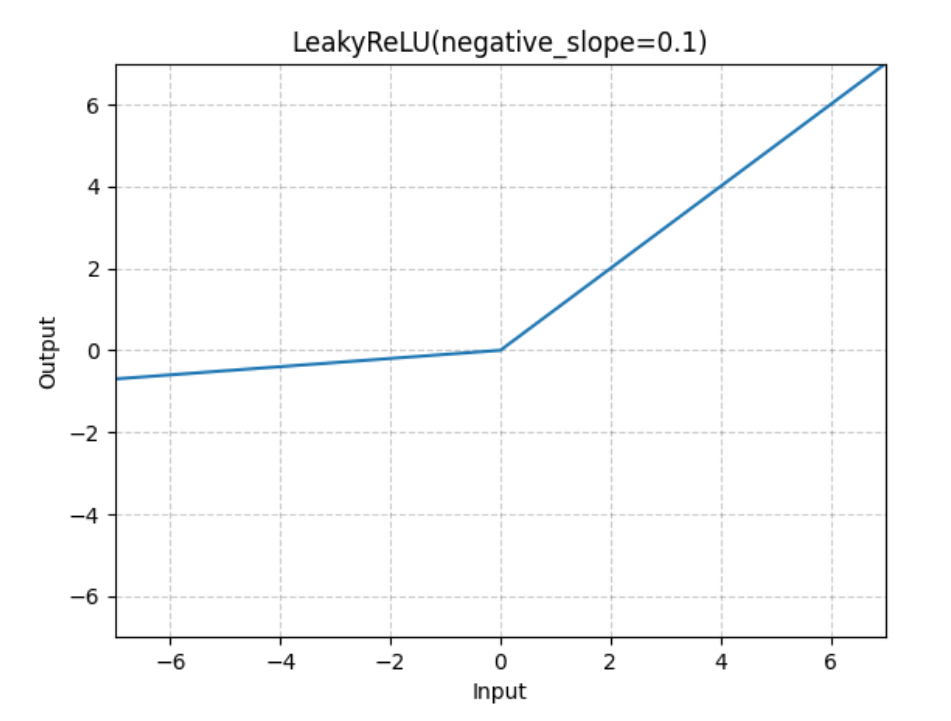

LeakyReLu

说到找函数,还是得去官网直接搜,咔一下,立马就搜到了。啊,那我肯定就直接复制着写。先看看官网里面的描述:

可以看得出来,做的不错,公式也很全面,啊,代码的参数也很完善,所以呢,不需要多想,直接抄到课程报告里,抄啊还不能直接复制,要怎么弄呢,给它充分的解释一下。就说,在负数范围俩面,通过增加一个常数因子,来对负数部分进行一个缩放,在保留负值的前提下,也能够让它有充分的激活函数的效果。啊,这样一说,显得就没那么敷衍了,再把公式一抄,写完一个了。

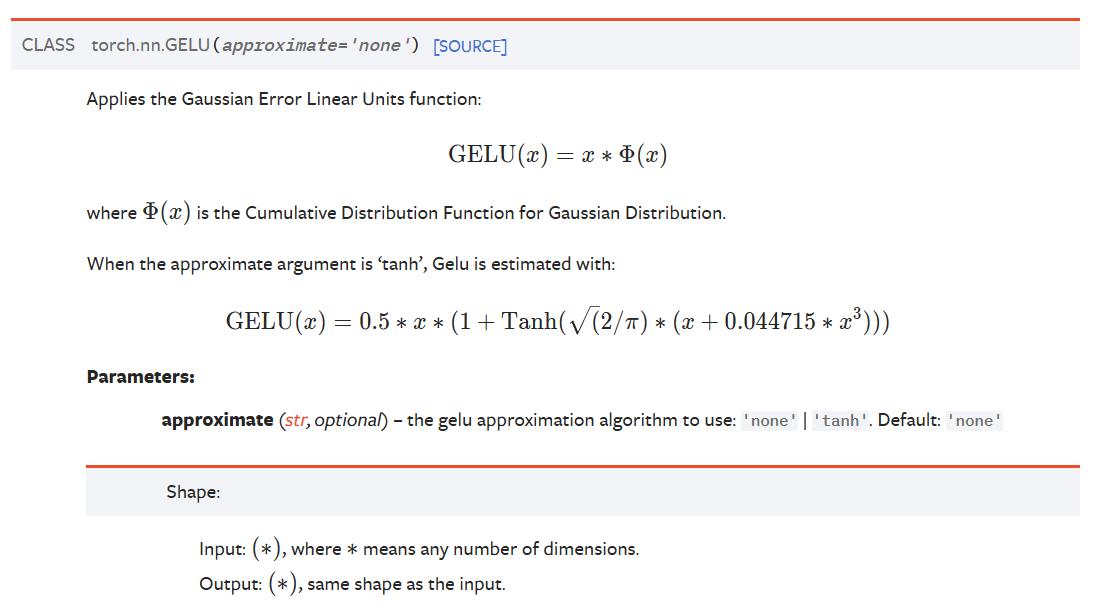

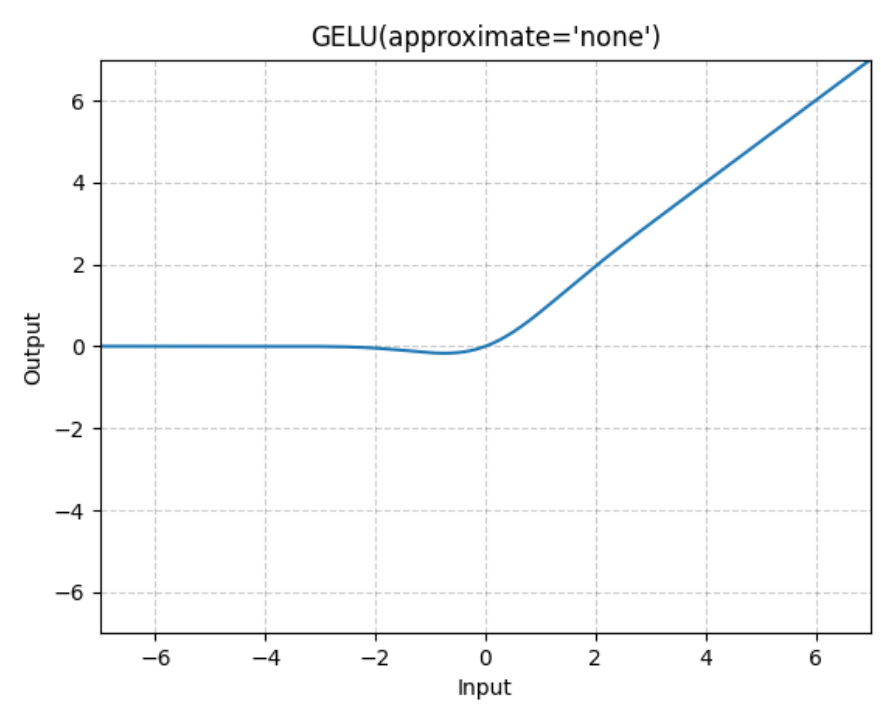

GELU

啊,这个的话,看上去就高级不少了,一看就长的不得了,完全不想理解。啊,仔细看看吧,函数看不懂,又是什么Tanh又是什么指数、三次幂,一堆看不懂的参数,头皮发麻。又仔细一看,嘶,看来没那么难,看上去就很恶心人那个,是tanh的,跟普通的无关,普通的是x 乘上 高斯累计分布函数,听上去也没那么复杂,就说结合高斯累计分布函数以及ReLu函数,同样起到保留负值与激活的作用。不错,还挺好说。最后再把公式一抄,又一个部分写完了。

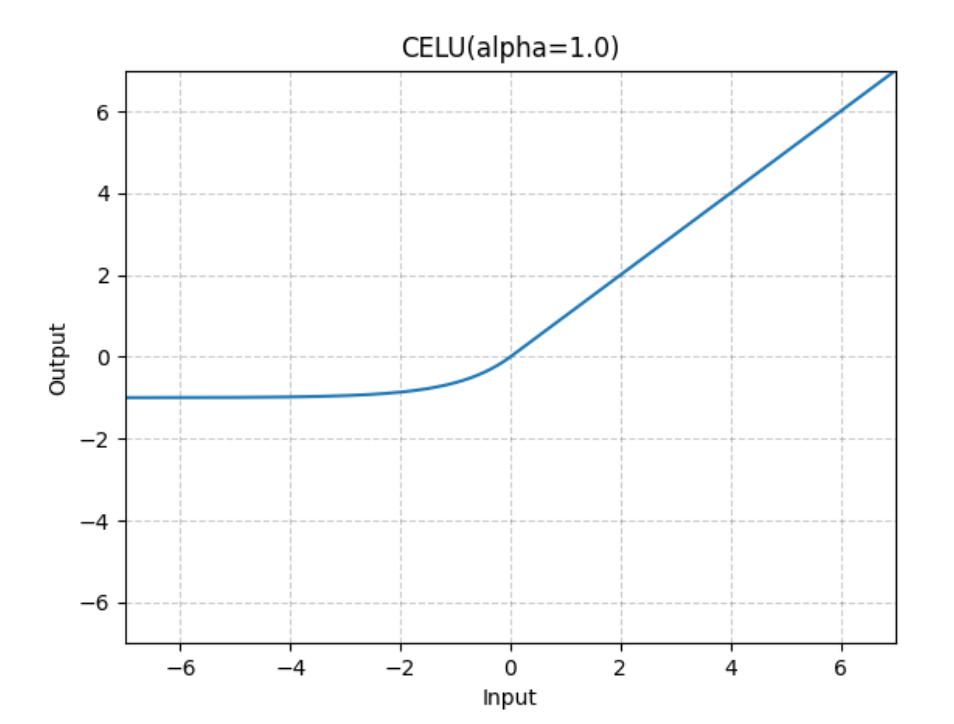

CELU

负数部分采用了加权指数+偏置的方式,让数值保持在-1,+无穷的区间,在进行激活过程中,数值变化相对来说更平缓,单调性也是固定的。就到这吧,先打CSGO去,晚会抄抄,结束。