2023年9月12日 深度学习课程是基于Pytorch框架

有的没的

因为之前瞎搞,环境乱七八糟,这次DL课程最好装上GPU版本,那么就通过这次一次性弄个好吧!绝对不是因为,我之前不会弄。(是这样的)

课程需要配置好环境。最后经过一段时间的瞎搞乱搞的调整,Pytorch-GPU版本成功安装好了。

我是根据B站--土堆教学【---->视频链接<----】,再加上我的特殊情况(总是CPU)版本的错误,进行修改从而达到的安装好的目的。

上面这个视频非常推荐观看!!

我的安装配置情况之前就弄不好

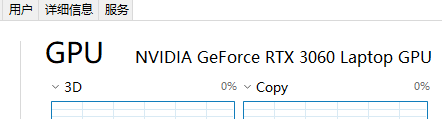

- 独立显卡:

NVIDIA GeForce 3060 Laptop - 电脑系统:

Windows 10 - Pytorch:

1.12.1 py3.10_cuda11.3_cudnn8_0 - CUDA:

11.3

一、基本流程

- 更新独显驱动(已经装了,不想更新也行)

- 确认

CUDA Driver版本,Pytorch版本 - 创建

conda的虚拟环境 - 通过指令安装

Pytorch - 配置好

Pycharm - 测试

Pytorch安装

二、开干! 【确认基本信息】

2.1确认自己的独立显卡型号。

去任务管理器啥的就有。我的显卡是GTX 3060 Laptop,算力是8.6

2.2 我们需要更新自己独立显卡的驱动。根据自己的情况进行安装最新的驱动。(已经装了,不想更新也行)

2.3 确认自己的显卡当前算力下支持的CUDA版本。

- 方法一:这里需要对比一下这个表~可以看到,因为我的算力是

8.6我就对着看,看11.1-11.4都是OK的。

- 方法二:通过

NVIDIA指令进行查询。

打开终端输入以下指令,会出现以下的信息。

nvidia-smi

可以看到,CUDA的版本是12.2,和刚才的11.1 - 11.4不匹配,我为了保险起见,最终还是选择了11.3的版本。它是可以不装最新的那个版本的。

三、开干!【实际安装】

3.1 创建Conda的虚拟环境

①用Prompt创建环境

在我们的Prompt中输入以下指令。Prompt就是这个

conda create -n DeepLearning -c https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/main

这段指令的意思就是创建一个虚拟环境:

- 名为

DeepLearning的虚拟环境 - 并且修改通道为清华的镜像

- 有询问输入

y即可

指令格式为:conda create -n 【环境名字】 -c 【通道链接】

②激活新创建的环境

通过以下指令进行激活。

conda activate DeepLearning

激活以后,左边的括号会改变哦。一开始我们是在base的环境下,激活后便到了DeepLearning下。

③安装需要的包

我这里踩坑两次,总是装成CPU版本。我们需要先安装一下anaconda,并且更新conda后面才能显示出来包的环境是否为GPU。

所以来到环境后我们可以先安装一个anaconda的一些包,保证conda指令较新。

conda install anaconda

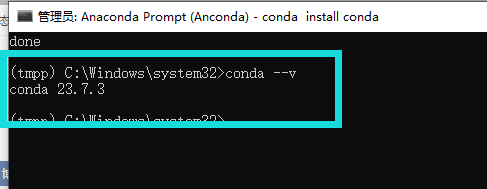

④更新conda

我们需要更新conda,我这个一装都是v-4.几最新的都23.多。使用以下指令:

conda update conda

如果出现如下提示:

说明没有用管理员方式打开,我们只要关掉,然后用管理员运行即可。

如果管理员还是这个德行。

我们就需要安装一下conda。使用指令,安装成功后再试试更新。然后可以用conda --v来查询版本。

conda install conda

变成上面这个求样子,这个运行完以后就虚拟环境部分结束了。终于弄好了,这一步卡了30分钟,我蠢撒子

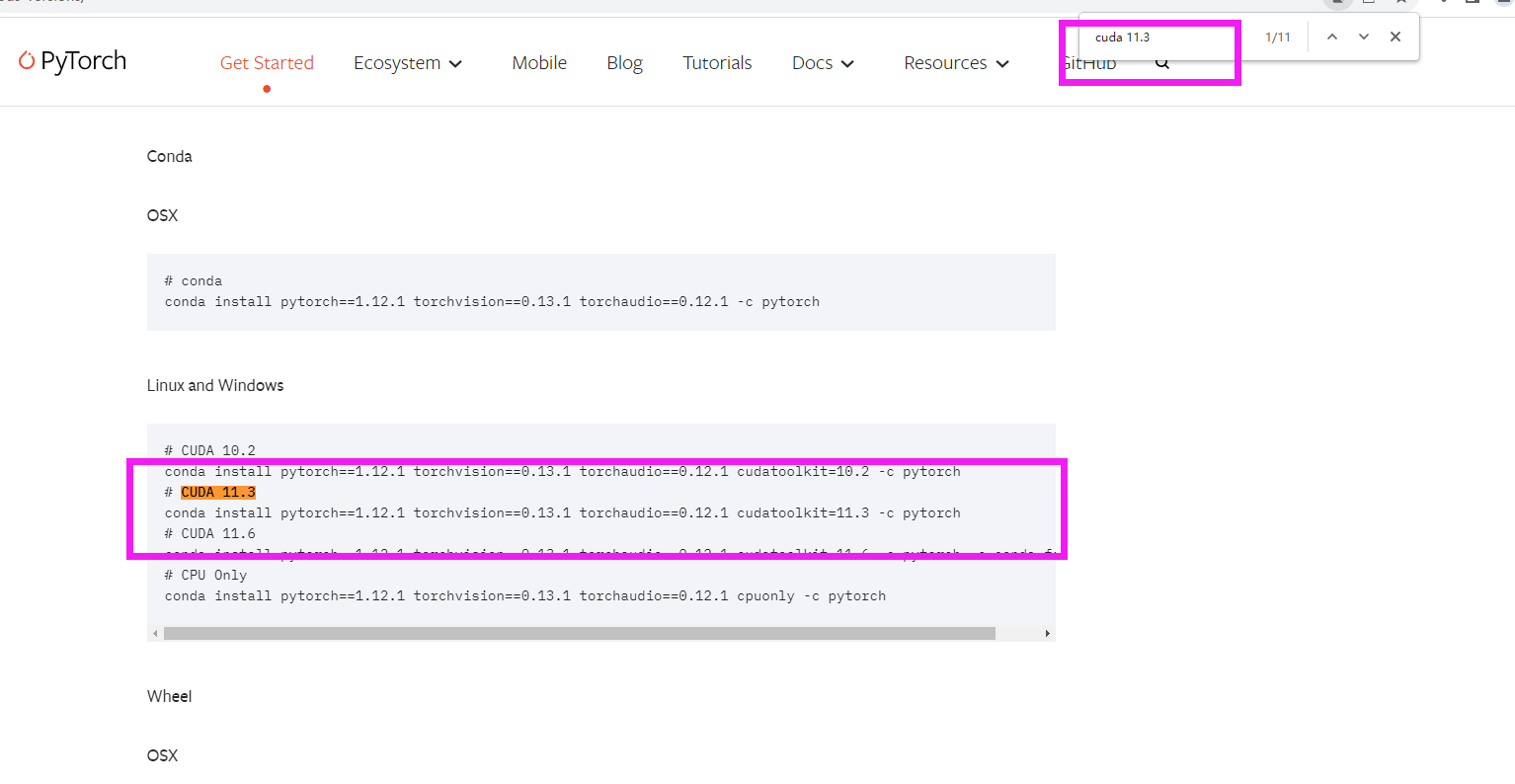

3.2 在Pytorch官网上找到自己的版本下载指令。

我们进入官网。Pytorch官网下载

不难看到,这版本都好新,11.8我怕装上用不了,我就去装旧的。点那个Previous。即可,进去后以你支持的CUDA版本,记好了是CUDA版本比如我的是CUDA 11.3。浏览器ctrl + f搜索。就会得到以下结果。

把这条代码复制过来就是:

conda install pytorch==1.12.1 torchvision==0.13.1 torchaudio==0.12.1 cudatoolkit=11.3 -c https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/pytorch/win-64/

此处,把最后的通道修改为了国内的通道,下的非常快,比原本的那个好一些。

3.3 返回虚拟环境

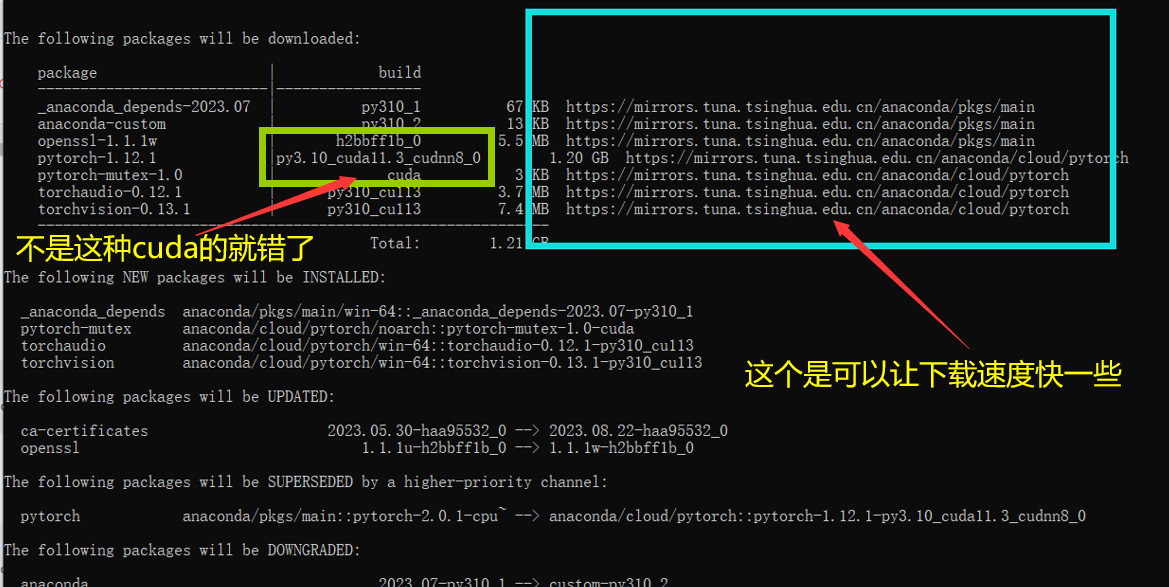

将指令输入到终端中,然后等待,就会出现以下的框框。

此处会对应几个情况,都是我遇到的!!我会一一说明。

- 如果此处,没有框框。是因为

conda的版本太低了,觉得没有安全感。你返回上面3.1的第④步自己去更新! - 但其实如果此处,没有框框。一直在转圈圈那你就等等它,极大概率会安装成功,只要之前做的是对的。

- 如果此处,

Pytorch不是cuda版本,显示了cpu说明官网指令不对,去复制官网的。 - 如果此处, 因为我先前装了

cudatollkit不是清华的镜像,就先取消安装把指令改为:

3.4 查看环境配置是否正确

输入以下指令,查看安装包。

conda list

会出现一长串,但是是排序好的,主要找这两个。

- 看看

pytorch是否是cuda的版本

- 看看

cudatoolkit安装了没。

如果都有了那就欧克!

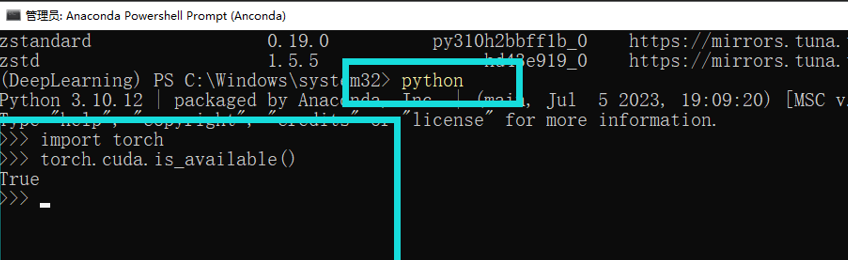

3.5 代码检查。

终端,输入以下指令。如果出现了True,哇靠!成啦!

python

import torch

print(torch.cuda.is_available())

四、配置Pycharm

4.1 创建一个新的文件

我们在配置的时候需要选择环境,用本地的环境,第一次是肯定看不到新创建的DeepLearning环境的。点击添加解释器。

选择,conda环境,然后选最新创建的那个DeepLearning。

4.2 等啊等等

输出代码

import torch

print(torch.cuda.is_available())

哇!输出True啦!如果是False就是安装错误需要重新做,或者你没有独立显卡啦!

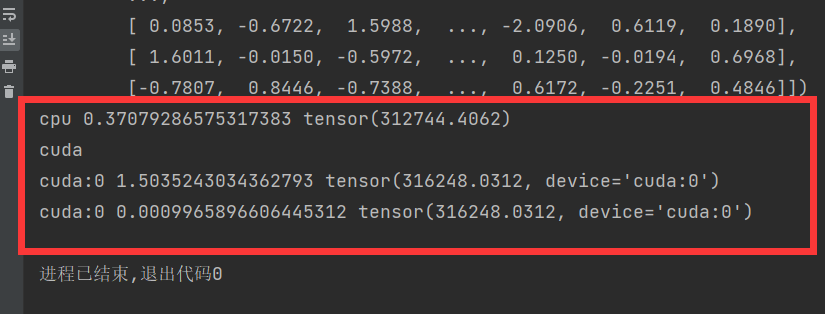

4.3 测试代码

把代码输入即可测试速度!这个是黏贴过来的!!【-->代码源地址<--】

import torch

import time

from torch import autograd

#GPU加速

print(torch.__version__)

print(torch.cuda.is_available())

a=torch.randn(10000,1000)

b=torch.randn(1000,10000)

print(a)

print(b)

t0=time.time()

c=torch.matmul(a,b)

t1=time.time()

print(a.device,t1-t0,c.norm(2))

device=torch.device('cuda')

print(device)

a=a.to(device)

b=b.to(device)

t0=time.time()

c=torch.matmul(a,b)

t2=time.time()

print(a.device,t2-t0,c.norm(2))

t0=time.time()

c=torch.matmul(a,b)

t2=time.time()

print(a.device,t2-t0,c.norm(2))

结束结束!!!!!祝自己能学点东西8........