prodigy优化器设置

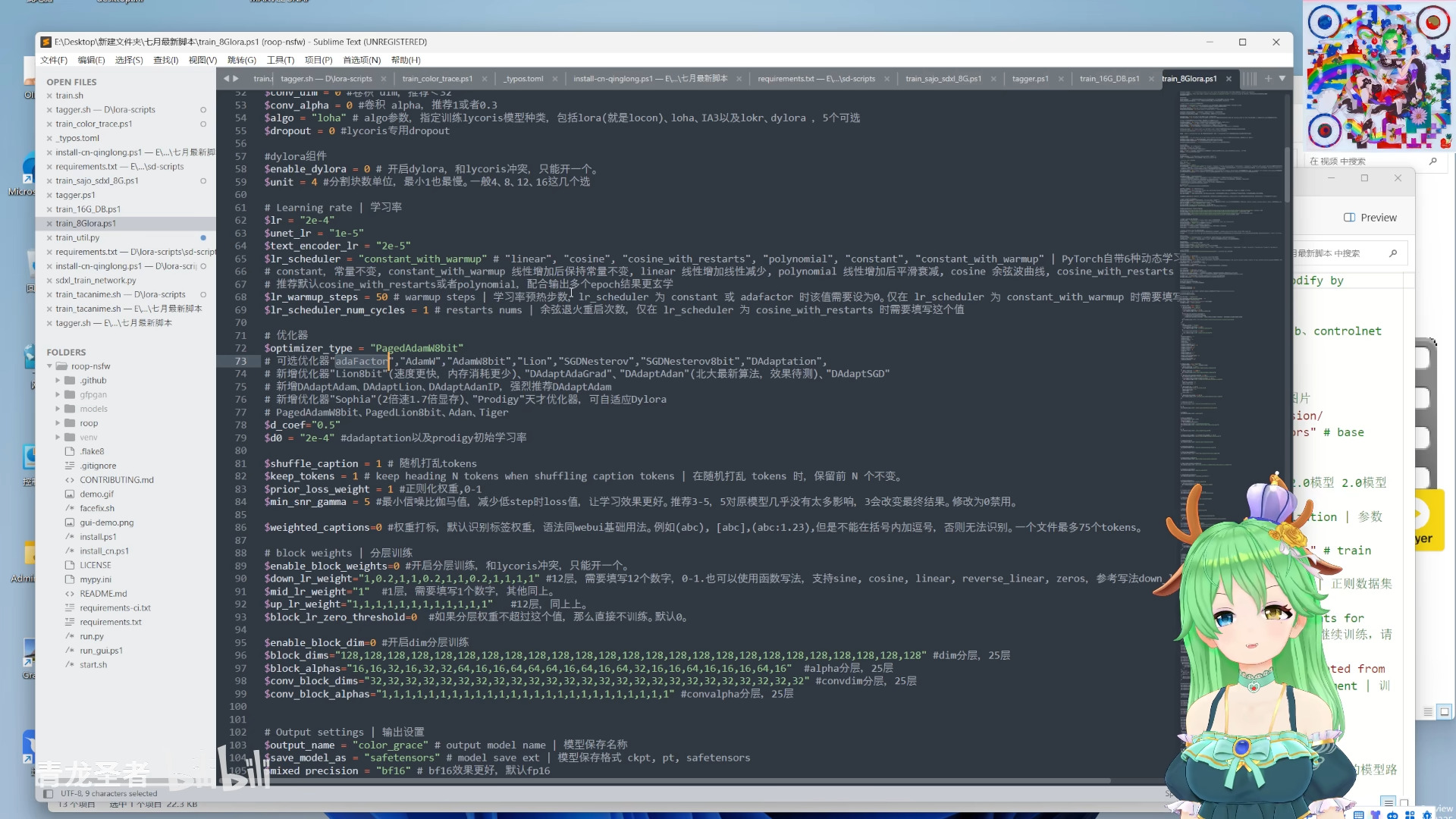

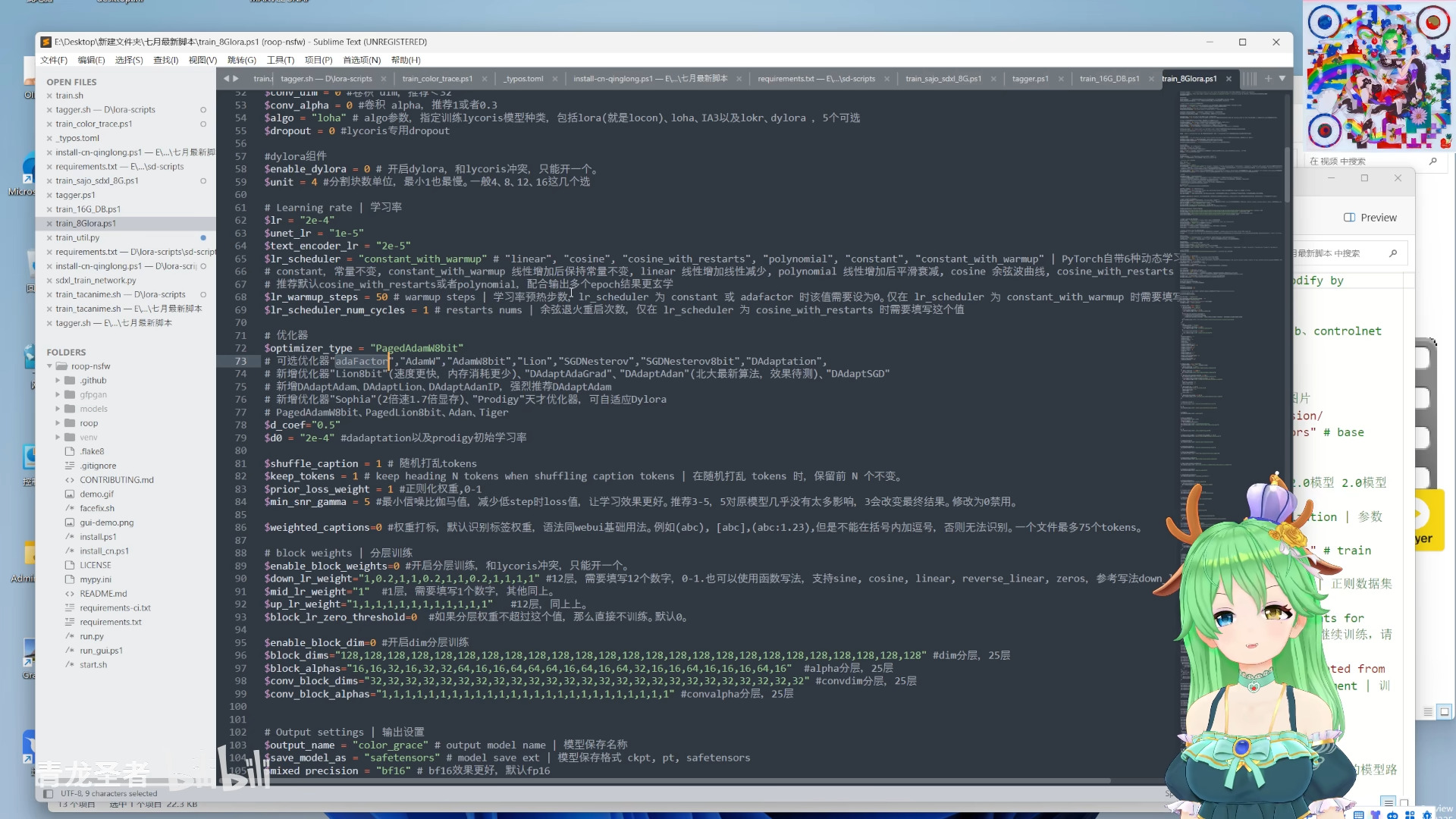

# Learning rate | 学习率

lr="1"

unet_lr="1"

text_encoder_lr="0"

lr_scheduler="constant_with_warmup" # "linear", "cosine", "cosine_with_restarts", "polynomial", "constant", "constant_with_warmup"

lr_warmup_steps=10 # warmup steps | 仅在 lr_scheduler 为 constant_with_warmup 时需要填写这个值

lr_restart_cycles=1 # cosine_with_restarts restart cycles | 余弦退火重启次数,仅在 lr_scheduler 为 cosine_with_restarts 时起效。

min_snr_gamma=4 #最小信噪比伽马值,减少低step时loss值,让学习效果更好。推荐3-5,5对原模型几乎没有太多影响,3会改变最终结果。修改为0禁用。

weighted_captions=0 #权重打标,默认识别标签权重,语法同webui基础用法。例如(abc), [abc], (abc:1.23),但是不能再括号内加逗号,否则无法识别。

# Merge lora and train | 差异提取法

base_weights=""

base_weights_multiplier="1.0"

# Block weights | 分层训练

enable_block_weights=0 #开启分层训练

down_lr_weight="1,0.2,1,1,0.2,1,1,0.2,1,1,1,1" #12层,需要填写12个数字,0-1.也可以使用函数写法,支持sine, cosine, linear, reverse_linear, zeros,参考写法down_lr_weight=cosine+.25

mid_lr_weight="1" #1层,需要填写1个数字,其他同上。

up_lr_weight="1,1,1,1,1,1,1,1,1,1,1,1" #12层,同上上。

block_lr_zero_threshold=0 #如果分层权重不超过这个值,那么直接不训练。默认0。

enable_block_dim=0 #开启分块dim训练

block_dims="64,64,64,64,64,64,64,64,64,64,64,64,64,64,64,64,64,64,64,64,64,64,64,64,64" #dim分块,25块

block_alphas="1,1,2,1,2,2,4,1,1,4,4,4,1,4,1,4,2,1,1,4,1,1,1,4,1" #alpha分块,25块

conv_block_dims="32,32,32,32,32,32,32,32,32,32,32,32,32,32,32,32,32,32,32,32,32,32,32,32,32" #convdim分块,25块

conv_block_alphas="1,1,1,1,1,1,1,1,1,1,1,1,1,1,1,1,1,1,1,1,1,1,1,1,1" #convalpha分块,25块

# Output settings | 输出设置

output_name="fuse_hand" # output model name | 模型保存名称

save_model_as="safetensors" # model save ext | 模型保存格式 ckpt, pt, safetensors

mixed_precision="bf16" # bf16效果更好但是30系以下显卡不支持,默认fp16

save_precision="bf16" # bf16效果更好但是30系以下显卡不支持,默认fp16

full_fp16=0 # 半精度全部使用fp16

full_bf16=1 # 半精度全部使用bf16

cache_latents=1 #缓存潜变量

cache_latents_to_disk=1 #开启缓存潜变量保存到磁盘,这样下次训练不用再次缓存转换,速度更快

no_half_vae=0 #禁止半精度,防止黑图。无法和mixed_precision混合精度共用。

# wandb

wandb_api_key=""

log_tracker_name=$output_name

# Sample output | 出图

enable_sample=1 #开启出图

sample_every_n_epochs=1 #每n个epoch出一次图

sample_prompts="./toml/sample_prompts.txt"

sample_sampler="euler_a"

# 其他设置

network_weights="" # pretrained weights for LoRA network | 若需要从已有的 LoRA 模型上继续训练,请填写 LoRA 模型路径。

enable_bucket=1 # arb for diff wh | 分桶

min_bucket_reso=640 # arb min resolution | arb 最小分辨率

max_bucket_reso=1536 # arb max resolution | arb 最大分辨率

persistent_data_loader_workers=1 # persistent dataloader workers | 容易爆内存,保留加载训练集的worker,减少每个 epoch 之间的停顿

clip_skip=2 # clip skip | 玄学 一般用 2

resume=""

# 优化器设置

#use_8bit_adam=1 # use 8bit adam optimizer | 使用 8bit adam 优化器节省显存,默认启用。部分 10 系老显卡无法使用,修改为 0 禁用。

#use_lion=0 # use lion optimizer | 使用 Lion 优化器

optimizer_type="Prodigy" # "adaFactor","AdamW8bit","Lion","DAdaptation", 推荐新优化器Lion。推荐学习率unetlr=lr=6e-5,tenclr=7e-6

# 新增优化器"Lion8bit"(速度更快,内存消耗更少)、"DAdaptAdaGrad"、"DAdaptAdan"(北大最新算法,效果待测)、"DAdaptSGD"

# 新增优化器 Sophia(2倍速1.7倍显存)、Prodigy天才优化器,可自适应Dylora

d0="2e-4"

d_coef="1"

青龙设置