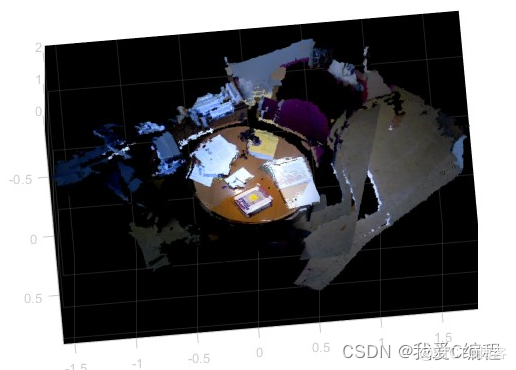

1.算法仿真效果

matlab2022a仿真结果如下:

2.算法涉及理论知识概要

三维点云室内重建是计算机视觉领域的一个重要研究方向,它可以为现实世界中的建筑空间提供高精度的三维模型。在这个领域中,SURF+AFFINE+RANSAC+ICP算法是一种常用的方法。本文将对这些算法进行详细介绍,并探讨它们在三维点云室内重建中的应用。

一、SURF算法

SURF(Speeded Up Robust Features)算法是一种用于图像特征匹配的算法,它可以快速且准确地检测出图像中的关键点,并计算出这些关键点的描述符。SURF算法的主要优点是具有高效性和鲁棒性,它可以在不同尺度和旋转角度下对图像进行特征匹配。SURF算法的实现基于高斯差分算子和海森矩阵的计算。在这个过程中,图像会被分成不同的尺度,并通过高斯差分来检测出关键点。然后,通过计算关键点周围像素的海森矩阵来得到关键点的描述符。最后,通过匹配描述符来找到两幅图像之间的对应点。

二、AFFINE算法

AFFINE(Affine Invariant Feature)算法是一种通过仿射变换来实现图像特征匹配的算法。与SURF算法不同的是,AFFINE算法可以在不同的仿射变换下对图像进行特征匹配,具有更高的鲁棒性。AFFINE算法的基本思想是通过计算二阶矩阵来描述特征点周围的图像结构,然后通过仿射变换来匹配这些特征点。AFFINE算法的实现需要进行以下步骤:首先,用高斯差分算子检测出特征点,并计算出特征点周围的二阶矩阵。然后,通过对二阶矩阵进行特征值分解来计算出特征向量和特征值。最后,通过对特征向量进行仿射变换来匹配特征点。

三、RANSAC算法

RANSAC(Random Sample Consensus)算法是一种用于估计模型参数的算法,它可以在存在噪声和异常值的情况下得到准确的模型参数。RANSAC算法的基本思想是通过随机抽样来选择一组数据,然后通过估计模型参数来计算出这组数据的误差,如果误差小于一个阈值,就将这组数据视为内点,否则就将它视为外点。通过重复这个过程,最终得到一个能够拟合大部分数据的模型。在三维点云室内重建中,RANSAC算法被用来估计点云中的平面或曲面模型,以便将点云分割成不同的区域。

四、ICP算法

ICP(Iterative Closest Point)算法是一种用于点云配准的算法,它可以将两个点云之间的对应点找到,并计算出它们之间的变换矩阵,以便将它们对齐。ICP算法的基本思想是通过不断迭代来寻找最优的变换矩阵,最终将两个点云对齐。

在三维点云室内重建中,ICP算法被用来将多个点云拼接成一个完整的三维模型。基于SURF+AFFINE+RANSAC+ICP算法的三维点云室内重建主要包括以下步骤:

通过激光扫描或RGB-D相机获取室内空间的点云数据。

对点云数据进行预处理,如去除噪声、滤波、降采样等。

使用SURF算法检测出点云中的关键点,并计算出关键点的描述符。

使用AFFINE算法在不同的仿射变换下对关键点进行匹配,并计算出匹配点对之间的变换矩阵。

使用RANSAC算法对匹配点对进行筛选,去除外点,得到一个可靠的匹配结果。

使用ICP算法将多个点云对齐,并拼接成一个完整的三维模型。

对三维模型进行后处理,如纹理映射、光照调整等。

最终生成一个高精度的三维室内模型。

基于SURF+AFFINE+RANSAC+ICP算法的三维点云室内重建具有高效性和鲁棒性,可以在不同的室内环境下得到准确的三维模型。

3.MATLAB核心程序

for i = 2:num_images

%加载下一个RGB和深度图像

[im2, d_img2] = load_images(i,imglistrgb,imglistdepth);

% SURF

[f2, vp2] = extractFeatures(rgb2gray(im2), detectSURFFeatures(rgb2gray(im2), 'MetricThreshold', SURF_threshold));

[idxPairs, ~] = matchFeatures(f1, f2);

p1 = double(vp1(idxPairs(:,1),:).Location); % [u1 v1]

p2 = double(vp2(idxPairs(:,2),:).Location); % [u2 v2]

%RGB图像2平面中的投影深度

[d_pos2, img2_pixels] = from_depth_to_RGB(d_img2,cam_params,rows,cols);

%使用NN为每个图像查找对应的3D点

[xyz_1] = match_2D_to_3D(img1_pixels, p1, d_pos1);

[xyz_2] = match_2D_to_3D(img2_pixels, p2, d_pos2);

%RANSAC(仿射)

num_SURF_matches = length(xyz_1);

max_inliers = 0;

SURF_pts = [xyz_1; xyz_2];

%RANSAC环路

........................................................................

%ICP迭代

for j = 1 : icp_num_iter

%将缩小后的图像2的点转换为图像1参考帧

xyz_pos2_in_1 = H_total*[d_pos2_red; ones(1, size(d_pos2_red, 2))];

xyz_pos2_in_1(4, :) = [];

%在图像1参考系中查找缩小图像2的最近点

xyz_pos1 = match_2D_to_3D(d_pos1, xyz_pos2_in_1', d_pos1);

%每个点的计算机错误

e_icp = (xyz_pos1 - xyz_pos2_in_1).*(xyz_pos1 - xyz_pos2_in_1);

e_icp = sqrt(sum(e_icp));

%移除距离较远的最近邻居

xyz_pos1(:, e_icp > e ) = [];

xyz_pos2_in_1(:, e_icp > e ) = [];

[R_icp, T_icp] = procrustes(xyz_pos1, xyz_pos2_in_1);

H_total = [R_icp T_icp; 0 0 0 1]\H_total;

end

end

% H transform %

aux_H{i,i} = eye(4);

for k = 1:i-1

aux_H{k,i} = H_total\aux_H{k,i-1};

aux_H{i,k} = inv(aux_H{k,i});

end

%Update

img1_pixels = img2_pixels;

d_pos1 = d_pos2;

f1 = f2;

vp1 = vp2;

end

for i = 1:num_images

transforms{i}.R = aux_H{i, 1}(1:3, 1:3);

transforms{i}.T = aux_H{i, 1}(1:3, 4);

end

end