梯度检验应用的注意事项

分享一些关于如何在神经网络实施梯度检验的实用技巧和注意事项。

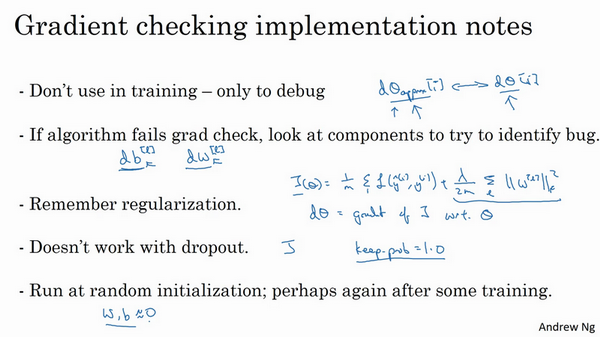

首先,不要在训练中使用梯度检验,它只用于调试。意思是,计算所有\(i\)值的\(d\theta_{\text{approx}}\left[i\right]\)是一个非常漫长的计算过程,为了实施梯度下降,必须使用\(W\)和\(b\) backprop来计算\(d\theta\),并使用backprop来计算导数,只要调试的时候,才会计算它,来确认数值是否接近\(d\theta\)。完成后,会关闭梯度检验,梯度检验的每一个迭代过程都不执行它,因为它太慢了。

第二点,如果算法的梯度检验失败,要检查所有项,检查每一项,并试着找出bug,也就是说,如果\(d\theta_{\text{approx}}\left[i\right]\)与dθ[i]的值相差很大,要做的就是查找不同的i值,看看是哪个导致\(d\theta_{\text{approx}}\left[i\right]\)与\(d\theta\left[i\right]\)的值相差这么多。举个例子,如果发现,相对某些层或某层的\(\theta\)或\(d\theta\)的值相差很大,但是\(\text{dw}^{[l]}\)的各项非常接近,注意\(\theta\)的各项与\(b\)和\(w\)的各项都是一一对应的,这时,可能会发现,在计算参数\(b\)的导数\(db\)的过程中存在bug。反过来也是一样,如果发现它们的值相差很大,\(d\theta_{\text{approx}}\left[i\right]\)的值与\(d\theta\left[i\right]\)的值相差很大,会发现所有这些项目都来自于\(dw\)或某层的\(dw\),可能帮定位bug的位置,虽然未必能够帮准确定位bug的位置,但它可以帮助估测需要在哪些地方追踪bug。

第三点,在实施梯度检验时,如果使用正则化,请注意正则项。如果代价函数\(J(\theta) = \frac{1}{m}\sum_{}^{}{L(\hat y^{(i)},y^{(i)})} + \frac{\lambda}{2m}\sum_{}^{}{||W^{[l]}||}^{2}\),这就是代价函数\(J\)的定义,\(d\theta\)等于与\(\theta\)相关的\(J\)函数的梯度,包括这个正则项,记住一定要包括这个正则项。

第四点,梯度检验不能与dropout同时使用,因为每次迭代过程中,dropout会随机消除隐藏层单元的不同子集,难以计算dropout在梯度下降上的代价函数\(J\)。因此dropout可作为优化代价函数\(J\)的一种方法,但是代价函数J被定义为对所有指数极大的节点子集求和。而在任何迭代过程中,这些节点都有可能被消除,所以很难计算代价函数\(J\)。只是对成本函数做抽样,用dropout,每次随机消除不同的子集,所以很难用梯度检验来双重检验dropout的计算,所以一般不同时使用梯度检验和dropout。如果想这样做,可以把dropout中的keepprob设置为1.0,然后打开dropout,并寄希望于dropout的实施是正确的,还可以做点别的,比如修改节点丢失模式确定梯度检验是正确的。实际上,一般不这么做,建议关闭dropout,用梯度检验进行双重检查,在没有dropout的情况下,算法至少是正确的,然后打开dropout。

最后一点,也是比较微妙的一点,现实中几乎不会出现这种情况。当\(w\)和\(b\)接近0时,梯度下降的实施是正确的,在随机初始化过程中……,但是在运行梯度下降时,\(w\)和\(b\)变得更大。可能只有在\(w\)和\(b\)接近0时,backprop的实施才是正确的。但是当\(W\)和\(b\)变大时,它会变得越来越不准确。需要做一件事,不经常这么做,就是在随机初始化过程中,运行梯度检验,然后再训练网络,\(w\)和\(b\)会有一段时间远离0,如果随机初始化值比较小,反复训练网络之后,再重新运行梯度检验。