要使用 CMake 和 TNN 库基于 C++ 实现神经网络模型的推理预测,你需要按照以下步骤进行操作:

- 准备环境

确保已安装 CMake 和 C++ 编译器。并从 TNN 的 GitHub 仓库下载源代码(https://github.com/Tencent/TNN)。

- 编译 TNN

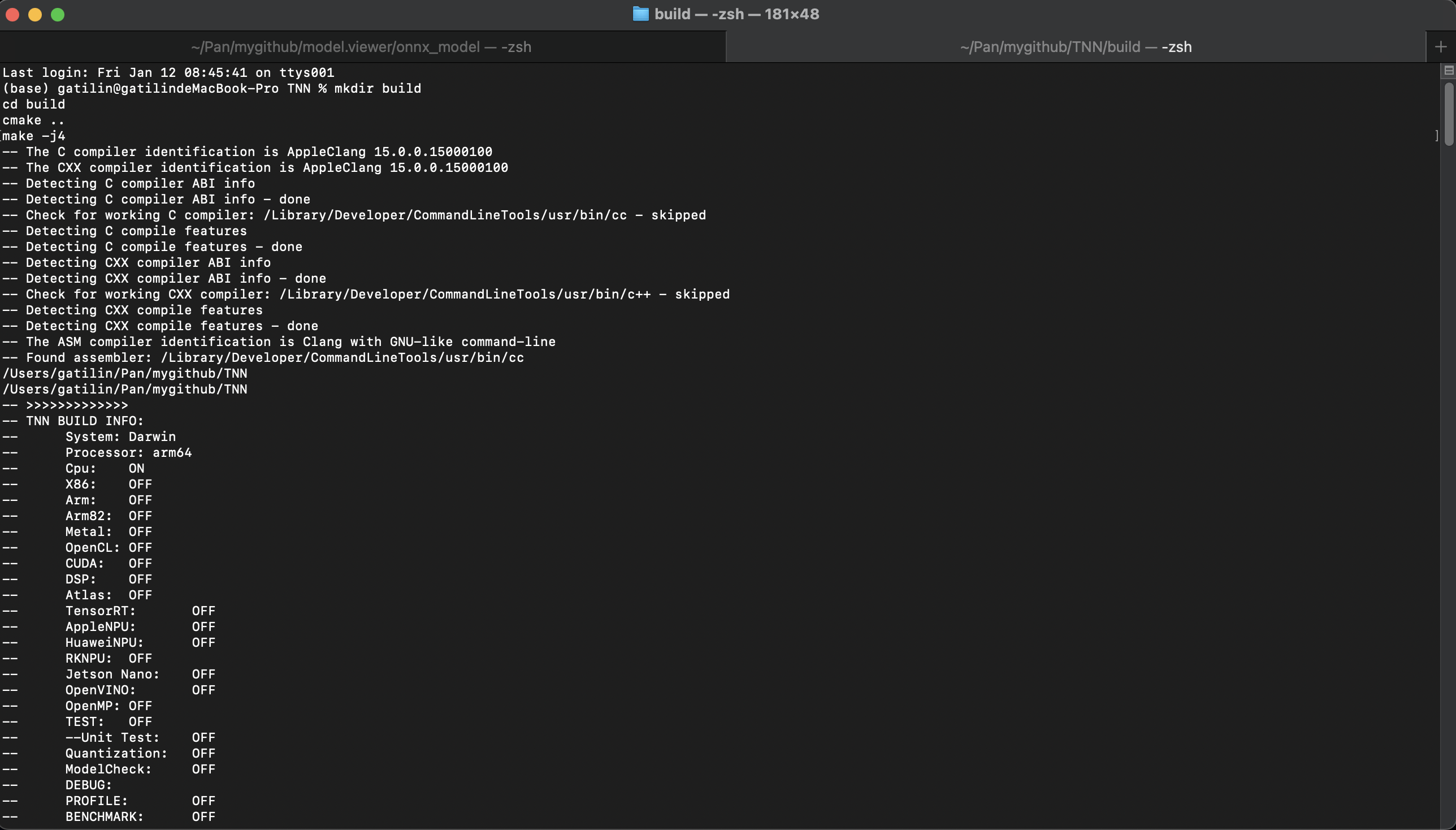

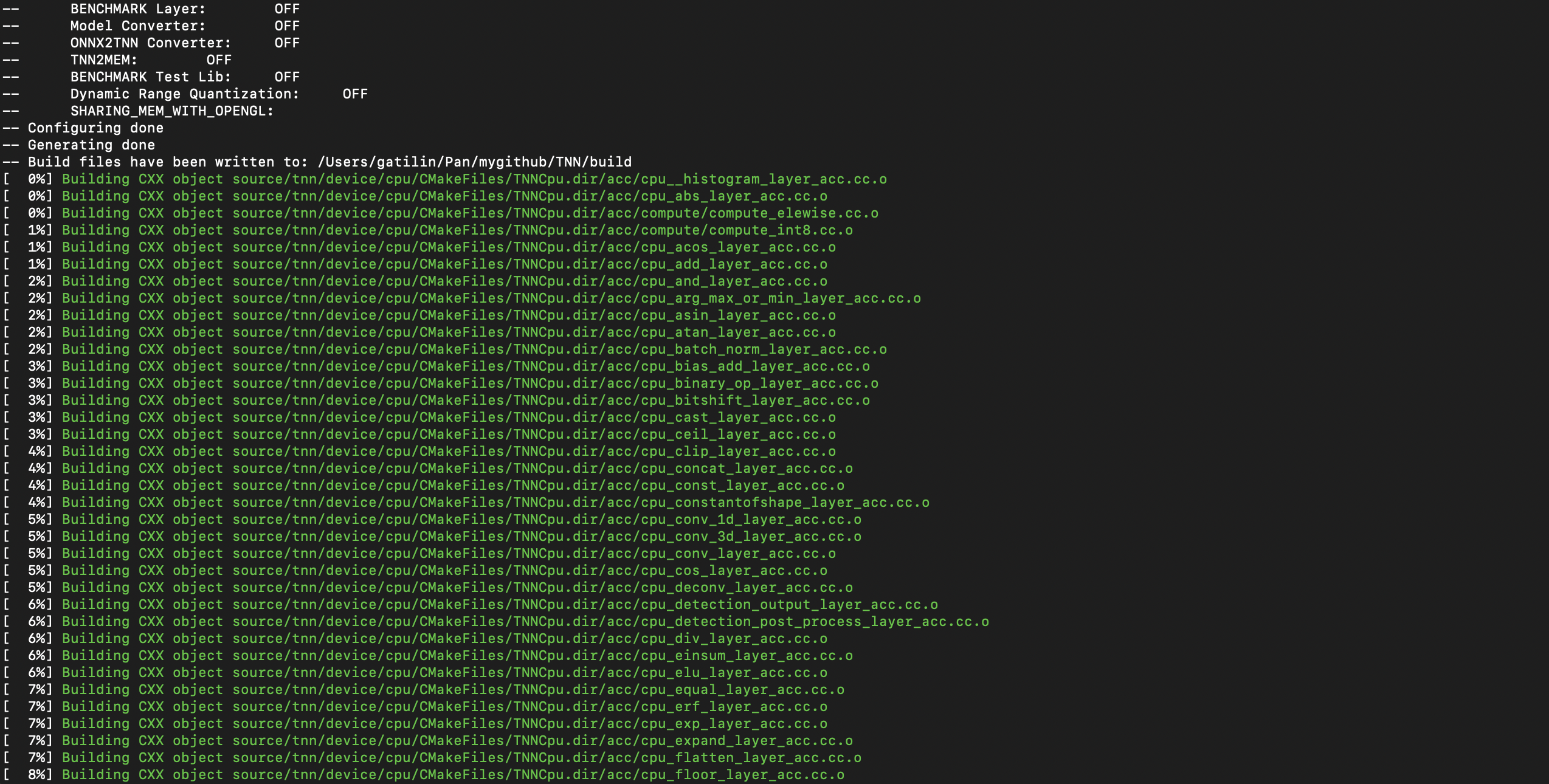

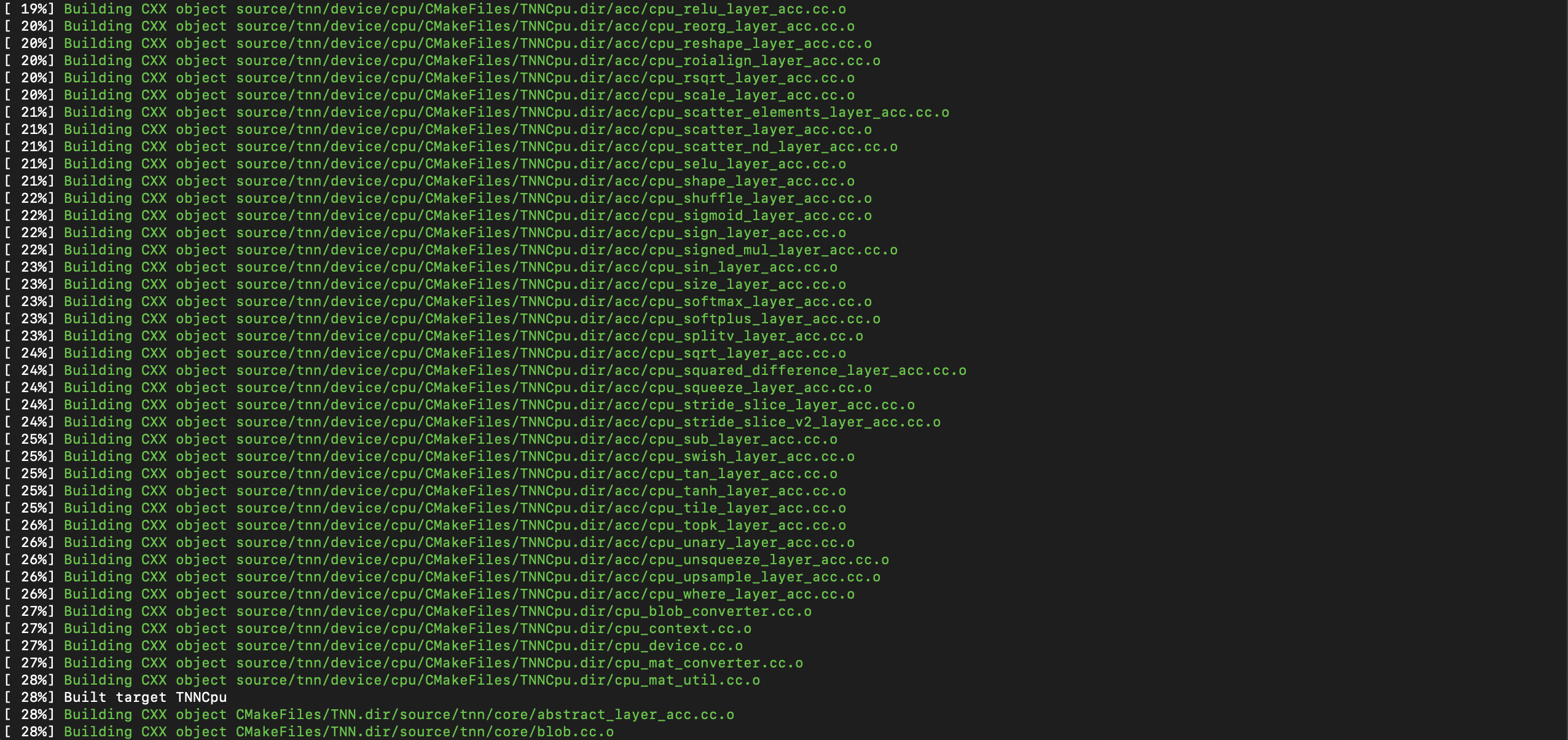

在 TNN 根目录下创建一个新目录,例如 build,然后进入该目录并运行以下命令:

mkdir build

cd build

cmake ..

make -j4

这将在 build 目录下生成 TNN 库文件。

过程如下:

- 创建你的项目

创建一个新的 C++ 项目,例如 TNNInference。在该项目中创建一个名为 CMakeLists.txt 的文件,用于配置 CMake。以下是一个示例:

cmake_minimum_required(VERSION 3.10)

project(TNNInference)

set(CMAKE_CXX_STANDARD 11)

# 添加 TNN 头文件和库文件路径

include_directories(${CMAKE_CURRENT_SOURCE_DIR}/path/to/TNN/include)

link_directories(${CMAKE_CURRENT_SOURCE_DIR}/path/to/TNN/lib)

add_executable(TNNInference main.cpp)

# 链接 TNN 库

target_link_libraries(TNNInference TNN)

- 编写 C++ 代码

在 main.cpp 中编写 C++ 代码,使用 TNN 进行模型推理。以下是一个简单的示例:

#include <iostream>

#include "tnn/core/common.h"

#include "tnn/core/tnn.h"

int main() {

// 创建 TNN 实例

std::shared_ptr<TNN_NS::TNN> tnn = std::make_shared<TNN_NS::TNN>();

// 配置模型文件路径

TNN_NS::ModelConfig model_config;

model_config.params.push_back("path/to/your/model.proto");

model_config.params.push_back("path/to/your/model.bin");

// 初始化 TNN

TNN_NS::Status status = tnn->Init(model_config);

if (status != TNN_NS::TNN_OK) {

std::cerr << "TNN init failed: " << status.description() << std::endl;

return -1;

}

// 创建输入和输出 Blob

TNN_NS::Blob input_blob, output_blob;

// 进行模型推理

status = tnn->Forward(&input_blob, &output_blob);

if (status != TNN_NS::TNN_OK) {

std::cerr << "TNN forward failed: " << status.description() << std::endl;

return -1;

}

// 获取并处理输出结果

// ...

return 0;

}

请注意,你需要根据你的模型和数据修改代码,例如设置输入 Blob 的形状、填充输入数据等。

- 编译和运行项目

在项目根目录下创建一个新目录,例如 build,然后进入该目录并运行以下命令:

mkdir build

cd build

cmake ..

make

./TNNInference

这将编译并运行你的项目,使用 TNN 库进行模型推理。

以上步骤将帮助你使用 CMake 和 TNN 库基于 C++ 实现神经网络模型的推理预测。