本篇博客跟大家分享一下如何在VMware虚拟机集群上部署HDFS集群

一·、下载hadoop安装包

进入官网:https://hadoop.apache.org 下载hadoop安装包

由于Apache Hadoop是国外网址,下载安装包对于网络要求较高

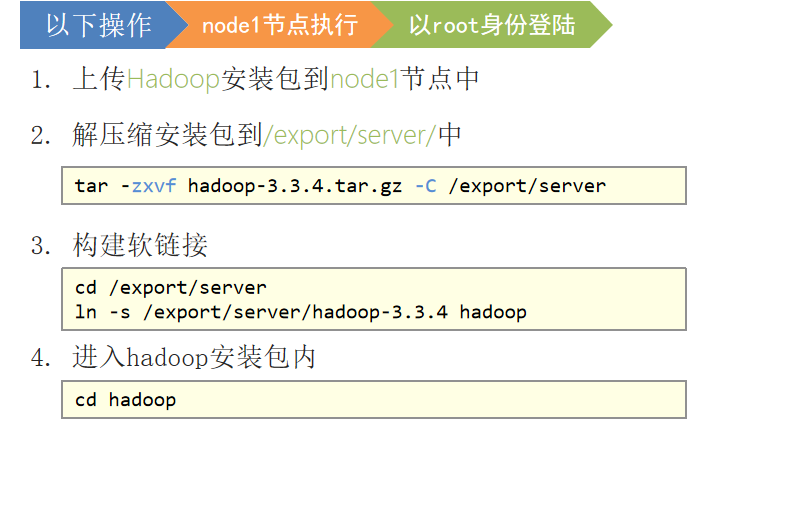

二、上传压缩包,进行解压

在进行解压之前,保证自己已经完成vmwa的黄静配置

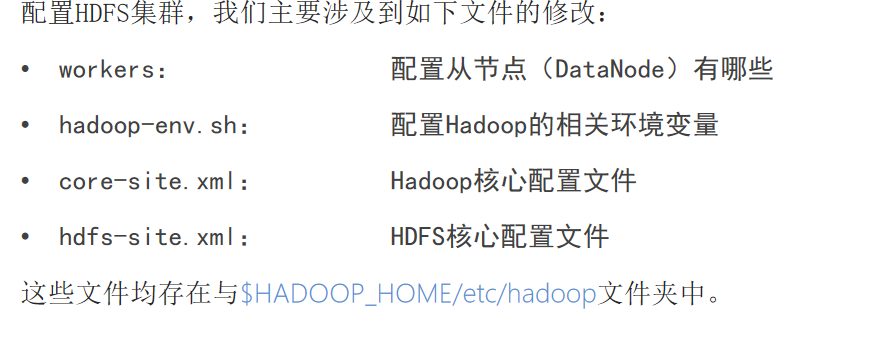

三、修改文件

配置workers文件

# 进入配置文件目录 cd etc/hadoop # 编辑workers文件 vim workers # 填入如下内容 node1 node2 node3

配置hadoop-env.sh文件

#编辑 hadoop-env.sh文件 vim hadoop-env.sh # 填入如下内容 export JAVA_HOME=/export/server/jdk export HADOOP_HOME=/export/server/hadoop export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop export HADOOP_LOG_DIR=$HADOOP_HOME/logs

配置core-site.xml文件

#编辑 core-site.xml vim core-site.xml #在文件内部填入如下内容 <configuration> <property> <name>fs.defaultFS</name> <value>hdfs://node1:8020</value> </property> <property> <name>io.file.buffer.size</name> <value>131072</value> </property> </configuration>

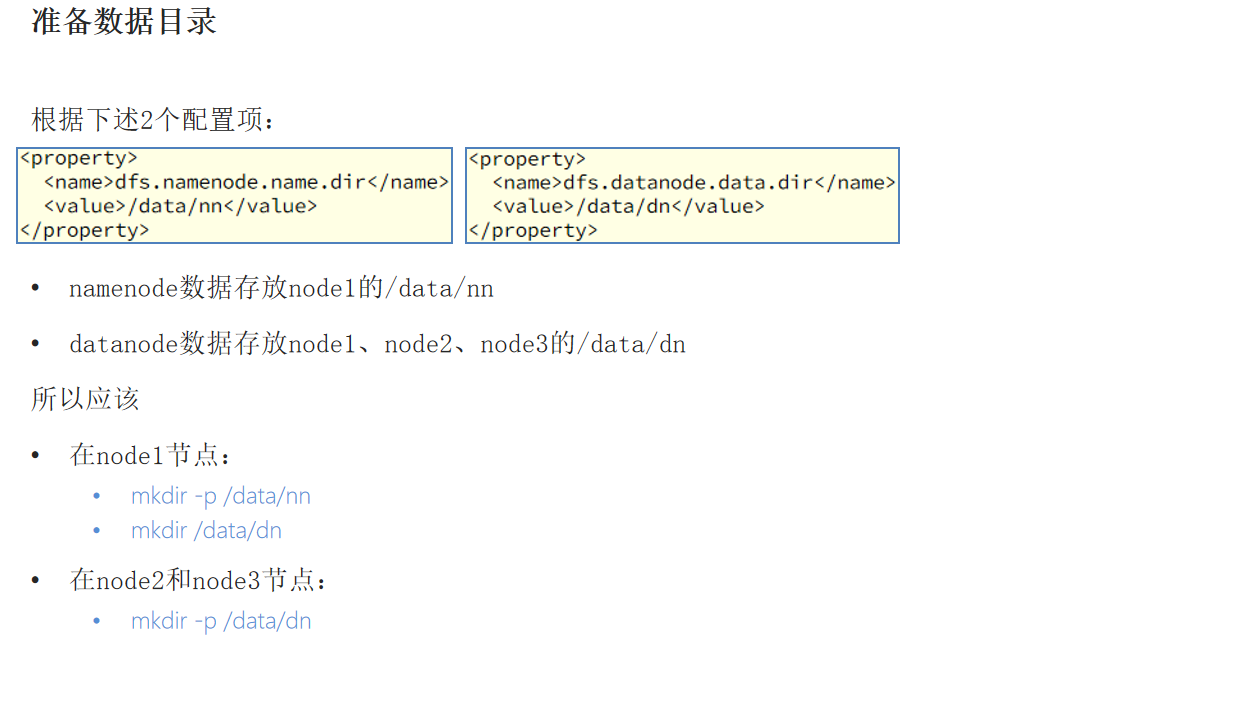

配置hdfs-site.xml文件

# 在文件内部填入如下内容 <configuration> <property> <name>dfs.datanode.data.dir.perm</name> <value>700</value> </property> <property> <name>dfs.namenode.name.dir</name> <value>/data/nn</value> </property> <property> <name>dfs.namenode.hosts</name> <value>node1,node2,node3</value> </property> <property> <name>dfs.blocksize</name> <value>268435456</value> </property> <property> <name>dfs.namenode.handler.count</name> <value>100</value> </property> <property> <name>dfs.datanode.data.dir</name> <value>/data/dn</value> </property> </configuration>

四、准备数据目录

五、分发hadoop文件夹

六、配置环境变量

在node1、node2、node3中分别输入

编辑环境变量:vim /etc/profile

插入以下内容:

export HADOOP_HOME=/export/server/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

七、授权为hadoop用户

以root身份,在node1、node2、node3三台服务器上均执行如下命令

# 以root身份,在三台服务器上均执行 chown -R hadoop:hadoop /data chown -R hadoop:hadoop /export

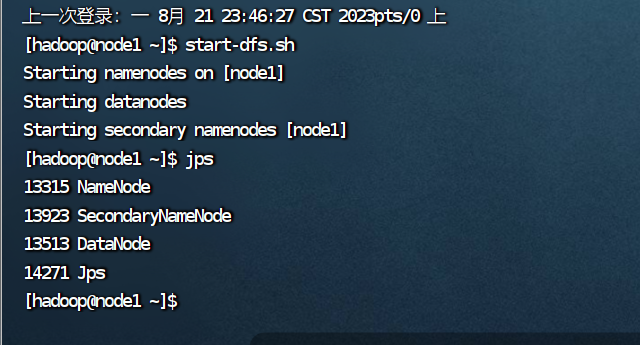

八、格式化文件系统

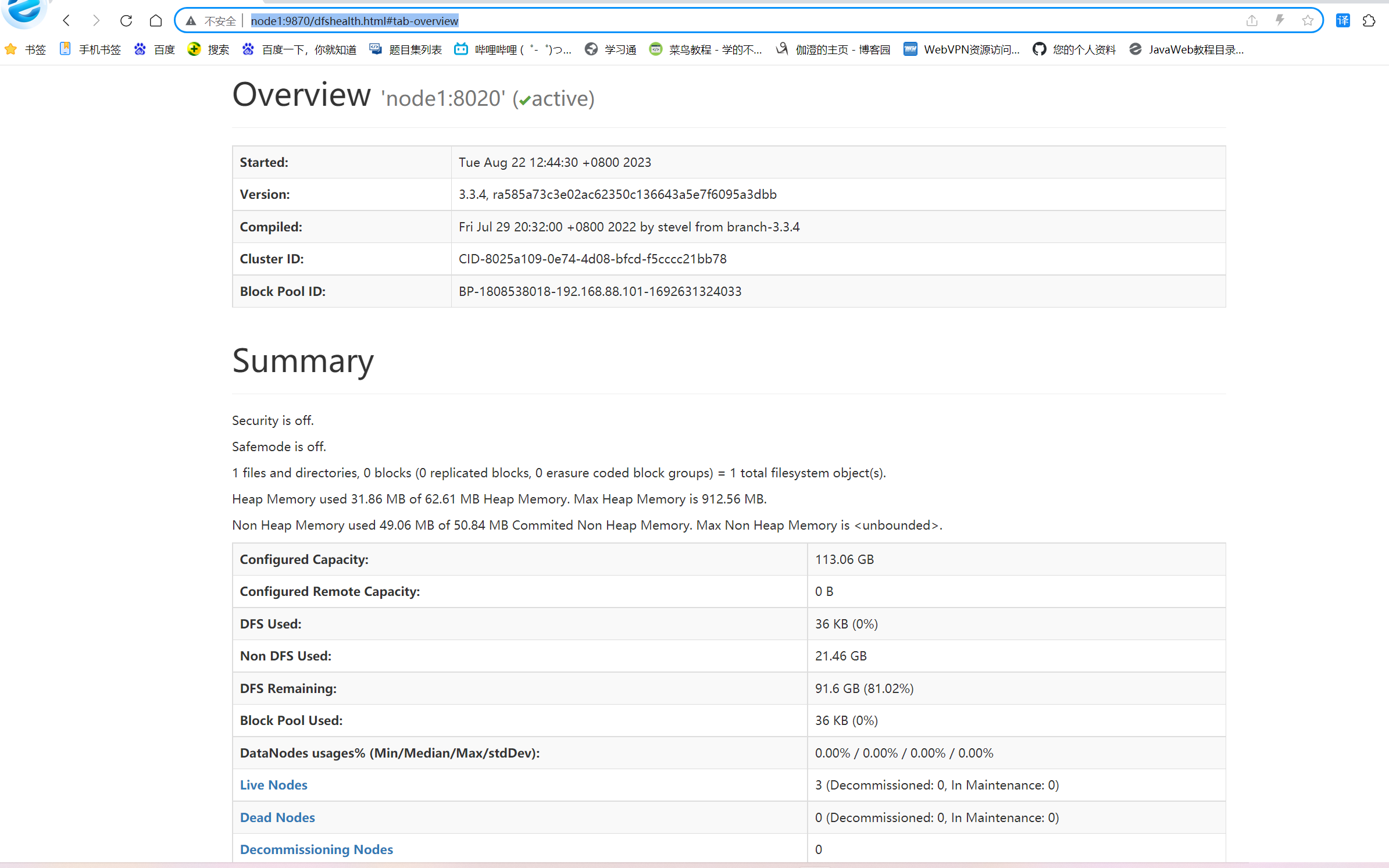

九、查看HDFS WEBUI

在浏览器输入网址 : http://node1:9870/dfshealth.html#tab-overview

显示如下页面。表示部署成功