1.算法理论概述

本文将从专业角度详细介绍基于CNN卷积神经网络的图像分割。主要包括以下几个方面:图像分割的基本原理、CNN卷积神经网络的基本结构、训练数据集的准备、网络训练和测试等。

1.1 图像分割的基本原理

图像分割是将一幅图像分割为多个具有独立语义的区域的过程。图像分割可以应用于计算机视觉、医学图像分析、遥感图像处理等领域。图像分割的基本原理是将图像像素进行分类,将相似的像素分为一组,不同的像素分为不同的组,从而得到图像的分割结果。常用的图像分割方法包括阈值分割、边缘检测、区域生长等。

1. 2 CNN卷积神经网络的基本结构

CNN卷积神经网络是一种前馈神经网络,广泛应用于图像处理、语音识别、自然语言处理等领域。CNN卷积神经网络的基本结构包括输入层、卷积层、池化层和全连接层。输入层是图像的像素值,每个像素都对应一个输入节点。卷积层是网络的核心部分,包括卷积运算和非线性激活函数。卷积运算通过卷积核对输入数据进行卷积操作,提取特征信息。非线性激活函数将卷积运算的结果映射到非线性空间,增加网络的非线性表达能力。池化层通过降采样操作减少特征图的尺寸,减少计算量和内存消耗。全连接层将池化层的输出连接到网络的输出节点,实现分类或回归等任务。

1.3 训练数据集的准备

CNN卷积神经网络的训练需要大量的标注数据集。在图像分割任务中,需要准备带有标注的图像数据集,其中每个像素都被标注为属于哪个类别。常用的图像分割数据集包括PASCAL VOC、COCO等。训练数据集应具有足够的多样性和覆盖范围,以保证网络的泛化能力。

1.4 网络训练

CNN卷积神经网络的训练包括前向传播和反向传播两个过程。前向传播是将输入数据通过网络进行正向传递,得到输出结果。反向传播是根据输出结果与标注数据之间的误差,通过反向传播误差信号来更新网络参数,以使网络输出更接近于标注数据。

CNN卷积神经网络的训练通常采用随机梯度下降(SGD)或其变种算法。SGD算法通过计算损失函数的梯度来更新网络参数。在训练过程中,需要设置合适的学习率、动量、正则化等参数,以避免过拟合或欠拟合。

CNN卷积神经网络训练完成后,需要对网络进行测试,以评估网络的性能。测试过程包括前向传播和评估性能两个步骤。前向传播是将测试数据输入网络,得到输出结果。评估性能可以采用各种指标,例如准确率、召回率、F1值等。

在图像分割任务中,常用的评估指标包括像素准确率、平均准确率(mean average precision,mAP)等。像素准确率是指正确分类的像素数除以总像素数。mAP是综合考虑了分类准确率和目标检测的平均准确率。

1.5 基于CNN卷积神经网络的图像分割实现步骤

基于CNN卷积神经网络的图像分割实现步骤包括以下几个部分:

数据准备

首先需要准备带有标注的图像数据集。在图像分割任务中,每个像素都应该被标注为属于哪个类别。常用的图像分割数据集包括PASCAL VOC、COCO等。数据集应该被分为训练集、验证集和测试集。

网络设计

根据任务需求,设计合适的网络结构。网络结构包括输入层、卷积层、池化层和全连接层。可以参考已有的网络结构,例如U-Net、FCN等。

网络训练

使用训练数据集对网络进行训练。训练过程包括前向传播和反向传播。在训练过程中,需要设置合适的学习率、动量、正则化等参数,以避免过拟合或欠拟合。

网络测试

使用测试数据集对训练好的网络进行测试。测试过程包括前向传播和评估性能。评估指标可以采用像素准确率、平均准确率等。

基于CNN卷积神经网络的图像分割是一种有效的图像分割方法。介绍了图像分割的基本原理、CNN卷积神经网络的基本结构、训练数据集的准备、网络训练和测试等方面。通过实现基于CNN卷积神经网络的图像分割,可以得到良好的分割结果,具有广泛的应用前景。

2.算法运行软件版本

MATLAB2022a

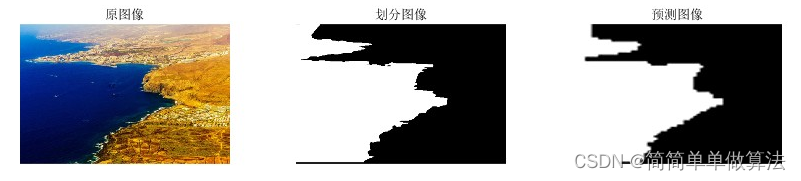

3.算法运行效果图预览

4.部分核心程序

%定义CNN网络的层次结构

layers = [

imageInputLayer([win_size win_size k])%1.输入层,数据大小win_size*win_size*k,k为图像通道数。

convolution2dLayer(3,16,'Padding','same')%卷积层16个3*3卷积核%2.卷积层,16个3*3大小的卷积核,步长为1,对边界补0。

batchNormalizationLayer%对每个batch做归一化

reluLayer%ReLU激活函数

maxPooling2dLayer(2,'Stride',2)%池化层2*2,步长2%3.池化层,使用2*2的核,步长为2。

convolution2dLayer(3,32,'Padding','same')%卷积层32个3*3卷积核%4.卷积层,32个3*3大小的卷积核,步长为1,对边界补0。

batchNormalizationLayer%对每个batch做归一化

reluLayer%ReLU激活函数

maxPooling2dLayer(2,'Stride',2)%池化层2*2,步长2%5.池化层,使用2*2的核,步长为2。

convolution2dLayer(3,64,'Padding','same')%卷积层64个3*3卷积核%6.卷积层,64个3*3大小的卷积核,步长为1,对边界补0。

batchNormalizationLayer%对每个batch做归一化

reluLayer%ReLU激活函数

maxPooling2dLayer(2,'Stride',2)%池化层2*2,步长2%7.池化层,使用2*2的核,步长为2。

fullyConnectedLayer(30)%30个节点的全连接层%8.全连接层,30个神经元。

fullyConnectedLayer(2)%2个节点的全连接层%9.全连接层,2个神经元。

softmaxLayer%8.分类层,使用softmax函数进行分类

classificationLayer];%9.输出层,将网络输出与真实标签进行比较,并计算误差

%定义CNN网络的训练参数

options = trainingOptions('sgdm', ...%优化算法采用Adam

'InitialLearnRate',0.001, ...%学习速率

'MaxEpochs',5, ...%最大训练轮数

'MiniBatchSize',50,...%每个mini-batch的大小

'Shuffle','every-epoch', ... %每个epoch随机打乱样本的顺序

'L2Regularization',0.001,...%L2正则化参数

'Verbose',false, ...%不显示训练过程

'Plots','training-progress'); %显示训练误差曲线

%使用trainNetwork函数进行训练

[net,info] = trainNetwork(train_input,train_output,layers,options);%训练网络

%使用testNetwork函数对测试集进行测试

YPred = classify(net,test_input);%测试网络

if size(YPred)~=size(test_output)

YPred=YPred';

end

%计算准确率

accuracy = sum(YPred == test_output)/numel(test_output)%输出测试集的ac率