\(\quad\)在自编码器中使用深度网络已成为有前途的研究方向,这种学习网络有两个挑战:

- 处理量化与控制reconstruction error (distortion)

- entropy (rate) of the latent image representation之间的权衡(rate都用熵表示吗?)

introduction

\(\quad\)训练这种基于网络的压缩方法有一个关键的挑战:优化编码器中潜在表示的比特率R,为了使用数量有限的比特对图像进行编码,需要将潜在的表示离散化映射到有限值的集合。而离散化是不可微的,这就给基于梯度的优化方法带来挑战,人们提出很多方法来解决这个问题。

\(\quad\)离散化后,信息论告诉我们比特率的正确度量是离散化符号的熵H。本文重点就是如何对熵进行建模以便在优化过程中权衡\(D+\lambda H(R)\)

\(\quad\)该文章提出的模型基于上下文模型,上下文模型之前被用来证明已训练模型的编码率,直接作为优化项中的熵。同时训练自动编码器和上下文模型,其中上下文模型学习图像表征的卷积概率模型,而自动编码器则利用它进行熵估计,以实现速率-失真权衡。

Quantization

\(\quad\)量化过程是把连续的数 离散到有限数集中,减少储存压力,但是要处理好反向传播的问题。

思考:这个有限的数集如何确定?

Entropy estimation

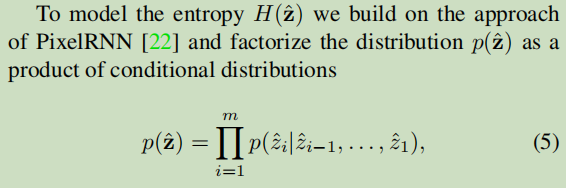

\(\quad\)这篇文章在PixelRNN的基础上,将概率分解为条件概率的累乘。

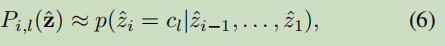

然后使用神经网络\(P(\hat z)\)作为上下文模型,来估计条件概率。过程为:

使用

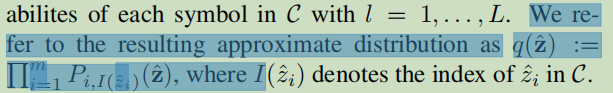

作为向量\(\hat z\)中第i个位置量化为有限集C中元素l的概率。将这种近似的概率分布称为\(q(\hat z)\)

- Conditional Compression Probability Models Imageconditional compression probability models variational compression hyperprior image text-to-image conditional diffusion control image image-to-image conditional adversarial compression sketch image rates probability probability-generating-function probability-generating-function probability function loss-of-function probability intoleran probability quantum theory logic