多模态+大语言模型

1. 将跨模态编码器等其它结构与LLM进行有机结合

Multimodal Few-Shot Learning with Frozen Language Models

https://arxiv.org/pdf/2106.13884.pdf

DeepMind,2021

固定llm的参数,把图片信息encode后当prefix与text拼接,论文中说llm的规模是7B

Flamingo

https://arxiv.org/pdf/2204.14198.pdf

固定llm,vision-encoder参数,额外添加两个可训练的部分:

(1)在Visual Encoder后加入了Perceiver Resampler模块,用于加强视觉表征;

(2)在LLM的每层之前加入了Gated xattn-dense模块用于加强跨模态信息交互。

BLIP-2

https://arxiv.org/pdf/2301.12597.pdf

固定llm,vision-encoder参数,添加了Q-former来将图片信息对齐到文本

训练分两阶段

阶段一:Q-former用bert-base参数初始化,设置三个训练目标联合训练

阶段二:vision-to-language generative

LLM使用OPT(2.7B,6.7B),FlanT5(XL,XXL)

MiniGPT-4

https://arxiv.org/pdf/2304.10592.pdf

主要强调高效,省钱

基于的LLM为Vicuna,vit和Q-former来自BLIP-2,能训的只有新加的一个线形层,4张A100训10小时

训练分两阶段:

-

第一阶段预训练:pretraining

-

- 使用Conceptual Caption、SBU和 LAION等几个数据集进行第一阶段的训练,batch size=256训练了2万步,大概覆盖了500万个image-text pairs,使用4张A100-80GB的GPU训练了10个小时;

- 经过第一阶段的pretrain,作者发现了一些模型很难产生连贯的语言输出的例子,而且会输出一些重复的单词或句子、支离破碎的句子或无关的内容;

-

第二阶段微调:finetuning

-

- finetune的prompts模板: ###$Human: < Img>

</ Img> \(###\)Assistant:$ - 使用3500条高质量的数据集去finetune模型,使得模型的输出有更好的连贯性,更加符合对话场景;在单张A100-80GB的GPU上训练了7分钟

- finetune的prompts模板: ###$Human: < Img>

LLaVA

https://arxiv.org/pdf/2304.08485.pdf

CLIP+LLaMA

LLaMA-Adapter: Efficient Fine-tuning of Language Models with Zero-init Attention

https://arxiv.org/pdf/2303.16199.pdf

LLaMA-Adapter是高效微调llama的一种方式,给transformer的后L层 layer 前面加 adapter

拓展到图文任务,把图文信息用encoder(CLIP)拼到adapter

2. 直接利用图像和文本信息训练得到的多模态大模型

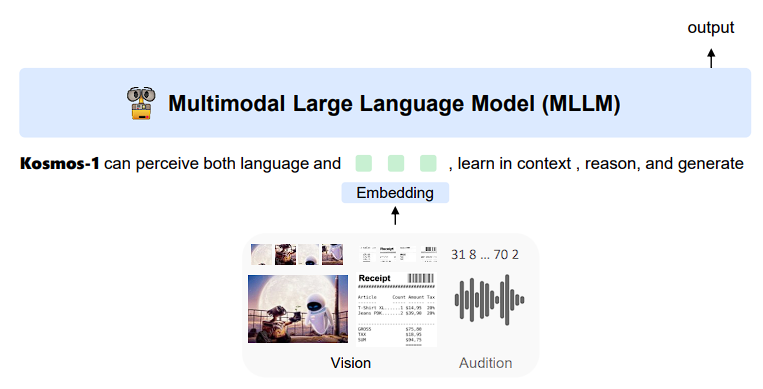

Language Is Not All You Need: Aligning Perception with Language Models(KOSMOS-1)

https://arxiv.org/pdf/2302.14045.pdf

KOSMOS-1 1.6B 从0到1训练全部参数

用special token标出文本中的图片特征

3. 其他思路

IMAGEBIND: One Embedding Space To Bind Them All

https://arxiv.org/pdf/2305.05665.pdf

将多种模态的信息编码到统一的一个表示空间,每个模态一个encoder,让image与每个模态都进行对比学习,6种模态靠image连接起来