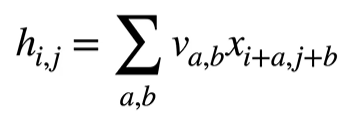

我们之前在用fashion_mnist数据集进行分类的时候,都是将图片展成了一个一维的张量(向量)作为输入,但是这样丢失了图片的空间信息。我们改变一下:将图片本身作为二维张量(矩阵)输入进去,并且把隐藏层表示也变成二维的,这样,权重就从二维变成了四维:隐藏层节点的 (h' * w') 个值,每一个值都是由h*w个像素值计算得来的。并进一步重新索引:

![]()

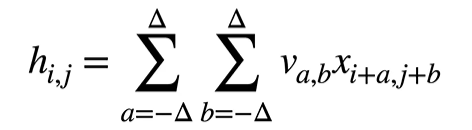

上等式最右端表达式可以这样理解:在输入图像x的每一个像素位置(i,j),它的偏移量为(a,b)处的像素都有不同的权重vi,j,a,b ,计算出隐藏层节点值hi,j .并且可以看到,当x的像素位置i,j变化时,此处的权重vi,j,a,b是会变化的。这是挺有趣的一点,它表明“某个像素(或局部小区域)出现在图像的左上角,或出现在中部偏右,带来的影响是不一样的”。(个人理解:在有些任务如目标检测中,这不是一件好事,但其他任务呢?这不一定就是坏事。)如果我们强行加入平移不变性,即:令

![]()

那么就有:

这去掉了权重的两个维度,使得图像某个位置的权重与这个位置无关,而只与这个位置附近的(偏移量为a,b的)像素有关。同时由于去掉了两个维度,参数量大大被减小了。

如果还是觉得参数量太大,我们可以限制a,b的值,即只关注当前位置(i,j)附近的一个很小范围内:

![]()

于是,就有:

我们说,这样做加入了局部性。卷积层就是在全连接层中加入平移不变性和局部性:

除了二维外,还有一维和三维交叉相关:

一维常见数据:文本、语言、时序序列。

三维常见数据:视频、医学图像、气象地图。

总结:

(1)卷积层将输入和核矩阵进行交叉相关,加上偏移后得到输出结果。

(2)核矩阵和偏移是可学习参数。

(3)核矩阵的大小是超参数。