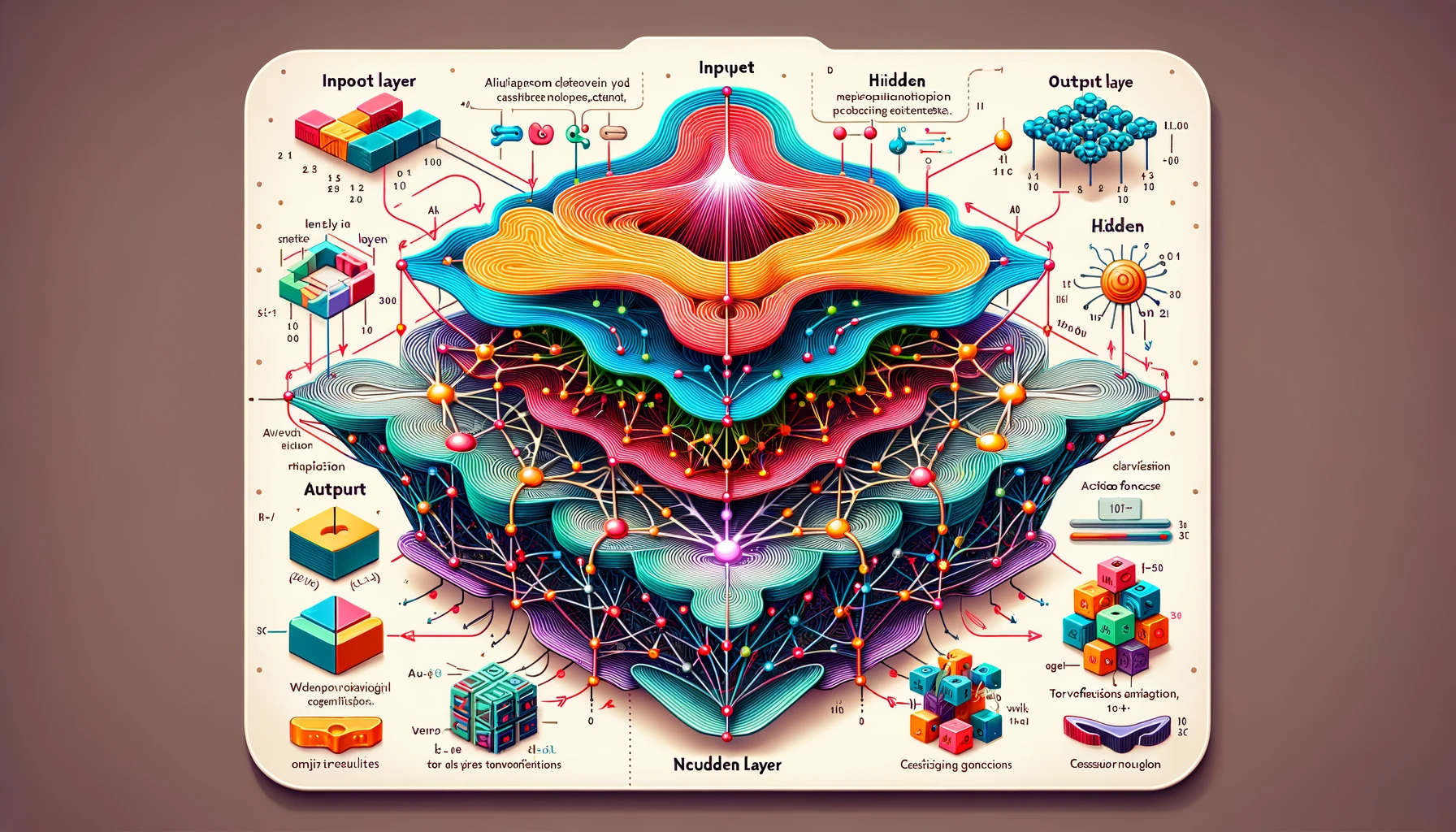

在人工智能领域,架构设计是决定一个模型性能和应用范围的关键因素。大语言模型和传统机器学习有不同的设计框架,使得它们在应用场景和处理任务上具有显著差异。大语言模型,如GPT和BERT,基于庞大而复杂的神经网络结构构成,这些神经网络结构拥有数百万甚至数十亿的参数,能够学习和理解大量的数据,尤其是在处理自然语言方面。这些模型通常采用深度学习技术,如循环神经网络(RNN)和转换器(Transformer)架构,可以更好地捕捉和生成人类语言的细微差别和复杂性。

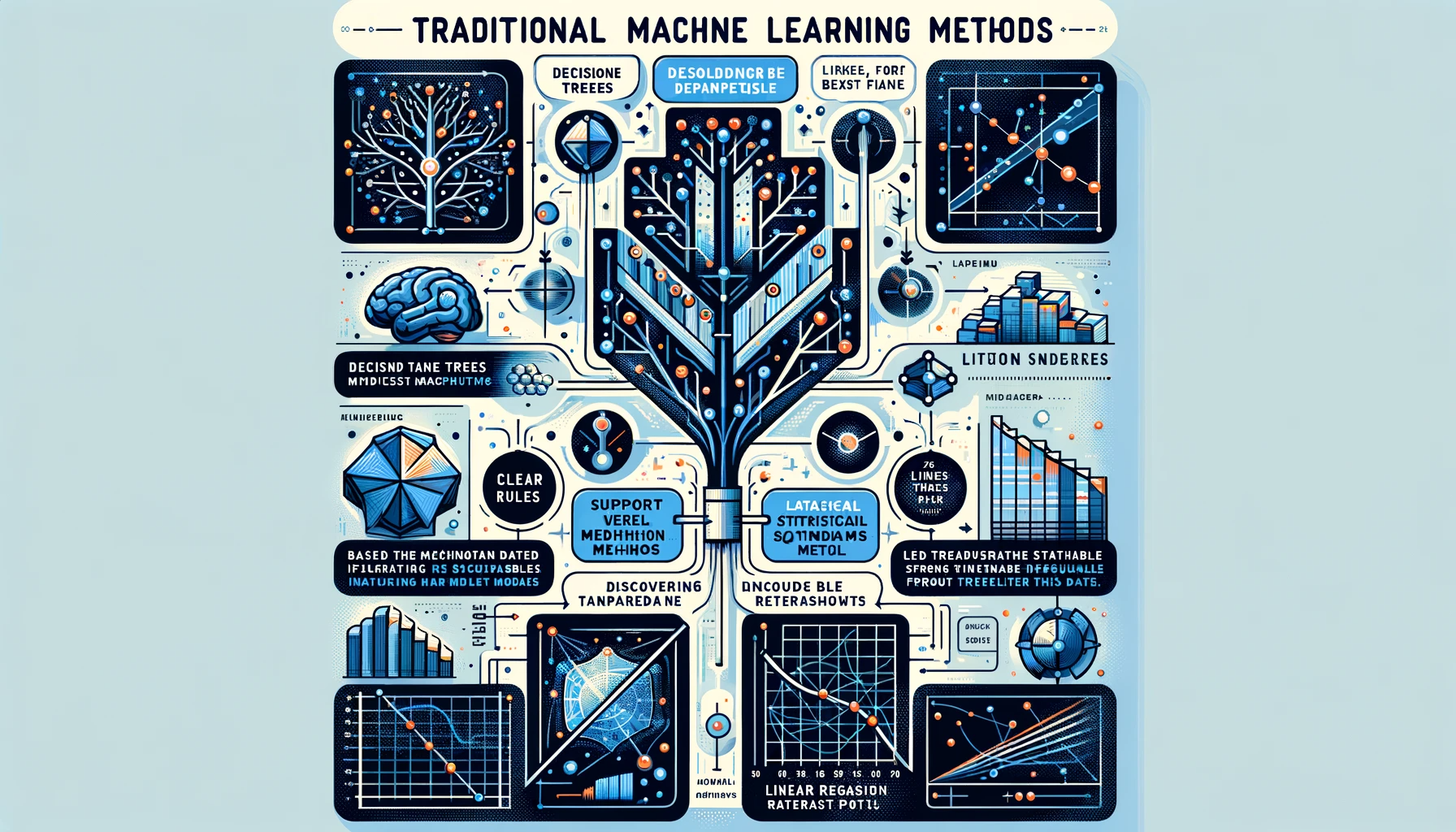

相比之下,传统机器学习方法如决策树、支持向量机(SVM)或线性回归模型,基于更为明确的规则和统计特征,专注于从数据中发现可解释的模式。这些模型相对简洁,易于理解和解释,在专业权威领域的应用场景中,传统机器学习的可解释性就显得非常重要,它有助于决策者对模型进行更深入的理解和信任。此外,这些传统机器学习方法在处理大量数据时表现出色,能够在保持较高准确性的同时,有效地识别出关键特征。

这些架构上的差异对模型处理能力和适用性产生了显著影响。LLMs由于其复杂的网络结构和大规模数据处理能力,大大提升了在理解和生成自然语言的性能。然而,这也导致对资源和计算需求的高需求,在一定程度上限制了LLMs的应用。

而传统机器学习方法在资源和计算上的需求相对较小,适用于即时响应和高需求计算效率的应用场景。尽管这些模型可能不适用于处理高度复杂的语言任务,但在特定任务的精确性和效率上有显著优势。

大语言模型和传统机器学习在架构上的主要差异反映了它们在处理任务和应用场景上的不同取向。了解这些差异对于选择合适的工具和方法来解决特定问题至关重要。随着技术的不断进步,我们也可能看到这些模型在未来融合和相互借鉴的趋势,以便更好地适应不断变化的技术需求和应用场景。