引言

心理学研究过人们当面对不同意见时的处理方式。当人们往往比较侧重于具有权威的意见,从而忽略忽略极少数的个别意见;并且人们还会比较侧重于自己而忽略其他人的意见。今天给大家分享的这篇文章,作者针对决策任务,对Auto-GPT代理进行了全面的基准研究,探索了大型语言模型(LLM)在决策任务中的应用。「实验结果表明GPT4有了类似于人类的能力,可以从不同的意见中提取有用信息,进行思考和批判然后提高自己的结果」。

Paper:https://arxiv.org/pdf/2306.02224.pdf

Code:https://github.com/younghuman/LLMAgent

背景介绍

最近,将大型语言模型(LLM)应用于自主代理(autonomous agents)在决策制定、角色模拟和工具应用等任务中取得了巨大成功。虽然扩大 LLM参数可以提升模型的通用能力,但若要将LLM直接用作自主代理仍然存在局限性。其主要原因是:缺乏长期记忆、输出内容不可控以及令牌长度限制。为克服这些问题,最近提出了各种提示、计划和记忆检索等方法,并得到了不错的效果。在所有代理中,有一个叫AutoGPT自主代理,它基于GPT连接到互联网并尝试完成任何任务。尽管在圈内引起了很大轰动,但由于能力受限,其完成任务的效果并不理想。

Auto-GPT智能体特征主要包括以下几个方面:

-

1.它可以直接接收最终的目标指令,实现复杂的多步任务,并且无需人类提供逐步引导; -

2.对每个单独的行动步骤,它通过生成‘Thoughts’、’Reasoning’、’Plan’和’Criticism’来实现自我反省(实际上是CoT和Reflexion); -

3.具备能够将简单的工具指令和示例整合各种工具的能力; -

4.能够融合了长期的自我记忆和记忆检索机制,仅需要提供目标定义和工具描述,就能适用于特定任务。

方法介绍

基于以上背景,作者探讨了Auto-GPT智能体的能力和局限性,并在在线决策任务上对Auto-GPT进行了深入的研究。在此过程中,「作者还提出了一种新方法,即通过外部模型提供额外意见的方式来增强LLMs」。

测试任务&基线模型

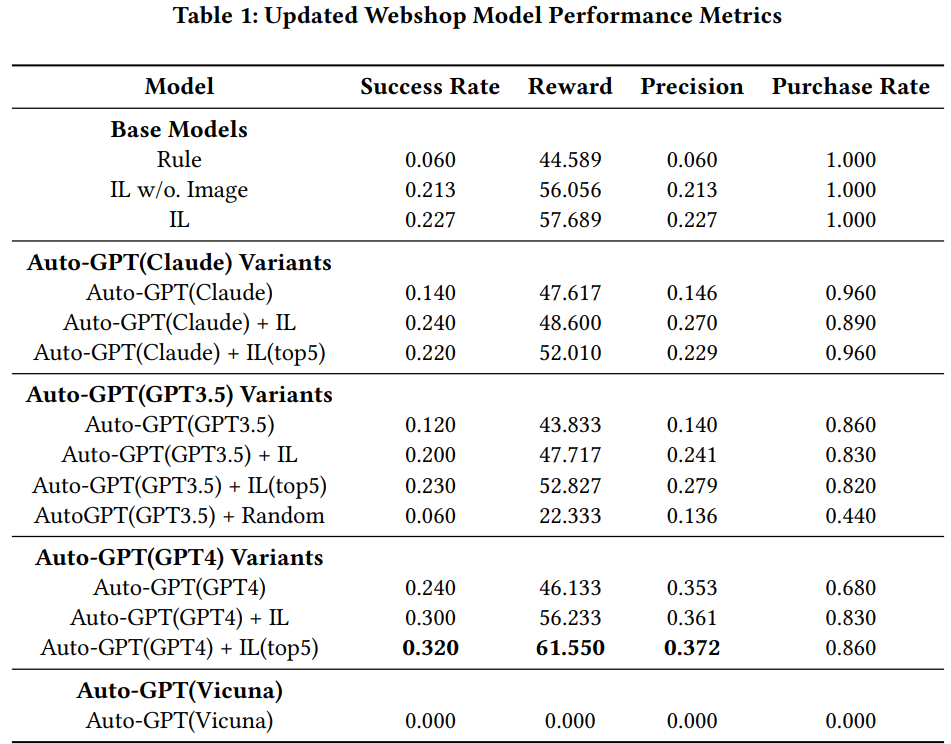

「Webshop」:它是一个模拟网购环境,该环境从亚马逊电商平台抓取超过118万个产品,并提供了如搜索、点击、导航、购买等真实客户操作。该评估过程主要看智能体是否成功购买了描述的产品,并且要求需要产品、属性、选项和价格全都匹配。该任务的基线模型采用模仿学习(IL)方法的模型,并于采用Auto-GPT方式运行的大语言模型进行比较。

在Webshop试验中,如下图所示。GPT4表现出色,其性能超过了其他IL模型。尽管无图像输入的原始IL模型仅取得了适度的成功率,但是加入了图像输入的IL模型表现更好。然而,只使用GPT3.5或Claude的Auto-GPT代理表现不如原始IL模型。但是,GPT4本身的性能优于所有IL模型。 「ALFWorld」:ALFWorld是一个研究环境,该环境包含超过25000个独特的、程序生成的任务,涵盖厨房、客厅、卧室等真实环境。它结合了复杂的任务导向和语言理解。此类任务需要agent具备解决复杂问题的能力,并对语言环境有深入的理解。基线模型使用模仿学习(IL)的DAgger agent进行,然后与采用Auto-GPT风格的生成语言模型进行比较。

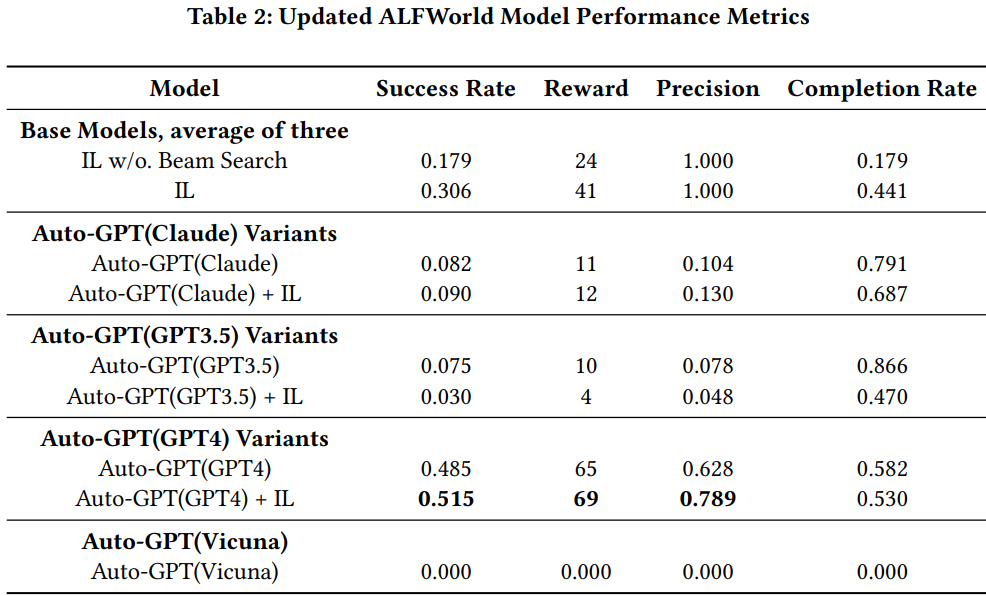

「ALFWorld」:ALFWorld是一个研究环境,该环境包含超过25000个独特的、程序生成的任务,涵盖厨房、客厅、卧室等真实环境。它结合了复杂的任务导向和语言理解。此类任务需要agent具备解决复杂问题的能力,并对语言环境有深入的理解。基线模型使用模仿学习(IL)的DAgger agent进行,然后与采用Auto-GPT风格的生成语言模型进行比较。

在ALFWorld实验中,如下图所示。IL模型与Beam Search的组合显著优于无Beam Search的版本。而在AutoGPT设置中运行的Claude和GPT3.5的性能均未超越IL模型,但无论是否使用Beam Search,GPT4明显超越了IL模型的性能。

Prompt设计

在没有进行大规模调优的情况下,作者将任务需求问题直接作为Auto-GPT的目标,适配了Auto-GPT进行各项任务。比如输入像"I want to purchase a folding storage box that is easy to install, made of faux leather, and has dimensions of 60x40x40cm"的句子。

为了帮助Auto-GPT理解可用的行动,作者将每个行为表现为一个工具。值得注意的是,在没有示例的情况下,仅使用工具指令的效果较差。然而,只要有少量的示例,性能就会显著提高。因此,为了利用LLM的上下文学习能力,在工具演示过程中,添加了1到2个few-shot示例。

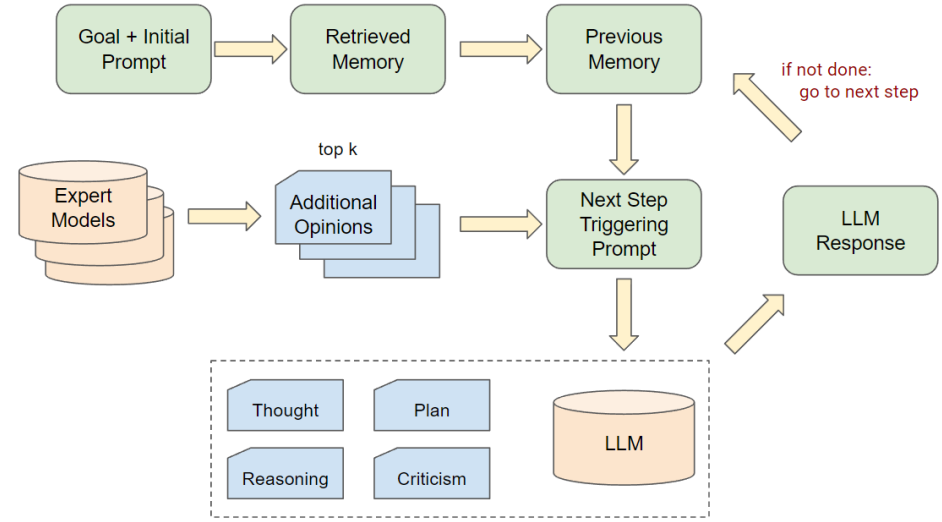

专家模型增强LLMs

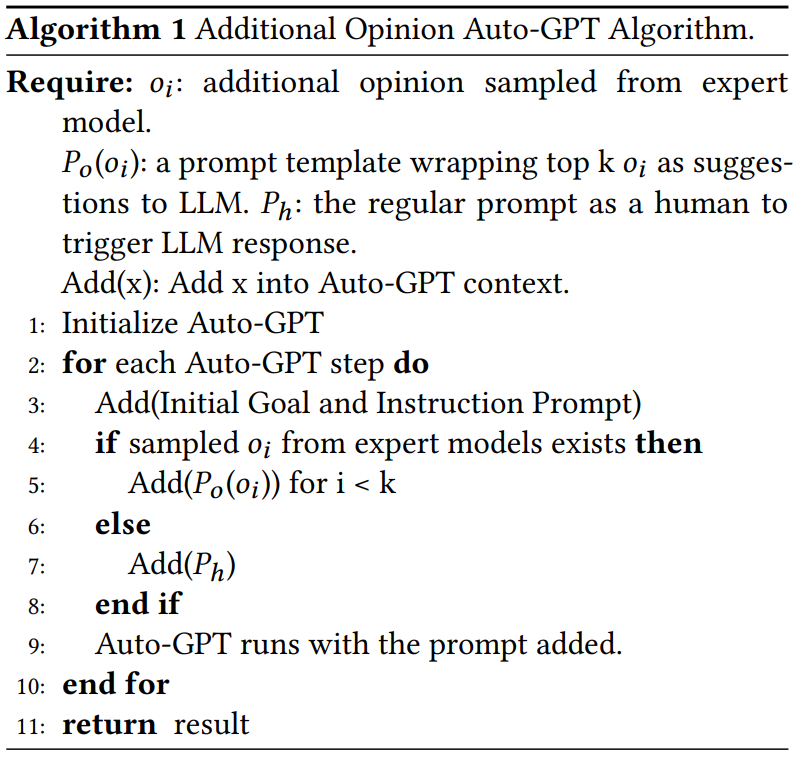

「为了引入来自外部专家模型的额外意见,作者改进了Auto-GPT的工作流」,如下图所示。具体来说,具体来说,在Auto-GPT的决策阶段,从专家模型中抽样出前k个意见,并将这些意见放入提示的上下文部分,以供大语言模型参考。 在这项工作中,作者简单地使用了对于每个任务都已经准备好的IL模型作为外部专家。提供给LLM额外意见的提示遵循这样的模板:‘Here’s one(a few) suggestion(s) for the command: Please use this suggestion as a reference and make your own judgement.’

在这项工作中,作者简单地使用了对于每个任务都已经准备好的IL模型作为外部专家。提供给LLM额外意见的提示遵循这样的模板:‘Here’s one(a few) suggestion(s) for the command: Please use this suggestion as a reference and make your own judgement.’

实验结果

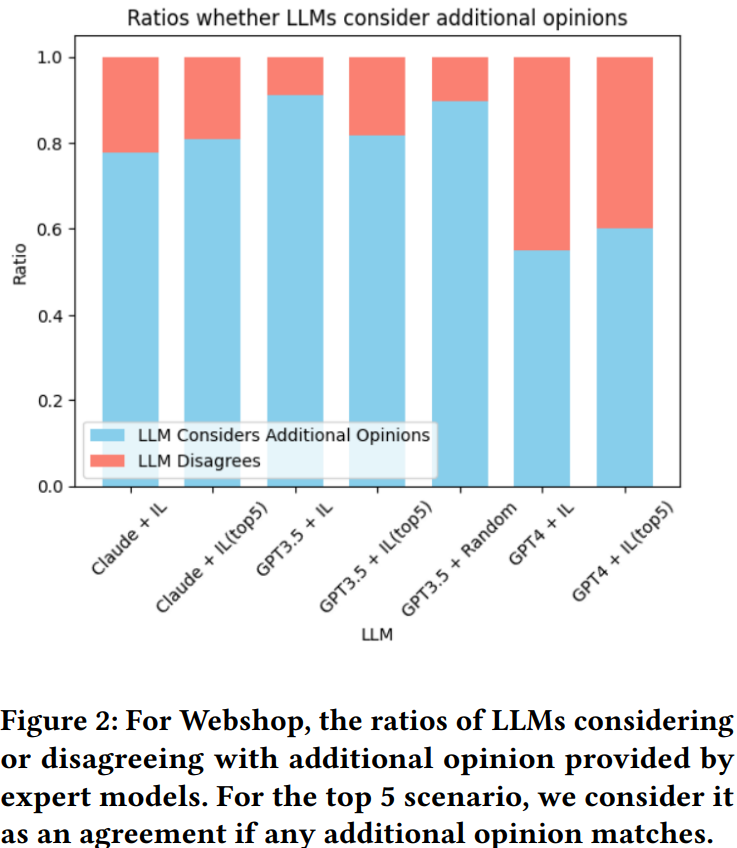

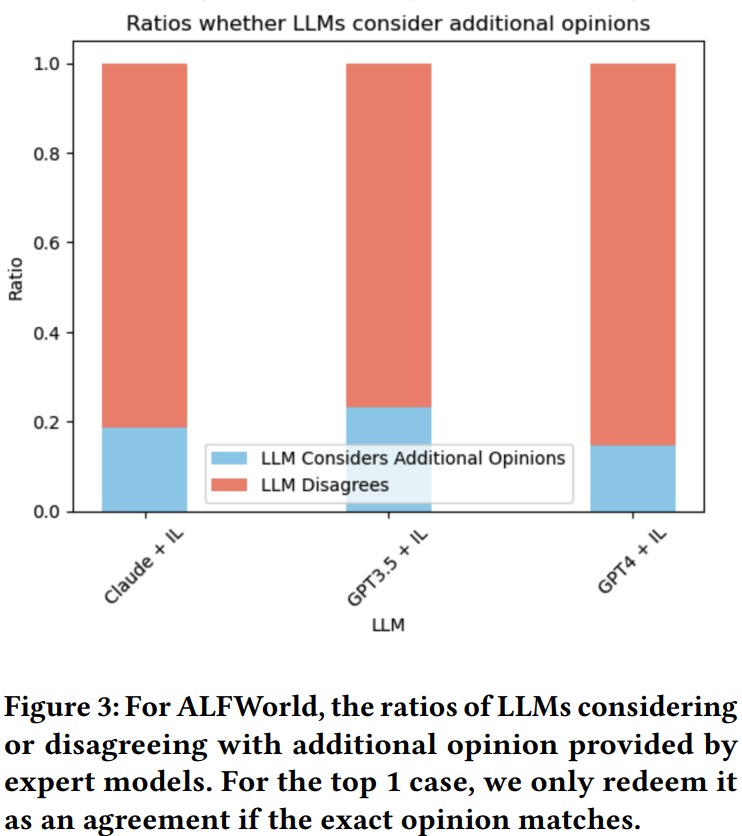

对于本文提出将大型语言模型(LLMs)与专家模型结合起来的方法。作者首先从专家模型中采样出前k个附加观点,然后将这些观点呈现给LLMs,让它们考虑这些观点并做出最后的决定。

在实验中如上图,「发现GPT-4模型在处理额外意见时表现出极高的辨别能力」。即使在信息噪声中,GPT-4也能区分出有益和无关的建议。而GPT-3.5模型在面对可能导致混淆的输入时,表现出了明显的劣势。总的来说,LLM与额外意见的一致性或不一致性,很大程度上取决于LLM的理解能力和额外意见的质量。

在实验中如上图,「发现GPT-4模型在处理额外意见时表现出极高的辨别能力」。即使在信息噪声中,GPT-4也能区分出有益和无关的建议。而GPT-3.5模型在面对可能导致混淆的输入时,表现出了明显的劣势。总的来说,LLM与额外意见的一致性或不一致性,很大程度上取决于LLM的理解能力和额外意见的质量。