2303.12789

发布时间 2023-04-01 15:24:11作者: th-is

摘要

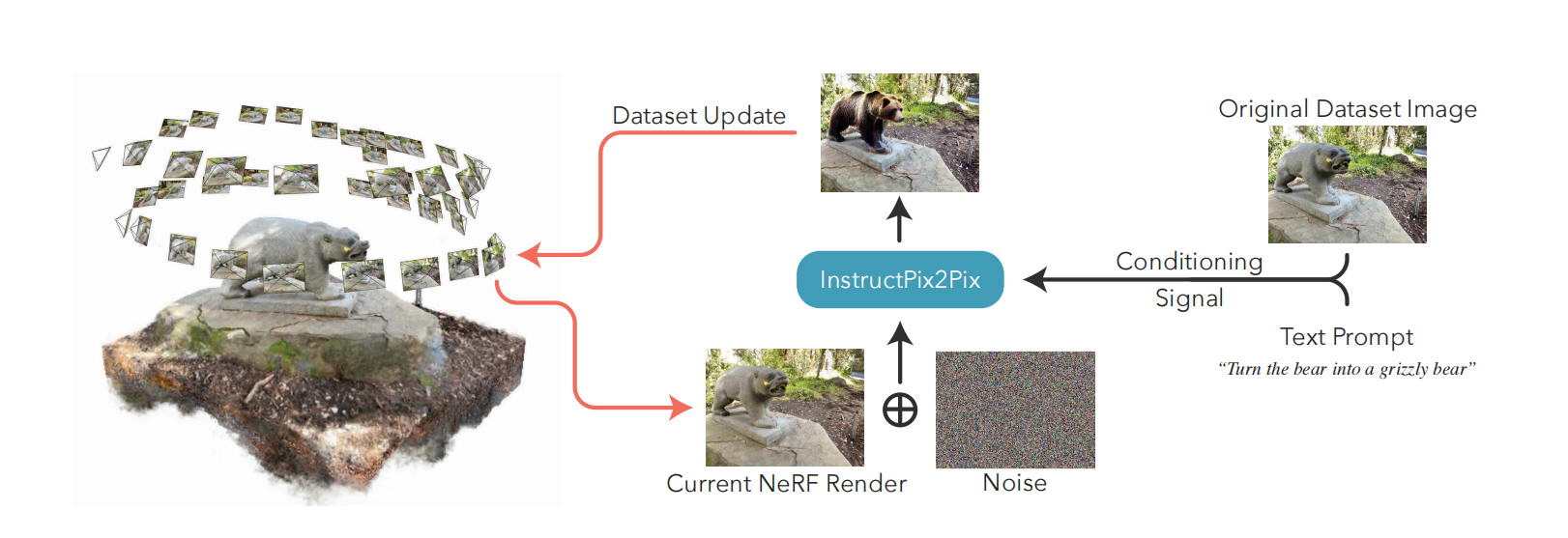

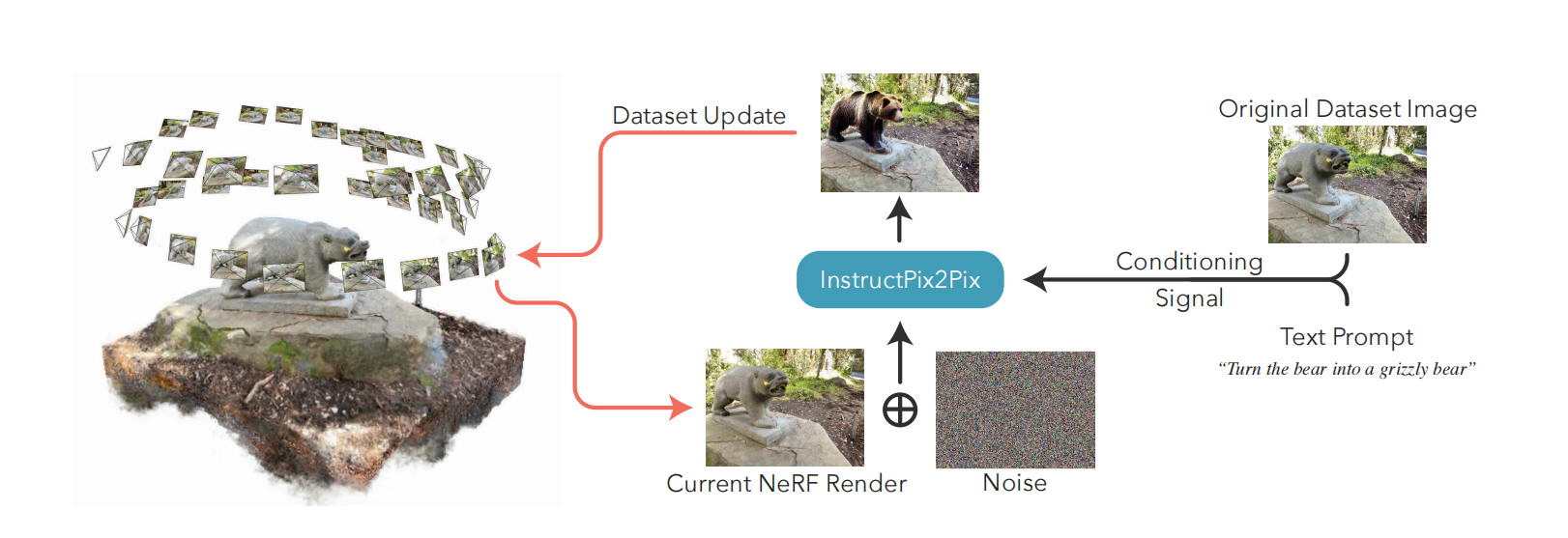

- Instruct-NeRF2NeRF:用文本指令 3D一致地 编辑NeRF场景

- 给定 一个场景的NeRF 和 用于重建它的图像集

- 使用 扩散模型 迭代编辑图像集

- 图像条件-扩散模型 InstructPix2Pix

- an image-conditioned diffusion model

- 同时优化底层场景,得到反映指令编辑的优化3D场景

- 基于预先捕获的NeRF场景进行操作,确保任何产生的编辑保持3d一致性。

引言

- 捕捉真实世界3D场景的数字化表示很容易:

- 从不同视点获取一个场景的图像集

- 重建其相机参数

- 使用这些摆好的图片(posed images)优化(optimize)NeRF

- 创建3D资产(assets)的创作并不容易

- 传统手工方式:

- 手动雕刻、挤压和重新纹理一个给定的对象

- 与神经表征(neural representations)的出现更加相关,而神经表征通常没有明确的表面

- 进一步激发3D编辑方法的需求,尤其是像捕捉技术那样的易操作性

- Instruct-NeRF2NeRF:用文字指令编辑3D

- 确保所产生的编辑3D一致: