基于超轻空谱特征协同网络的遥感影像变化检测

论文访问地址:https://ieeexplore.ieee.org/document/10081023

论文公开代码:https://github.com/SUST-reynole/USSFC-Net

论文引用信息:T. Lei, X. Geng, H. Ning, Z. Lv, M. Gong, Y. Jin and A. K. Nandi, "Ultralightweight Spatial–Spectral Feature Cooperation Network for Change Detection in Remote Sensing Images," in IEEE Transactions on Geoscience and Remote Sensing, vol. 61, pp. 1-14, 2023, Art no. 4402114, doi: 10.1109/TGRS.2023.3261273.

1.概述

现有的深度卷积神经网络在遥感变化检测任务中已取得了巨大的成功,但依旧受困于两个问题:首先,首先,现有的多尺度特征融合方法往往采用冗余特征提取和融合策略,这导致了变化检测模型需要较高的计算成本和内存占用。其次,变化检测中的常规的注意力机制难以同时对空间和谱间特征进行建模并生成三维注意力权重,这忽略了空间特征和谱间特征之间的协同作用。为了解决上述问题,本文提出了一个高效的超轻空谱特征协同网络(USSFC-Net),提出的USSFC-Net主要有两个优势。首先,设计了一种多尺度解耦卷积(MSDConv),它与目前流行的空洞空间金字塔池化(ASPP)模块及其变体明显不同,它可以通过循环多尺度的卷积灵活地捕捉变化对象的多尺度特征。同时,MSDConv的解耦设计可以大大减少参数的数量和计算冗余。其次,引入了一种高效的空谱特征协同策略(SSFC),从而获得更加丰富的特征。SSFC不同于现有的注意力机制,因为它不需要添加任何参数就能够推理出三维空谱注意力权重。在三个遥感影像变化检测数据集上的实验表明,所提出的USSFC-Net具有比大多数卷积神经网络更好的变化检测精度并且需要更低的计算成本和更少的参数量。另外,实验表明它甚至优于一些基于Transformer的变化检测方法。

2.方法

图1 本文提出的的USSFC-Net。(a)总体架构:将一对双时相图像输入到非权重共享的编码器中,并将每个阶段的差分图像融合到解码器。将本文提出的基于SSFC策略的MSDConv作为特征提取器的基本组成部分。(b)本文提出的基于SSFC策略的MSDConv。MSDConv可以捕获变化对象的多尺度特征表示。SSFC为MSDConv生成了更丰富的特性。两者可以协同提高变化检测精度。

A.网络整体结构

如图1所示,USSFC-Net由一个双分支非权重共享编码器和解码器组成。首先,我们将一组双时相图像分别输入由MSDConv和SSFC组成的双分支编码器中进行特征提取。在此阶段,每个MSDConv块可以有效地捕获双时相图像的多尺度特征。为了丰富MSDConv生成的特征,我们在空间相关性扩展阶段使用SSFC策略进行特征增强。接下来是解码器,它由反卷积上采样层和使用提出的MSDConv的特征恢复层组成。在编码器的每个阶段,我们获取一个差分图像,并将其连接到解码器的相应位置,以获得更丰富的变化对象的特征映射。最后,网络通过点卷积进行降维和归一化操作,输出最终的变化检测结果。从图1 (a)可以看出,与其他流行的变化检测网络相比,USSFC-Net在孪生结构[1]上做了以下改动:(1)使用非权重共享的伪孪生编码器,通过增加少量参数来实现更好的特征提取。(2)引入MSDConv代替编解码器结构中的普通卷积。(3) 引入了SSFC策略。MSDConv从多尺度角度保持了变化对象的完整性,SSFC从注意力角度帮助MSDConv生成更丰富的特征。显然,通过将MSDConv与SSFC相结合,我们可以获得更好的遥感图像变化检测结果。

B.多尺度解耦卷积(MSDConv)

MSDConv的结构如图1 (b)所示。MSDConv的灵感来自于Xception[2],但又与之完全不同。MSDConv不仅遵循Xception中提出的空间相关性和通道相关性可以充分解耦的结论,而且还实现了一种有效的空间相关性扩展策略。具体来说,设X为输入特征映射,X∈RC×H×W,其中C、H、W分别表示特征映射的通道数、特征映射的高度、特征映射的宽度。使用普通卷积生成特征图的过程可以表示为:

![]()

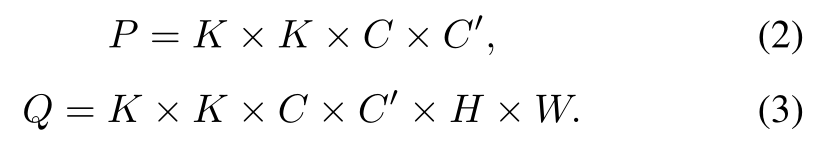

由式(1)可知,利用普通卷积学习特征时,参数量P和计算量Q为:

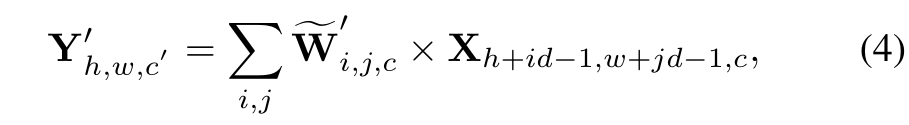

为了减少普通卷积运算的参数冗余,本文提出了一种新的具有解耦空间和通道相关性的卷积运算。具体来说,为了获得C0特征映射,我们首先通过点卷积生成C0/2原生特征映射。因此,生成的原生特征图不需要任何空间相关性映射,仅通过降维获得紧密的信道相关性。在第二阶段,我们使用循环多尺度卷积来扩展原生特征图的空间相关性,从而得到辅助特征图。如图1(b)所示,循环多尺度卷积由(1,3,6)等膨胀率组合的空洞卷积实现。值得注意的是,循环多尺度卷积将不同的膨胀率扩展到同一卷积层对应的卷积核上。这保证了MSDConv可以仅通过一个卷积层捕获变化对象的多尺度特征,并通过层的迭代融合多尺度特征。与式(1)类似,膨胀率为d的循环多尺度卷积可表示为:

其参数量Pm和计算量Qm为:

由此可知,所提出的MSDConv的参数量和计算量仅为普通卷积的(1/(2K2) + 1/(2C))。

C.空谱特征协同策略(SSFC)

为了得到注意力机制中查询(Query)和键(Key)之间的关系,我们受到Nadaraya-Watson核回归的启发,设计了一种基于高斯核的SSFC策略,它的推导过程为:

![]()

↓

![]()

↓

![]()

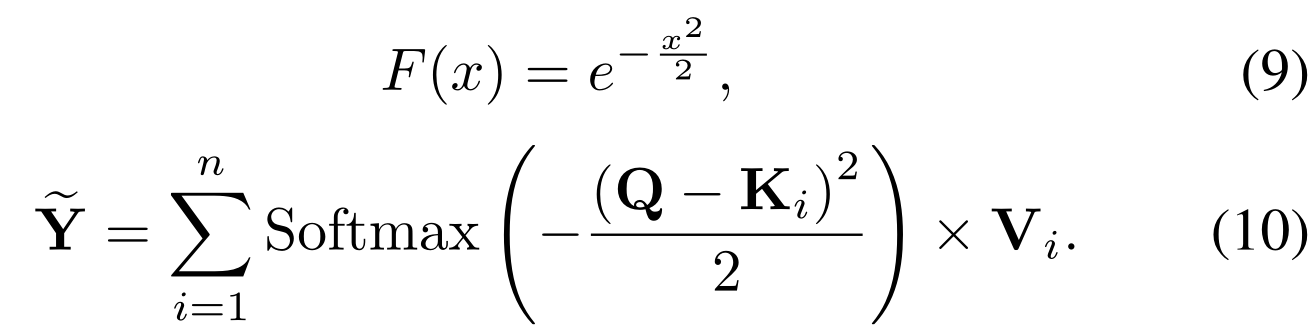

在实际应用中,K和V都是输入特征X∈RC×H×W,其中C、H和W分别表示特征图的通道数、特征图的高度和特征图的宽度。Q为通道维度X∈RC×1×1的均值,σ2为通道维度方差。σ2的值影响特征图的丰富度,σ2值越大,特征图的方差越大,对应的特征图中的上下文信息越丰富。为了使注意力权重为正易化,我们在原始注意力分数的基础上加上1/2,用Sigmoid函数进行归一化,得到注意力权重。最后,将得到的注意力权重与输入特征图X(Value)相乘,得到输出特征图Y。SSFC策略如图2所示。

图2 提出的SSFC策略流程图。该策略与目前流行的2D注意力机制明显不同,它不需要任何可学习参数,仅通过启发式计算在特征图上生成3D注意力权重。

本文提出的SSFC策略可以利用空谱特征协同的思想生成三维注意力权重。通过建立空间-谱间依赖关系,SSFC可以增强遥感图像中变化目标的边缘和内部细节。与现有的注意力机制如SE[3]、CBAM[4]相比,SSFC没有添加任何可学习参数,更加简单高效。最后,我们将SSFC嵌入到MSDConv中,如图1 (b)所示。

3.实验

本文在三个遥感影像变化检测数据集上进行了实验。它们是LEVIR-CD [5], CDD[6]和DSIFN-CD[7]。为了评价提出方法的性能,本文主要使用Precision (Pre)、Recall (Rec)和F1-score (F1)三个评价指标对实验结果进行综合评价。实验结果如下。

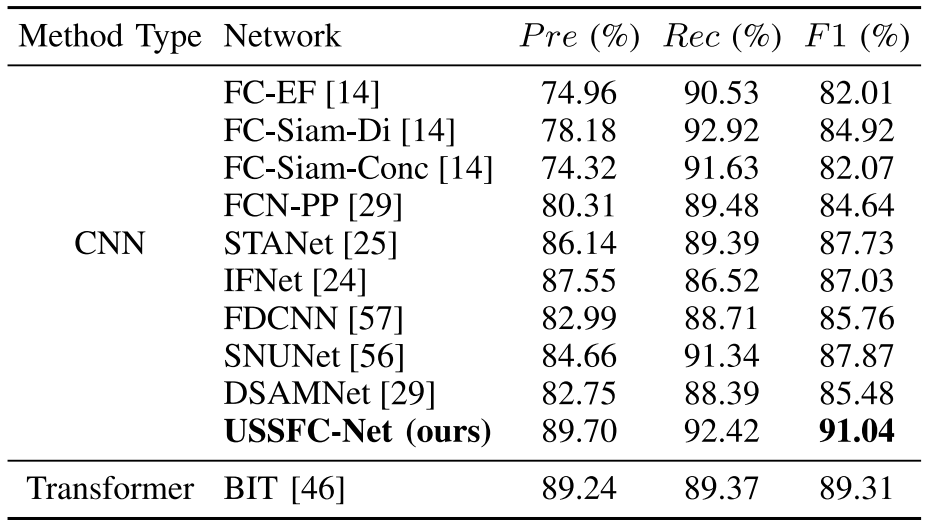

表1 在LEVIR-CD测试集的对比实验结果

表2 在CDD测试集的对比实验结果

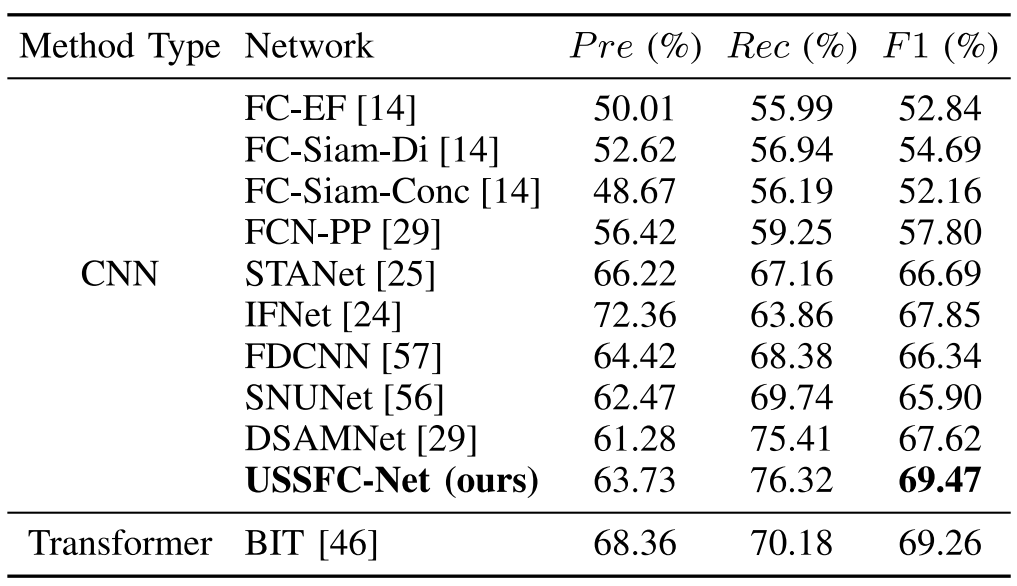

表3 在DSIFN-CD测试集的对比实验结果

在LEVIR-CD、CDD和DSIFN-CD数据集上的可视化实验结果如图3所示。

图3 LEVIR-CD、CDD和DSIFN-CD测试集结果的可视化比较。白色表示真阳性,黑色表示真阴性。(a)前时序图像; (b)后时空图像; (c)标签; (d)我们提出的USSFC-Net; (e)FC-EF; (f) FC-Siam-Di; (g) FC-Siam-Conc; (h)FCN-PP; (i)STANet; (j)IFNet; (k)FDCNN; (l)SNUNet; (m)DSAMNet; (n)BIT

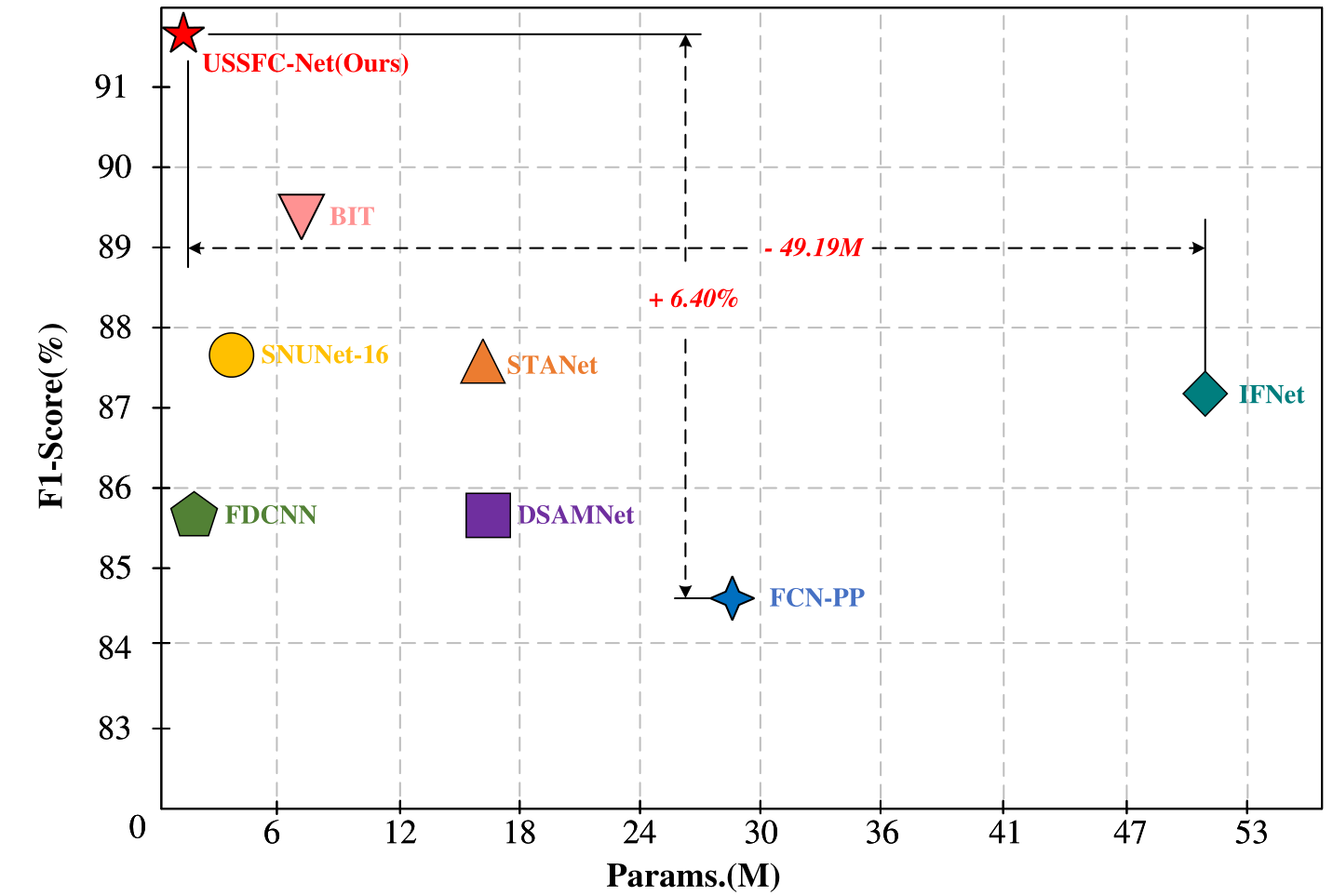

我们从不同角度测试和分析了所提出的USSFC-Net和其他遥感图像变化检测方法的模型效率。包括三个指标:F1,参数量(Params.)和浮点运算量(FLOPs)。具体结果如表4和图4所示。很明显,我们的方法具有最高的检测精度并且需要最低的参数和计算成本。

表4 模型效率对比实验结果

图4 不同方法计算效率(Params.)和精度(F1)的比较。

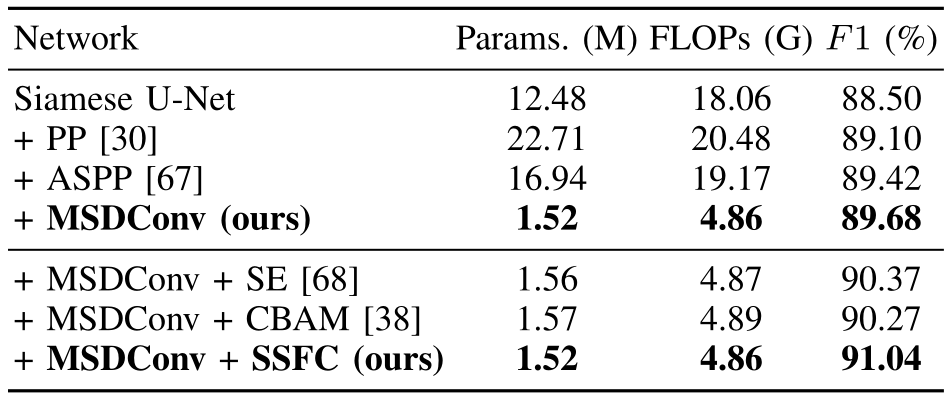

为了验证所提出的MSDConv和SSFC的有效性,我们分别对这两个模块进行了消融实验,结果如表5所示。

表5 提出的MSDConv和SSFC在LEVIR-CD测试集上的消融实验结果

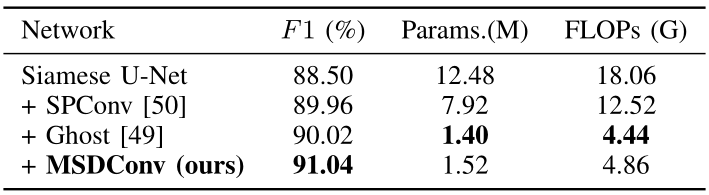

为了验证所提出的MSDConv比目前流行的轻量级卷积运算对网络压缩率和精度的贡献更大,我们在LEVIR-CD数据集上进行了实验,其中包括所提出的MSDConv与类似的轻量级卷积运算(包括SPConv[8]和Ghost Module[9])的性能比较,以及生成特征丰度的可视化结果。除此之外,我们也进行了一些实验以更科学地选择MSDConv的膨胀率组合,如表7所示。

表6 在LEVIR-CD测试集上不同轻量级卷积的比较

表7 在LEVIR-CD测试集上MSDConv中不同膨胀率组合的比较。

图 5 LEVIR-CD测试集上不同网络卷积层的信息熵,其大小反映了该卷积层包含的信息量的多少

图6 在LEVIR-CD测试集上对提出的MSDConv的特征图可视化。(a)前时序图像;(b)后时空图像;(c)标签;(d)孪生U-Net (e)提出的USSFC-Net。可以看出我们的方法可以得到更加丰富的特征图

图7 在LEVIR-CD测试集上SSFC后的特征激活。(a)前时序图像;(b)后时空图像;(c)特征激活图;(d)标签。(c)中的红色和黄色表示较高的注意力值。

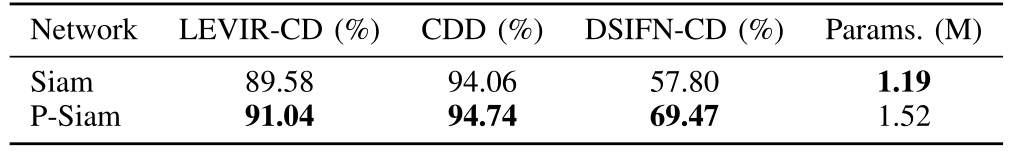

表8 三个测试集上的孪生USSFC-Net(Siam)和伪孪生的结构(P-Siam)的对比结果

4.总结

本文提出了一种用于遥感图像变化检测的超轻空谱特征协同网络(USSFC-Net)。提出的USSFC-Net通过引入MSDConv和SSFC解决了当前变化检测的主要问题。具体而言,MSDConv通过设计紧凑的结构,可以有效地提取变化对象的多尺度特征。SSFC策略有效地捕获全局上下文信息,通过共同建模空间和谱间特征来细化特征,并且不需要任何额外的参数。本文在三个变化检测公共数据集上测试了USSFC-Net。实验结果表明,该方法在检测精度、参数量和计算量方面优于其他基于CNN或Transformer的对比方法。值得注意的是,随着深度学习模型的普及,工业部署已经成为当前深度学习模型实际应用的重要挑战。希望所提出的USSFC-Net能够有效地解决在低资源设备上部署遥感图像变化检测模型的挑战,提高检测精度,同时实现模型的高效简化。

参考文献:

[1] R. C. Daudt, B. L. Saux, A. Boulch, “Fully convolutional siamese networks for change detection,” in Proc. Int. Conf. Image Process. (ICIP), 2018, pp. 4063-4067.

[2] F. Chollet, “Xception: Deep learning with depthwise separable convolutions,” in Proc. IEEE Conf. Comput. Vis. Pattern Recognit. (CVPR), 2017, pp. 1251-1258.

[3] J. Hu, L. Shen, G. Sun, “Squeeze-and-excitation networks,” in Proc. IEEE Conf. Comput. Vis. Pattern Recognit. (CVPR), 2018, pp. 71327141.

[4] S. Woo, J. Park, J. Y . Lee, and I. S. Kweon, “Cbam: Convolutional block attention module,” in Proc. Eur . Conf. Comput. Vis. (ECCV), 2018, pp. 3-19.

[5] H. Chen and Z. Shi, “A spatial-temporal attention-based method and a new dataset for remote sensing image change detection,” Remote Sens., vol. 12, no. 10, p. 1662, 2020.

[6] M. A. Lebedev, Y . V . Vizilter, O. V . Vygolov, V . A. Knyaz, and A. Y . Rubis, “Change detection in remote sensing images using conditional adversarial networks,” ISPRS Int. Arch. Photogramm. Remote Sens. Spat. Inf. Sci., vol. 42, no. 2, pp. 565-571, 2018.

[7] C. Zhang, P . Y ue, D. Tapete, L. Jiang, B. Shangguan, L. Huang and G. Liu, “A deeply supervised image fusion network for change detection in high resolution bi-temporal remote sensing images,” ISPRS J. Photogramm. Remote Sens., vol. 166, pp. 183-200, 2020.

[8] K. Han, Y . Wang, Q. Tian, et al., “Ghostnet: More features from cheap operations,” in Proc. IEEE/CVF Conf. Comput. Vis. Pattern Recognit. (CVPR), 2020, pp. 1580-1589.

[9] Q. Zhang, Z. Jiang, Q. Lu, J. N. Han, Z. Zeng, S. H. Gao and A. Men, “Split to be slim: An overlooked redundancy in vanilla convolution,” in Proc. Int. Joint Conf. Artif. Intell. (IJCAI), 2021, pp. 3195-3201.