SeaFormer: Squeeze-enhanced Axial Transformer for Mobile Semantic Segmentation

* Authors: [[Qiang Wan]], [[Zilong Huang]], [[Jiachen Lu]], [[Gang Yu]], [[Li Zhang]]

初读印象

comment:: (SeaFormer)提出了一种适用于移动设备的轻量级网络,设计了一个通用的注意力块,特点是提出了轴向压缩和细节增强。

动机

Transformer的计算成本和内存需求使得这些方法不适用于移动设备,尤其是高分辨率图像输入。

其他优化方法存在延迟过高的问题。

轴向注意力及其变种以相当低的计算成本提供了性能增益。但忽略了池化/平均操作带来的局部细节的缺失。

方法

总体框架

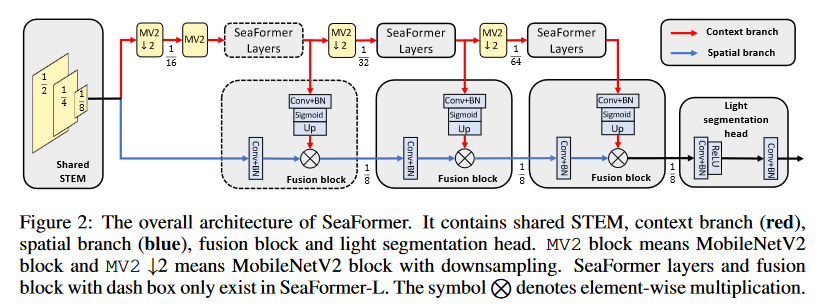

模型结构主要包含了MV2的Stem、上下文和空间分支和轻量分割头。- Stem:仅将特征下采样8倍,并且其中config系数在topformer的基础上对倒数第二个stage减少了一层,并增加了通道数量。

模型结构主要包含了MV2的Stem、上下文和空间分支和轻量分割头。- Stem:仅将特征下采样8倍,并且其中config系数在topformer的基础上对倒数第二个stage减少了一层,并增加了通道数量。

- 上下文分支:获得更大的感受野,获得上下文信息。特征进一步进行三个stage的下采样,并中间使用设计的seaformer layer进行特征增强。backbone部分由stem和上下文分支组成。

- 空间分支:采用大分辨率的特征,并使用特征融合模块不断吸收来自高分辨率的上下文信息。

- 轻量分割头:将特征从8倍下采样后进行像素分类。

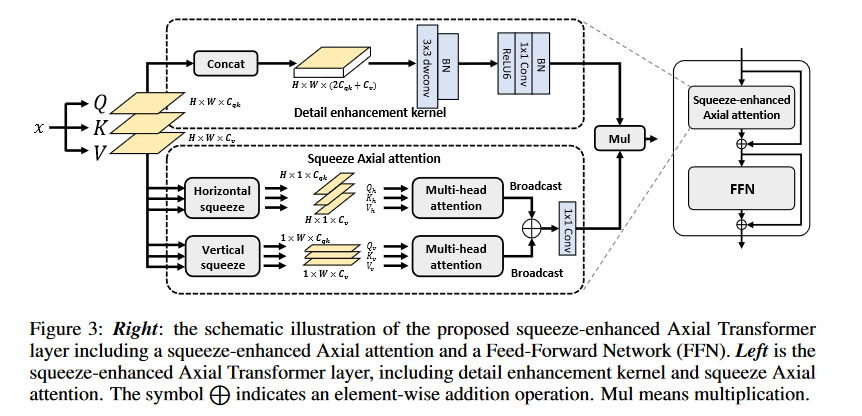

Squeeze-Enhanced Axial Attention

- 上半:将QKV进行拼接并卷积以提取局部信息。

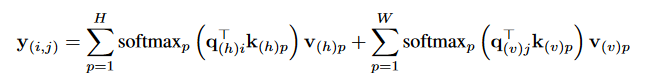

- 下半:分别在水平和竖直方向求平均,压缩操作将全局信息保留到单一坐标轴上,从而大大减轻了全局语义提取。在两个方向分别作注意力:

*通过广播进行相加。

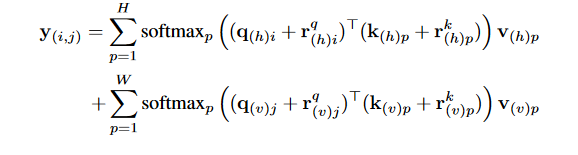

*通过广播进行相加。 - 嵌入绝对位置感知:

启示

可以学习此论文的写作和画图。

- Squeeze-enhanced Segmentation Transformer SeaFormer Semanticsqueeze-enhanced segmentation transformer seaformer convolutional segmentation networks semantic segmentation criss-cross attention semantic segmentation generative gaussian semantic segmentation attentional semantic network segmentation transformers semantic segvit segmentation transformer unetformer unet-like transformer-based combinations segmentation seaformer squeeze-enhanced