LangKit:大语言模型界的“安全管家”

发布时间 2023-06-27 11:04:58作者: BOTAI

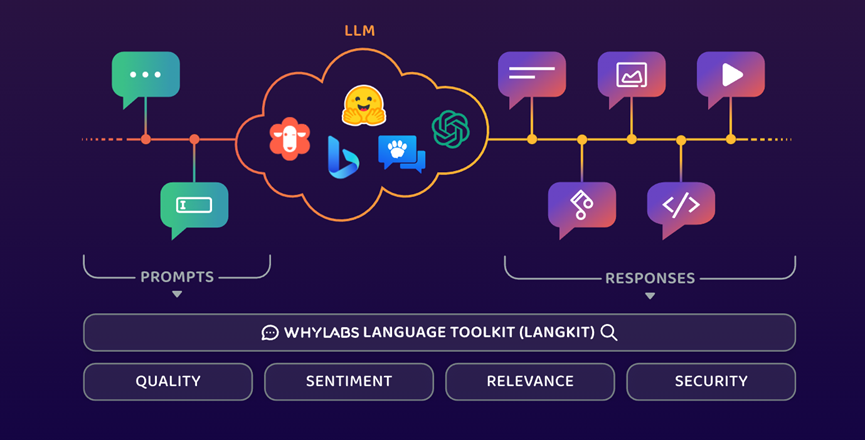

ChatGPT等大语言模型一直有生成虚假信息、数据隐私、生成歧视信息等难题,阻碍了业务场景化落地。为了解决这些痛点并增强大语言模型的安全性,AI和数据监控平台WhyLabs推出了LangKit。(开源地址:https://github.com/whylabs/langkit)

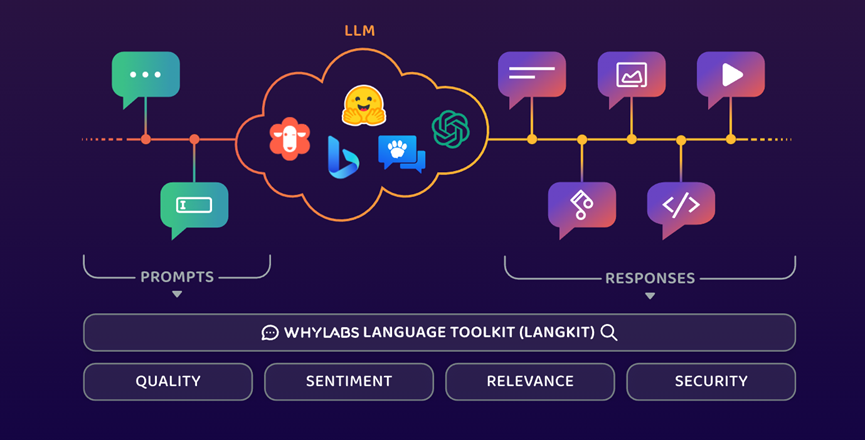

LangKit提供文本输入/输出监控、安全和隐私、情绪分析、虚假信息分析等功能,适用于ChatGPT、LLaMA、Alpaca、Guanaco、Vicuna、 Dolly、Bard等大语言模型。

「AIGC开放社区」免费体验了一下LangKit的功能,6分钟左右就能完成基础模块配置,支持可视化数据监测,可以精准到按小时观察大语言模型的活动、异常、输出等参数。总体来说,LangKit相当于大语言模型的“安全管家”,可有效降低大语言模型的非法内容输出。(免费体验地址:https://whylabs.ai/whylabs-free-sign-up?ref=content.whylabs.ai)

LangKit产品演示

在大语言模型的使用过程中,内容输出的准确性非常重要尤其是对金融、医疗、制造等对数据准确性要求极高的行业。

所以,LangKit可以通过内容设定和文本输出、主题交互等多渠道跟踪监测,可以增强模型的内容输出准确性。产品方面,LangKit主要提供内容护栏、大语言模型评估和可视化数据监测三大功能。

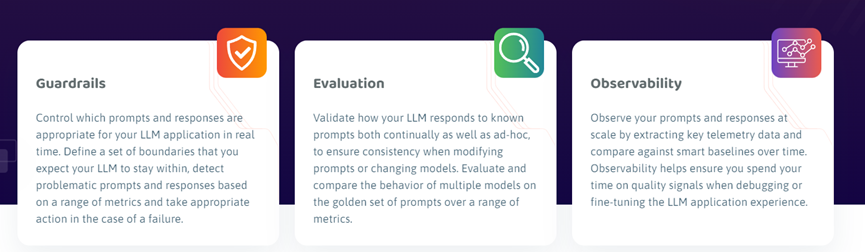

内容护栏:用户可以定义大语言模型的内容护栏,将歧视、非法、敏感的数据进行过滤。例如,不允许大语言模型输出一些非法信息的输出,如何制作高精度毒品。用户在控制台启动内容护栏后,大语言模型就不会输出这类内容。

大语言模型评估:LangKit提供了一系列评估标准、参数,来帮助用户评估其大语言模型的输出、提示是否符合安全标准,并提供合理的治理和合规策略。

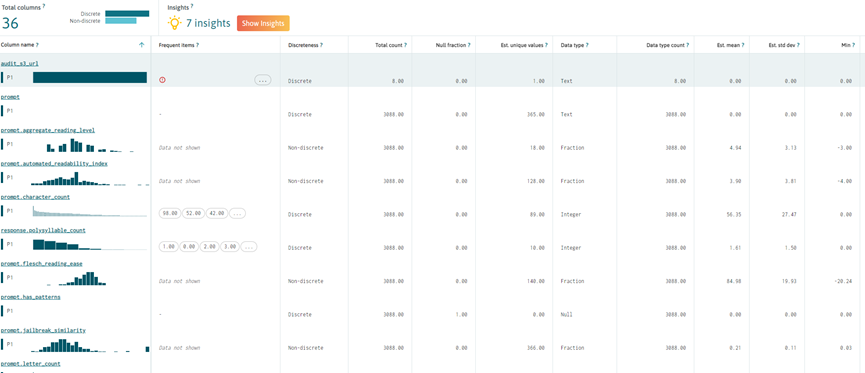

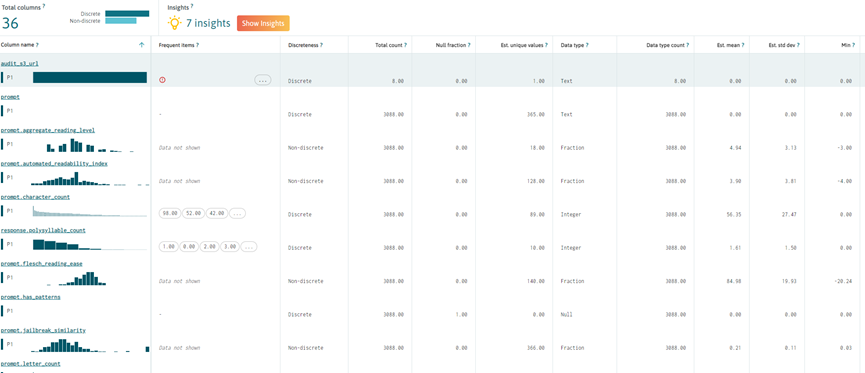

可视化数据监测:几乎LangKit的所有功能都提供了可视化数据监测,让用户更简单、直观的大语言模型的活动、异常等。功能包括,模型活动、输入、输出、表现、性能追踪、特征输出等元素监测。

LangKit的使用流程非常简单,「AIGC开放社区」通过在线方式体验了一下,下面是产品使用流程。

1)在https://whylabs.ai/whylabs-free-sign-up?ref=content.whylabs.ai点击【GET STARTED FOR FREE】免费注册一个账号。

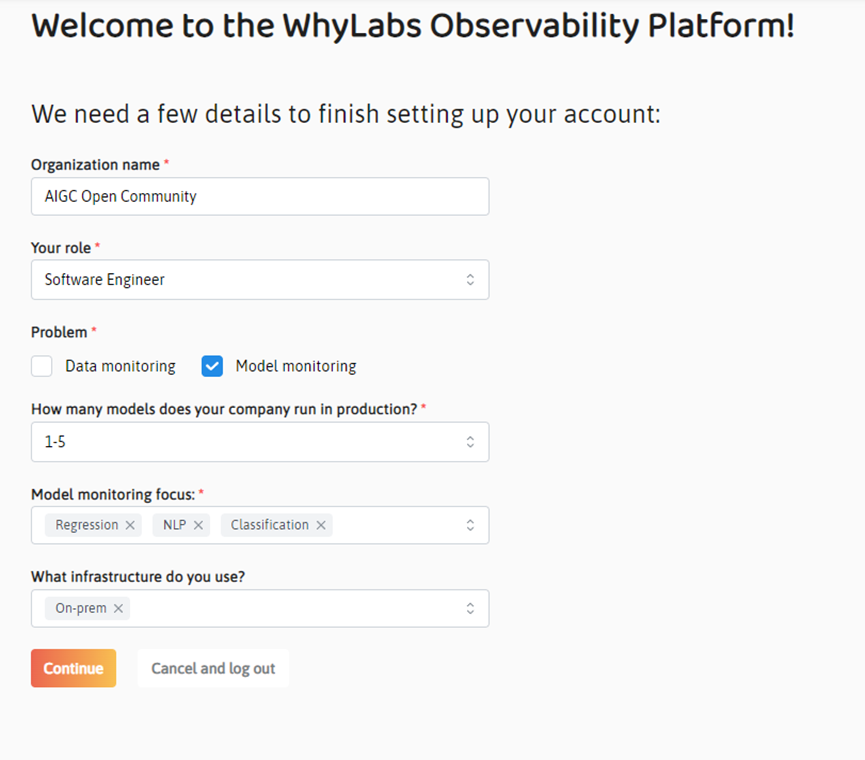

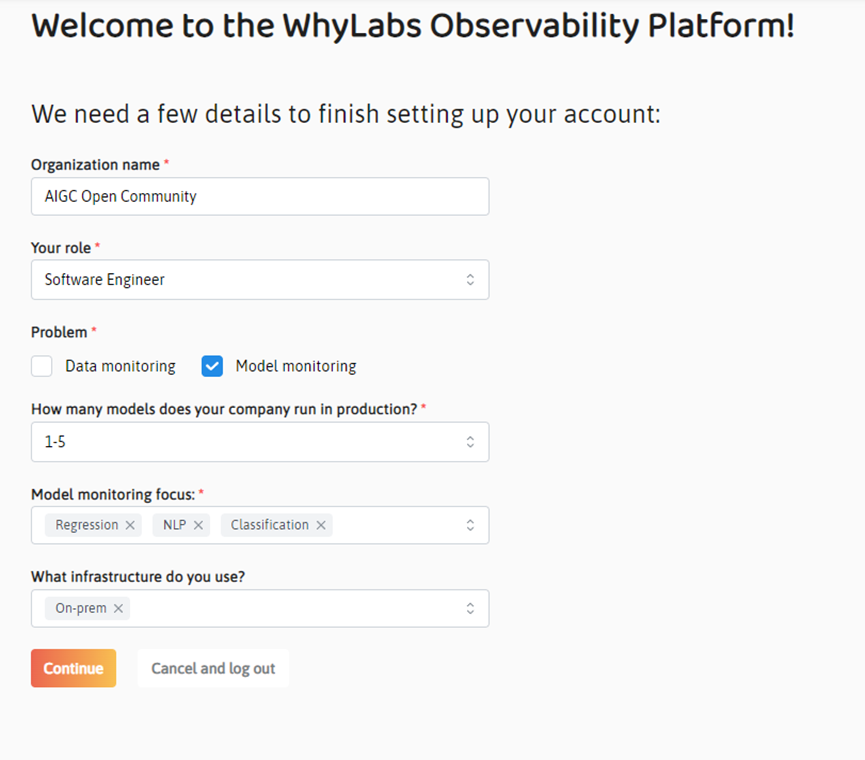

2)注册完毕后,登录账号,然后输入组织机构的名称、岗位角色、监控类型(选模型监控)、模型数量、模型监控重点和基础设施等。

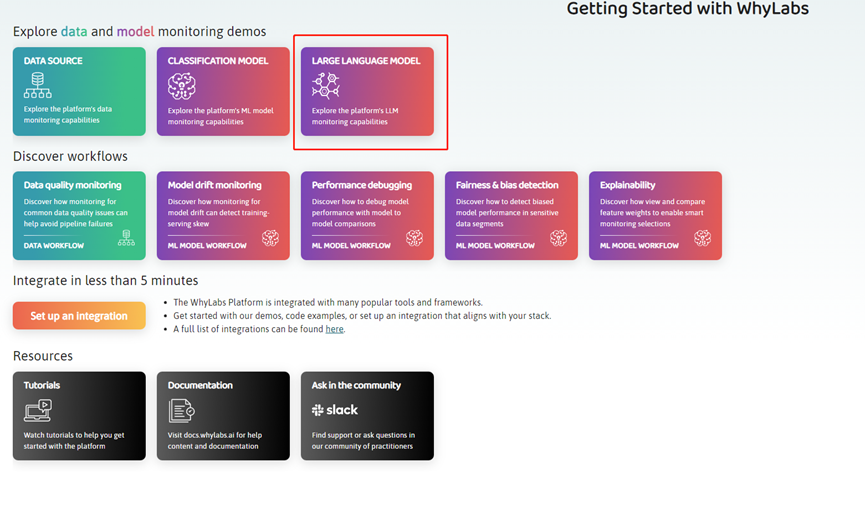

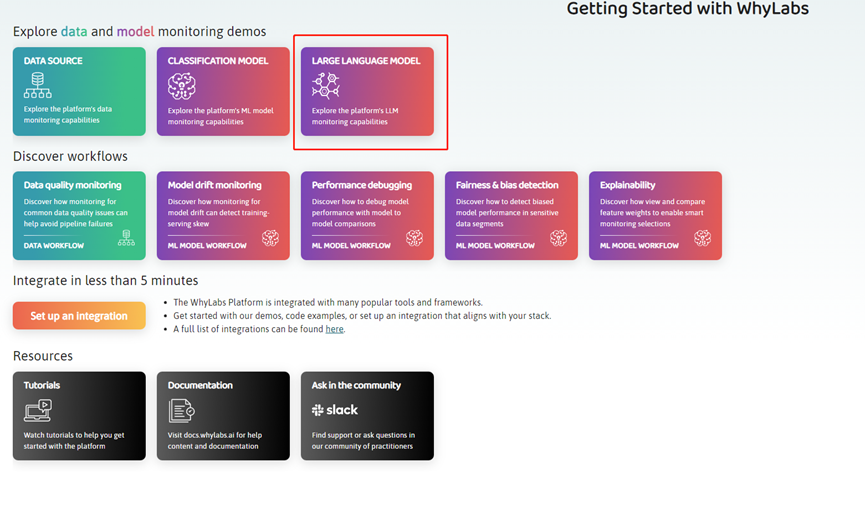

3)如果不熟悉LangKit的产品和基础设置,可以选择大语言模型演示,将为用户提供完成的功能展示。

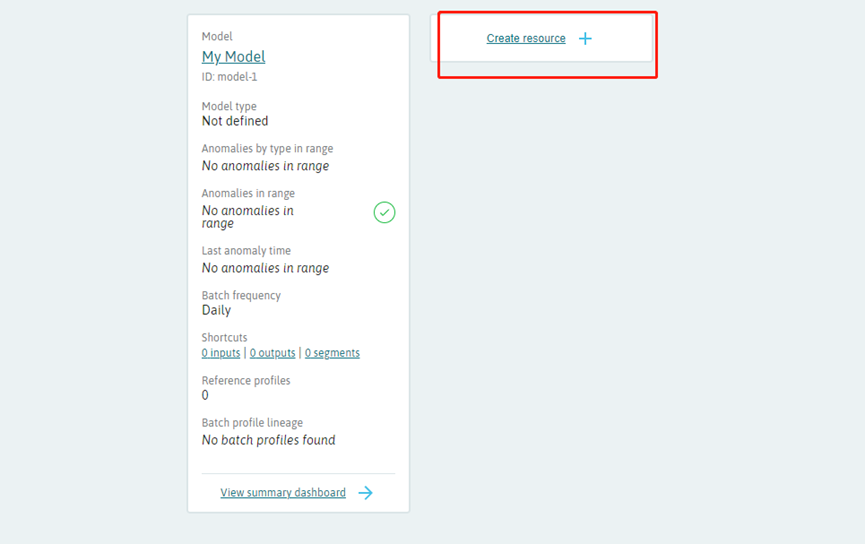

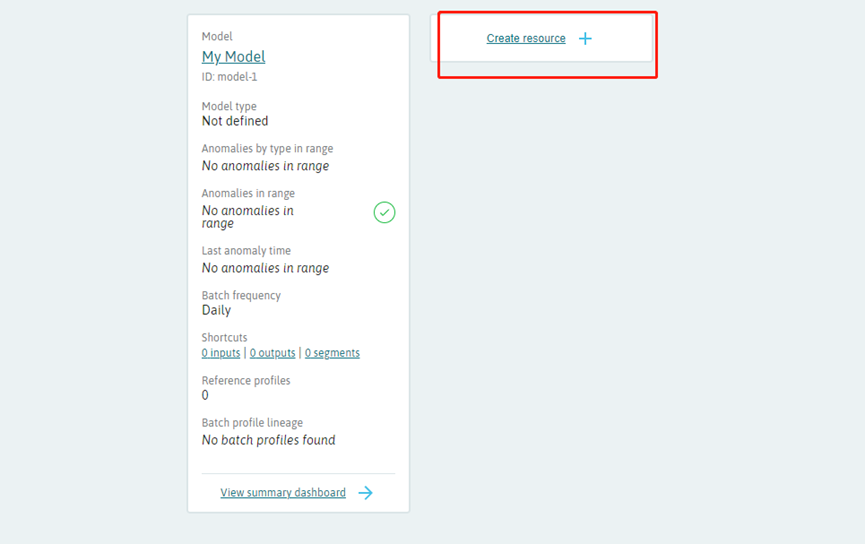

4)熟悉功能后点击退出演示,选择自己的组织名称,然后点击【Create resource】开始进行模型监控配置即可。

数据安全方面,WhyLabs表示,与其他大语言模型监控产品相比,LangKit不会存储用户输入的数据或模型的输出内容。

LangKit只搜集相关的提示、响应数据和用户交互时模型所产生的基本提示,仅使用少量的数据1小时就能监控大语言模型数百万次交互记录。这极大的保证了企业和用户的数据安全。