发表时间:2020

文章要点:这篇文章提出了Prioritized Sequence Experience Replay (PSER),一个新的经验回放机制来提升训练速度和效果。主要的出发点就是不仅要给重要的transition高的priority,对于到达这个重要的transition的之前的那些transitions,也要增加它们的priority(also increases the priorities of previous transitions leading to the important transitions)。

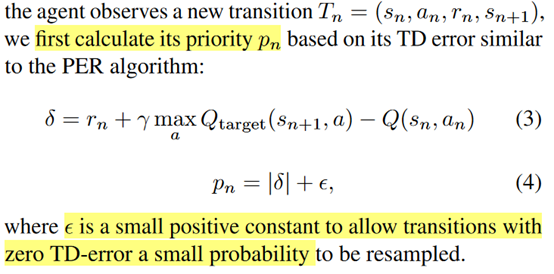

具体的,作者先和PER一样,根据TD error算一个priority

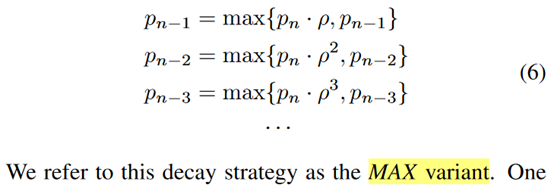

这个\(p_n\)是\(s_n\)的priority,然后基于这个\(p_n\)来做衰减,给前面的状态赋priority

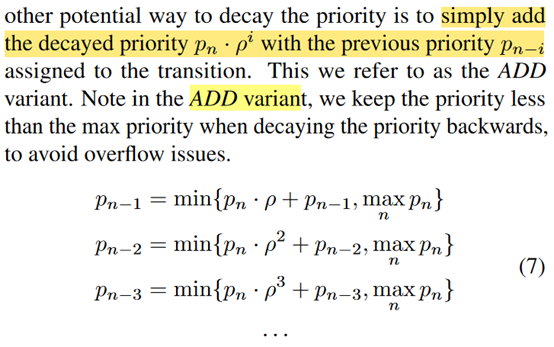

或者

然后作者并不是衰减到一条轨迹的初始状态,而是设置了一个window来衰减,window之外的不变。作者解释是因为指数衰减很快,太远的地方其实值已经很小了,起不到什么作用了,这样做可以减少计算量。Window的指标就是小于1%就不算了。

此外,作者还发现一个称为priority collapse的问题,就是说假如PSER已经给一个状态赋了一个很小的priority,那么再对前面的值衰减,那前面的transition就更小了,那么就和PER没有区别了。作者就又加了一个参数来让衰减慢一点

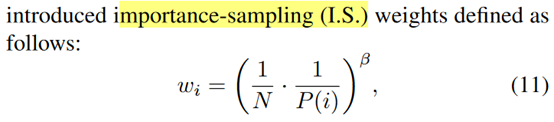

最后,PSER也用了PER的权重修正

然后就结束了。

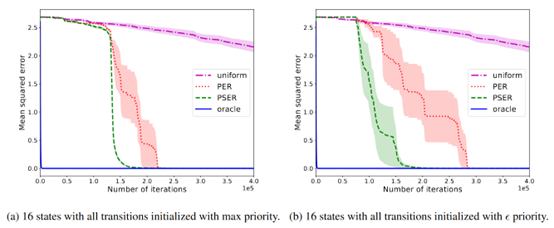

总结:总的来说,就是给当前采到的transition之前的transition加一个衰减了的priority,然后又用trick控制了衰减速度。从效果上来看有一定提升的,不过好像就跑了一个种子,还有可能就是因为trick太多,而且没有解释清楚为啥这些因素work,所以没中吧。

疑问:这个确实感觉就像是trick,效果不太好说。

- Prioritized Experience Sequence Replayprioritized experience sequence replay model-augmented prioritized experience augmented replay conservative estimation experience prioritized perspective revisiting experience experience efficient tables replay optimization experience replay experience framework reverb replay fundamentals revisiting experience replay experience remember forget replay topological experience replay