1.针对的问题

在弱监督时序动作定位领域提出了一些帧监督的方法,但是由于标签稀疏性,现有的工作无法学习动作的完整性,动作预测零碎,导致在高IoU阈值的情况下表现较差。作者试图通过生成密集的伪标签,为模型提供完整性指导。

2.主要贡献

•引入了一个新的框架,其中生成了密集的最优序列,以在点监督设置下为模型提供完整性指导。

•提出了两种新的损失,通过对比动作实例与背景实例的动作分数和特征相似性,促进动作完整性学习。

•模型达到了最新水平,在四个基准上有很大差距。此外,它甚至在完全监督的方法中表现良好。

3.方法

首先选择伪背景点来补充点级动作标签。然后,通过将这些点作为种子,在确定种子的同时,搜索可能包含完整动作实例的最佳序列。为了从获得的序列中学习完整性,作者引入了两种新的损失,分别从动作得分和特征相似性的角度将动作实例与背景实例进行对比。

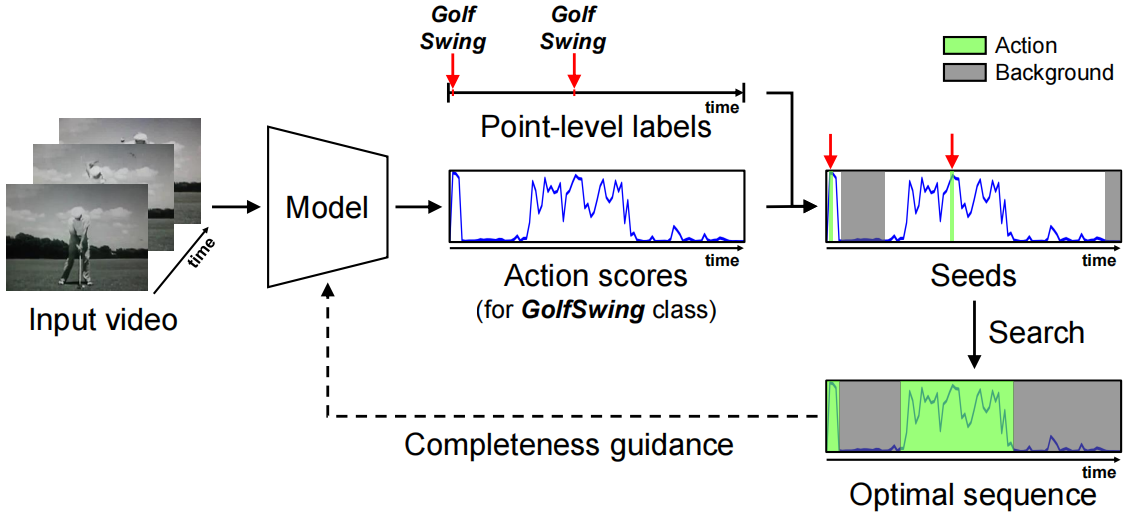

想法的简化说明。作者使用点作为种子来寻找最优序列,从而为模型提供完整性指导。

方法概述。除了传统的目标,即视频级和点级的分类损失外,作者还建议学习动作的完整性(下部)。根据最终的动作分数,在与点级标签一致的候选者中选择最优序列。它反过来提供了完整性指导与两个提出的损失,对比动作实例与背景实例有关的(a)动作得分和(b)特征相似性

先将输入的视频分成16帧的片段,然后将其输入到预先训练好的特征提取器中。将得到的双流特征通过concatenation融合,得到X∈RD×T,其中D和T分别表示特征维数和段数。然后经过单个1D卷积层,然后再进行ReLU激活,从而生成嵌入特征F∈RD×T。然后,将嵌入特征输入到具有sigmoid函数的一维卷积层中,以预测段级类分数P∈RC×T,其中C表示动作类的数量。同时,推导了class-agnostic的背景分数Q∈RT,来建模不属于任何动作类的背景帧。然后,我们将动作分数与背景概率的complement相融合,得到最终的分数![]() ,即

,即![]() 。然后使用时序top-k得到视频级类别得分。

。然后使用时序top-k得到视频级类别得分。

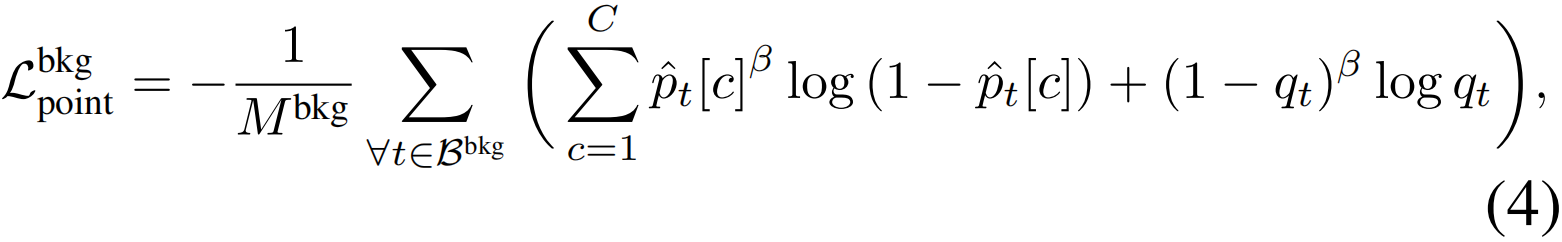

这里作者收集了一些伪背景点来补充动作点。选择原则是,必须在两个相邻的动作实例之间放置至少一个背景帧,以将它们分开。具体来说,在两个相邻的动作点之间,找到背景分数大于阈值的片段。如果某个区段中没有满足条件的片段,将选择背景分数最大的片段。同时,对于在一个部分中选择多个背景点的情况,将它们之间的所有点标记为背景,背景点的分类损失计算方法为:

其中,Mbkg为所选背景点的个数,β为focusing因子。

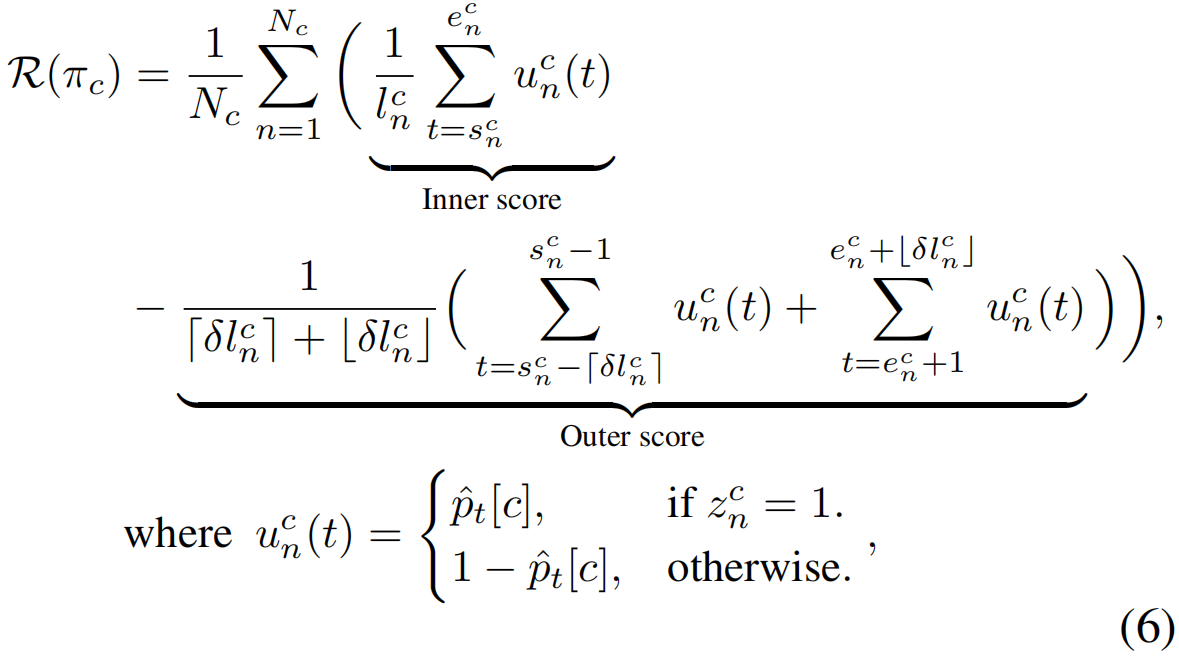

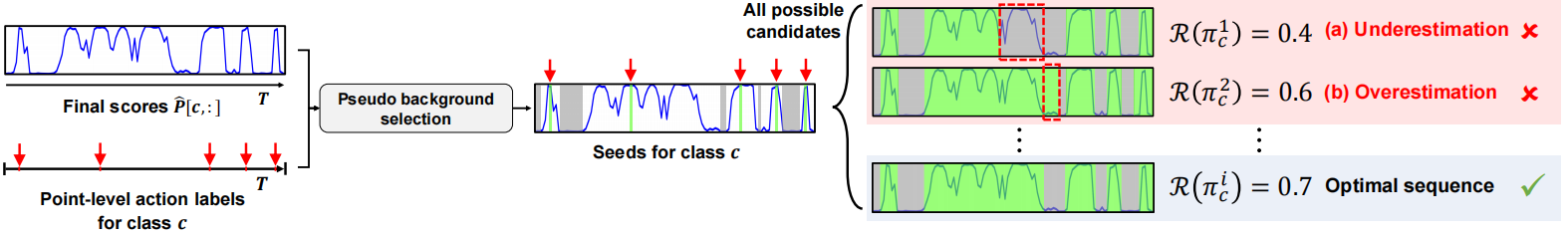

最优序列搜索 点级别的分类损失不足以了解行动的完整性,因为点标签只覆盖了行动实例的一小部分。因此,作者提出生成密集的伪标签,这些伪标签可以为模型的动作完整性提供一些提示。这里基于的逻辑是,对于一个完整的动作实例,内部分数和外部分数之间的对比可能很大,但对于一个不完整的动作实例来说却很小。作者利用这一点作为一个评分函数来搜索最优序列,从中模型可以学习动作的完整性。

类的序列表示为πc={(scn,ecn , zcn)}Ncn=1,其中scn和ecn分别表示第n个实例的起始点和结束点,而Nc为类c的实例总数。另外,zcn∈{0,1}表示实例的类型,即如果第n个实例是第c个动作类的,则zcn = 1,否则为0(背景),给定一个输入序列,第c类动作类的序列πc的完整性得分计算方法为

lcn=ecn−scn + 1是πc的第n个实例的时间长度,δ是调整外部范围的超参数(设置为0.25),Nc是c类的动作和背景实例的总数。然后,可以通过找到使得分最大化的序列来获得c类的最优序列,即,π∗c= arg maxπc R(πc),最优序列搜索过程如下图所示:

给定了class-specific的最优序列{π∗c}Cc=1,目标是让模型学习动作的完整性。为此,作者设计了两个损失,通过对比动作实例和背景实例来实现完整性学习。这有助于进行完整的行动预测。

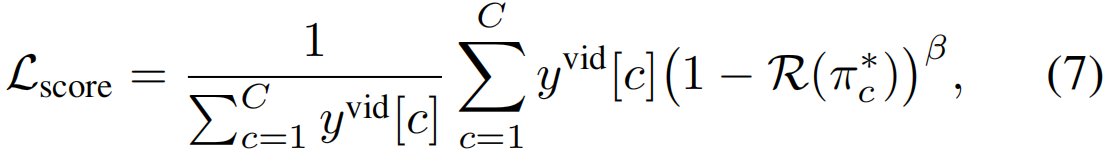

分数对比损失 鼓励模型根据最终分数将动作(背景)实例与其周围环境分开。它也可以解释为将模型输出拟合到最佳序列(图2a)。从形式上讲,损失的计算方法是:

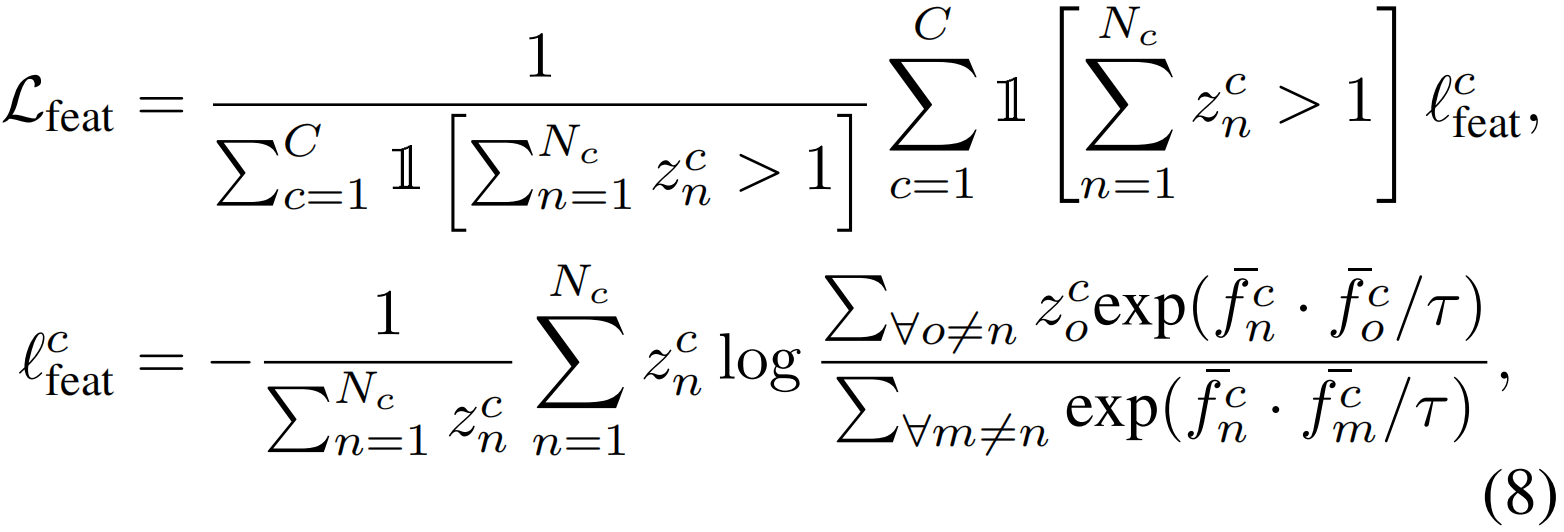

特征对比损失 与同一视频中的任何其他背景实例相比,来自不同实例但具有相同动作类别的特征应该更接近彼此,给定最优序列{π∗c= {(scn,ecn,zcn)}Ncn=1}Cc=1,所提出的特征对比损失表示为:

其中lcfeat为c类的部分损失,τ为温度参数,1[·]为指标函数。

- Action Weakly-supervised Completeness Localization supervisedaction weakly-supervised completeness localization weakly-supervised weakly-supervised segmentation transformers representative localization propagation supervised completeness localization localization simultaneous real-time slamesh api-ms-win-core-localization-l api-ms-win-core-localization-l localization localization cross-modal moment videos