1、⼤数据

-

⼤数据:是指⽆法在⼀定时间内⽤常规软件⼯具对其内容进⾏抓取、管理和处理的数据集合

-

主要解决海量的数据存储和分析计算的问题。

2、数据单位

-

按⼤小: bit Byte KB MB GB TB PB EB ZB YB BB NB DB

-

1Byte=8bit 1KB=1024Byte 1MB=1024KB...

3、⼤数据4特征 4V

- 时效性

- 不可变性

5、⼤数据部门的组织结构

- 平台组

-

Hadoop,Flume,Kafka,Hbase,Spark,Hive 等框架的平台搭建

-

集群性能监控

-

集群性能调优

-

-

数据仓库组

-

ETL⼯程师 (数据清洗)

-

数据分析(数据仓库建模)

-

- 实时组

-

实时的指标分析,性能调优

-

- 数据挖掘组

- 算法工程师

- 推荐系统

- 用户画像工程师

6、Hadoop

-

Hadoop是⼀个开源分布式系统架构,解决海量数据存储和海量数据计算的问题

-

创始⼈:Doug Cutting

-

2008年 - 成为Apache顶级项⽬

-

Hadoop发⾏版本社区版:Apache HadoopCloudera发⾏版:CDHHortonworks发⾏版:HDP

7、为什么使⽤Hadoop

-

hadoop 1.x

-

MapReduce(计算+资源调度)

-

HDFS (数据存储)

-

Common (辅助⼯具)

-

-

hadoop 2.x

-

MapReduce(计算)

-

Yarn (资源调度)

-

HDFS (数据存储)

-

Common (辅助⼯具)

-

9、Common (辅助⼯具)

-

nn NameNode 存储⽂件的元数据, 如 ⽂件名,⽂件⽬录结构,⽂件属性(⽣成时间 ,副本数,⽂件权限),以及每个⽂件的块列表和块所在的DataNode等。

-

dn DataNode 在本地⽂件系统存储⽂件块数据,以及块数据的检验和

-

2nn Secondary NameNode 每隔⼀段时间 对NameNode元数据备份

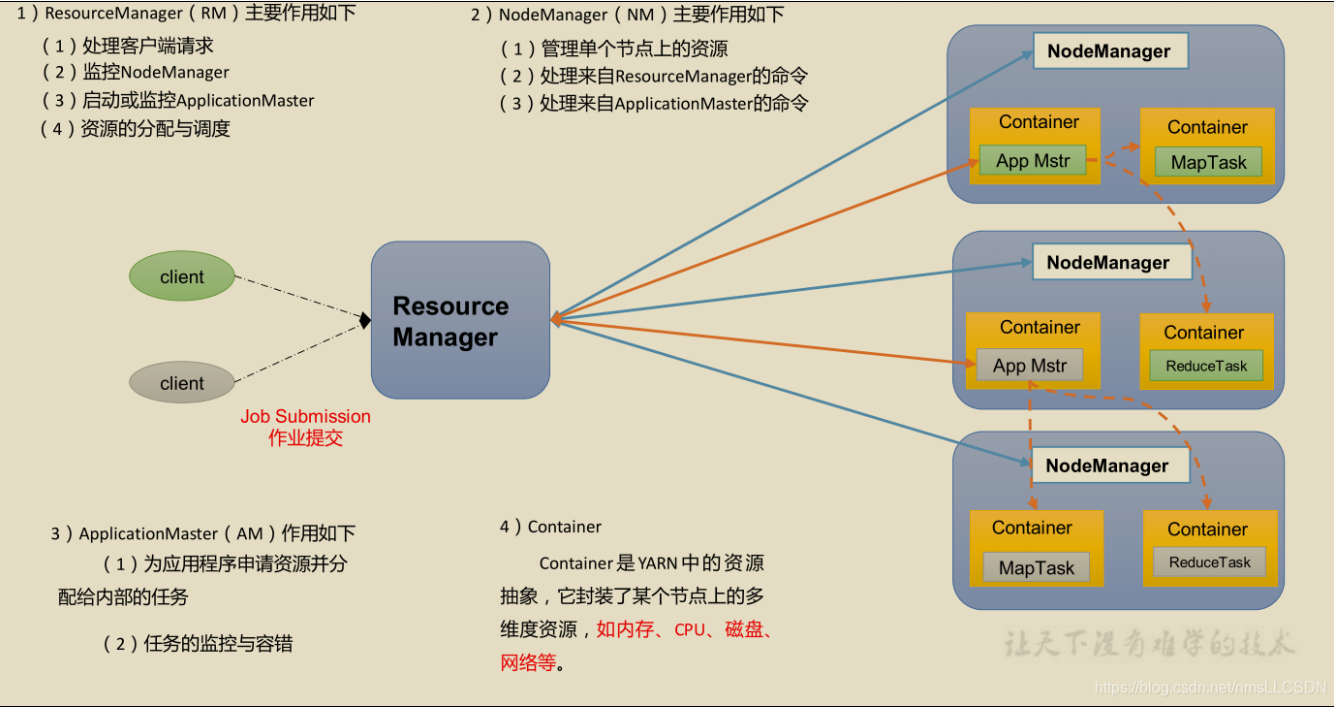

10、Yarn 架构概述

11、MapReduce 架构

- Map 阶段并⾏处理输⼊数据

- Reduce 阶段对Map结果进⾏汇总

12、⼤数据的⽣态体系

- 数据来源层

数据库(结构化的数据) ⽂件⽇志(半结构化数据) 视频PPT等(⾮结构化的数据)

- 数据传输层 sqoop 数据传递 Flume⽇志收集 Kafka 消息队列

- 数据存储层 HDFS存储

-

资源管理层 Yarn资源管理

-

数据计算层

-

MapReduce离线计算 -> Hive 数据查询

-

Spark Core 内存计算

-

数据挖掘SparkMilib

-

数据查询 Spark sql

-

实时计算 Spark Streaming

-

- Storm 实时计算 Flink

-

- 任务调度层 Azkaban任务调度

-

数据模型层 数据可视化,业务应⽤

13、Hadoop运⾏环境搭建(重点)

1、启动虚拟机hadoop101

2、检查jdk是否已安装:java -version

3、在windows端修改hosts使192.168.18.101与hadoop101对应并 ping通

4、切换到安装包路径:cd /opt/software/并上传hadoop-2.6.0.tar.gz

5、解压安装包⽂件:tar -zxvf hadoop-2.6.0.tar.gz -C /opt/install/

6、创建软链接:切换到install⽬录cd /opt/install 然后再创建软件 链接 ln -s hadoop-2.6.0/ hadoop

7、添加环境变量:vi /etc/profile,并在最后添加以下两⾏

8、使配置⽂件⽣效:source /etc/profile

9、测试试是否安装成功:hadoop version

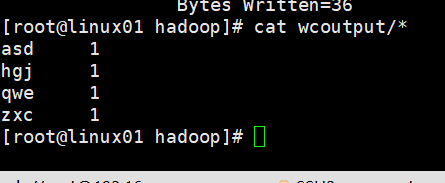

10、测试本地运⾏模式:当前在/opt/install/hadoop/⽬录下,创建 输⼊⽬录:mkdir wcinput

11、创建wc.input⽂件:cd wcinput/;vi wc.input,并在⽂件中输⼊ 任意单词,然后保存退出

12、切换到/opt/install/hadoop⽬录:cd /opt/install/hadoop

13、执⾏程序:hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.6.0.jar wordcount wcinput wcoutput

14、查看输出⽂件:cat wcoutput/*

15、清理测试⽂件并停机做快照