Deep-Learning-Based Spatio-Temporal-Spectral Integrated Fusion of Heterogeneous Remote Sensing Images

abstract

为了解决STF中的生成heterogeneous images问题:

为此,本文首次提出了一种基于新型深度残差循环生成对抗网络 (GAN) 的异构集成框架。

所提出的网络由前向融合部分和后向退化反馈部分组成。前向部分根据各种观察结果生成所需的融合结果;后向退化反馈部分考虑成像退化过程,并从融合结果中反向生成观察结果。

所提出的网络支持的异构集成融合框架可以同时合并多源异构观测的互补空间、时间和光谱信息,以实现异构时空融合、时空融合和异构时空-光谱融合。

此外,可以利用所提出的异构集成融合框架来缓解土地覆盖变化和厚云层覆盖的两个瓶颈。

introduction

大多数这些STF方法都可以捕获物候变化,但它们在反映土地覆盖变化方面存在瓶颈,特别是当变化的土地覆盖在目标时间的LR 图像中难以察觉时。

然而,由于多源数据集之间存在复杂的非线性关系,目前对融合融合方法的研究仅限于同质光学图像,没有考虑SAR和光学图像等不同成像机制的异构信息。

同质光学(homogeneous optics)是指一种光学成像系统,在这个系统中,光线在整个成像系统中传播的过程中不会发生折射、反射或散射等光学效应,即光线的传播路径是均匀的。同质光学系统包括很多光学仪器,如简单的放大镜、显微镜、望远镜等。在同质光学系统中,光线的传播路径可以通过几何光学来描述,因为光线的路径可以用直线来表示,而不需要考虑光的波动性。同质光学成像系统的优点是成像质量高、构造简单、成本低廉,因此在很多应用领域得到广泛应用。

SAR(Synthetic Aperture Radar,合成孔径雷达)和光学图像是两种不同的成像机制。其中,光学图像是利用可见光、红外线等电磁波进行成像,而SAR则是通过发射微波信号,利用微波信号在地面物体上的散射反射来实现成像。由于这两种成像机制的不同,它们获得的图像数据也有很大的差别。例如,光学图像可以提供高分辨率、高精度的彩色图像,而SAR图像则可以在天气恶劣、遮挡严重的情况下提供更好的图像质量。因此,在进行图像融合时,需要考虑这些不同成像机制的异构信息,将它们合并起来,以获得更全面、准确的信息。如果没有考虑这些异构信息,可能会导致融合后的图像失真、信息不足或不准确,从而影响融合结果的质量和有效性。

本文贡献:

- 我们提出了一种新颖的深度残差循环 GAN,它由前向融合部分和后向退化反馈部分组成,其中从前向部分的输入到后向部分的输出形成循环一致性约束。

- 首次实现了多源异构遥感影像的融合,成功实现了异构时空融合、时空融合和异构时空-光谱融合。

- 所提出的异构集成融合框架可以有效缓解土地覆盖变化和厚云覆盖的两大瓶颈,不仅可以预测目标时间的 HR 图像,还可以预测变化。

PROPOSED METHOD

\(X\in R^{M\times N \times B}\) 表示目标时间 t2 所需的 HR MS(多光谱)图像.

\(\tilde{X}\in R^{m\times n\times B}\)表示在 t2 处观察到的 LR MS 图像。

\(S = M/m = N/n\) 是 LR MS 图像与 HR MS 图像的空间分辨率比。

\(\hat{X}\in R^{M\times N \times B}\)是\(\tilde{X}\) 双三次上采样到与X相同空间大小的结果.

\(Y\in R^{M\times N \times b}\) 表示在 t2 观测到的 HR SAR 图像,其中 b < B。

\(Z \in R^{M×N×B}\) 表示在辅助时间 t1 观察到的 HR MS 图像。请注意,t2 在 t1 之后.

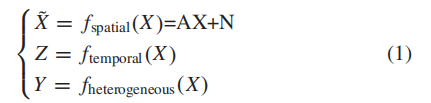

观察结果与所需图像之间的关系可以表示为:

其中\(f_{spatial}(·)\)表示X到\(\tilde{X}\)的空间退化关系,通常假设为模糊降采样操作[6],可以用模糊降采样矩阵A和噪声N表示.

\(f_{temporal}(·)\) 表示从 X 到 Z 的时间关系,通常假定为线性模型 [29]、[31]。

\(f_{heterogeneous}(·)\) 表示 X 和 Y 之间的异质关系,目前很难明确表达。

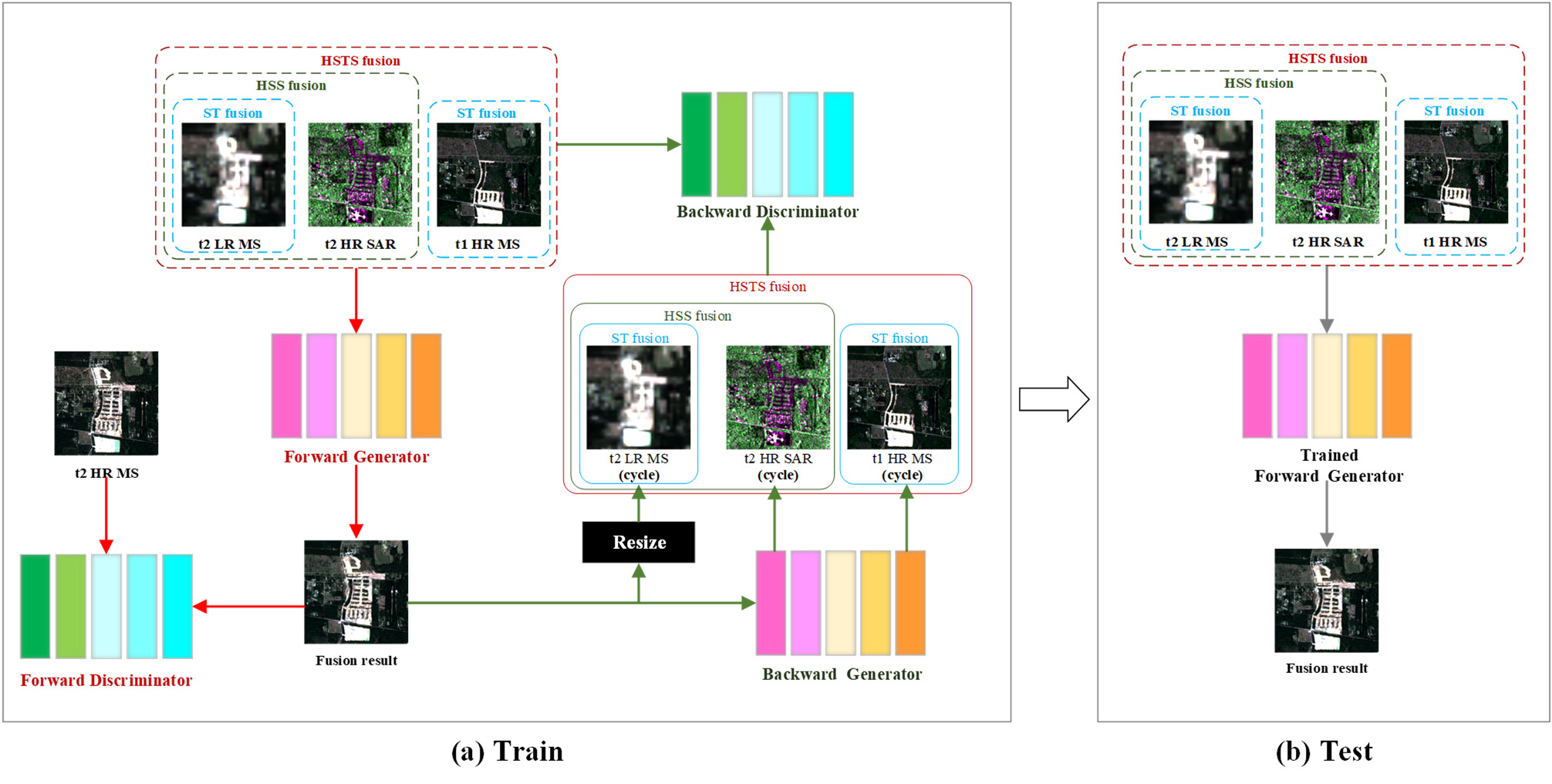

在上图1(a)所示的网络训练中,网络可以分为前向融合部分和后向退化反馈部分.

前向融合部分包括前向生成器和前向鉴别器。

正向生成器网络的输入由调整为相同空间大小并沿光谱维度连接的观测值组成。

具体来说,对于异构时空-光谱融合,前向生成器的输入由t2 HR SAR、t1 HR MS 和调整大小的 t2 LR MS 图像组成,即 \((Y, Z, \hat{X})\)。

对于异构空间光谱融合,正向生成器的输入是 \((Y, \hat{X})\)。

对于时空融合,前向生成器的输入是 \((Z, \hat{X})\)。

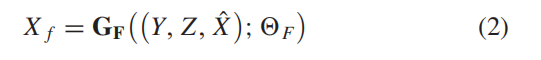

也就是说,训练了三个网络以利用不同融合策略的效果。在下文中,我们以异构时空-光谱融合为例详细描述了所提出的网络。如图 1(a) 所示,正向生成器的输出是 t2 处的融合 HR MS 图像。这可以写成:

反向退化反馈部分考虑遥感成像的退化过程,从融合结果\(X_{f}\)中反向生成观测图像。

由于公式(1)中的\(f_{spatial}(·)\)和\(f_{heterogeneous}(·)\)比较清晰,而(1)中的\(f_{temporal}(·)\)很难准确建模。

如图 1(a) 所示,反向部分利用“resize”分支重新生成 t2 LR MS 图像,后向生成器隐含地实现 \(f_{temporal}(·)\) 和 \(f_{heterogeneous}(·)\)。

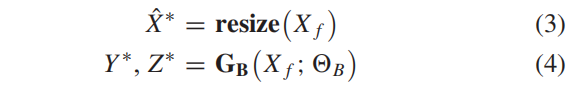

它们可以表示为:

其中 resize(·) 表示模糊和重采样操作。

请注意,在厚云覆盖的情况下,resize(·) 表示模糊和重采样以及添加云掩模的顺序操作.\(\hat{X}^{*}\) 是重新生成的 t2 LR MS 图像。GB(·)和\(\Theta _{B}\)分别表示后向生成器和相应的可训练参数。

\(Y^{∗}\) 和 \(Z^{∗}\) 表示再生的 t2 HR SAR 和 t1 HR MS 图像.

从正向生成器的输入到“调整大小”分支和反向生成器的输出形成一个循环。

后向鉴别器鉴别 \((Y, Z, \hat{X})\) 和 \((Y^{∗}, Z^{∗}, \hat{X}^{∗})\)。在图 1(b) 所示的网络测试中,相应的观测值被输入到每个融合类的训练前向生成器中,然后输出就是最终的融合结果。

loss function

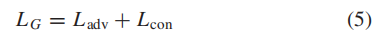

对于网络结构,所提出网络的损失函数也包括两部分:生成器网络的损失函数和鉴别器网络的损失函数。两个生成器一起训练一个损失函数,可以写成:

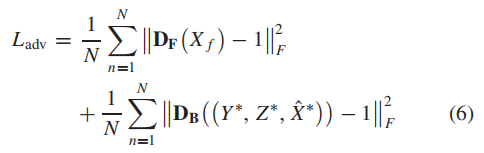

其中 LG 表示生成器的总损失,由两项组成:\(L_{adv}\) 和 \(L_{con}\)。 \(L_{adv}\) 是生成器和鉴别器之间的对抗性损失[42],定义为:

其中第一项是与前向鉴别器相关的对抗性损失,第二项是与后向鉴别器相关的对抗性损失.

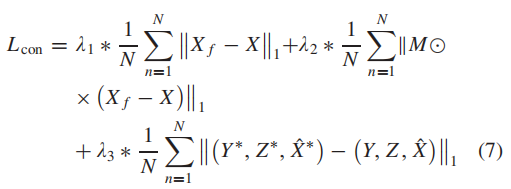

(5) 中的 \(L_{con}\) 是内容损失,以确保生成器的输出接近 ground truth。

其中第一项计算正向生成器输出与理想融合结果之间的全局损失。

第二项计算正向生成器输出与云覆盖区域理想融合结果之间的局部损失,其中 M 是二值化的云遮罩,1 代表云覆盖区域,0 代表无云区域。

\(\odot\)是点积运算符。

最后一项是正向生成器的输入与“resize”分支和反向生成器的输出之间的循环一致性损失。 λ1、λ2 和 λ3 是平衡这三项的可调参数。

由于平均绝对误差 (MAE) 损失 [43] 对异常值的敏感度低于 MSE 损失,因此根据经验将其用于内容损失.

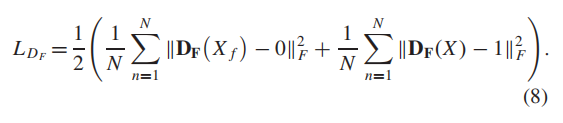

这两个鉴别器分别用它们自己的损失函数进行训练。前向鉴别器区分前向生成器输出和理想融合结果,即 t2 HR MS 图像。它判断 t2 HR MS 图像为真,标签为 1,正向生成器的输出为假,标签为 0。损失函数可以表示如下:

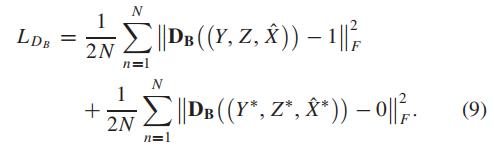

类似地,后向鉴别器区分前向生成器的输入以及“resize”分支和后向生成器的输出。它用标签 1 判断前者为真,用标签 0 判断后者为假。

损失函数可以表述如下:

在网络训练中,生成器和判别器的可训练参数根据相应的损失函数依次更新。考虑到 GAN 的敏感性,我们从 [44] 中学习并相应地设置超参数。前 75 个时期的学习率设置为 0.0002,在最后 75 个时期线性衰减到 0。此外,(7)中的可调权重设置为:λ1 = 50,λ2 = 100,λ3 = 50。利用 Adam 优化器 [45] 优化网络参数。

- Spatio-Temporal-Spectral Deep-Learning-Based Heterogeneous Integrated Learningspatio-temporal-spectral deep-learning-based deep-learning-based recommendation heterogeneous preference learning heterogeneous federated learning yourself spatio-temporal-spectral heterogeneous integrated integrated-repos integrated_network_security_in integrated-repos integrated repos