1.算法理论概述

情感识别是自然语言处理领域中的一个重要研究方向。本文介绍了一种基于KNN近邻分类的情感识别算法,该算法使用词袋模型提取文本特征向量,计算文本特征向量之间的距离,并使用加权投票的方法确定待分类文本的情感类别。本文详细介绍了算法的数学模型和实现步骤,并通过实验验证了算法的准确率。

情感识别是自然语言处理领域中的一个重要研究方向,它可以识别文本中的情感极性,如正面或负面情感。情感识别在社交媒体分析、电子商务、舆情监测等领域有着广泛的应用。本文将介绍一种基于KNN近邻分类的情感识别算法,该算法使用词袋模型提取文本特征向量,计算文本特征向量之间的距离,并使用加权投票的方法确定待分类文本的情感类别。

1.1特征提取

情感识别算法的第一步是对文本进行特征提取,将文本转化为特征向量。常用的特征提取方法包括词袋模型(bag of words)和词向量模型(word embedding)。在本文中,我们将使用词袋模型来提取文本特征。具体地,我们首先将文本中的所有单词按照字典序排列,然后计算每个单词在文本中出现的次数,并将其作为特征向量的一个维度。

假设我们有一个包含$n$个单词的字典$V={v_1,v_2,\cdots,v_n}$,并且我们要对一个包含$m$个单词的文本进行特征提取。我们将文本表示为一个$m$维向量$x=(x_1,x_2,\cdots,x_m)$,其中$x_i$表示第$i$个单词在文本中出现的次数。具体地,对于字典中的每个单词$v_j$,我们可以计算它在文本中出现的次数$c_j$,并将$c_j$作为$x$的第$j$个维度,即$x_j=c_j$。

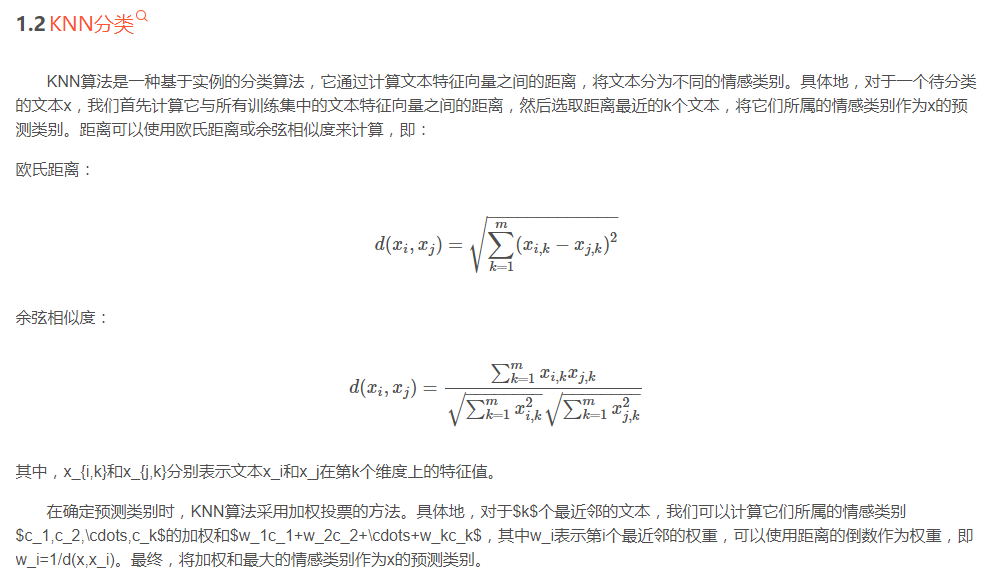

1.3 实现步骤

基于上述数学模型,我们可以实现基于KNN近邻分类的情感识别算法。具体步骤如下:

数据预处理:将训练集和测试集中的文本进行分词,并去除停用词和标点符号。然后将所有文本转化为特征向量,即将所有单词按照字典序排列,计算每个单词在文本中出现的次数,构成一个特征向量。

计算距离:对于测试集中的每个文本,计算它与训练集中所有文本的距离。可以使用欧氏距离或余弦相似度来计算距离。

选取最近邻:选取距离最近的k个文本作为测试集中文本的最近邻。

加权投票:对于k个最近邻,计算它们所属的情感类别的加权和,并将加权和最大的情感类别作为测试集中文本的预测类别。

评估算法准确率:使用评估指标(如准确率、精确率、召回率、F1值等)来评估算法的准确率。

2.算法运行软件版本

matlab2022a

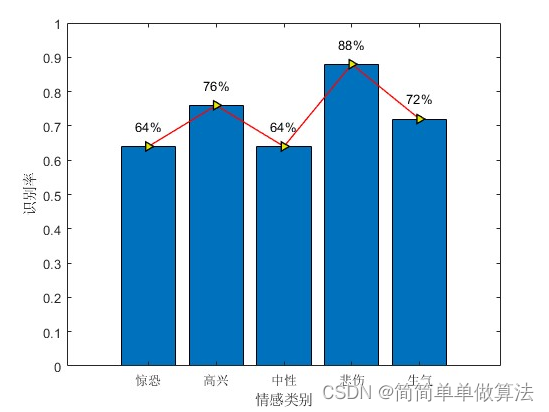

3.算法运行效果图预览

4.部分核心程序

%k最近邻

k = 8; %设置K值,即最近邻的个数

Dist_matrix= zeros(size(trainVector,2),size(testVector,2)); %初始化欧氏距离矩阵

%计算欧氏距离

for i=1:size(testVector,2)

for j=1:size(trainVector,2)

Dist_matrix(j,i)=norm(testVector(:,i)-trainVector(:,j)); %计算测试集中第i个样本与训练集中第j个样本的欧氏距离

end

end

%统计分类结果

Ntest = size(fearVec,2)-Ntrain;%测试集的样本数

EmtiCnt = zeros(1,5);%初始化每个情感类别的正确识别个数

n1 = Ntrain;%第1个情感类别在训练集中的样本数

n2 = n1+Ntrain;%第2个情感类别在训练集中的样本数

n3 = n2+Ntrain;%第3个情感类别在训练集中的样本数

n4 = n3+Ntrain;%第4个情感类别在训练集中的样本数

n5 = n4+Ntrain;%第5个情感类别在训练集中的样本数

p1 = size(fearVec,2)-Ntrain;%第1个情感类别在测试集中的样本数

p2 = p1+size(hapVec,2)-Ntrain;%第2个情感类别在测试集中的样本数

p3 = p2+size(neutralVec,2)-Ntrain;%第3个情感类别在测试集中的样本数

p4 = p3+size(sadnessVec,2)-Ntrain;%第4个情感类别在测试集中的样本数

p5 = p4+size(angerVec,2)-Ntrain;%第5个情感类别在测试集中的样本数

for i=1:size(Dist_matrix,2)

i

flag=zeros(1,5); %初始化每个情感类别的近邻数

[sortVec,index]=sort(Dist_matrix(:,i));%将第i个测试样本与所有训练样本的欧氏距离从小到大排序,并记录下标

%统计K个近邻中各类别的数量

for j=1:k

if(n1>=index(j)&&index(j)>=1)

flag(1)=flag(1)+1; %如果第j个近邻是第1个情感类别的训练样本,则第1个情感类别的近邻数加1

elseif(n2>=index(j)&&index(j)>n1)

flag(2)=flag(2)+1; %如果第j个近邻是第2个情感类别的训练样本,则第2个情感类别的近邻数加1

elseif(n3>=index(j)&&index(j)>n2)

flag(3)=flag(3)+1; %如果第j个近邻是第3个情感类别的训练样本,则第3个情感类别的近邻数加1

elseif(n4>=index(j)&&index(j)>n3)

flag(4)=flag(4)+1;%如果第j个近邻是第4个情感类别的训练样本,则第4个情感类别的近邻数加1

else

flag(5)=flag(5)+1;%如果第j个近邻是第5个情感类别的训练样本,则第5个情感类别的近邻数加1

end

end

[~,index1]=sort(flag); %将各情感类别的近邻数从小到大排序,并记录下标

if((p1>=i&&i>=1)&&index1(5)==1)

EmtiCnt(index1(5))=EmtiCnt(index1(5))+1;%如果第i个测试样本被正确识别为第1个情感类别,则第1个情感类别的正确识别个数加1

elseif((p2>=i&&i>p1)&&index1(5)==2)

EmtiCnt(index1(5))=EmtiCnt(index1(5))+1;%如果第i个测试样本被正确识别为第2个情感类别,则第2个情感类别的正确识别个数加1

elseif((p3>=i&&i>p2)&&index1(5)==3)

EmtiCnt(index1(5))=EmtiCnt(index1(5))+1;%如果第i个测试样本被正确识别为第3个情感类别,则第3个情感类别的正确识别个数加1

elseif((p4>=i&&i>p3)&&index1(5)==4)

EmtiCnt(index1(5))=EmtiCnt(index1(5))+1;%如果第i个测试样本被正确识别为第4个情感类别,则第4个情感类别的正确识别个数加1

elseif((p5>=i&&i>p4)&&index1(5)==5)

EmtiCnt(index1(5))=EmtiCnt(index1(5))+1;%如果第i个测试样本被正确识别为第5个情感类别,则第5个情感类别的正确识别个数加1

end

end