Flink实时处理入门

1、Flink框架介绍

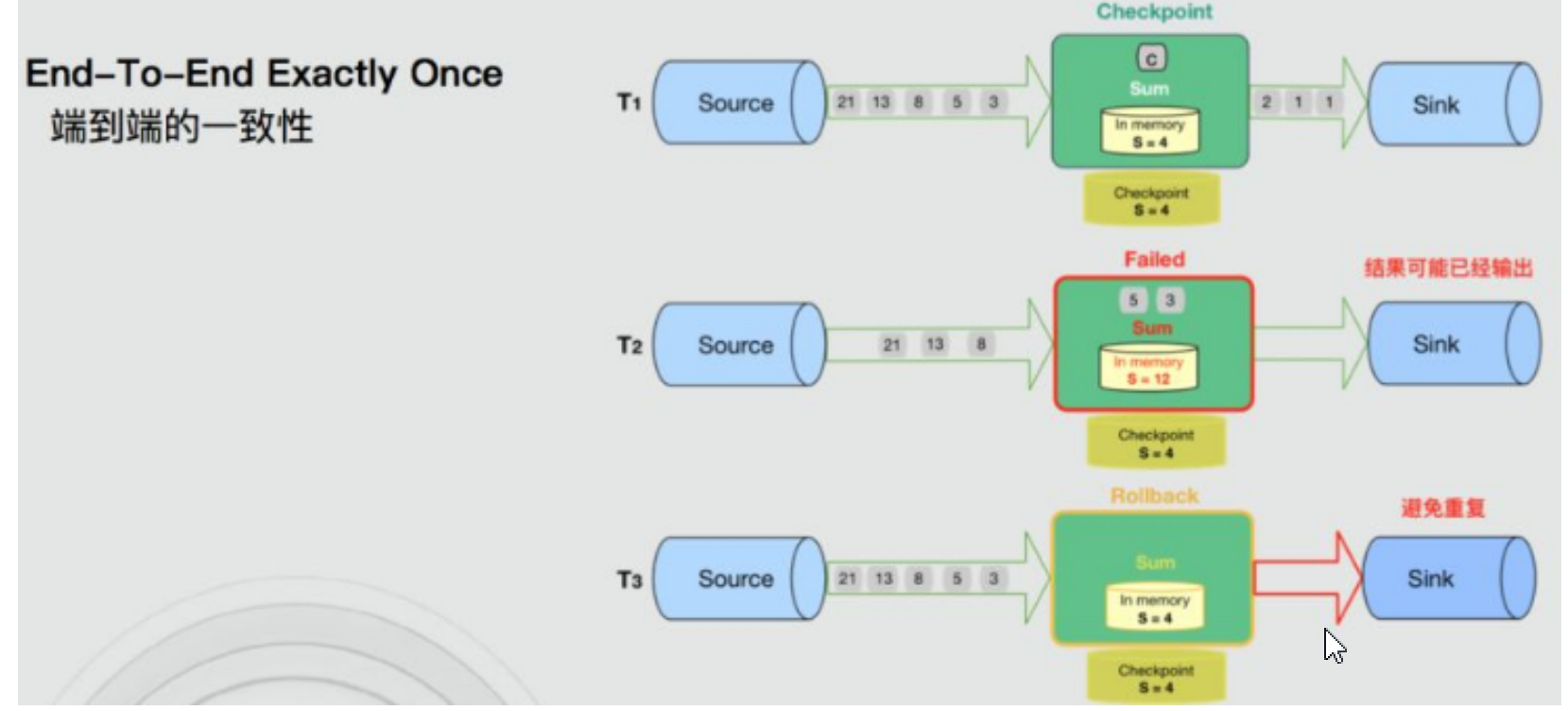

Flink 诞生于欧洲的一个大数据研究项目 StratoSphere。它是由 3 所地处柏林的大学和欧洲其他一 些大学在 2010~2014 年共同进行的研究项目,由柏林理工大学的教授沃克尔·马尔科(Volker Markl)领衔开发。2019年1月阿里巴巴收购Flink项目,开源于apache孵化。

Flink 的官网主页地址:https://flink.apache.org/

Flink 的中文主页地址:https://flink.apache.org/zh/

Flink 的中文社区地址:https://flink-learning.org.cn/activity

阿里云Flink技术地址:https://help.aliyun.com/product/45029.html

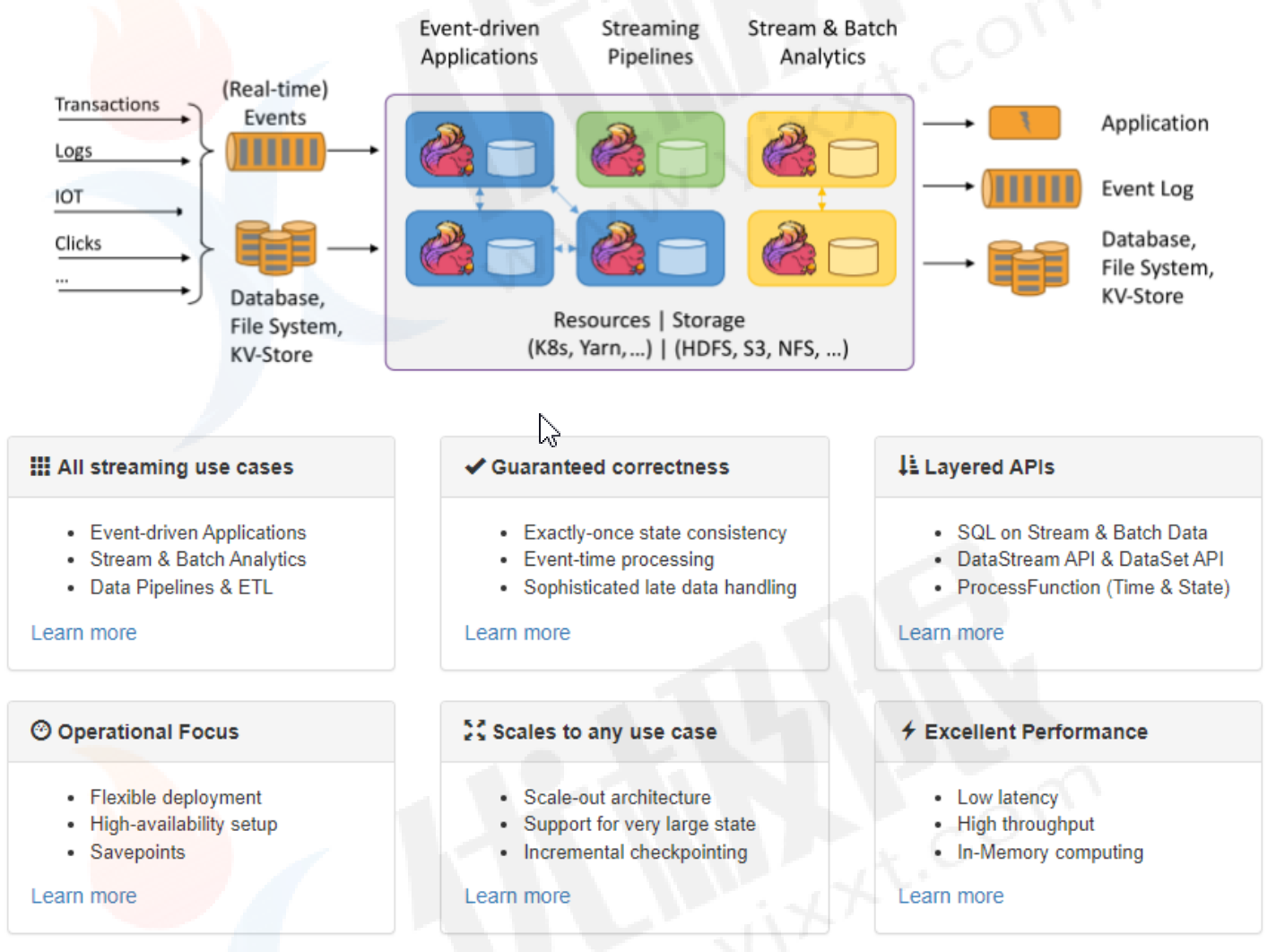

框架优势:所有流式场景、正确性保证、分层API、聚集运维、大规模运算、性能卓越

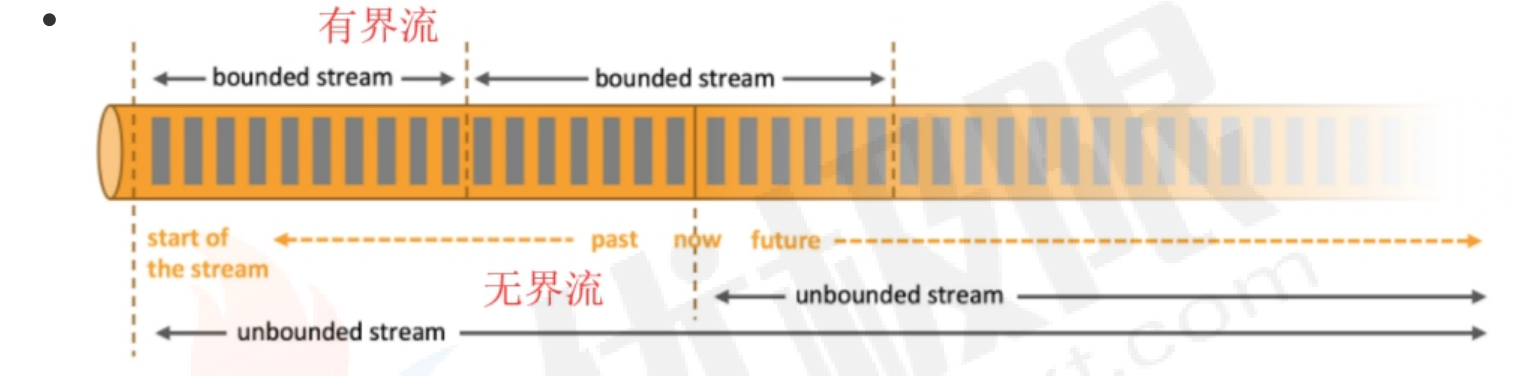

1.1、无界和有界数据

任何类型的数据都可以形成一种事件流。

数据可以分为有界流和无界流:

- 无界流:有定义流的开始,没有定义流的结束,无休止产生数据流。数据被摄取后立即处理,处理无界流要以特定顺序摄取事件。

- 有界流:有定义流的开始,也有定义流的结束。有界流可以在摄取所有数据后计算,有界流所有数据可以被排序,不需要有序摄取,有界流处理称为批处理。

flink擅长处于有界流和无界流的数据集。

2、Flink编程模型

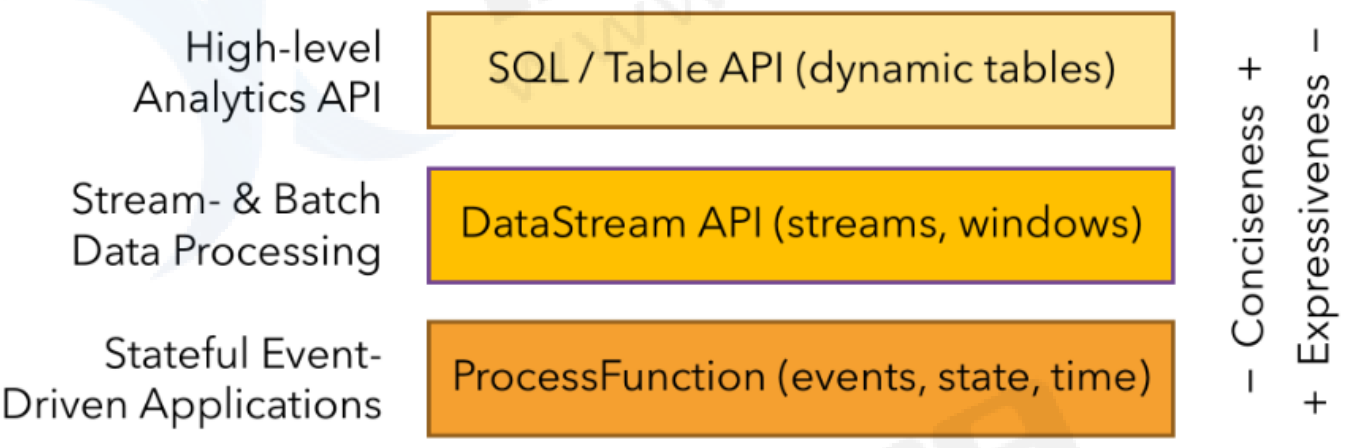

2.1、分层API

ProcessFunction:Flink最底层的APi,可以操作窗口内多个数据源和数据流,对时间和状态的细粒度控制,但是开发比较复杂,灵活性高!

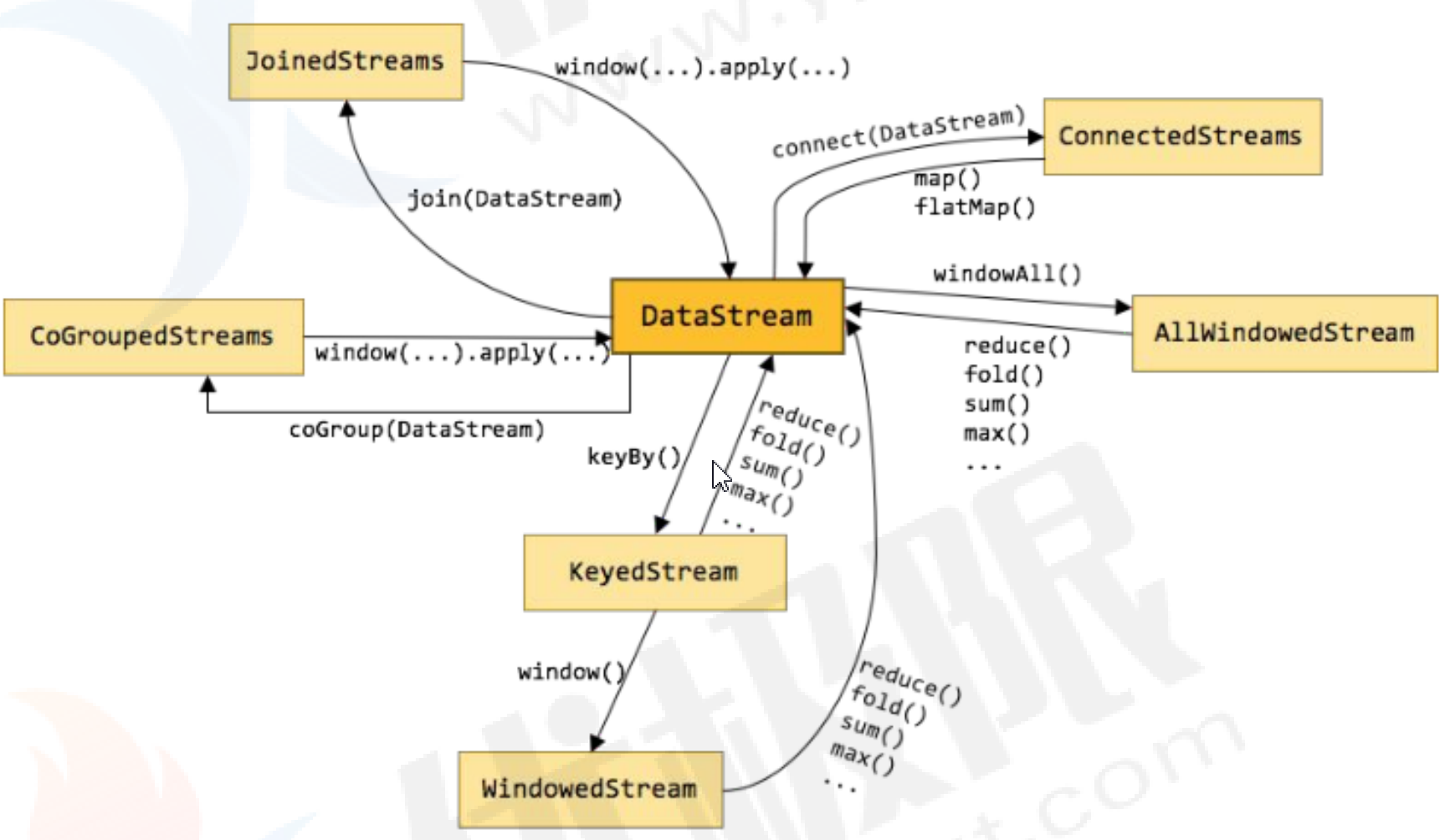

DataStream API在processFunction基础上多一些算子,支持java和scala语言,预定了map()等函数;还细分为DataSet API和DataStream,其中DataSetApi是处理批数据,DataStream处理流数据。

SQL&Table API最顶层API,就是写SQL语句处理数据,适合通用性数据的解决方案,SQL构建在Table表之上的,需要构建Table环境。

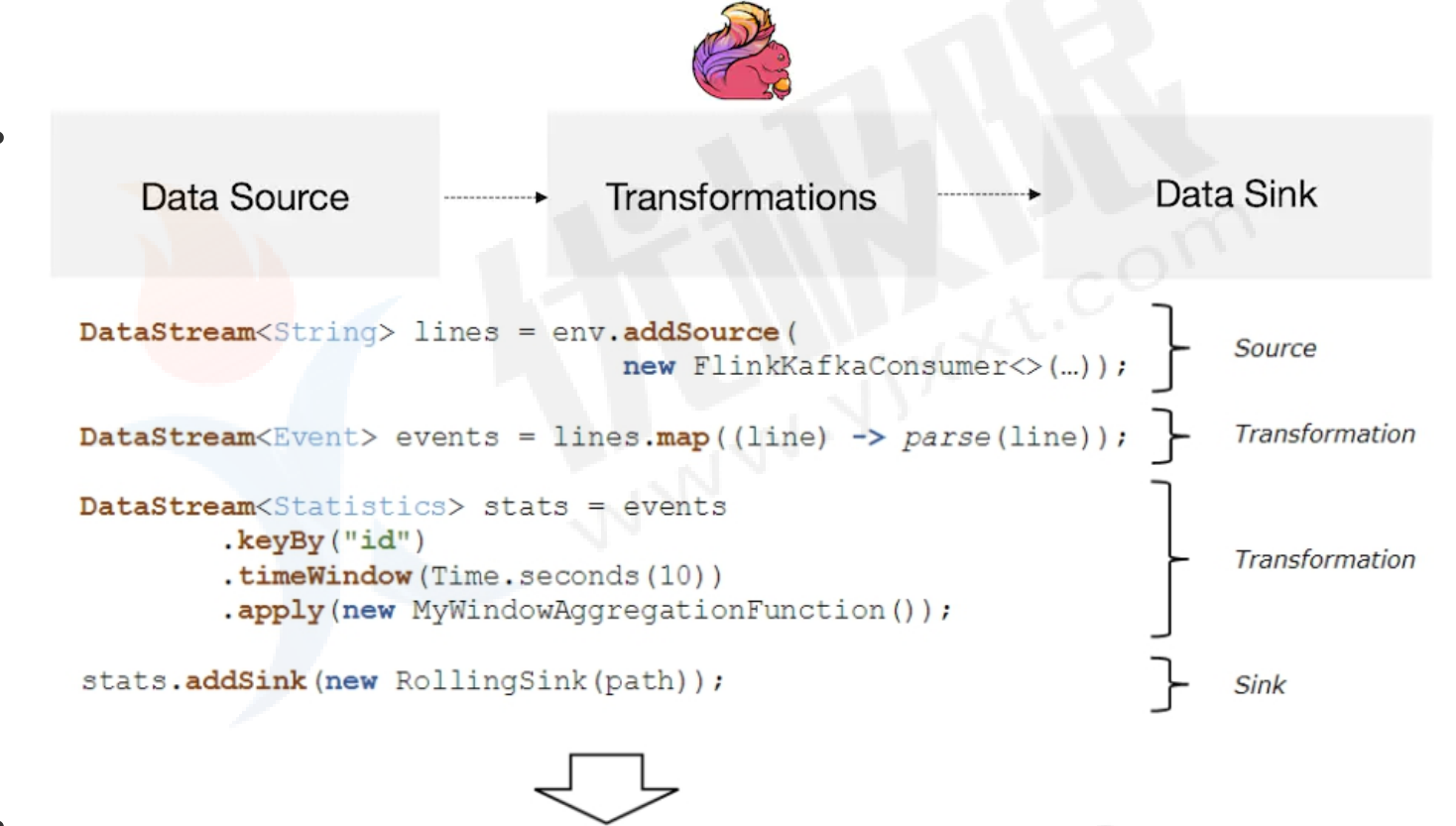

2.2、编程模型

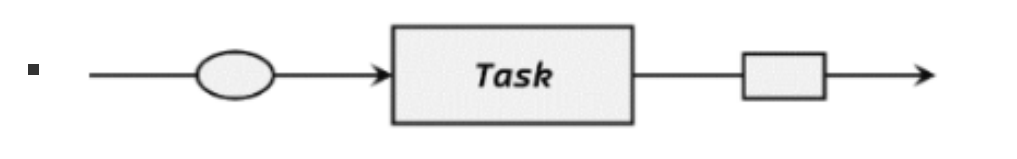

每个flink程序由source operator + transformation operator + sink operator组成

2.3、环境搭建

前置条件:必须JDK11、scala-2.12.x

- 导入依赖

<properties>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

<maven.compiler.source>11</maven.compiler.source>

<maven.compiler.target>11</maven.compiler.target>

<flink.version>1.15.2</flink.version>

<scala.version>2.12.2</scala.version>

<log4j.version>2.12.1</log4j.version>

</properties>

<dependencies>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-java</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-java</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-scala_2.12</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-scala_2.12</artifactId>

<version>${flink.version}</version>

</dependency>

<!--flink客户端-->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-clients</artifactId>

<version>${flink.version}</version>

</dependency>

<!--本地运行的webUI-->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-runtime-web</artifactId>

<version>${flink.version}</version>

</dependency>

<!--flink与kafka整合-->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-kafka</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-base</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-jdbc</artifactId>

<version>${flink.version}</version>

</dependency>

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

<version>8.0.16</version>

</dependency>

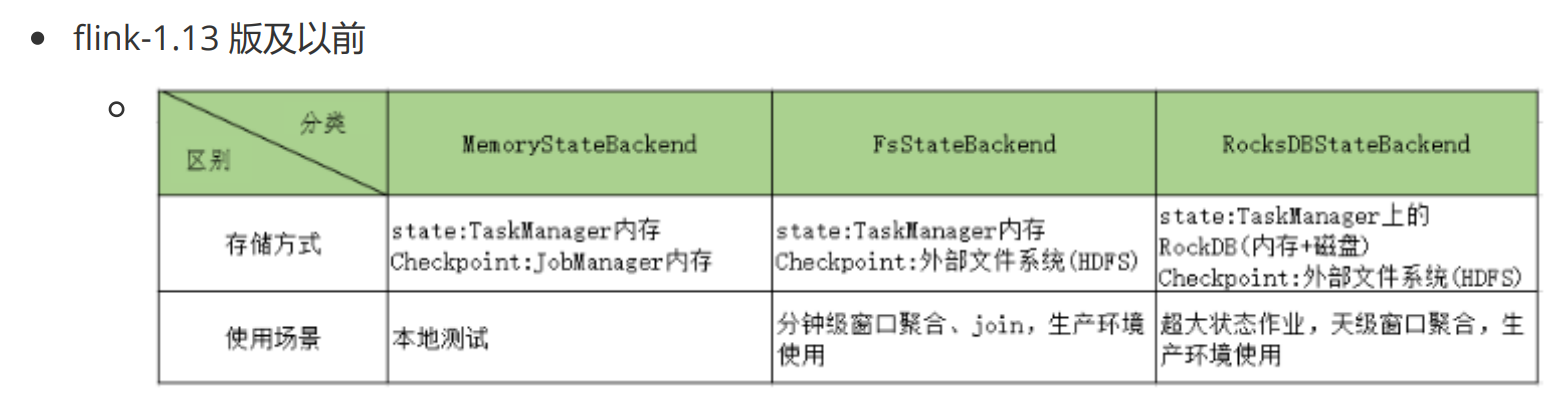

<!--状态后端-->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-statebackend-rocksdb</artifactId>

<version>${flink.version}</version>

</dependency>

<!--日志系统-->

<dependency>

<groupId>org.apache.logging.log4j</groupId>

<artifactId>log4j-slf4j-impl</artifactId>

<version>${log4j.version}</version>

</dependency>

<dependency>

<groupId>org.apache.logging.log4j</groupId>

<artifactId>log4j-api</artifactId>

<version>${log4j.version}</version>

</dependency>

<dependency>

<groupId>org.apache.logging.log4j</groupId>

<artifactId>log4j-core</artifactId>

<version>${log4j.version}</version>

</dependency>

</dependencies>

为了使用 Scala API,将 flink-java 的 artifact id 替换为 flink-scala_2.12 ,同时 将 flink-streaming-java 替换为 flink-streaming-scala_2.12

- 配置log4j2.properties

rootLogger.level = WARN

rootLogger.appenderRef.console.ref = ConsoleAppender

appender.console.name = ConsoleAppender

appender.console.type = CONSOLE

appender.console.layout.type = PatternLayout

appender.console.layout.pattern = %d{HH:mm:ss,SSS} %-5p %-60c %x - %m%n

- 模拟目标数据(存在项目根目录路径下)

hello01 yjxxt01

hello02 yjxxt02

hello03 yjxxt03

hello04 yjxxt04

hello05 yjxxt05

hello06 yjxxt06

hello07 yjxxt07

hello08 yjxxt08

hello01 yjxxt01

hello02 yjxxt02

hello03 yjxxt03

hello04 yjxxt04

hello05 yjxxt05

hello06 yjxxt06

hello07 yjxxt07

hello08 yjxxt08

- 批处理java版本WordCount代码

package com.zwf.flinkdemo;

import org.apache.flink.api.common.functions.FlatMapFunction;

import org.apache.flink.api.common.functions.MapFunction;

import org.apache.flink.api.java.ExecutionEnvironment;

import org.apache.flink.api.java.operators.AggregateOperator;

import org.apache.flink.api.java.operators.DataSource;

import org.apache.flink.api.java.operators.FlatMapOperator;

import org.apache.flink.api.java.operators.MapOperator;

import org.apache.flink.api.java.tuple.Tuple2;

import org.apache.flink.util.Collector;

import java.util.Arrays;

/**

* @author MrZeng

* @version 1.0

* @date 2023-12-28 20:27

*/

public class Hello01WordCountByDataSetUseJava {

public static void main(String[] args) {

//创建flink环境

ExecutionEnvironment environment = ExecutionEnvironment.getExecutionEnvironment();

//获取数据源

DataSource<String> source = environment.readTextFile("data/data.txt");

//开始转换

FlatMapOperator<String, String> map = source.flatMap(new FlatMapFunction<String, String>() {

@Override

public void flatMap(String line, Collector<String> collector) throws Exception {

Arrays.stream(line.split("\\s+")).forEach(word -> collector.collect(word));

}

});

//开始计数

MapOperator<String, Tuple2<String, Integer>> map1 = map.map(new MapFunction<String, Tuple2<String, Integer>>() {

@Override

public Tuple2<String, Integer> map(String s) throws Exception {

return Tuple2.of(s, 1);

}

});

//开始分类并统计

AggregateOperator<Tuple2<String, Integer>> sum = map1.groupBy(0).sum(1);

try {

sum.print();

} catch (Exception e) {

throw new RuntimeException(e);

}

}

}

- 批处理scala版WordCount代码

package com.zwf.flinkscala

import org.apache.flink.api.scala.{DataSet, ExecutionEnvironment, createTypeInformation}

/**

* @author MrZeng

* @date 2023-12-28 20:29

* @version 1.0

*/

object WordCountByDataSetUseScala {

def main(args: Array[String]): Unit = {

//flink批处理 wordcount

//加载flink环境

val environment: ExecutionEnvironment = ExecutionEnvironment.getExecutionEnvironment

//读取文件数据

val ds: DataSet[String] = environment.readTextFile("data/data.txt")

//缺少createTypeInformation包

ds.flatMap(_.split("\\s+")).map((_,1)).groupBy(0).reduce((x,y)=>x._1->(x._2+y._2)).print()

}

}

2.4、数据流处理

先下载netcat工具:https://eternallybored.org/misc/netcat/

解压缩后把nc.exe和nc64.exe包存放C:\Windows\System32

注意:为了防止程序报毒,先关闭杀毒软件!

- 运行nc工具 在cmd窗口下

nc -lp [端口号]

- 在linux下运行

yum install -y nc

nc -l -k -p [端口]

- java代码

package com.zwf.flinkdemo;

import org.apache.flink.api.common.functions.FlatMapFunction;

import org.apache.flink.api.common.functions.MapFunction;

import org.apache.flink.api.java.functions.KeySelector;

import org.apache.flink.api.java.tuple.Tuple2;

import org.apache.flink.streaming.api.datastream.DataStreamSource;

import org.apache.flink.streaming.api.datastream.KeyedStream;

import org.apache.flink.streaming.api.datastream.SingleOutputStreamOperator;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.util.Collector;

/**

* @author MrZeng

* @version 1.0

* @date 2023-12-28 22:11

*/

public class StreamingToWordCount {

public static void main(String[] args) throws Exception {

//获取流处理的环境

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

DataStreamSource<String> stream = environment.socketTextStream("localhost", 9999);

//进行mapTask操作

SingleOutputStreamOperator<String> flatMap = stream.flatMap(new FlatMapFunction<String, String>() {

@Override

public void flatMap(String line, Collector<String> collector) throws Exception {

//先进行按空格切分

String[] words = line.split("\\s+");

//把所有的word收集

for (String w : words) {

collector.collect(w);

}

}

});

//mapTask处理

SingleOutputStreamOperator<Tuple2<String, Integer>> map = flatMap.map(new MapFunction<String, Tuple2<String, Integer>>() {

@Override

public Tuple2<String, Integer> map(String w) throws Exception {

return Tuple2.of(w, 1);

}

});

//根据key进行处理

KeyedStream<Tuple2<String, Integer>, String> keyBy = map.keyBy(new KeySelector<Tuple2<String, Integer>, String>() {

@Override

public String getKey(Tuple2<String, Integer> stringIntegerTuple2) throws Exception {

return stringIntegerTuple2.f0;

}

});

//计算下标为1

SingleOutputStreamOperator<Tuple2<String, Integer>> sum = keyBy.sum(1);

//打印值

sum.print();

//执行wordcount程序

environment.execute();

}

}

- scala代码

package com.zwf.flinkscala

import org.apache.flink.streaming.api.scala._

/**

* @author MrZeng

* @date 2023-12-29 8:31

* @version 1.0

*/

object StreamingWordCount {

def main(args: Array[String]): Unit = {

//创建environment环境

val environment: StreamExecutionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment

//创建网络socket连接

val DStream: DataStream[String] = environment.socketTextStream("localhost", 8888)

DStream.flatMap(_.split("\\s+")).map((_,1)).keyBy(_._1).sum(1).print()

environment.execute()

}

}

注意:运行时要先使用nc工具监听端口,再启动程序!否则会报错!

在编写scala代码时,注意导入隐式转换包:import org.apache.flink.streaming.api.scala._

- java简化版代码

package com.zwf.flinkdemo;

import org.apache.flink.api.common.typeinfo.TypeInformation;

import org.apache.flink.api.common.typeinfo.Types;

import org.apache.flink.api.java.tuple.Tuple2;

import org.apache.flink.streaming.api.datastream.DataStreamSource;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

/**

* @author MrZeng

* @version 1.0

* @date 2023-12-29 10:40

*/

public class SimpleFlinkJava {

public static void main(String[] args) throws Exception {

//创建flink环境

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

//建立socket连接

DataStreamSource<String> DStream = environment.socketTextStream("localhost", 7777);

//处理流 第一种方式使用参数

DStream.flatMap((v,out)->{

String[] split = v.split("\\s+");

for (String s:split){

out.collect(s);

}

}, Types.STRING)

.map(v-> Tuple2.of(v,1),Types.TUPLE(TypeInformation.of(String.class),TypeInformation.of(Integer.class)))

.keyBy((x)->x.f0).sum(1).print();

//第二种方法 使用returns

DStream.<String>flatMap((v,out)->{

String[] split = v.split("\\s+");

for (String s:split){

out.collect(s);

}

}).returns(String.class)

.map(v-> Tuple2.of(v,1)).returns(Types.TUPLE(Types.STRING,Types.INT))

.keyBy((x)->x.f0).sum(1).print();

environment.execute();

}

}

- scala简化版代码

package com.zwf.flinkscala

import org.apache.flink.streaming.api.scala._

/**

* @author MrZeng

* @date 2023-12-29 11:08

* @version 1.0

*/

object SimpleFlinkScala {

def main(args: Array[String]): Unit = {

//创建环境

val environment: StreamExecutionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment

//建立socket编程

val dataStream: DataStream[String] = environment.socketTextStream("localhost", 6666)

//处理流数据

dataStream.flatMap(_.split("\\s+")).map(_->1).keyBy(_._1).sum(1).print()

//执行流

environment.execute();

}

}

2.5、TypeInformation

由于java代码的特点,存在类型擦除,也就是泛型中有泛型会造成类型匹配失败,就需要指定数据类型,防止找不到类型。

flink使用了TypeInformation的概念来表达数据类型,针对不同数据类型产生特定序列化器、反序列化器和比较操作符。也能通过分析输入和输出数据来自动获取数据的类型信息以及序列化器和反序列化器,在一些特定环境下我们需要明确数据类型来提高程序的性能。

- 数据类型

flink支持java和scala所有原始数据类型。最常用的数据类型有以下:

- Primitives(原始数据类型)

- java和scala的元组,java元组从0开始计数位置,scala元组从1开始计数位置。Flink实现java Tuple可以有25个元素,根据元素数量不同,实现了Tuple1、Tuple2....一直到Tuple25,也可以通过public属性访问f0、f1、f2等,或者使用getFields()访问,下标从0开始。

- scala样例类和java的pojo类。

- 返回数据类型

使用scala时无需指定!

- 需要使用 SingleOutputStreamOperator 的 returns 方法来指定算子的返回数据类型。

//第二种方法 使用returns

DStream.<String>flatMap((v,out)->{

String[] split = v.split("\\s+");

for (String s:split){

out.collect(s);

}

}).returns(String.class)

.map(v-> Tuple2.of(v,1)).returns(Types.TUPLE(Types.STRING,Types.INT))

.keyBy((x)->x.f0).sum(1).print();

environment.execute();

使用TypeInformation指定返回的数据类型,也是flink类型系统的核心,是生产序列化和反序列化工具和Comparator工具类。同时它还连接schema和编程语言内部系统的桥梁。

DStream.flatMap((v,out)->{

String[] split = v.split("\\s+");

for (String s:split){

out.collect(s);

}

}, Types.STRING)

.map(v-> Tuple2.of(v,1),Types.TUPLE(TypeInformation.of(String.class),TypeInformation.of(Integer.class)))

.keyBy((x)->x.f0).sum(1).print();

为了支持泛型,Flink引入了TypeHit类

// 要使用TypeHint来指定。

Types.TUPLE(new TypeHint<Tuple2<String,Integer>>(){}.getTypeInfo());

Types对象既可以使用TypeHit指定又可以使用Types指定,序列化和反序列化以及比较器已经定义好了。

Types.POJO(String.class);

Types.TUPLE(Types.STRING,Types.INT);

Types.TUPLE(new TypeHint<Tuple2<String,Integer>>(){}.getTypeInfo());

2.6、基本概念介绍

- Stream执行环境

每个Flink作业都要执行环境,流式应用就需要用到StreamExecutionEnvironment。

DS API为你的作业构建一个job graph,附加到 StreamExecutionEnvironment。

调用environment.execute()时此graph打包发送到jobManager上。jobManager对作业并行处理并将其子任务分发给Task Manager来执行。

每个作业的多个并行子任务将在task slot中,如果没有调用execute()方法,应用不会执行。

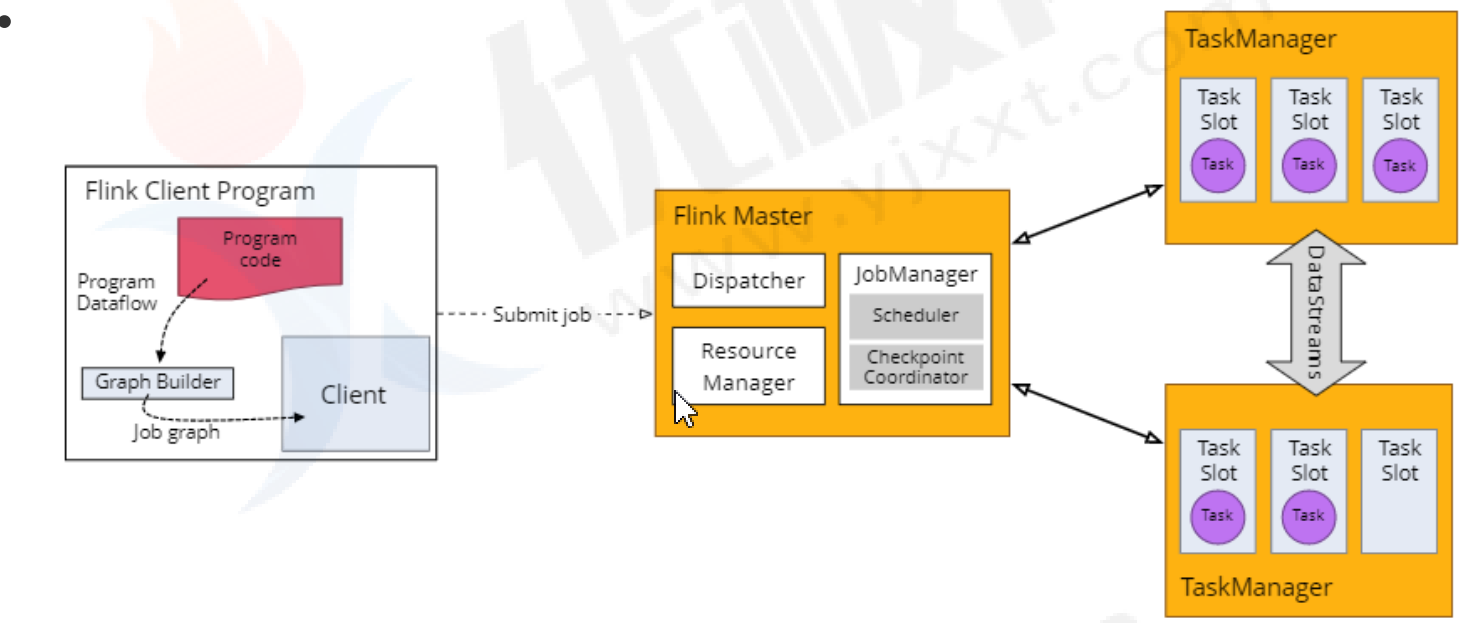

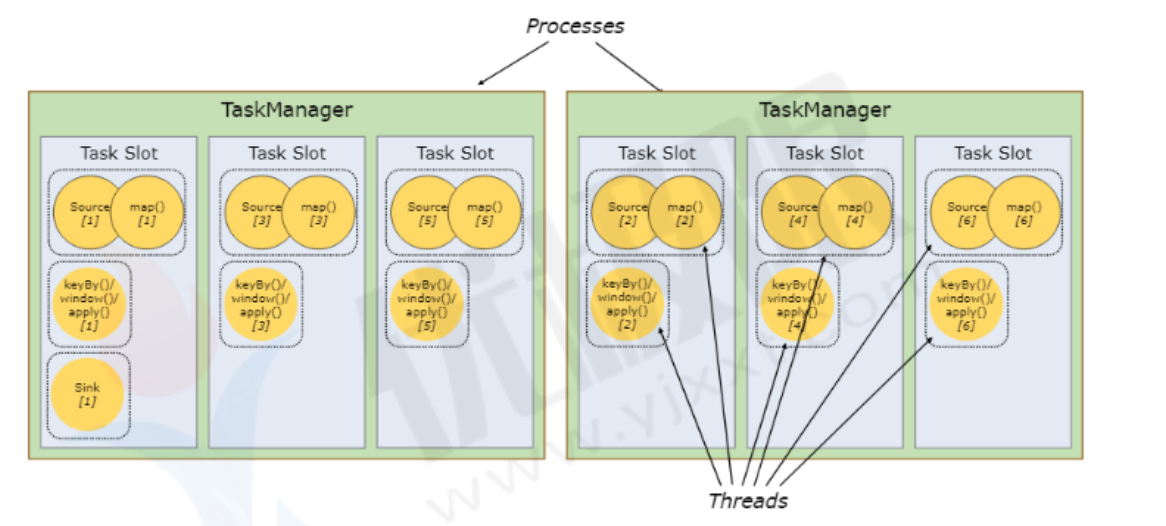

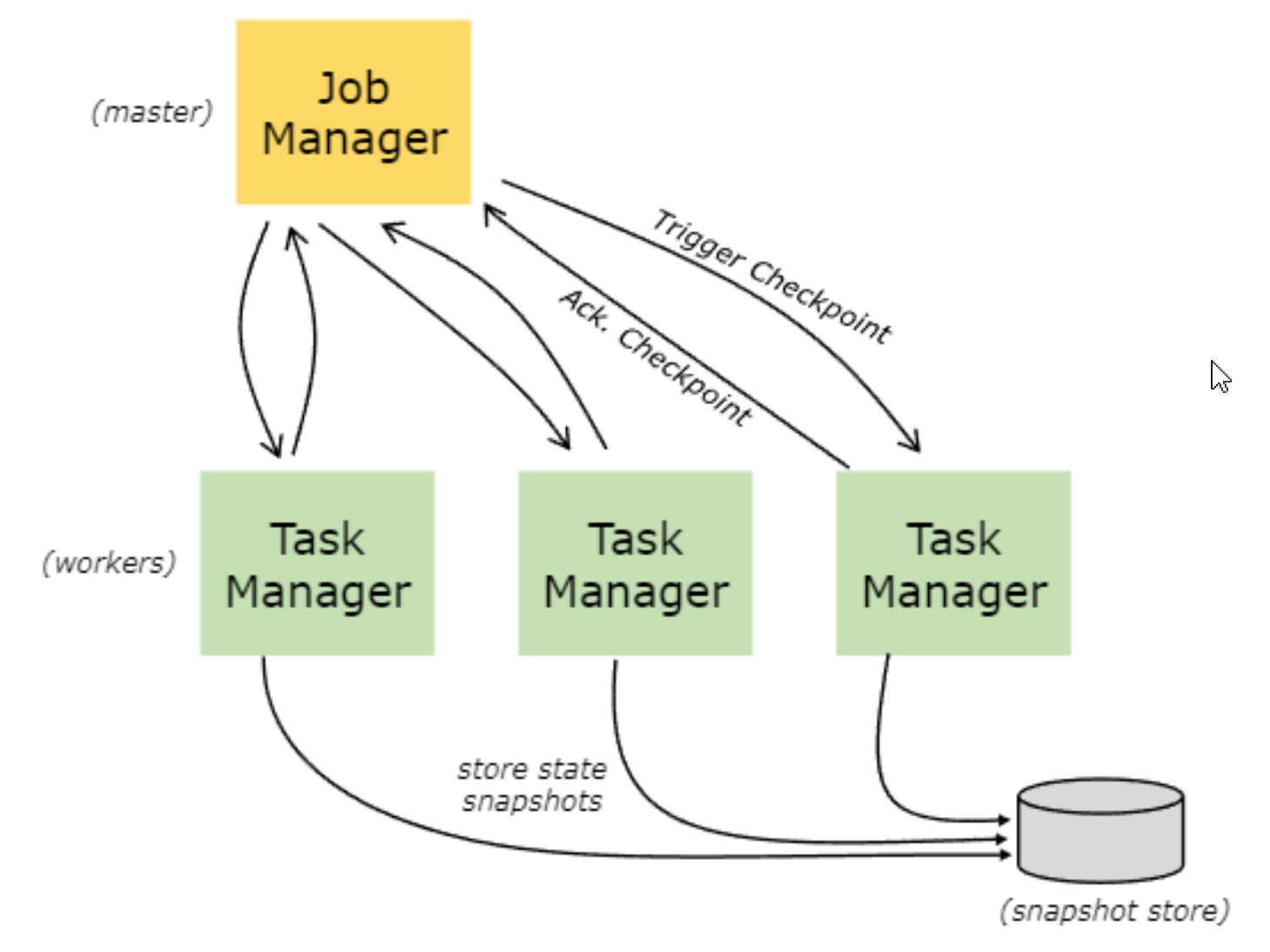

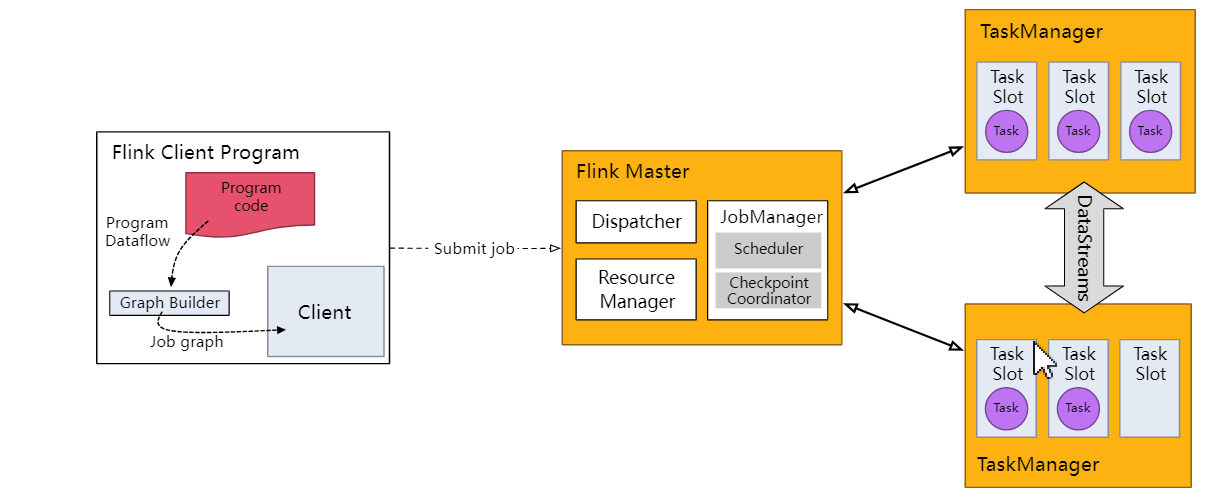

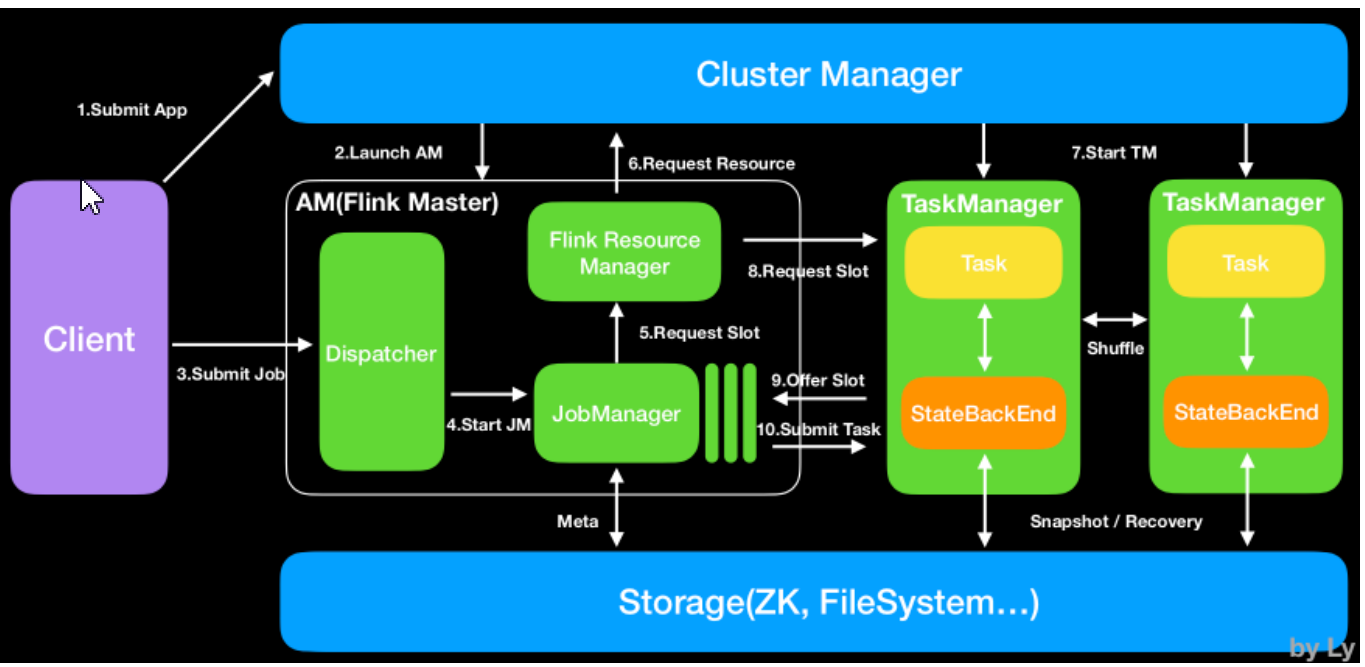

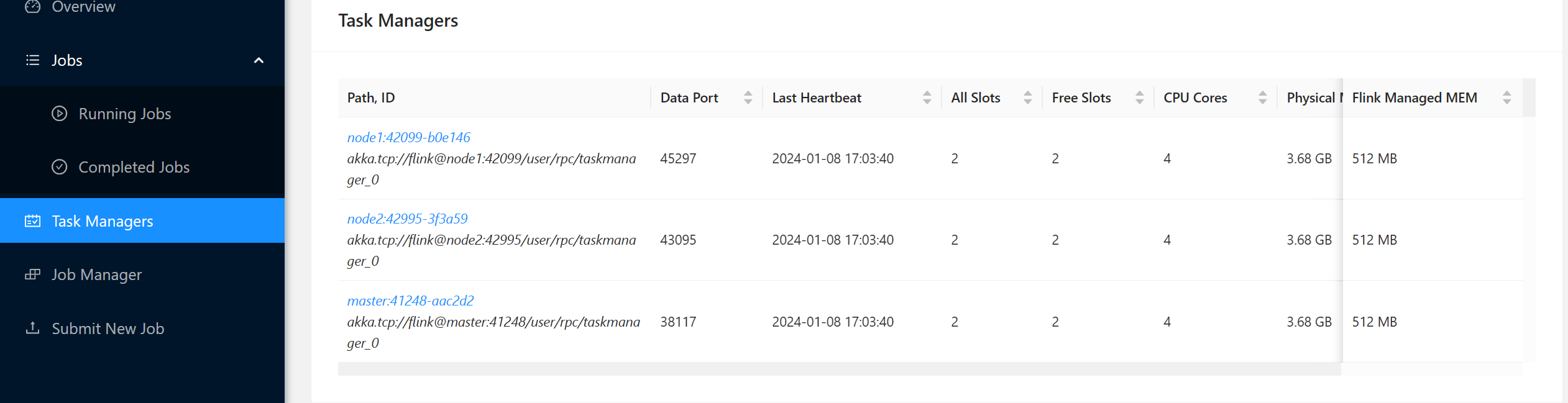

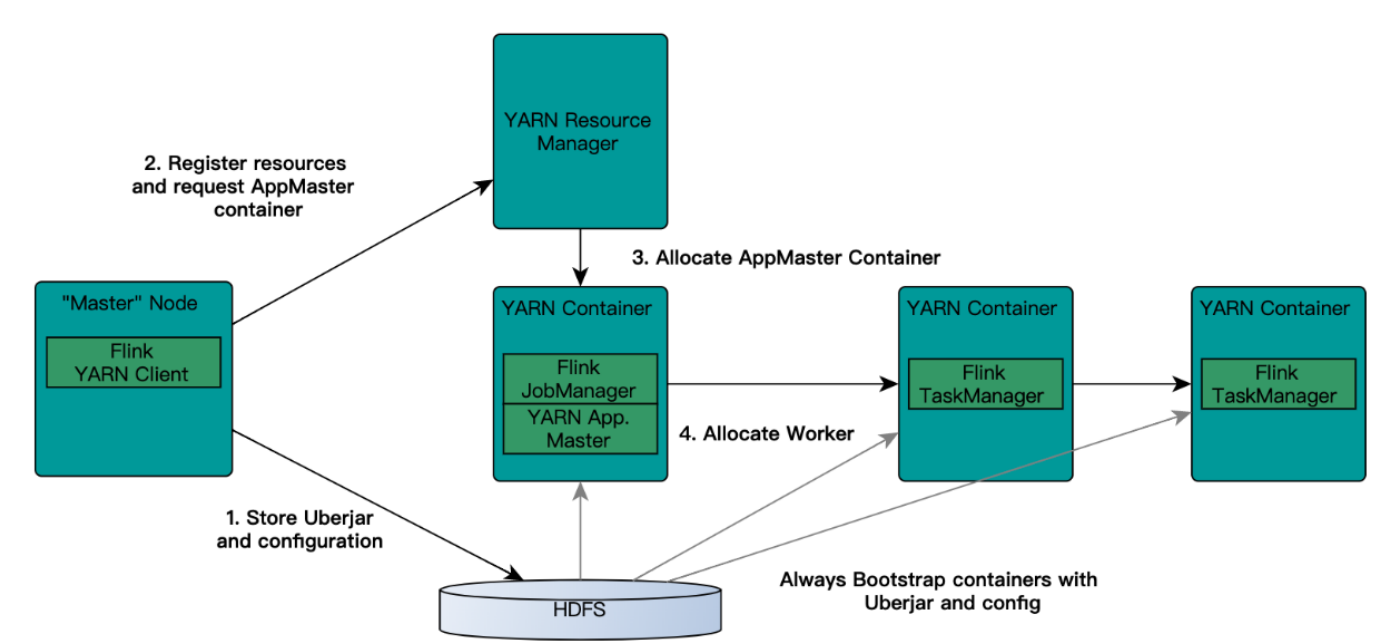

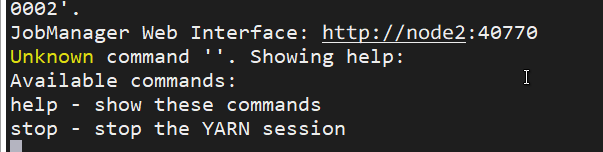

- Flink运行环境由JobManagers和TaskManagers两个进程组成:

JobManagers:有时也叫Masters,主要协调分布式运行。他们调度任务,协调checkpoint,协调失败任务的恢复。一个Flink集群至少有一台JobManager节点,多台情况下就是一个leader和standby。

TaskManagers:有时也叫Workers,TaskManager主要执行dataflow中的任务tasks,缓存数据以及进行数据流的交换;TaskManager在jvm中以多线程执行任务;TaskManger提供了一定数量的插槽,控制执行任务数;每一个集群至少有一个TaskManger;一个TaskManager可以同时执行多个任务(同一个算子子任务、不同算子、不同应用程序)。

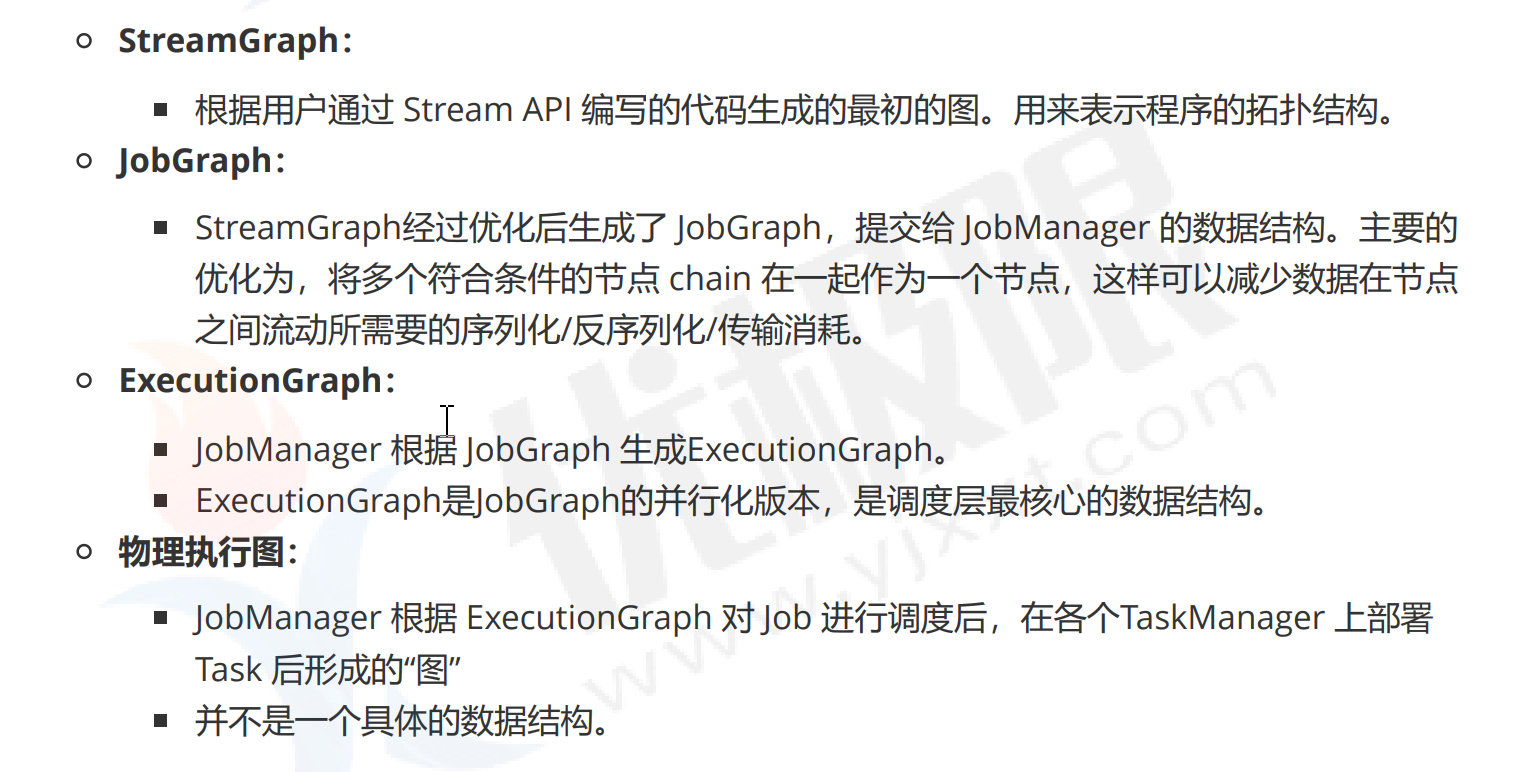

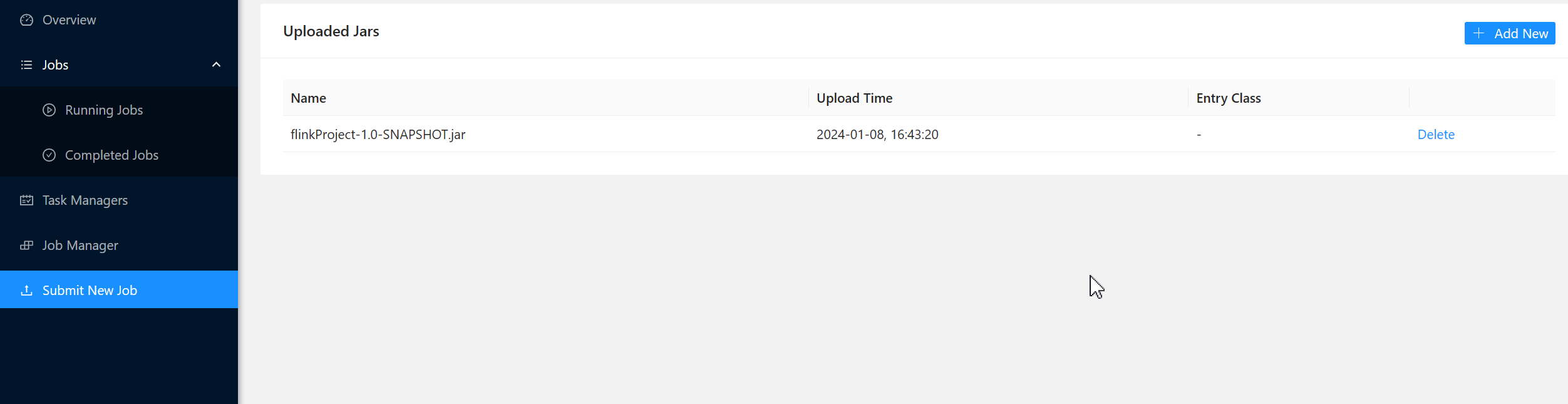

- Flink任务执行计划

Flink 中的执行图可以分成四层:StreamGraph -> JobGraph -> ExecutionGraph -> 物理执行图。

2.7、任务并行度

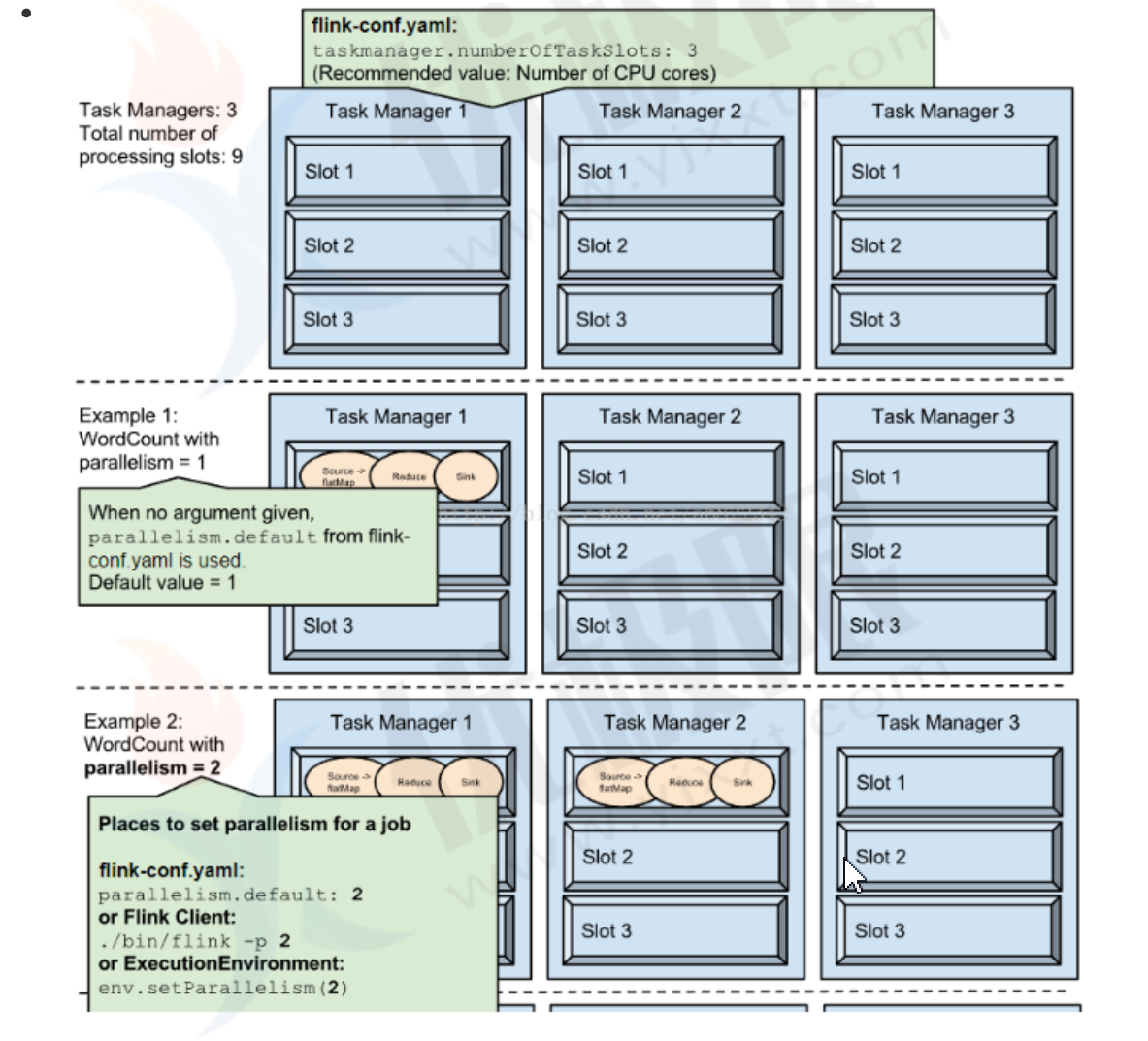

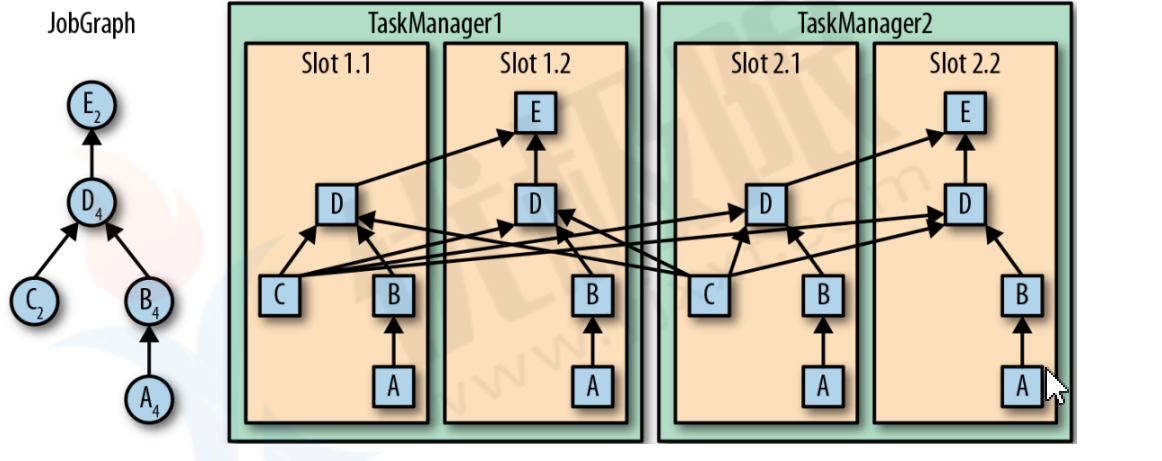

任务在TaskManager上执行占用Task slot个数决定程序的并行度;一个程序中,不同的算子可能具有不同的并行度。

为了提高任务执行效率,同一个数据源执行任务可以在不同的slot中运行。

将tasks调度到slots上,可以让多个 tasks跑在同一个TaskManager内,也就可以是的tasks之间的数据交换更高效。

图中AC是数据源,C数据源可以再slot1.1和slot2.1并行运算,E输出数据源在slot1.2和slot2.2并行运算!

- 并行度设置

任务并行度设置分为4个等级:

- 配置文件:通过设置 ${flink_home}/conf/flink-conf.yaml 配置文件中的 parallelism.default`配置 项来定义默认并行度。

- 执行环境级别:在作业代码中设置并行度

- 算子级别:设置特定算子调用setParallelism()方法来定义单个运算符,数据源或数据接收器的并行度。

- 代码实现

public static void main(String[] args) {

//flink执行计划

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

//设置执行并行度为2 在转换过程中 每个算子2个并行度运算 只有数据源有1个并行度

//这里设置的并行度是指这个作业并行度是2

//有三种设置并行度方式:1、作业范围的并行度设置 2、配置文件设置并行度,集群生效 3、指定算子设置并行度

environment.setParallelism(2);

DataStreamSource<String> stream = environment.socketTextStream("localhost", 8888);

stream.flatMap((x,coll)->{

String[] split = x.split("\\s+");

for (String s:split){

coll.collect(s);

}

//指定特定算子并行度

},Types.STRING).setParallelism(1).map((x)-> Tuple2.of(x,1), Types.TUPLE(Types.STRING,Types.INT)).keyBy((tup)->tup.f0).sum(1).print();

//默认转换过程中的所有算子都是8个并行度 数据源1个并行度

String plan = environment.getExecutionPlan();

System.out.println(plan);

}

2.8、Flink操作链

操作链是flink默认开启机制,是为了减少数据shuffle阶段IO传输,提升计算性能,减少了线程间切换和缓冲,降低时延。

条件:上下游算子实例间一对一数据传输,类似于spark中的窄依赖;上下游算子并行度相同;上下游属于槽位共享组;

链条可以在程序中关闭!默认是开启的!

// 当前环境关闭操作链..

environment.disableOperatorChaining();

//单个算子关闭操作链

Stream.disableChaining();

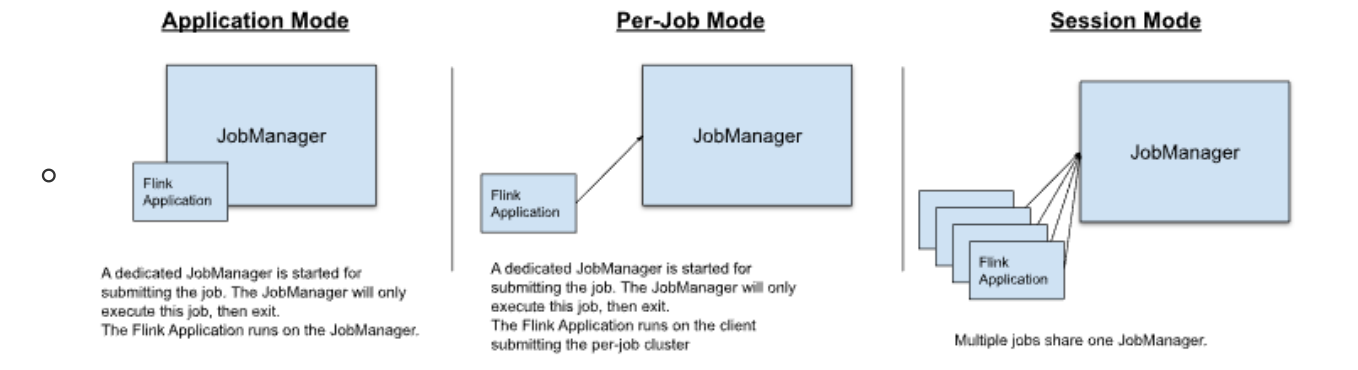

3、Flink三种运行环境

- 批处理运行环境

ExecutionEnvironment environment = ExecutionEnvironment.getExecutionEnvironment();

- 流处理运行环境

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

- 流处理环境兼容WebUI

<!--本地运行的webUI-->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-runtime-web</artifactId>

<version>1.15.2</version>

</dependency>

StreamExecutionEnvironment ui = StreamExecutionEnvironment.createLocalEnvironmentWithWebUI(new Configuration());

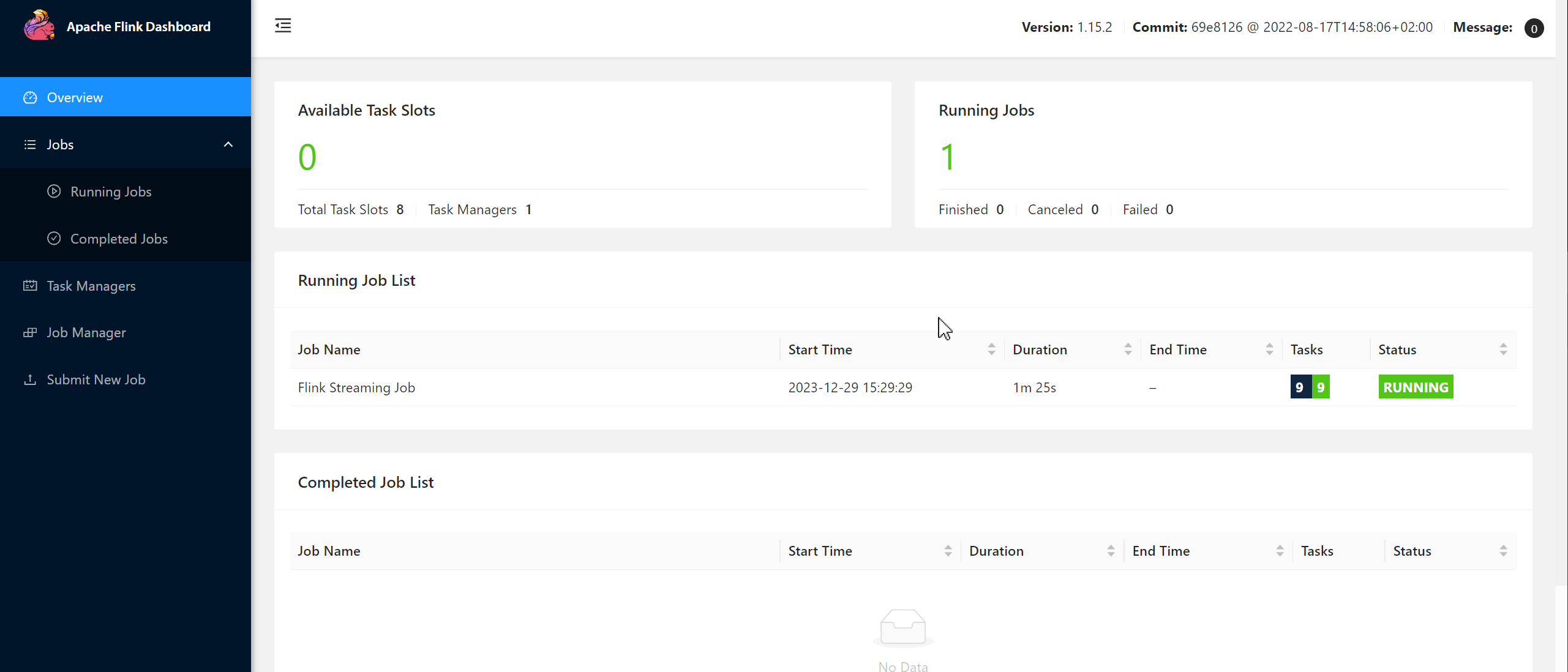

由于在本地环境,因此在浏览器访问http://localhost:8081.

4、Source类算子

4.1、通用方式

- 基于文本文件获取数据源

//基于File文件获取数据源

environment.readTextFile("data/data.txt");

- 基于socket网络获取数据源

//基于socket获取数据源

DataStreamSource<String> stream = environment.socketTextStream("localhost", 9999);

- 基于集合获取数据源

//基于Collection获取数据源

List<String> list = List.of("11", "22", "33", "44", "55");

DataStreamSource<String> streamSource = environment.fromCollection(list);

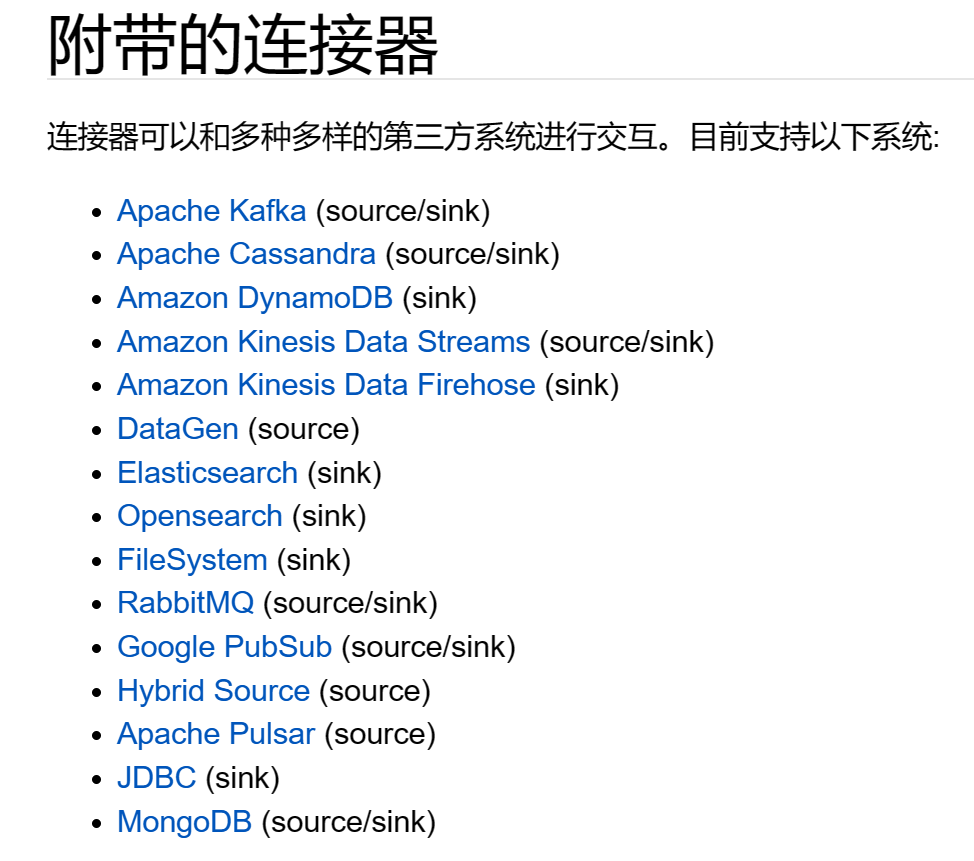

4.2、Connector方式

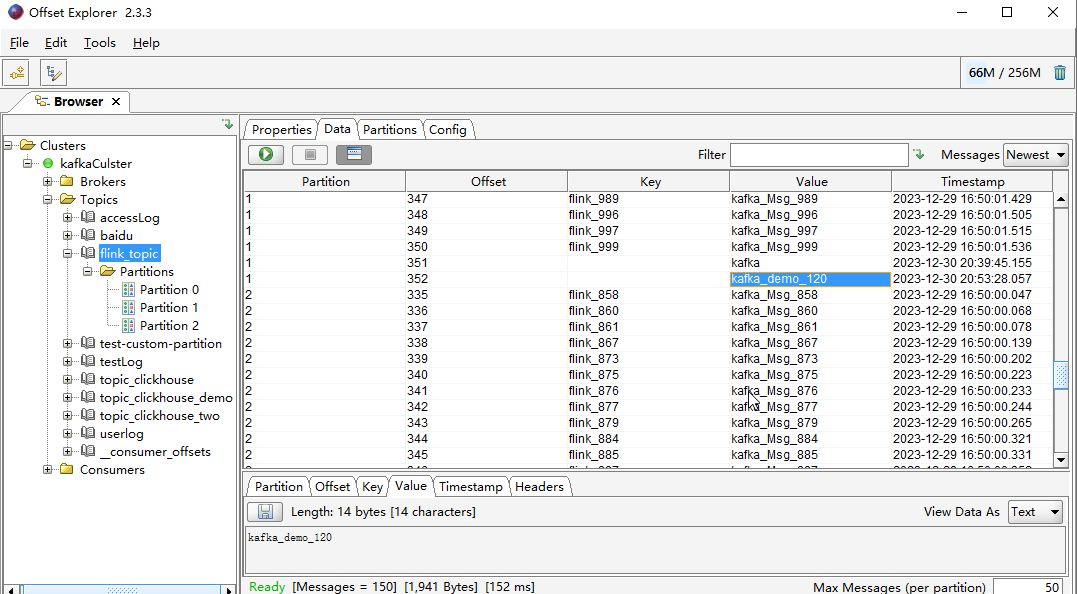

如图Flink连接器支持kafka、ElasticSearch、JDBC等数据源获取!我们通过这些第三方组件获取数据进行计算处理。官网手册:

https://nightlies.apache.org/flink/flink-docs-release-1.18/zh/docs/connectors/datastream/overview/这里只列举从kafka获取数据源,其他的自行查找官方文档!kafka版本在0.10及以上!

注意:从kafka读取数据时,flink设置的并行度应该小于kafka分区数,否则flink在用事件时间处理时会造成数据全部迟到,因为在读取source数据源时,使用forward模式传输,读取最小时间为水位线,当读取到空的并行处理时没有水位线flink没有时间,计算线程阻塞停止。

- 导入依赖

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-kafka</artifactId>

<version>1.15.2</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-base</artifactId>

<version>1.15.2</version>

</dependency>

- 创建主题

kafka-topics.sh --zookeeper node1:2181,master:2181,node2:2181/kafka0110 --create --replication-factor 2 --partitions 3 --topic flink_topic

- 创建kafka连接工具类

public class KafkaUtils {

//创建kafka生产者

public static KafkaProducer<String,String> getProducer(){

Properties prop=new Properties();

prop.setProperty("bootstrap.servers","node1:9092,master:9092,node2:9092");

//设置写出数据格式

prop.setProperty("key.serializer","org.apache.kafka.common.serialization.StringSerializer");

prop.setProperty("value.serializer","org.apache.kafka.common.serialization.StringSerializer");

//应答方式

prop.put("acks","all");

//错误重试次数

prop.put("retries",2);

//批量写出 16KB为一批数据

prop.put("batch.size",1024*16);

KafkaProducer<String, String> producer = new KafkaProducer<>(prop);

return producer;

}

//创建kafka消费者

public static KafkaConsumer<String,String> getConsumer(String groupId) {

//读取配置文件

Properties properties = new Properties();

properties.put("bootstrap.servers", "node1:9092,master:9092,node2:9092");

//设置groupId

properties.put("group.id", groupId);

//zk超时时间

properties.put("zookeeper.session,timeout.ms", "1000");

//反序列化

properties.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

properties.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

//当消费者第一次消费时,从最低的偏移量开始消费

properties.put("auto.offset.reset", "earliest");

//设置自动提交

properties.put("auto.commit.enable", "true");

//消费者自动提交偏移量的时间间隔 1s

properties.put("auto.commit.interval.ms", "1000");

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(properties);

return consumer;

}

}

- flink消费

import com.zwf.util.KafkaUtils;

import org.apache.flink.api.common.eventtime.WatermarkStrategy;

import org.apache.flink.api.common.serialization.SimpleStringSchema;

import org.apache.flink.connector.kafka.source.KafkaSource;

import org.apache.flink.connector.kafka.source.enumerator.initializer.OffsetsInitializer;

import org.apache.flink.streaming.api.datastream.DataStreamSource;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.ProducerRecord;

/**

* @author MrZeng

* @version 1.0

* @date 2023-12-29 16:19

*/

public class StreamDataSource {

public static void main(String[] args) throws Exception {

//启动线程向kafka中发送数据

new Thread(()->{

KafkaProducer<String, String> producer = KafkaUtils.getProducer();

for (int i=0;i<1000;i++){

ProducerRecord<String, String> record = new ProducerRecord<>("flink_topic", "flink_" + i, "kafka_Msg_" + i);

producer.send(record);

try {

Thread.sleep(10);

} catch (InterruptedException e) {

throw new RuntimeException(e);

}

}

}).start();

//创建环境

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment().setParallelism(1);

//flink连接kafka消费数据

KafkaSource<String> connector = KafkaSource.<String>builder()

.setBootstrapServers("node1:9092,master:9092,node2:9092")

.setTopics("flink_topic")

.setGroupId("my-group")

.setStartingOffsets(OffsetsInitializer.earliest())

.setValueOnlyDeserializer(new SimpleStringSchema())

.build();

//读取kafka数据源

DataStreamSource<String> streamSource = environment.fromSource(connector, WatermarkStrategy.noWatermarks(), "kafka Source");

streamSource.map(w->w.toUpperCase()).print();

//执行kafka 流处理

environment.execute();

}

}

4.3、自定义Source数据源

自定义数据源连接器需要实现

ParallelSourceFunction接口或者继承接口实现类RichParallelSourceFunction实现接口的方式读取源数据会设置多个并行度会造成数据重复消费,就需要继承接口的实现去获取上下文环境进行控制。

- 原始方法

package com.zwf.sourceconnector;

import org.apache.commons.io.FileUtils;

import org.apache.flink.api.common.functions.IterationRuntimeContext;

import org.apache.flink.api.common.functions.RuntimeContext;

import org.apache.flink.configuration.Configuration;

import org.apache.flink.streaming.api.datastream.DataStreamSource;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.functions.source.ParallelSourceFunction;

import org.apache.flink.streaming.api.functions.source.RichParallelSourceFunction;

import java.io.File;

import java.util.List;

import java.util.Objects;

/**

* @author MrZeng

* @version 1.0

* @date 2023-12-29 17:22

*/

public class CustomerConnector {

public static void main(String[] args) throws Exception {

//获取flink环境

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

//获取自定义数据源 设置并行度为2 会重复读取消费数据

DataStreamSource<String> source = environment.addSource(new CustomerDataSource("data/data.txt")).setParallelism(2);

//数据转大写 并打印输出

source.map(x->x.concat("==道德经==")).print();

environment.execute();

}

}

//最原始自定义数据源方式

class CustomerDataSource implements ParallelSourceFunction<String>{

private String path;

public CustomerDataSource(String path) {

this.path = path;

}

@Override

public void run(SourceContext<String> ctx) throws Exception {

List<String> list = FileUtils.readLines(new File(path), "UTF-8");

for(String data:list){

ctx.collect(data);

}

}

@Override

public void cancel() {

}

}

- 获取上下文环境控制重复读取

public class CustomerConnector {

public static void main(String[] args) throws Exception {

//获取flink环境

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

//获取自定义数据源 设置并行度为2 会重复读取消费数据

DataStreamSource<String> source = environment.addSource(new CustomerDataSource("data/data.txt")).setParallelism(2);

//数据转大写 并打印输出

source.map(x->x.concat("==道德经==")).print();

environment.execute();

}

}

//第二种法继承自定义数据源的RichParallelSourceFunction获取上下文环境

class CustomerRichParallel extends RichParallelSourceFunction<String>{

private String path;

public CustomerRichParallel(String path) {

this.path = path;

}

@Override

public void run(SourceContext<String> ctx) throws Exception {

//获取并行度数

int number = this.getRuntimeContext().getNumberOfParallelSubtasks();

//获取并行度ID

int parallelId = this.getRuntimeContext().getIndexOfThisSubtask();

List<String> list = FileUtils.readLines(new File(path), "UTF-8");

for (String v:list){

//把多个并行度相同的数据去重

if(Math.abs(Objects.hash(v)%number)==parallelId) {

ctx.collect(v);

}

}

}

@Override

public void cancel() {

}

@Override

public RuntimeContext getRuntimeContext() {

return super.getRuntimeContext();

}

@Override

public IterationRuntimeContext getIterationRuntimeContext() {

return super.getIterationRuntimeContext();

}

@Override

public void open(Configuration parameters) throws Exception {

super.open(parameters);

}

@Override

public void close() throws Exception {

super.close();

}

}

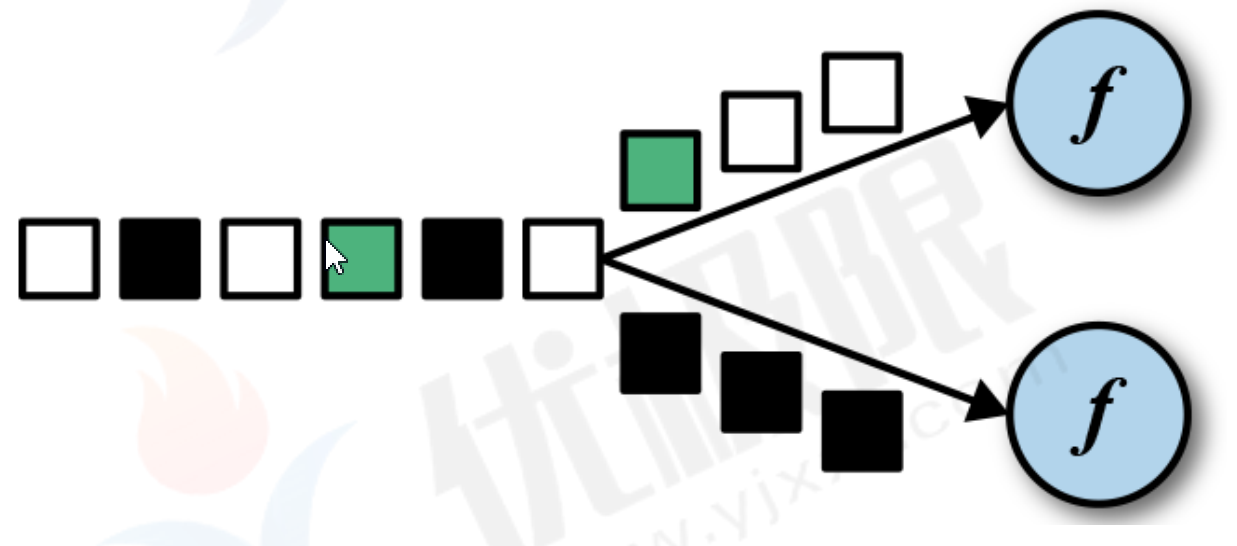

5、Transform算子

- map

映射算子,把集合中每个元素取出来后进行处理后,再返回!

keybySource.map(x-> Tuple2.of(1,x), Types.TUPLE(Types.INT,Types.STRING)).keyBy(x->x.f1).sum(0).print();

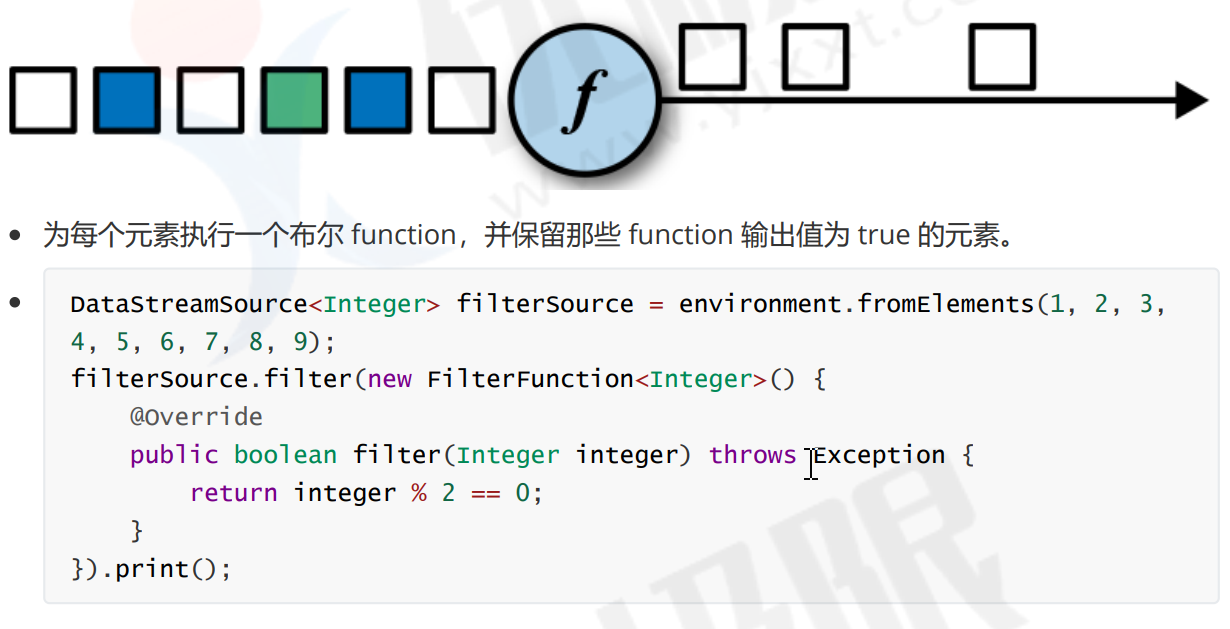

- filter

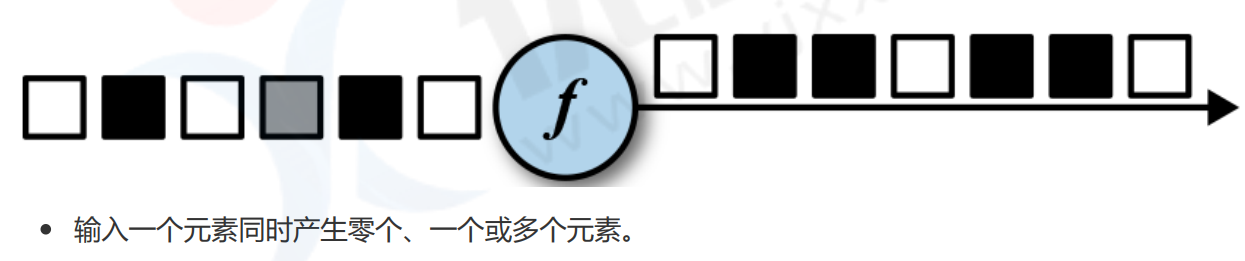

- flatMap

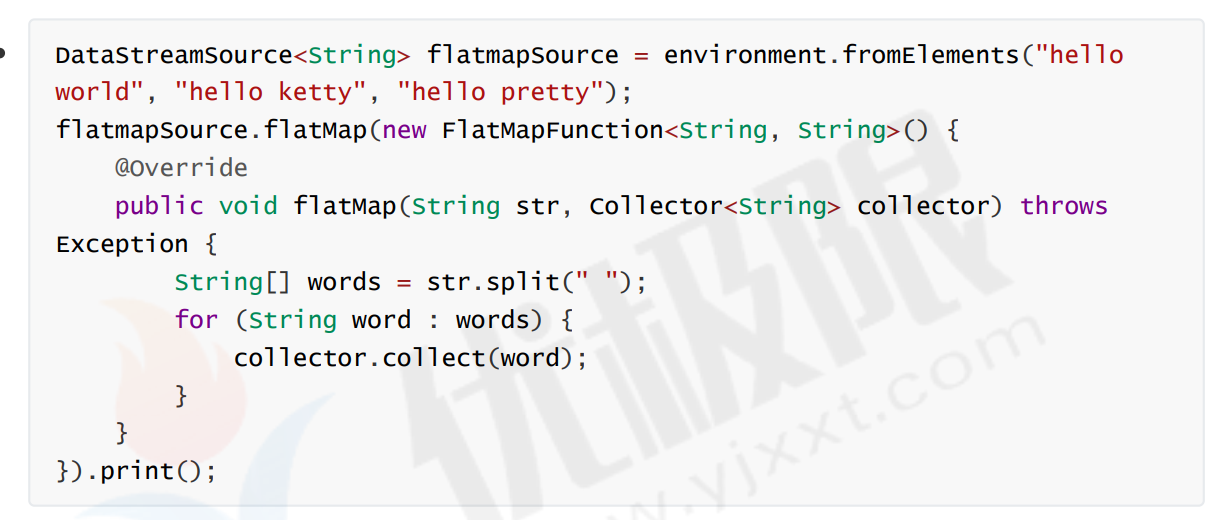

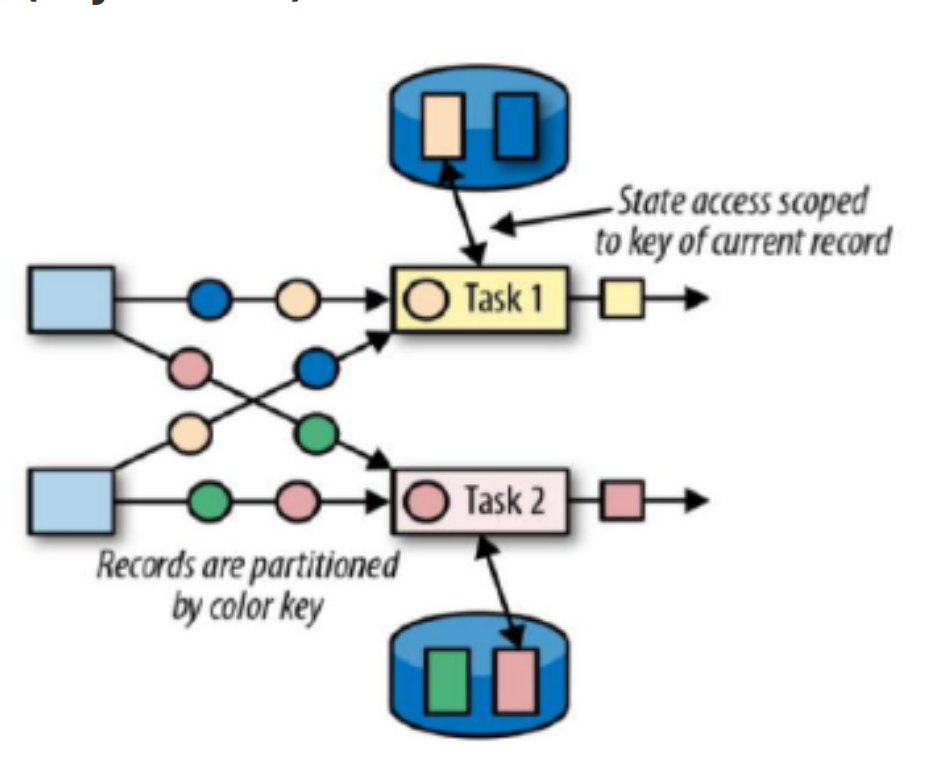

- keyBy

在逻辑上将流划分为不想交的分区。具有相同key的记录都分配到同一个分区。在内部,keyBy()是通过哈希分区实现的。

DataStreamSource<String> keybySource = environment.fromElements("aaaa", "bbb", "ccc", "aaaa", "ddd");

keybySource.map(x-> Tuple2.of(1,x), Types.TUPLE(Types.INT,Types.STRING)).keyBy(x->x.f1).sum(0).print();

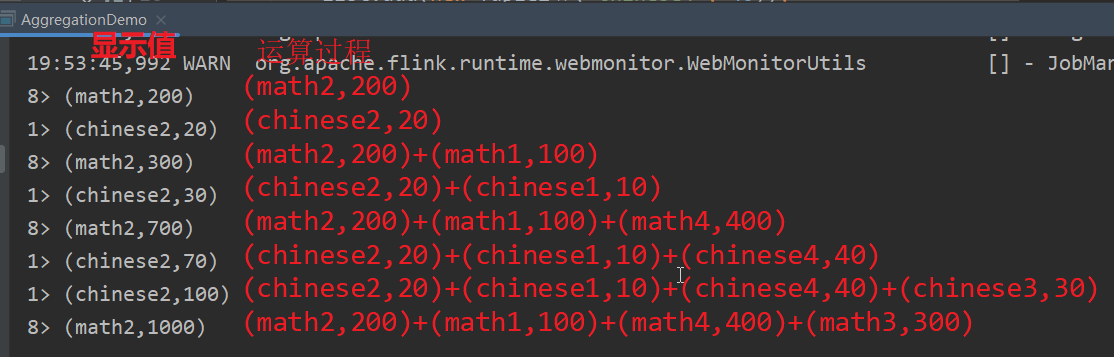

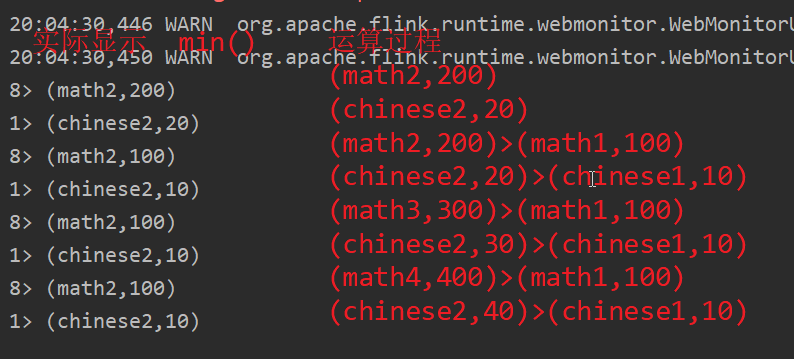

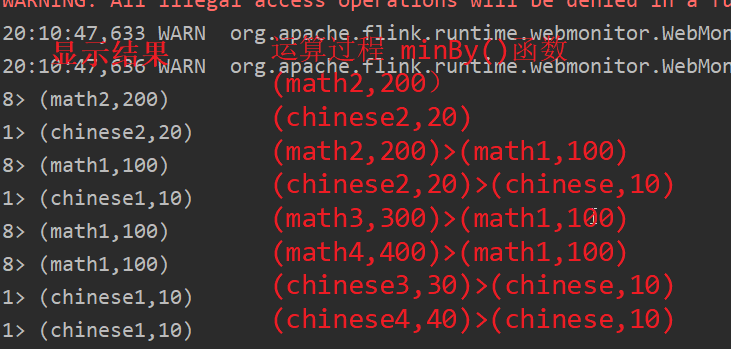

- aggregation函数

滚动聚合算子由 KeyedStream 调用,并生成一个聚合以后的DataStream

滚动聚合算子是多个聚合算子的统称, 有 sum、 min、 minBy、 max、 maxBy;

常见聚合方法:

- sum():在输入流上对指定的字段做滚动相加操作。

- min():在输入流上对指定的字段求最小值。

- max():在输入流上对指定的字段求最大值。

- minBy():在输入流上针对指定字段求最小值,并返回最小值字段所在的那条数据。

- maxBy():在输入流上针对指定字段求最大值,并返回最大值字段所在的那条数据。

- sum()使用

//创建flink环境

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

List<Tuple2<String, Integer>> list = new ArrayList<>();

list.add(new Tuple2<>("math2", 200));

list.add(new Tuple2<>("chinese2", 20));

list.add(new Tuple2<>("math1", 100));

list.add(new Tuple2<>("chinese1", 10));

list.add(new Tuple2<>("math4", 400));

list.add(new Tuple2<>("chinese4", 40));

list.add(new Tuple2<>("math3", 300));

list.add(new Tuple2<>("chinese3", 30));

DataStreamSource<Tuple2<String, Integer>> source = environment.fromCollection(list);

source.keyBy(x -> x.f0.length()).sum(1).print();

environment.execute();

- min()使用 max()同理

source.keyBy(x -> x.f0.length()).min(1).print();

- minBy()使用,maxBy()同理

source.keyBy(x -> x.f0.length()).minBy(1).print();

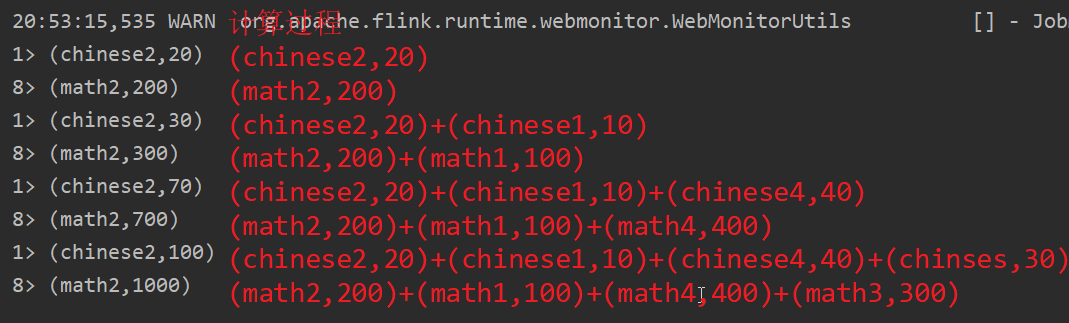

- reduce()

在相同key 的数据流上“滚动”执行 reduce。将当前元素与最后一次 reduce 得到的值组合然后输出新值。

//创建flink环境

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

List<Tuple2<String, Integer>> list = new ArrayList<>();

list.add(new Tuple2<>("math2", 200));

list.add(new Tuple2<>("chinese2", 20));

list.add(new Tuple2<>("math1", 100));

list.add(new Tuple2<>("chinese1", 10));

list.add(new Tuple2<>("math4", 400));

list.add(new Tuple2<>("chinese4", 40));

list.add(new Tuple2<>("math3", 300));

list.add(new Tuple2<>("chinese3", 30));

DataStreamSource<Tuple2<String, Integer>> source = environment.fromCollection(list);

source.keyBy(x -> x.f0.length()).reduce((x,y)-> new Tuple2<>(x.f0,(x.f1+y.f1))).print();

environment.execute();

- Iterate函数算子

//Iterate 迭代器使用 用于循环处理数据流

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

environment.setParallelism(1);

//数据源

DataStream<String> source = environment.fromElements("苹果,101", "桃子,51", "葡萄,202");

IterativeStream<Tuple3<String, Integer, Integer>> iterateStream = source.map((x) -> {

String[] split = x.split(",");

return Tuple3.of(split[0], Integer.parseInt(split[1]), 0);

}, Types.TUPLE(Types.STRING, Types.INT, Types.INT)).iterate();

//迭代体

SingleOutputStreamOperator<Tuple3<String, Integer, Integer>> iterativeBody = iterateStream.map((x) -> {

x.f1 -= 10;

x.f2++;

return x;

}, Types.TUPLE(Types.STRING, Types.INT, Types.INT));

//迭代条件

SingleOutputStreamOperator<Tuple3<String, Integer, Integer>> filter = iterativeBody.filter(x -> x.f1 > 10);

iterateStream.closeWith(filter);

//不满足迭代条件的

SingleOutputStreamOperator<Tuple3<String, Integer, Integer>> output = iterativeBody.filter(x -> x.f1 <= 10);

output.print("不满足条件的数据:");

//运行环境

environment.execute();

- connect()函数,可以将两组数据类型不一样,元素个数不一样的数据联合一起。

- union()函数,可以将两组数据类型一样,元素个数一样的数据联合一起,并且不会去重。

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

DataStreamSource<String> data1 = environment.fromElements("Yes", "Yes", "Yes", "No", "No");

DataStreamSource<Double> data2 = environment.fromElements(40.3D, 20.6D, 25D, 32.3D, 37.6D);

ConnectedStreams<String,Double> connect = data1.connect(data2);

connect.map(new CoMapFunction<String, Double, String>() {

@Override

public String map1(String value) throws Exception {

if(value.equals("Yes")){

return "报警器安全!";

}

return "报警器危险!";

}

@Override

public String map2(Double value) throws Exception {

if(value.doubleValue()>30.0){

return "温度感应器危险!";

}

return "温度感应器安全!";

}

}).print();

environment.execute();

6、Flink Sink类算子

把计算好的结果写入哪个设备,普通组件:File、Console、Socket(套节字);Connector:kafka、jdbc等。

- 写入txt/csv/文件中或者控制台中,socket套接字!一般用于测试环境。

//文本字符传入文本文件中

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

//默认是8个并行度 会出现生成8个文本文件,但是可能会出现有的文本文件没有字符!

//防止重复设置一个并行度

environment.setParallelism(1);

List<Tuple2<String, String>> lists = new ArrayList<>();

lists.add(new Tuple2<>("赵欣", "18"));

lists.add(new Tuple2<>("李四", "22"));

lists.add(new Tuple2<>("王五", "23"));

lists.add(new Tuple2<>("赵六", "18"));

lists.add(new Tuple2<>("田七", "16"));

lists.add(new Tuple2<>("朱八", "14"));

lists.add(new Tuple2<>("甜甜", "13"));

DataStreamSource<Tuple2<String, String>> source = environment.fromCollection(lists);

//存为csv文件必须是Tuple类型 否则会报错!

source.map(x->x,Types.TUPLE(Types.STRING,Types.STRING)).writeAsCsv("data/new"+System.currentTimeMillis()+".csv");

// 保存文本文件 可以不用是Tuple类型

// source.writeAsText("data/new.txt");

//打印控制台

source.print();

environment.execute();

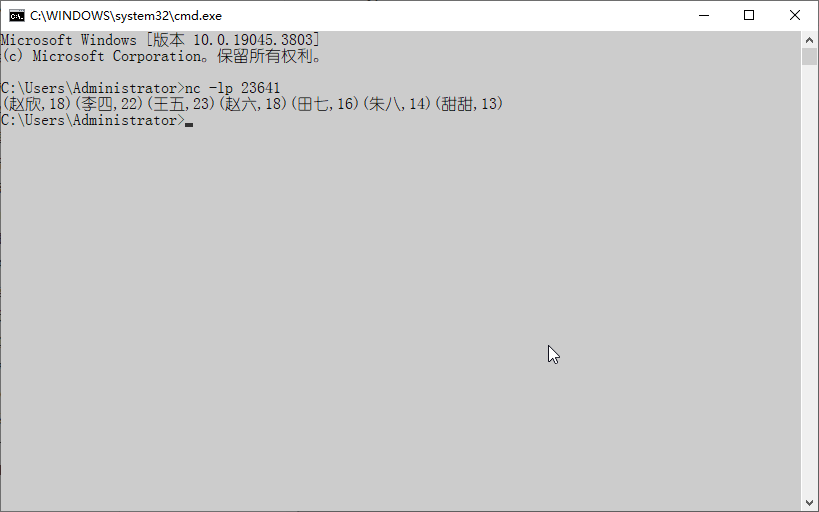

- 使用套接字上传到服务器

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

//默认是8个并行度 会出现生成8个文本文件,但是可能会出现有的文本文件没有字符!

//防止重复设置一个并行度

environment.setParallelism(1);

List<Tuple2<String, String>> lists = new ArrayList<>();

lists.add(new Tuple2<>("赵欣", "18"));

lists.add(new Tuple2<>("李四", "22"));

lists.add(new Tuple2<>("王五", "23"));

lists.add(new Tuple2<>("赵六", "18"));

lists.add(new Tuple2<>("田七", "16"));

lists.add(new Tuple2<>("朱八", "14"));

lists.add(new Tuple2<>("甜甜", "13"));

DataStreamSource<Tuple2<String, String>> source = environment.fromCollection(lists);

//输出道服务器中

source.writeToSocket("localhost", 23641, new SerializationSchema<Tuple2<String, String>>() {

@Override

public byte[] serialize(Tuple2<String, String> element) {

try {

return element.toString().getBytes("GBK");

} catch (UnsupportedEncodingException e) {

throw new RuntimeException(e);

}

}

});

environment.execute();

使用nc模拟测试

把数据写入Connector中,包括jdbc、kafka等。

<!--flink与kafka整合-->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-kafka</artifactId>

<version>1.15.2</version>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-base</artifactId>

<version>1.15.2</version>

</dependency>

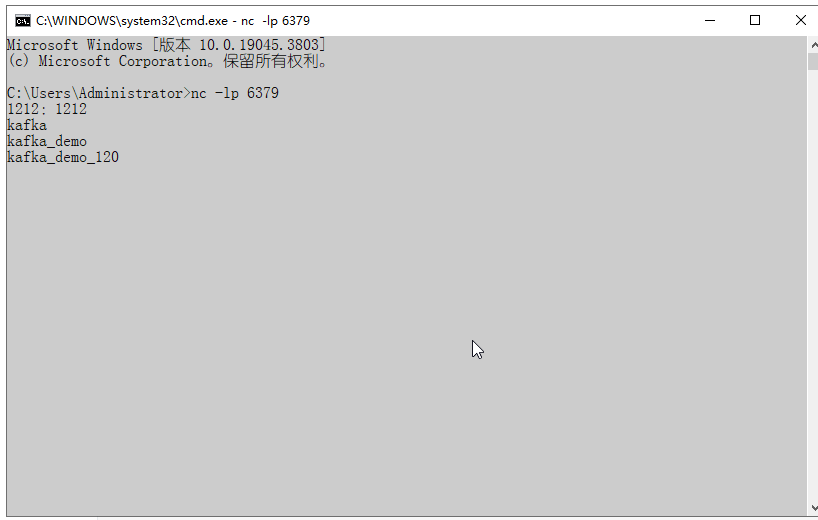

- CMD监听socket端口写数据

//把数据写入kafka

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

environment.setParallelism(1);

DataStreamSource<String> streamSource = environment.socketTextStream("localhost", 6379);

//设置kafka写出配置

KafkaSink<String> build = KafkaSink.<String>builder()

.setBootstrapServers("node1:9092,master:9092,node2:9092")

.setRecordSerializer(KafkaRecordSerializationSchema.builder()

.setTopic("flink_topic")

.setKeySerializationSchema(new SimpleStringSchema())

.setValueSerializationSchema(new SimpleStringSchema())

.build()

).setDeliverGuarantee(DeliveryGuarantee.AT_LEAST_ONCE)

.build();

streamSource.sinkTo(build);

environment.execute();

}

- 把计算数据写入JDBC连接器

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-jdbc</artifactId>

<version>1.15.2</version>

</dependency>

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

<version>8.0.16</version>

</dependency>

- Jdbc建表语句

create table if not exists scott.Books(

id varchar(50),

title varchar(50),

author varchar(50),

price double,

qty Int

)

package com.zwf.sink;

import org.apache.commons.lang3.RandomStringUtils;

import org.apache.commons.lang3.RandomUtils;

import org.apache.flink.api.common.typeinfo.Types;

import org.apache.flink.connector.jdbc.JdbcConnectionOptions;

import org.apache.flink.connector.jdbc.JdbcExecutionOptions;

import org.apache.flink.connector.jdbc.JdbcSink;

import org.apache.flink.streaming.api.datastream.DataStreamSource;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import java.util.UUID;

/**

* @author MrZeng

* @version 1.0

* @date 2023-12-30 21:10

*/

class Book{

private String id;

private String title;

private String author;

private Double price;

private Integer qty;

public Book(String id, String title, String author, Double price, Integer qty) {

this.id = id;

this.title = title;

this.author = author;

this.price = price;

this.qty = qty;

}

public String getId() {

return id;

}

public void setId(String id) {

this.id = id;

}

public String getTitle() {

return title;

}

public void setTitle(String title) {

this.title = title;

}

public String getAuthor() {

return author;

}

public void setAuthor(String author) {

this.author = author;

}

public Double getPrice() {

return price;

}

public void setPrice(Double price) {

this.price = price;

}

public Integer getQty() {

return qty;

}

public void setQty(Integer qty) {

this.qty = qty;

}

@Override

public String toString() {

return "Book{" +

"id=" + id +

", title='" + title + '\'' +

", author='" + author + '\'' +

", price=" + price +

", qty=" + qty +

'}';

}

}

public class JdbcSinkDemo {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

DataStreamSource<Book> source = environment.fromElements(

new Book(RandomStringUtils.randomAlphabetic(8), "<<java从入门到精通>>", "詹姆斯.高斯林", 19.26D, 11)

, new Book(RandomStringUtils.randomAlphabetic(8), "<<python从入门到精通>>", "詹姆斯.高斯林", 23.12D, 20)

, new Book(RandomStringUtils.randomAlphabetic(8), "<<c++从入门到精通>>", "詹姆斯.高斯林", 63.56D, 26)

, new Book(RandomStringUtils.randomAlphabetic(8), "<<scala从入门到精通>>", "詹姆斯.高斯林", 58.3D, 18));

source.addSink(JdbcSink.sink("insert into Books (id, title, author, price, qty) values (?,?,?,?,?)",(ps, t)->{

ps.setString(1,t.getId());

ps.setString(2,t.getTitle());

ps.setString(3,t.getAuthor());

ps.setDouble(4,t.getPrice());

ps.setInt(5,t.getQty());

//批数据为1条就提交 默认是5000条 否则数据不会立即插入数据库 要挤攒到5000条

//才能把数据插入数据库

},new JdbcExecutionOptions.Builder().withBatchSize(1).build()

,new JdbcConnectionOptions

.JdbcConnectionOptionsBuilder()

.withUrl("jdbc:mysql://master:3306/scott?useUnicode=true&characterEncoding=UTF-8&serverTimeZone=UTC")

.withDriverName("com.mysql.cj.jdbc.Driver")

.withUsername("root")

.withPassword("Root@123456.")

.build()));

environment.execute();

}

}

自定义Sink函数

<dependency>

<groupId>org.springframework</groupId>

<artifactId>spring-core</artifactId>

<version>5.3.21</version>

</dependency>

- java代码

package com.zwf.sink;

import org.apache.commons.io.FileUtils;

import org.apache.flink.streaming.api.datastream.DataStreamSource;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.functions.sink.SinkFunction;

import org.springframework.util.DigestUtils;

import java.io.File;

import java.util.ArrayList;

/**

* @author MrZeng

* @version 1.0

* @date 2023-12-30 22:17

*/

public class CustomSinkDemo {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment environment =

StreamExecutionEnvironment.getExecutionEnvironment();

environment.setParallelism(2);

//操作数据

ArrayList<String> list = new ArrayList<>();

list.add("君子周而不比,小人比而不周");

list.add("君子喻于义,小人喻于利");

list.add("君子怀德,小人怀土;君子怀刑,小人怀惠");

list.add("君子欲讷于言而敏于行");

list.add("君子坦荡荡,小人长戚戚");

DataStreamSource<String> source =

environment.fromCollection(list);

source.addSink(new CustomSinkFunction("data/" +

System.currentTimeMillis()+".txt"));

environment.execute();

}

}

class CustomSinkFunction implements SinkFunction<String> {

private File file;

public CustomSinkFunction(String path) {

file = new File(path);

}

@Override

public void invoke(String value, Context context) throws Exception {

//写出数据

String s = DigestUtils.md5DigestAsHex(value.getBytes("UTF-8"))+"\t\n";

FileUtils.writeStringToFile(file,s,"UTF-8",true);

}

}

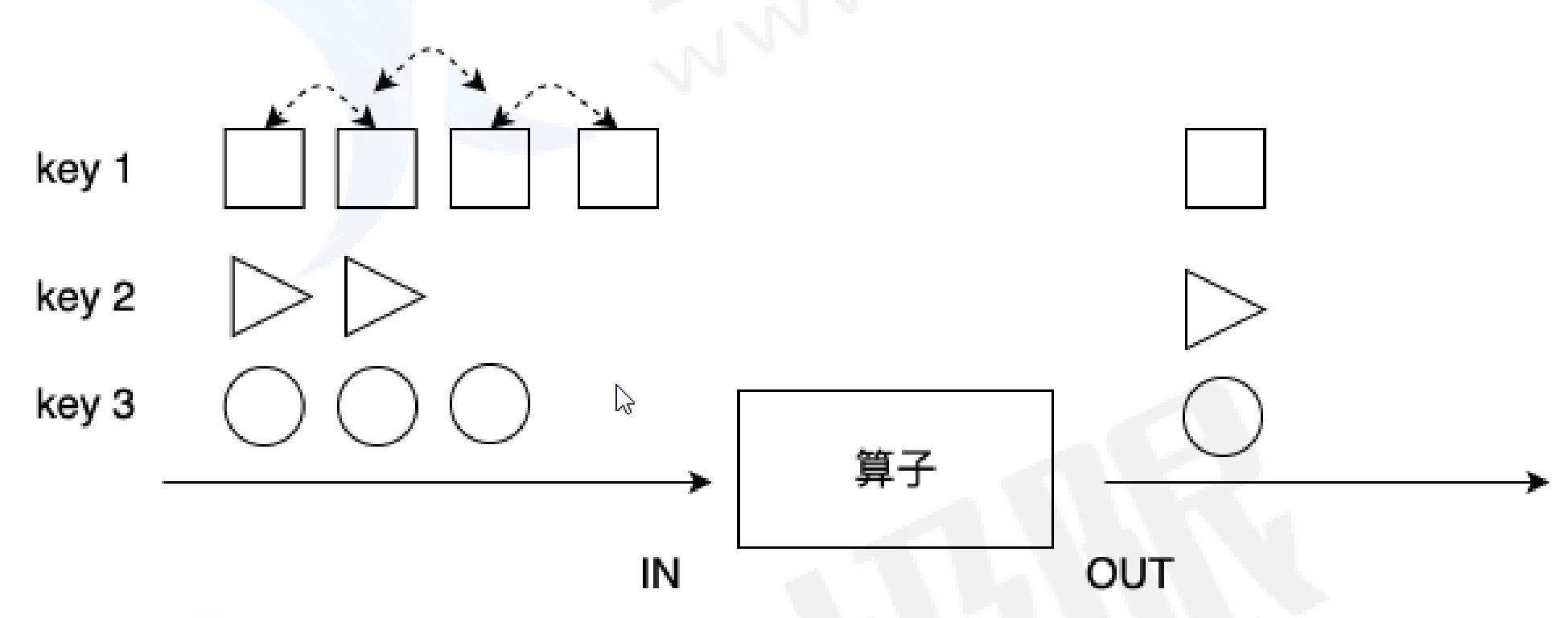

7、分区类算子

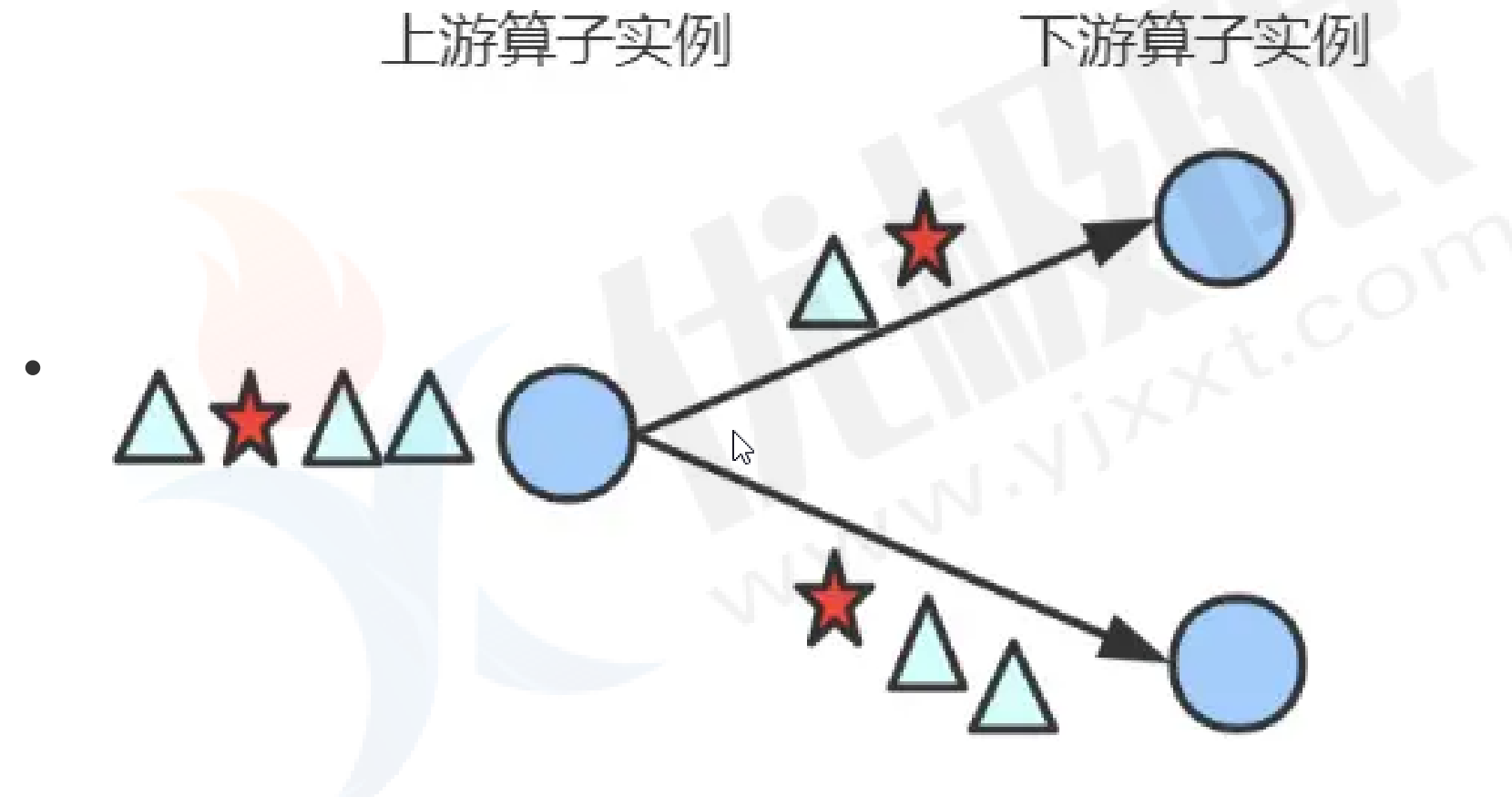

- 分区算子:用于指定上游 task 的各并行 subtask 与下游 task 的 subtask 之间如何传输数据。

Global(): 分区器会将上游所有元素都发送到下游的第一个算子实例上(SubTask Id=0)。

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

environment.setParallelism(2);

DataStreamSource<String> source = environment.readTextFile("data/data.txt").setParallelism(1);

//把所有的数据拉取到第一个并行度上

source.global().print("globalFunction");

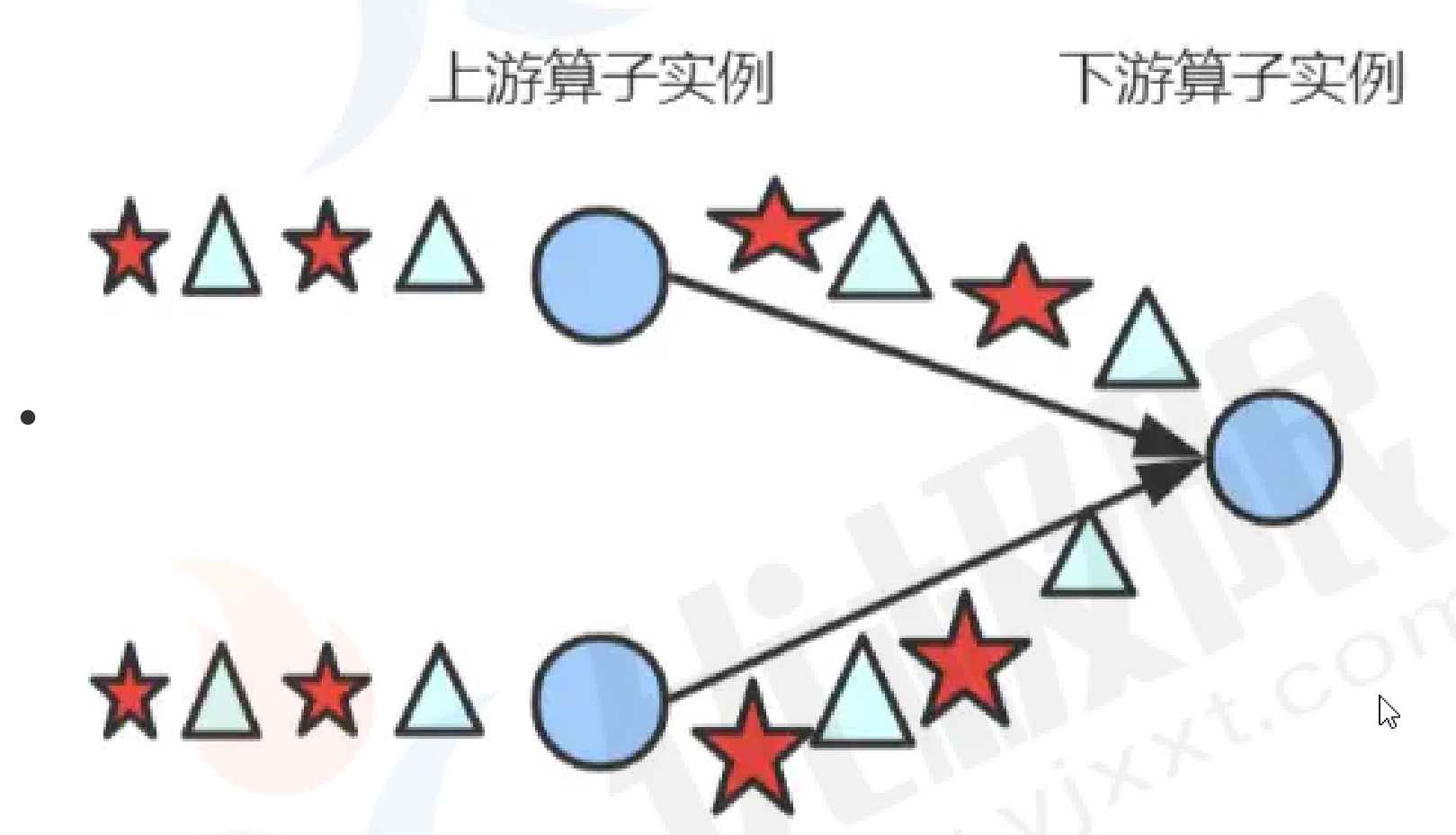

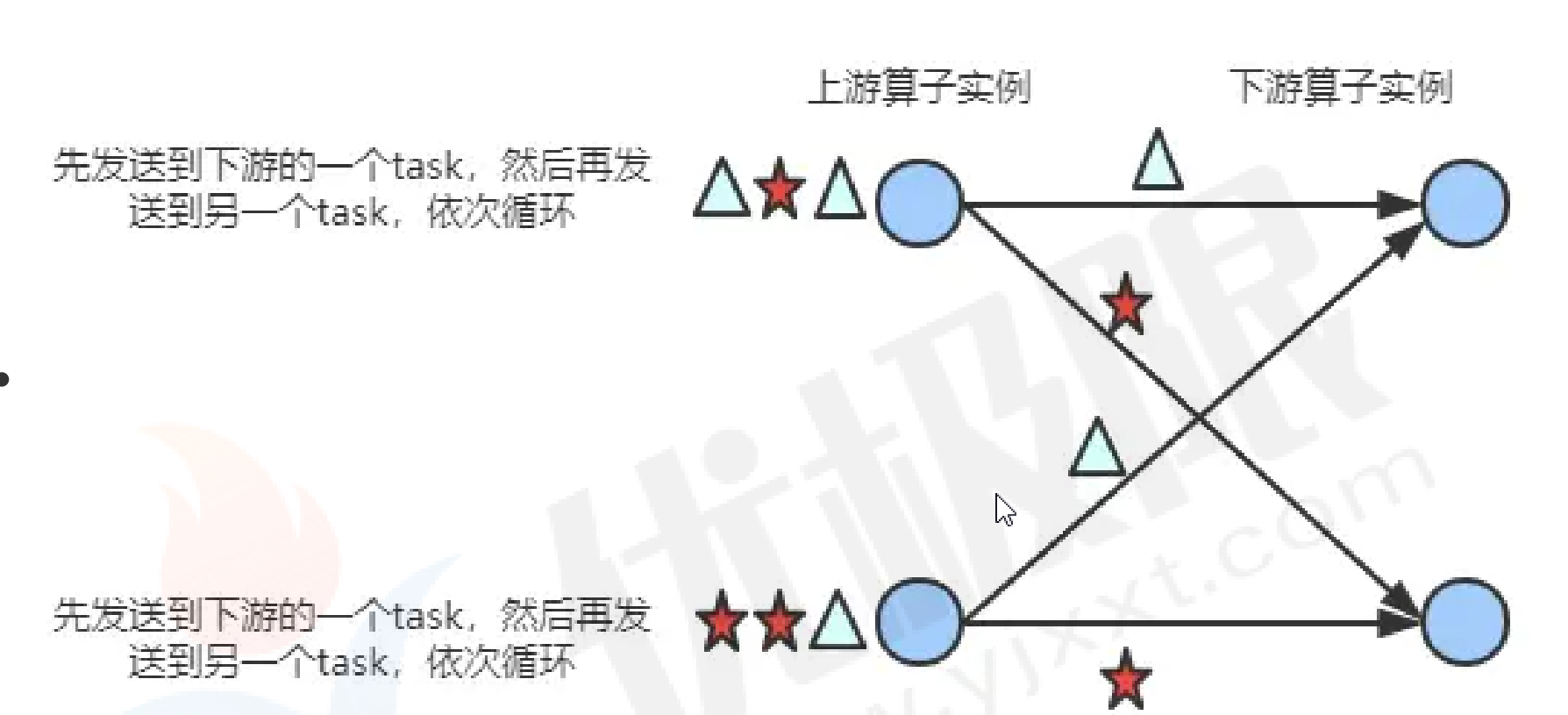

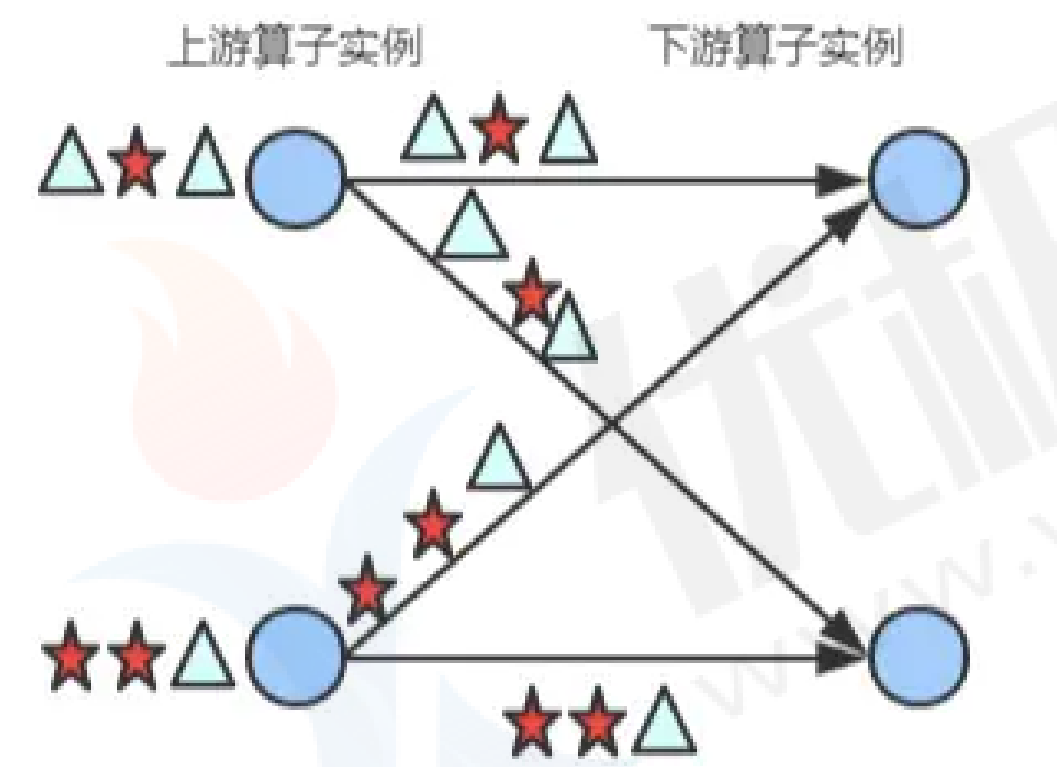

reblance():上游轮询把数据分发给下游!

source.rebalance().print("rebalance").setParallelism(4);

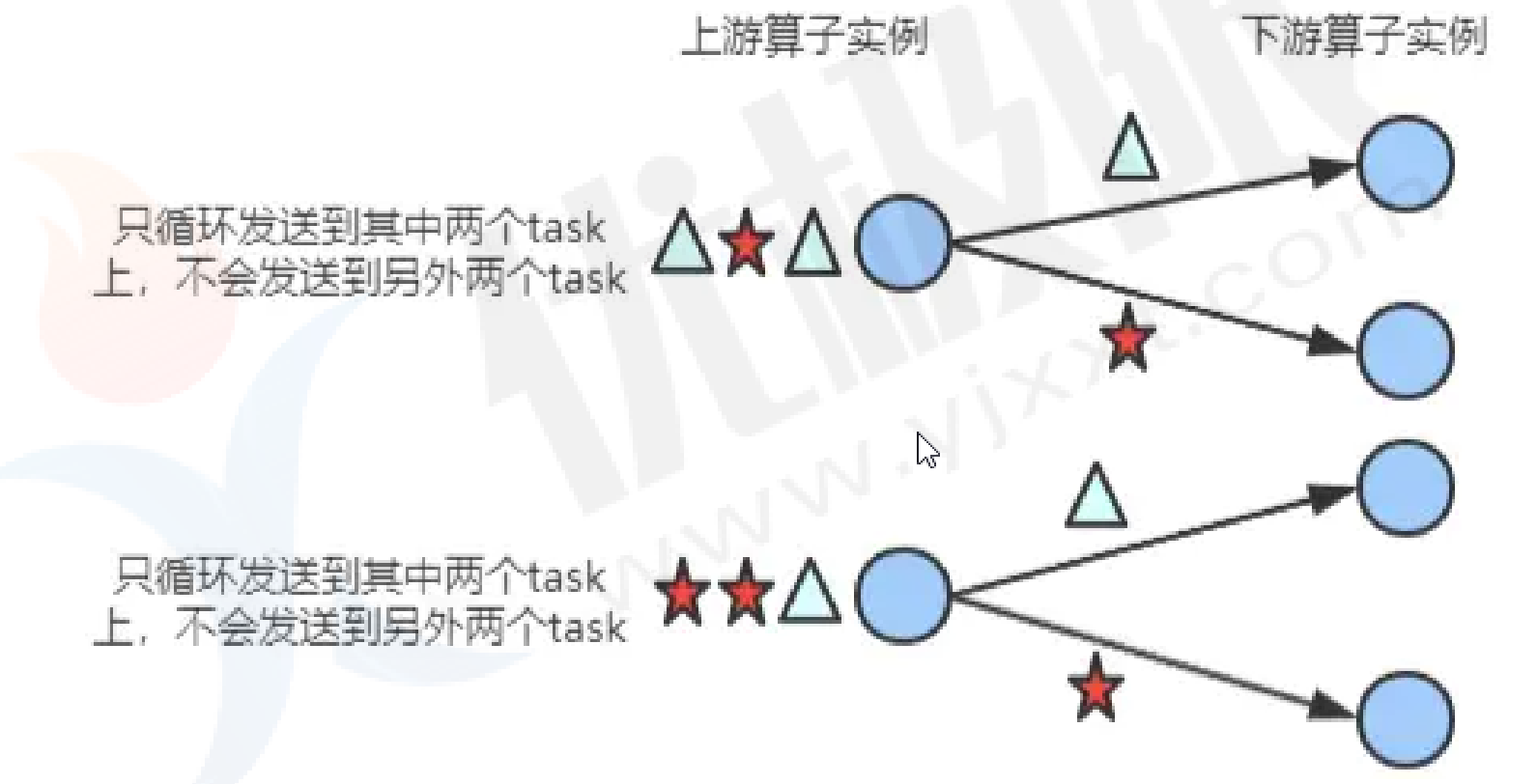

rescale():上游按照比例把数据发送给下游

- 若上游并行度是2,下游是4,则上游一个并行度以循环的方式将记录输出到下游的两个并行 度上;上游另一个并行度以循环的方式将记录输出到下游另两个并行度上。

source.rescale().print("rescale").setParallelism(2);

shuffle():上游取出一个数据后随机分发给下游

source.shuffle().print("shuffle").setParallelism(2);

broadcast():上游所有数据广播给下游所有分区,也就是说下游每个分区都可以获取上游的全量数据,一般用于大小表join操作!

source.broadcast().print("broadcast==>").setParallelism(4);

forward():上游数据分发给下游每个分区,必须要求上下游分区数一致,当两个数据可以组成操作链时,默认使用操作链方式进行发送!

keyby(): 按照key值的hash值对分区数取余进行分发给下游分区。

source.keyBy(x->x).print("keyBy分区器:").setParallelism(4);

partitionCustom():自定义分区器,自定义设置分区器分发规则。

source.partitionCustom(new Partitioner<String>() {

@Override

public int partition(String key, int numPartitions) {

return Math.abs(key.hashCode())%numPartitions;

}

}, new KeySelector<String, String>() {

@Override

public String getKey(String value) throws Exception {

return value;

}

}).print("自定义分区器").setParallelism(4);

8、Flink Process Function

转换算子是无法访问事件的时间戳信息和水位线信息的,而这在一些应用场景下,极为重要。

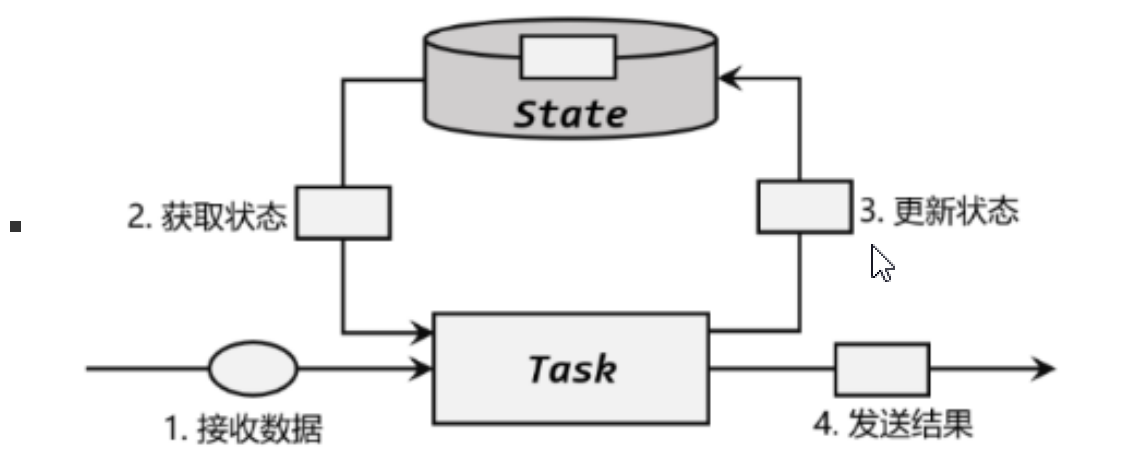

ProcessFunction 函数是低阶流处理算子,可以访问流应用程序所有(非循环)基本构建块:事件(数据元素)、状态(容错和一致性)、定时器(事件时间和处理时间)

- 函数分类

Flink提供了8个不同的处理函数:

- ProcessFunction:最基本的处理函数,基于 DataStream 直接调用.process()时作为参数传入。

- KeyedProcessFunction:对流按键分区后的处理函数,基于 KeyedStream 调用.process()时作为参数传入。要想使用 定时器,比如基于 KeyedStream。

- ProcessWindowFunction:开窗之后的处理函数,也是全窗口函数的代表。基于 WindowedStream 调用.process()时作 为参数传入。

- ProcessAllWindowFunction:同样是开窗之后的处理函数,基于 AllWindowedStream 调用.process()时作为参数传入。

- CoProcessFunction:合并(connect)两条流之后的处理函数,基于 ConnectedStreams 调用.process()时作为参 数传入。关于流的连接合并操作。

- ProcessJoinFunction:间隔连接(interval join)两条流之后的处理函数,基于 IntervalJoined 调用.process()时作 为参数传入。

- BroadcastProcessFunction:广播连接流处理函数,基于 BroadcastConnectedStream 调用.process()时作为参数传入。 这里的“广播连接流”BroadcastConnectedStream,是一个未 keyBy 的普通 DataStream 与 一个广播流(BroadcastStream)做连接(conncet)之后的产物。

- KeyedBroadcastProcessFunction:按键分区的广播连接流处理函数,同样是基于 BroadcastConnectedStream 调用.process() 时作为参数传入。与 BroadcastProcessFunction 不同的是,这时的广播连接流,是一个 KeyedStream与广播流(BroadcastStream)做连接之后的产物。

- WordCount案例

package com.zwf.processFunction;

import org.apache.flink.api.common.state.ValueState;

import org.apache.flink.api.common.state.ValueStateDescriptor;

import org.apache.flink.api.common.typeinfo.Types;

import org.apache.flink.api.java.tuple.Tuple2;

import org.apache.flink.configuration.Configuration;

import org.apache.flink.streaming.api.datastream.DataStreamSource;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.functions.KeyedProcessFunction;

import org.apache.flink.streaming.api.functions.ProcessFunction;

import org.apache.flink.util.Collector;

/**

* @author MrZeng

* @version 1.0

* @date 2024-01-02 11:13

*/

public class WordCount {

public static void main(String[] args) throws Exception {

//使用flink最底层API开发 wordcount案例代码

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

DataStreamSource<String> source = environment.readTextFile("data/data.txt");

environment.setParallelism(1);

//处理数据

source.process(new ProcessFunction<String, String>() {

@Override

public void processElement(String line, ProcessFunction<String, String>.Context ctx, Collector<String> out) throws Exception {

String[] split = line.split("\\s+");

for(String s:split) {

out.collect(s);

}

}

}).process(new ProcessFunction<String, Tuple2<String,Integer>>() {

@Override

public void processElement(String word, ProcessFunction<String, Tuple2<String, Integer>>.Context ctx, Collector<Tuple2<String, Integer>> out) throws Exception {

out.collect(Tuple2.of(word,1));

}

}).keyBy(w->w, Types.TUPLE(Types.STRING,Types.INT)).process(new KeyedProcessFunction<Tuple2<String, Integer>, Tuple2<String, Integer>, Tuple2<String, Integer>>() {

private ValueState<Integer> valueState;

@Override

public void open(Configuration parameters) throws Exception{

//设置状态初始值

valueState= getRuntimeContext().getState(new ValueStateDescriptor<Integer>("word-count",Integer.class,0));

}

@Override

public void processElement(Tuple2<String, Integer> value, KeyedProcessFunction<Tuple2<String, Integer>, Tuple2<String, Integer>, Tuple2<String, Integer>>.Context ctx, Collector<Tuple2<String, Integer>> out) throws Exception {

//获取初始值

Integer countV = valueState.value();

//把同一个key的值进行累加 并更新状态初始值

countV += value.f1;

valueState.update(countV);

//输出数据

out.collect(Tuple2.of(value.f0, countV));

}

}).print();

environment.execute();

}

}

- 侧输出

process function可以通过Context对象发射一个事件到一个或者多个side outputs。

一个side output可以定义为OutputTag[X]对象,X是输出流的数据类型。

process function的side outputs功能可以产生多条流,并且这些流的数据类型可以不一样。

package com.zwf.processFunction;

import org.apache.flink.api.common.state.ValueState;

import org.apache.flink.api.common.state.ValueStateDescriptor;

import org.apache.flink.api.common.typeinfo.Types;

import org.apache.flink.api.java.tuple.Tuple2;

import org.apache.flink.configuration.Configuration;

import org.apache.flink.streaming.api.datastream.DataStreamSource;

import org.apache.flink.streaming.api.datastream.SingleOutputStreamOperator;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.functions.KeyedProcessFunction;

import org.apache.flink.streaming.api.functions.ProcessFunction;

import org.apache.flink.util.Collector;

import org.apache.flink.util.OutputTag;

/**

* @author MrZeng

* @version 1.0

* @date 2024-01-02 11:13

*/

public class WordCount {

public static void main(String[] args) throws Exception {

//使用flink最底层API开发 wordcount案例代码

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

DataStreamSource<String> source = environment.readTextFile("data/data.txt");

environment.setParallelism(1);

//创建侧输出流标签

OutputTag<String> tag1 = new OutputTag<>("sideOutput1"){};

OutputTag<Integer> tag2 = new OutputTag<>("sideOutput2"){};

//处理数据

SingleOutputStreamOperator<Tuple2<String, Integer>> process = source.process(new ProcessFunction<String, String>() {

@Override

public void processElement(String line, ProcessFunction<String, String>.Context ctx, Collector<String> out) throws Exception {

String[] split = line.split("\\s+");

for (String s : split) {

out.collect(s);

}

}

}).process(new ProcessFunction<String, Tuple2<String, Integer>>() {

@Override

public void processElement(String word, ProcessFunction<String, Tuple2<String, Integer>>.Context ctx, Collector<Tuple2<String, Integer>> out) throws Exception {

//侧输出流

ctx.output(tag1, word);

out.collect(Tuple2.of(word, 1));

}

}).keyBy(w -> w, Types.TUPLE(Types.STRING, Types.INT)).process(new KeyedProcessFunction<Tuple2<String, Integer>, Tuple2<String, Integer>, Tuple2<String, Integer>>() {

private ValueState<Integer> valueState;

@Override

public void open(Configuration parameters) throws Exception {

//设置状态初始值

valueState = getRuntimeContext().getState(new ValueStateDescriptor<Integer>("word-count", Integer.class, 0));

}

@Override

public void processElement(Tuple2<String, Integer> value, KeyedProcessFunction<Tuple2<String, Integer>, Tuple2<String, Integer>, Tuple2<String, Integer>>.Context ctx, Collector<Tuple2<String, Integer>> out) throws Exception {

//获取初始值

Integer countV = valueState.value();

//把同一个key的值进行累加 并更新状态初始值

countV += value.f1;

valueState.update(countV);

ctx.output(tag2, countV);

//输出数据

out.collect(Tuple2.of(value.f0, countV));

}

});

//获取侧输出流数据

process.getSideOutput(tag1).print("sideOutput1");

process.getSideOutput(tag2).print("sideOutput1");

//主通道输出

process.print();

environment.execute();

}

}

9、时间语义

- Event Time(事件时间)

事件时间就是每个事件在其生产设备发生的时间。这个时间通常记录在进入Flink之前嵌入在记录中,并且可以从每个记录中提取事件时间戳!指的是数据本身携带的时间,这个时间是在事件产生时的时间,对于乱序、延时、或者数据重放情况,都能给出正确的结果。

例如:充值数据

- Ingestion time(摄入时间)

摄入时间指的是数据进入flink的时间。

- processing time(处理时间)

处理时间指正在执行相应操作的机器系统时间,当流式程序在基于时间运行时,所有的时间的操作都使用运行相应机器系统时钟。处理时间容易受流和机器之间传输的影响具有不确定性,但是提供了最佳的性能和最低的延迟。

例如:秒杀数据

- 代码实现

时间语义要为窗口计算服务,flink1.12以前,默认以处理时间作为默认时间语义,可以在环境上设置所想要的时间语义,但是新版本已经过时

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

DataStreamSource<String> source = environment.fromElements("hadoop", "spark", "flink", "clickhouse");

//1.12老版本写法 以事件时间为默认时间

environment.setStreamTimeCharacteristic(TimeCharacteristic.EventTime);

//设置摄入时间

environment.setStreamTimeCharacteristic(TimeCharacteristic.IngestionTime);

//以处理时间当做时间标准

environment.setStreamTimeCharacteristic(TimeCharacteristic.ProcessingTime);

flink1.12以后,flink默认以事件时间作为默认的时间语义。

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

DataStreamSource<String> source = environment.fromElements("hadoop", "spark", "flink", "clickhouse");

//1.12版本以后写法 以处理时间为默认时间

source.keyBy(x->x).window(SlidingEventTimeWindows.of(Time.seconds(5),Time.seconds(1)));

source.keyBy(x->x).window(SlidingProcessingTimeWindows.of(Time.seconds(5),Time.seconds(1)));

source.keyBy(x->x).window(TumblingEventTimeWindows.of(Time.seconds(5),Time.seconds(1)));

environment.execute();

10、Flink窗口函数

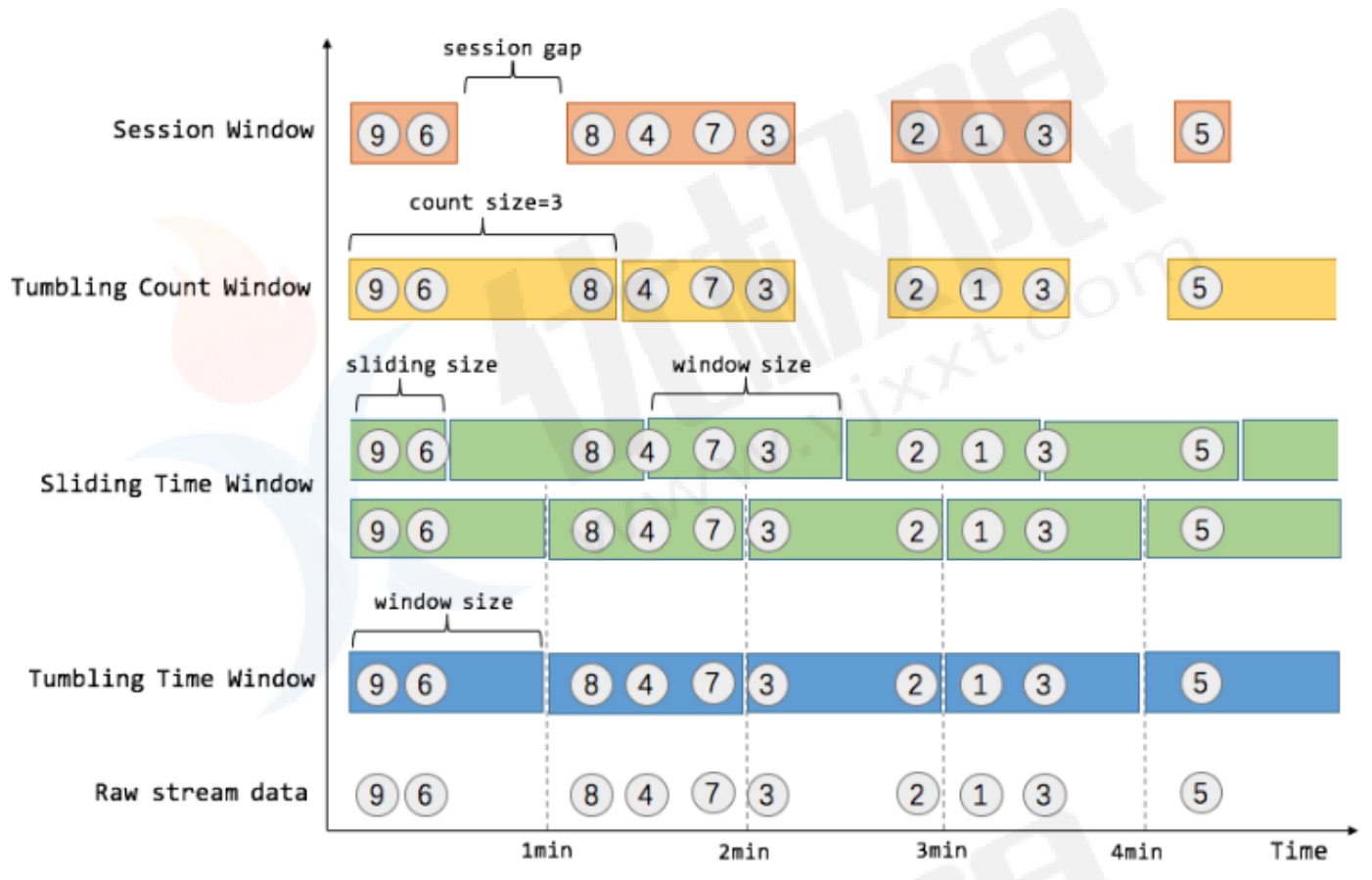

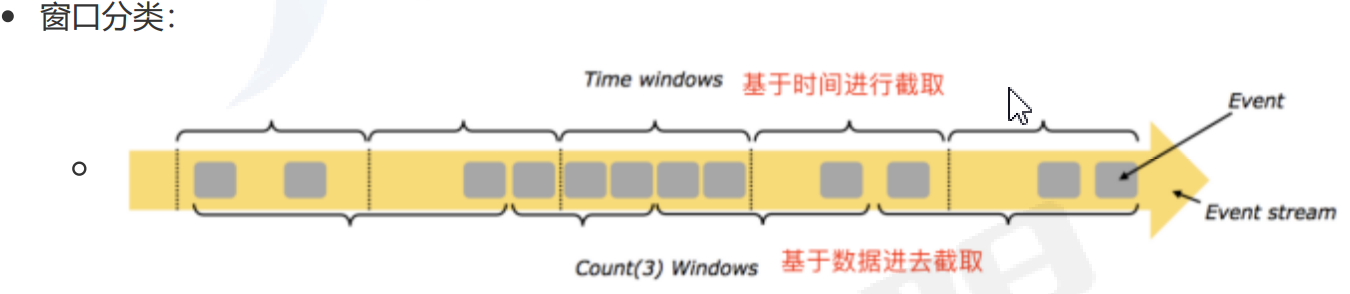

- 基本概念

在流处理应用中,数据是连续不断的,如果我们需要对数据进行聚合处理,就需要设置一个窗口,并对这个窗口内的数据进行计算。例如:在过去1min内有多少用户点击了我们的网页等。

Windows是flink处理无限流的核心,Windows将流拆分为有限大小的”桶“,可以在其应用上进行计算。Flink认为Batch是Streaming的一个特例,所以需要在一个窗口内对数据进行计算。而窗口(window)就是从 Streaming 到 Batch 的一个桥梁。Flink 提供了 非常完善的窗口机制。

基于时间划分驱动,例如:每30s

基于数据数量驱动,例如:每一百个元素,与时间无关。

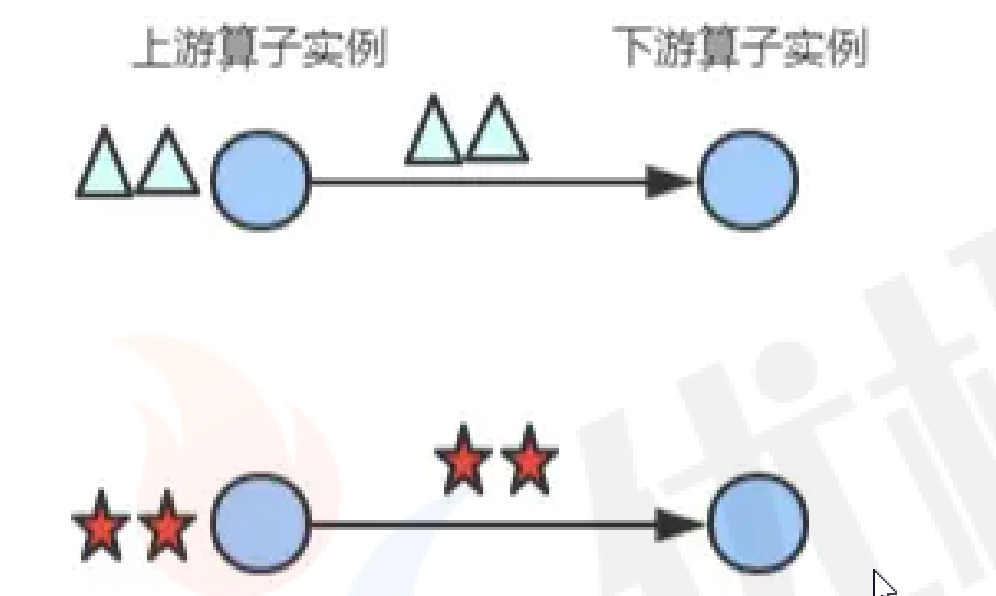

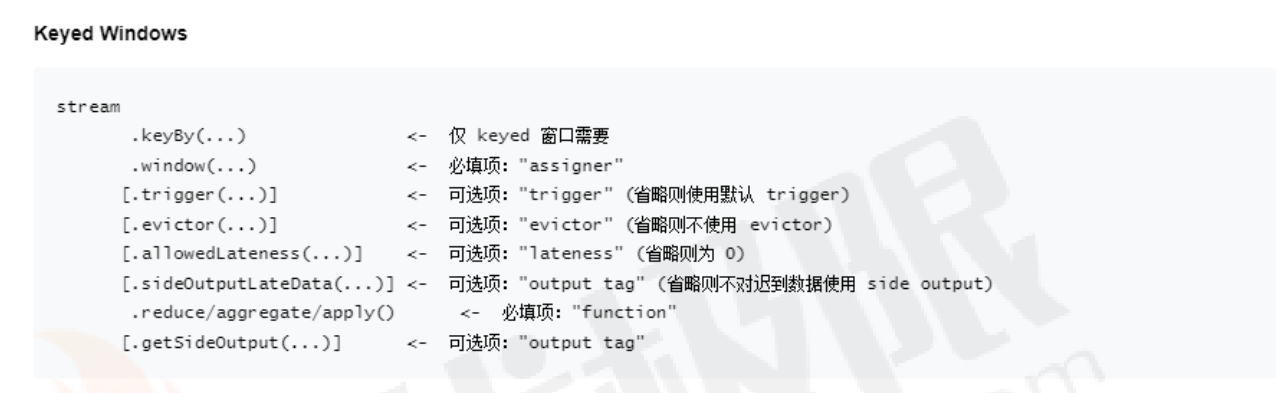

- Keyed&non-keyed

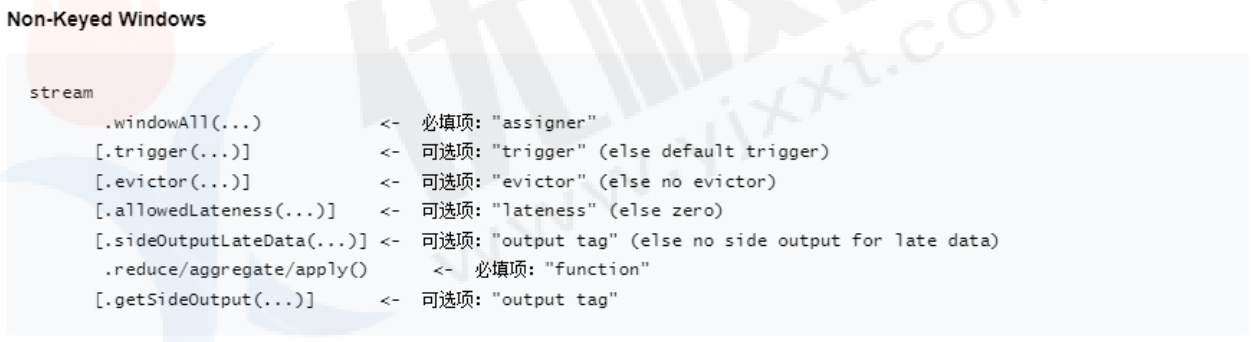

Flink 窗口在 keyed streams 和 non-keyed streams 上使用的基本结构:

- keyed streams 要调用 keyBy(...) 后再调用 window(...) 。

- non-keyed streams 直接调用 windowAll(...) 。

- 区别:一个计算每个分区内数据,一个计算全量数据。

定义窗口前确定的是你的Stream是keyed还是non-keyed:对于keyed stream,其中数据的任何属性都可以作为key。属于同一个key的元素会被发送到同一个task,使用keyed stream允许你的窗口计算由多个task并行,每个逻辑上的keyed stream都可以单独被处理。

- count window

分区后计数窗口基于元素的个数来截取数据,每个分区中相同key达到固定个数就触发计算并关闭窗口。相当于座位有限,”人满就发车“,是否发车与时间无关,每个窗口截取数据的个数就是窗口大小。

//countWindows(3)相当于滚动3个数据为一个窗口 countWindows(3,2)相当于在窗口大小为3个数据滑动2个数据进行计算

source.map(x-> Tuple2.of(x,1), Types.TUPLE(Types.STRING,Types.INT)).keyBy(x->x.f0,Types.STRING).countWindow(3,2).sum(1).print("3个数据为一个窗口计算一次");

- Window All

不分区计算窗口基于元素个数来截取数据,达到固定个数就触发计算并关闭窗口,通俗点就是要数据个数达到设置的个数据就进行计算!

package com.zwf.windowFunction;

import org.apache.flink.api.common.time.Time;

import org.apache.flink.api.common.typeinfo.Types;

import org.apache.flink.api.java.tuple.Tuple2;

import org.apache.flink.streaming.api.datastream.DataStreamSource;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

/**

* @author MrZeng

* @version 1.0

* @date 2024-01-02 20:03

*/

public class CountWindowAllDemo {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

DataStreamSource<String> source = environment.socketTextStream("localhost", 9999);

//countWindowAll不能加keyBy()

source.map(x->{

String[] values = x.split(":");

return Tuple2.of(values[0],Integer.parseInt(values[1]));

//countWindowAll(3) 相当于窗口大小等于滑动窗口大小变成窗口滚动(tumbling)

//countWindowAll(3,2) 在窗口大小为3的窗口内滑动2个数据进行计算关闭窗口(sliding) 。

}, Types.TUPLE(Types.STRING,Types.INT)).countWindowAll(3,2).reduce((x1,x2)->{

x1.f1+=x2.f1;

return x1;

}).print("window all");

environment.execute();

}

}

总结:countwindow分为keyed和no-keyed,keyed是在指定同key的数据达到固定个数进行计算,而no-keyed只要数据个数达到固定个数就进行计算。

缺陷:如果上游数据个数不稳定,就会造成处理时间不确定!

- TimeWindow

为了弥补CountWindow()的缺失,flink又推出了时间窗口函数,时间窗口是最常用的窗口函数,可以分为滚动、滑动和会话三种。

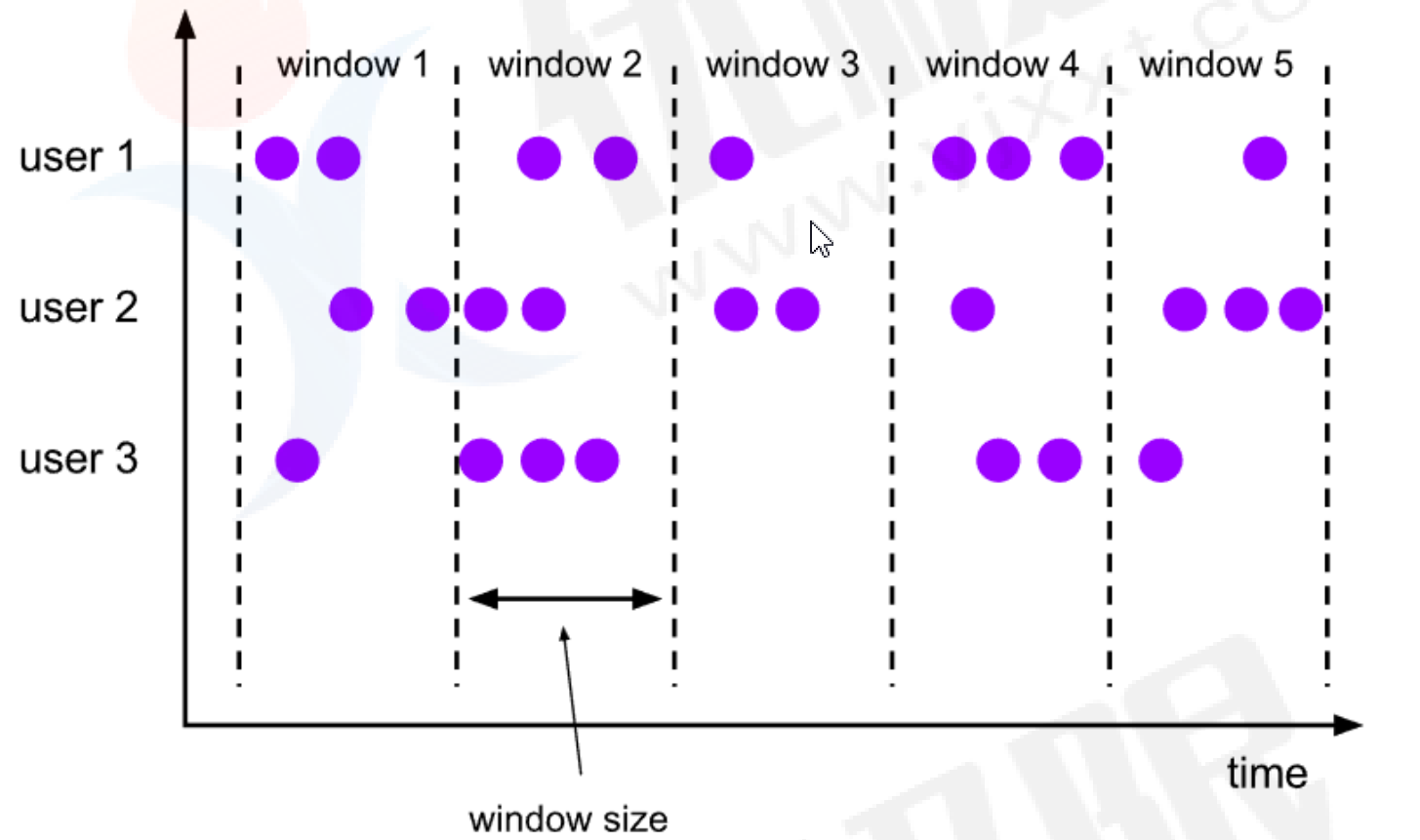

- 翻滚窗口(Tumbling Window,无重叠)

- 滑动窗口(Sliding Window,有重叠)

- 会话窗口(Session Window,活动间隙)

除了Flink自定义的,还可以继承WindowAssigner类来实现自定义Window Assigner

所有内置的window assigner(除了global window)都是基于时间分发数据的,process time或event time均可。

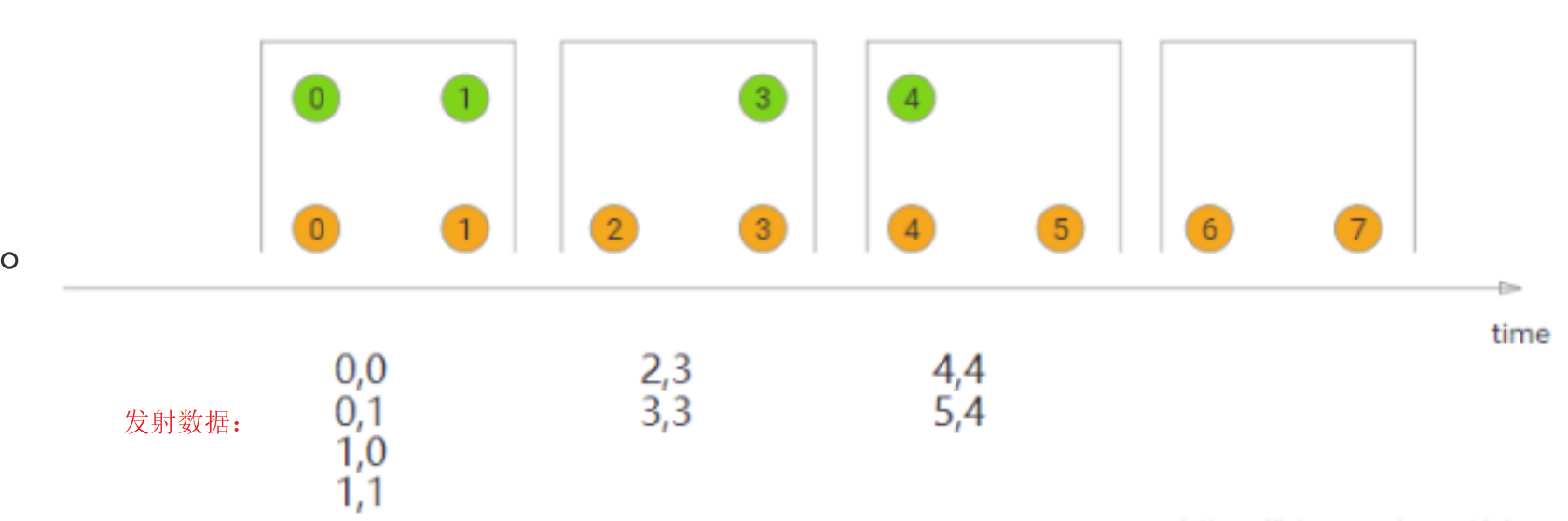

- Tumbling Window

滚动窗口的assigner分发元素到指定大小的窗口;滚动窗口大小是固定的,各自范围之间不重叠;如果你指定了窗口大小为5分钟,每5分钟就有一个窗口被计算,新窗口被创建。

- 案例(keyed 滚动窗口案例)

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

DataStreamSource<String> source = environment.socketTextStream("localhost", 6379);

source.map(x->{

String[] values = x.split(":");

return Tuple2.of(values[0],Integer.valueOf(values[1]));

}, Types.TUPLE(Types.STRING,Types.INT)).keyBy(x->x.f0).window(TumblingProcessingTimeWindows.of(Time.seconds(5))).reduce((x1, x2)->{

x1.f1+=x2.f1;

return x1;

//处理时间要放在下游

}).map(y-> {

y.f0=LocalDateTime.now().format(DateTimeFormatter.ofPattern("yyyy年MM月dd日HH 时mm分ss秒SSS毫秒"))+"[处理时间:]"+y.f0;

return y;

},Types.TUPLE(Types.STRING,Types.INT)).print("时间窗口聚合").setParallelism(1);

environment.execute();

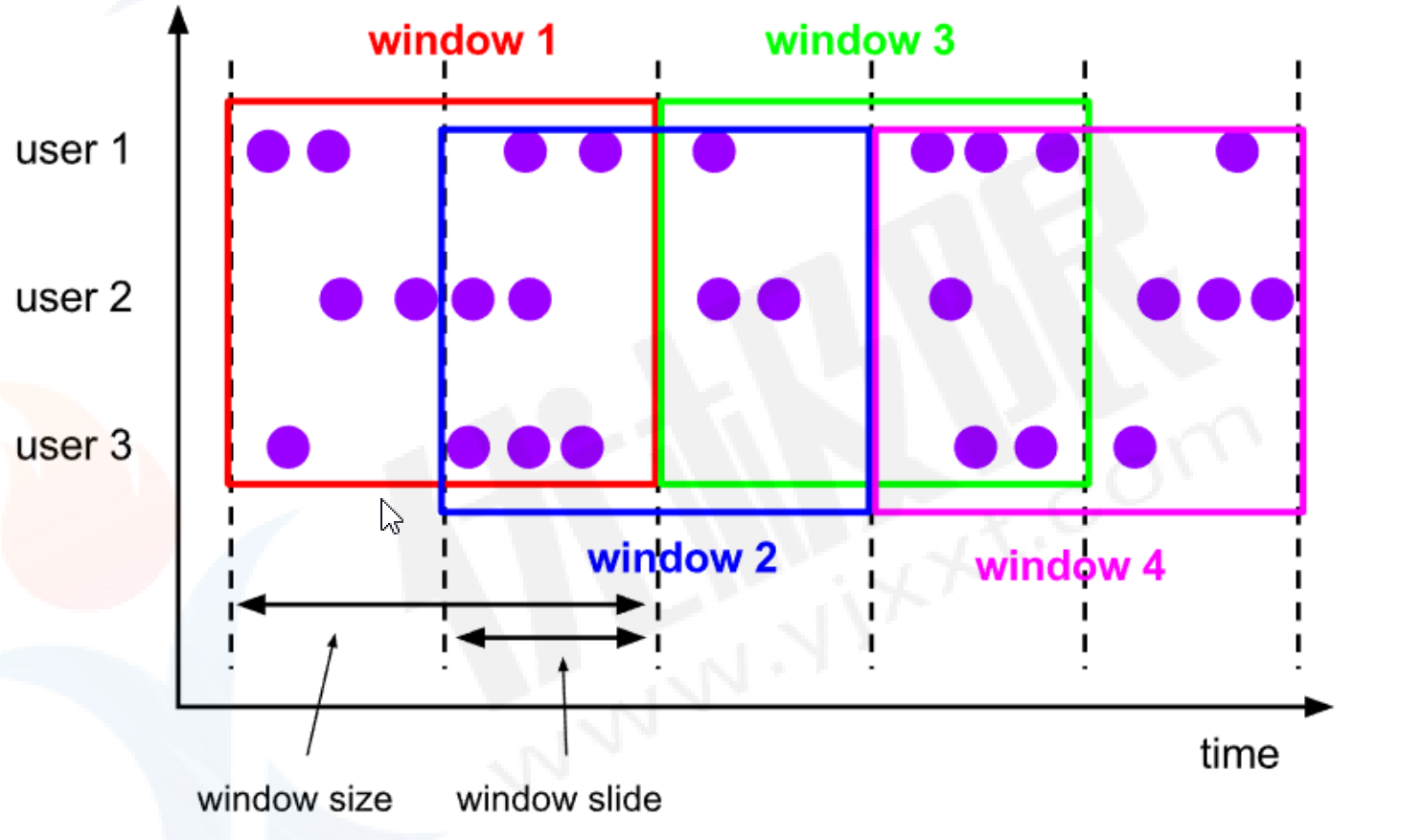

- Sliding Window

滑动窗口的 assigner 分发元素到指定大小的窗口,窗口大小通过 window size 参数设置。

滑动窗口需要一个额外的滑动距离(window slide)参数来控制生成新窗口的频率。

如果滑动窗口时间大小等于窗口时间大小,窗口元素滚动!(只设置窗口大小,不设置滑动间隔)

如果滑动窗口时间大小小于窗口时间大小,数据有重叠!

如果滑动窗口时间大小大于窗口时间大小,数据集有丢失!

- 案例(no-keyed滑动窗口案例)

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

DataStreamSource<String> source = environment.socketTextStream("localhost", 9999);

source.map((x)-> {

String[] split = x.split(":");

return Tuple2.of(split[0],Integer.valueOf(split[1]));

}, Types.TUPLE(Types.STRING,Types.INT)).windowAll(SlidingProcessingTimeWindows.of(Time.seconds(5),Time.seconds(2))).reduce((y1,y2)-> {

y1.f1 +=y2.f1;

return y1;

}).map(x->{

x.f0+="[处理时间:]"+ LocalDateTime.now().format(DateTimeFormatter.ofPattern("yyyy年MM月dd日HH 时mm分ss秒SSS毫秒"));

return x;

},Types.TUPLE(Types.STRING,Types.INT)).print().setParallelism(1);

environment.execute();

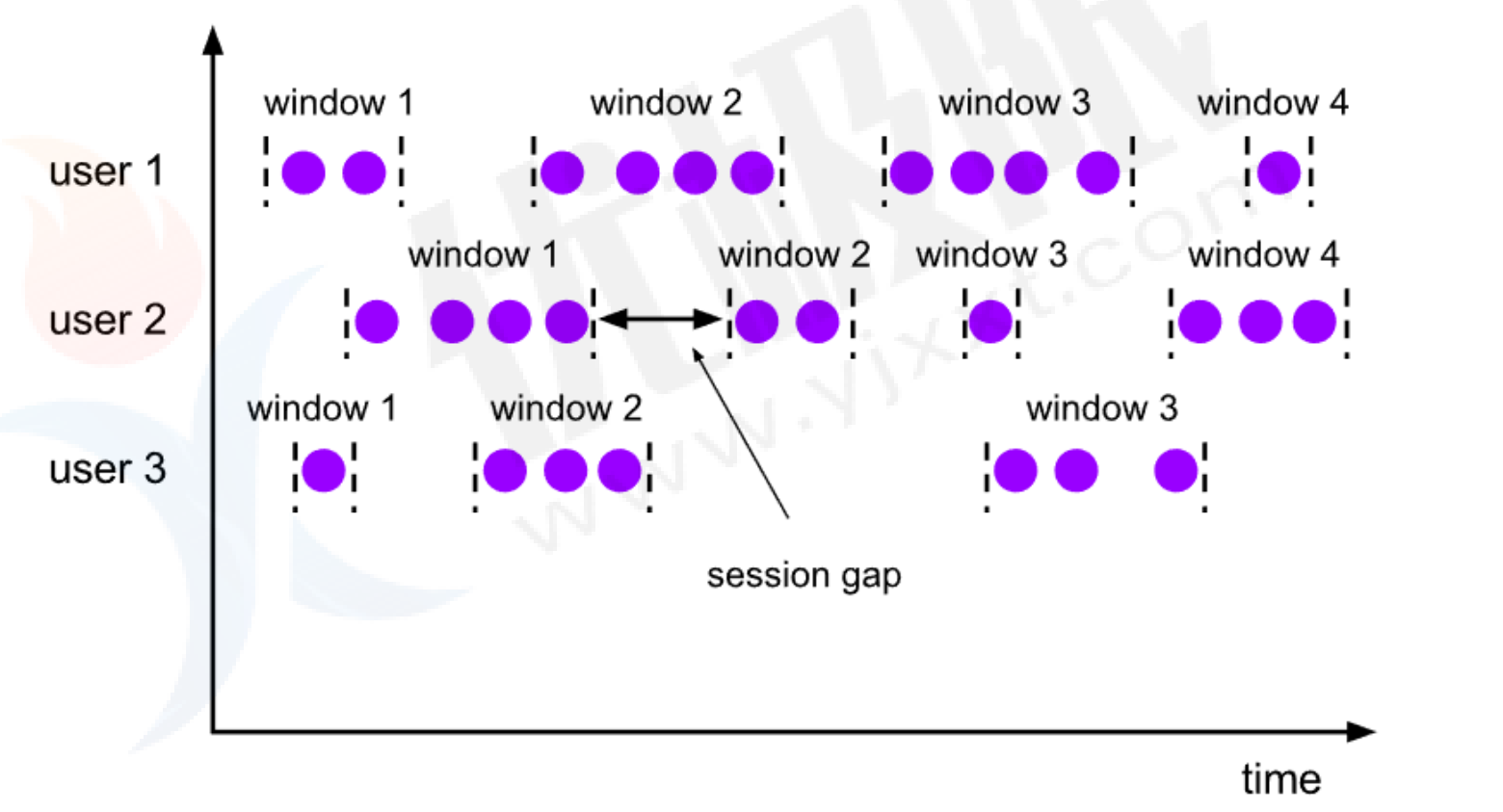

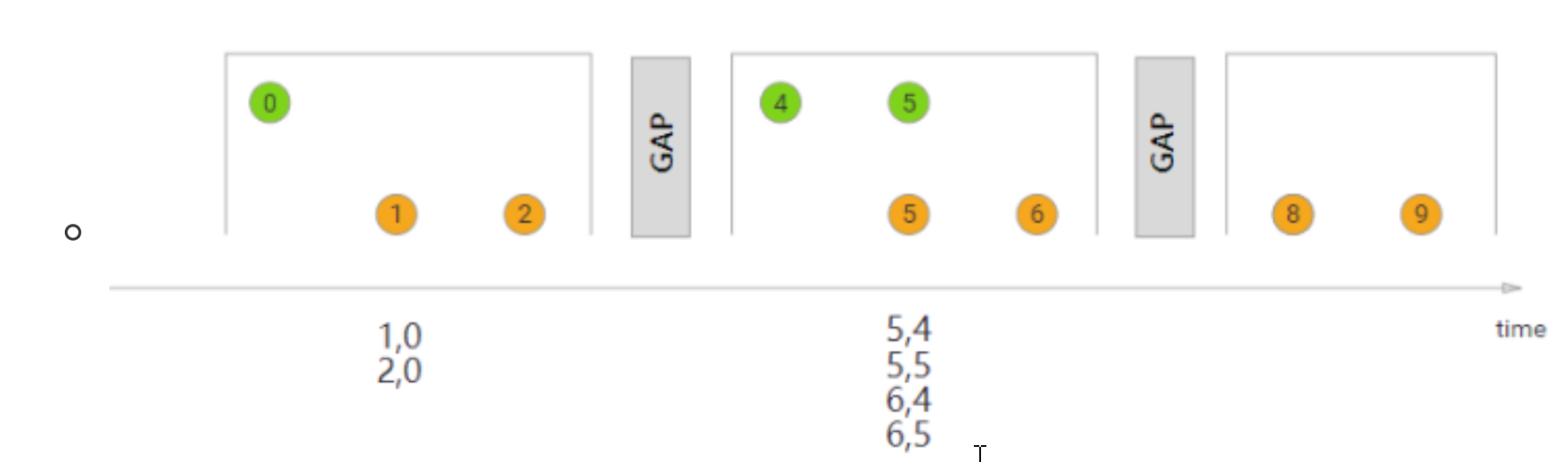

- Session Windown

会话窗口的 assigner 会把数据按活跃的会话分组。与滚动时间和滑动窗口不同的是会话窗口不会相互重叠,没有固定开始和结束时间。会话窗口设置固定的会话间隔或者用会话间隔函数动态定义时间算作不活跃。超出不活跃时间段,会话就关闭,接下来的数据发到新会话窗口。

- 案例

//session会话 只要在会话间隔时间内有数据输入就不会计算 超过会话间隔输入/不输入数据都会计算!

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

DataStreamSource<String> source = environment.socketTextStream("localhost", 6666);

source.map(x->{

String[] split = x.split(":");

return Tuple2.of(split[0],Integer.valueOf(split[1]));

}, Types.TUPLE(Types.STRING,Types.INT)).keyBy(x->x.f0).window(ProcessingTimeSessionWindows.withGap(Time.seconds(3))).reduce((y1,y2)->{

y1.f1+= y2.f1;

return y1;

}).map(x->{

x.f0+="[时间间隔]"+ LocalDateTime.now().format(DateTimeFormatter.ofPattern("yyyy年MM月dd日HH 时mm分ss秒SSS毫秒"));

return x;

},Types.TUPLE(Types.STRING,Types.INT)).print();

environment.execute();

- global windows

GlobalWindows作为一个全局的窗口分配器,它不像TimeWindow或CountWindow那样通过元素 个数来划分成一个个窗口,而是把分区内所有的元素分配到同一个窗口,所以说如果没有定义触发器,那么整个subTask中就只有一个窗口,且一直存在,不会触发计算。(自定义触发计算逻辑)

窗口模式仅在你指定了自定义的[trigger]时有用。 否则,计算不会发生,因为全局窗口没有天然的终点去触发其中积累的数据。

window和windowAll区别:

- window只能在已经分区的 KeyedStream 上定义,通过KeyedStream转化为 WindowedStream执行具体的开窗操作。

- windowAll只能在未分区的DataStream上定义,调用windowAll方法后,会把DataStream转 化为AllWindowedStream,并得到全局统计结果。也就是说WindowAll并行度只能1,且不可设置并行度。

- 案例(自定义globalwindowfunction函数)

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

DataStreamSource<String> source = environment.socketTextStream("localhost", 8888);

source.map(x->{

String[] split = x.split(":");

return Tuple2.of(split[0],Integer.valueOf(split[1]));

//自定义同一个key 5个数据计算一次 通过触发器设置

}, Types.TUPLE(Types.STRING,Types.INT)).keyBy(x->x.f0).window(GlobalWindows.create()).trigger(PurgingTrigger.of(CountTrigger.of(5))).reduce((y1, y2)->{

y1.f1+=y2.f1;

return y1;

}).map(x->{

x.f0+="[处理时间]"+ LocalDateTime.now().format(DateTimeFormatter.ofPattern("yyyy年MM月dd日HH 时mm分ss秒SSS毫秒"));

return x;

},Types.TUPLE(Types.STRING,Types.INT)).print("global window function");

environment.execute();

- 案例(no-keyed 自定义globalwindowfunction函数)

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

DataStreamSource<String> source = environment.socketTextStream("localhost", 8888);

source.map(x->{

String[] split = x.split(":");

return Tuple2.of(split[0],Integer.valueOf(split[1]));

//自定义全量数据 5个数据计算一次

}, Types.TUPLE(Types.STRING,Types.INT)).windowAll(GlobalWindows.create()).trigger(CountTrigger.of(5)).reduce((y1, y2)->{

y1.f0+="_"+y2.f0;

y1.f1+=y2.f1;

return y1;

}).map(x->{

x.f0+="[处理时间]"+ LocalDateTime.now().format(DateTimeFormatter.ofPattern("yyyy年MM月dd日HH 时mm分ss秒SSS毫秒"));

return x;

},Types.TUPLE(Types.STRING,Types.INT)).print("global window function");

environment.execute();

11、增量聚合函数

增量聚合函数有ReduceFunction和AggregateFunction两种,其中reduceFunction必须要求进出数据类型必须以一致,因此我们传入数据时,必须把数据转为输入时的数据格式再输出!

AggregateFunction可以看做是ReduceFunction的通用版本,可以不要求输入和输出数据一致,里面有四个实现方法:

- createAccumulator():创建一个累加器,这就是为聚合创建了一个初始状态,每个聚合任务只会调用一次。

- add():传入新的value值和累加器的值,对新的数据进一步聚合过程,返回一个新的累加器值。每条数据到来之后都会调用这个方法。

- getResult():这个方法只在窗口要输出结果时调用。

- merge():合并两个累加器,并将合并后的状态作为一个累加器返回。这个方法只在需要合并窗口 的场景下才会被调用;常见的合并窗口就是会话窗口(Session Windows)

总结:来一条加一条数据,达到特定的触发条件输出计算结果!

- 案例(reduce案例)

//增量函数

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

DataStreamSource<String> source = environment.socketTextStream("localhost", 9999);

source.map(w->{

String[] split = w.split(":");

return Tuple2.of(split[0],Integer.valueOf(split[1]));

}, Types.TUPLE(Types.STRING,Types.INT)).keyBy(x->x.f0).countWindow(3).reduce((t1,t2)->{

System.out.println("窗口增量计算函数来一条算一条.main["+t1+"]["+t2+"]");

t1.f0=t1.f0+"_"+t2.f0;

t1.f1=t1.f1+t2.f1;

return t1;

}).print("count--Tumbling").setParallelism(1);

environment.execute();

- 案例( Aggregate案例 求平均数)

//自定义聚合函数

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

DataStreamSource<String> source = environment.socketTextStream("localhost", 9999);

source.map(x->{

String[] split = x.split(":");

return Tuple2.of(split[0],Integer.valueOf(split[1]));

//3行同一个key值数据计算一次 滚动计算

}, Types.TUPLE(Types.STRING,Types.INT)).keyBy(x->x.f0).countWindow(3).aggregate(

//三个泛型 输入数据类型 中间累加数据类型 输出数据类型

new AggregateFunction<Tuple2<String, Integer>, Tuple3<String,Integer, Integer>, Tuple2<String,Double>>() {

@Override

public Tuple3<String, Integer, Integer> createAccumulator() {

return Tuple3.of(null, 0, 0);

}

@Override

public Tuple3<String, Integer, Integer> add(Tuple2<String, Integer> value, Tuple3<String, Integer, Integer> accumulator) {

accumulator.f1 = value.f1 + accumulator.f1;

accumulator.f0 = value.f0;

accumulator.f2++;

return accumulator;

}

@Override

public Tuple2<String, Double> getResult(Tuple3<String, Integer, Integer> accumulator) {

Double avg = accumulator.f1 * 1.0 / accumulator.f2;

return Tuple2.of(accumulator.f0, avg);

}

@Override

public Tuple3<String, Integer, Integer> merge(Tuple3<String, Integer, Integer> a, Tuple3<String, Integer, Integer> b) {

return null;

}

}).print();

environment.execute();

12、全量聚合函数

全量聚合函数在一个窗口触发特定条件时,只计算一次并输出结果,没有触发特定条件过程中,不会进行计算!

常见的全量窗口函数:

- apply(windowFunction<>())

- process(processFunction<>())

- 案例

//全量数据聚合

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

DataStreamSource<String> source = environment.socketTextStream("localhost", 8888);

//使用name:数字

source.map(x->{

String[] value = x.split(":");

return Tuple2.of(value[0],Integer.parseInt(value[1]));

/**

* Tuple2<String, Integer>:输入参数

* Tuple3<String,Integer,String>:输出参数:key,值,窗口信息

*/

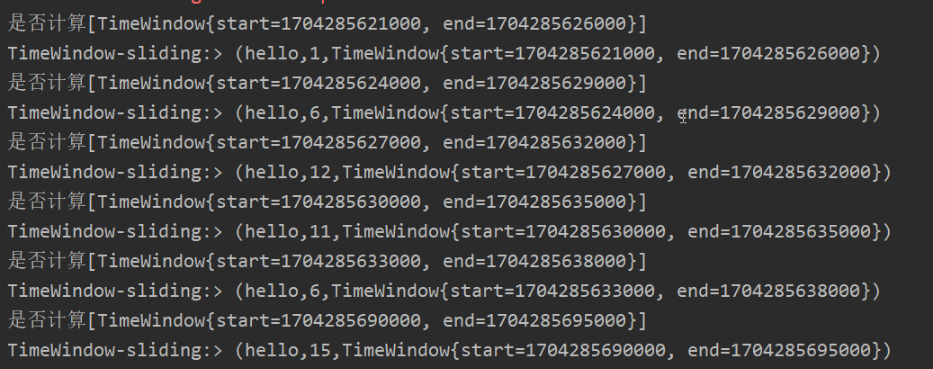

}, Types.TUPLE(Types.STRING,Types.INT)).keyBy(k->k.f0).window(SlidingProcessingTimeWindows.of(Time.seconds(5),Time.seconds(3))).apply(new WindowFunction<Tuple2<String, Integer>, Tuple3<String,Integer,String>, String, TimeWindow>() {

/**

* @param s key值

* @param window 有GlobalWindow和TimeWindow.

* @param input 输入的数据集合 迭代输入

* @param out 输出参数

- *

*/

@Override

public void apply(String s, TimeWindow window, Iterable<Tuple2<String, Integer>> input, Collector<Tuple3<String, Integer, String>> out) throws Exception {

System.out.println("是否计算"+"["+window+"]");

//结果变量

int sum=0;

for (Tuple2<String, Integer> integerTuple2 : input) {

sum+=integerTuple2.f1;

}

out.collect(Tuple3.of(s,sum,window.toString()));

}

}).print("TimeWindow-sliding:").setParallelism(1);

environment.execute();

13、WaterMark

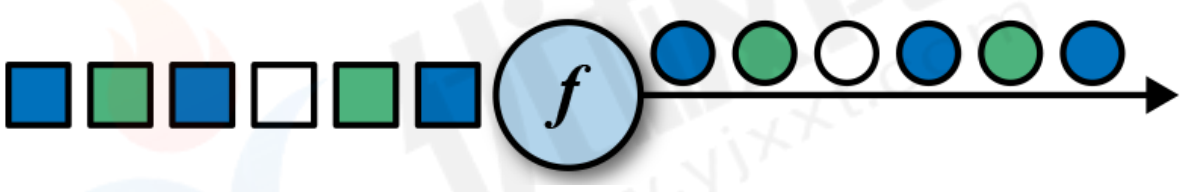

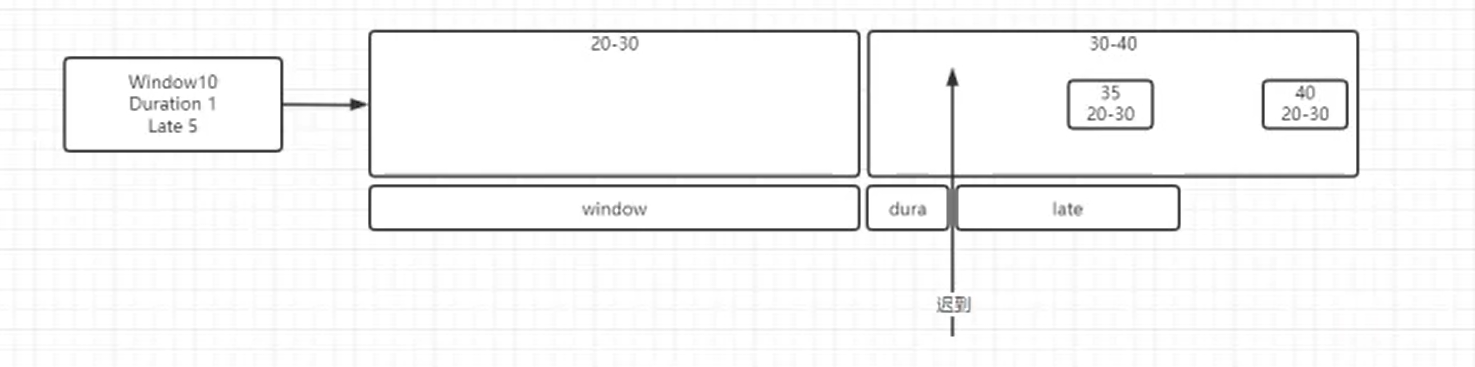

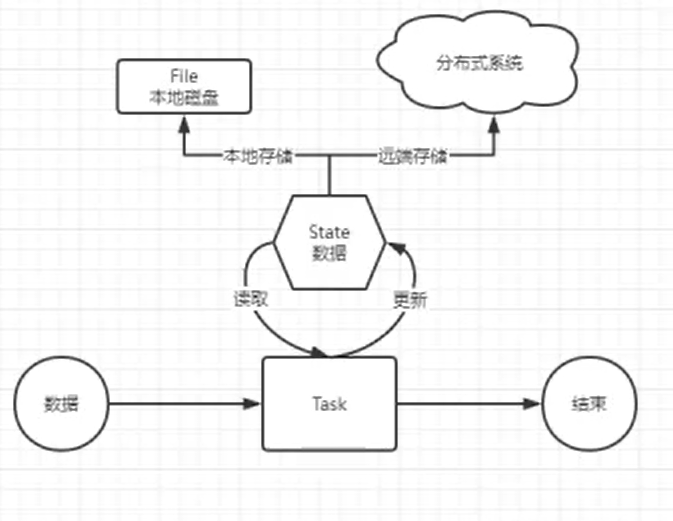

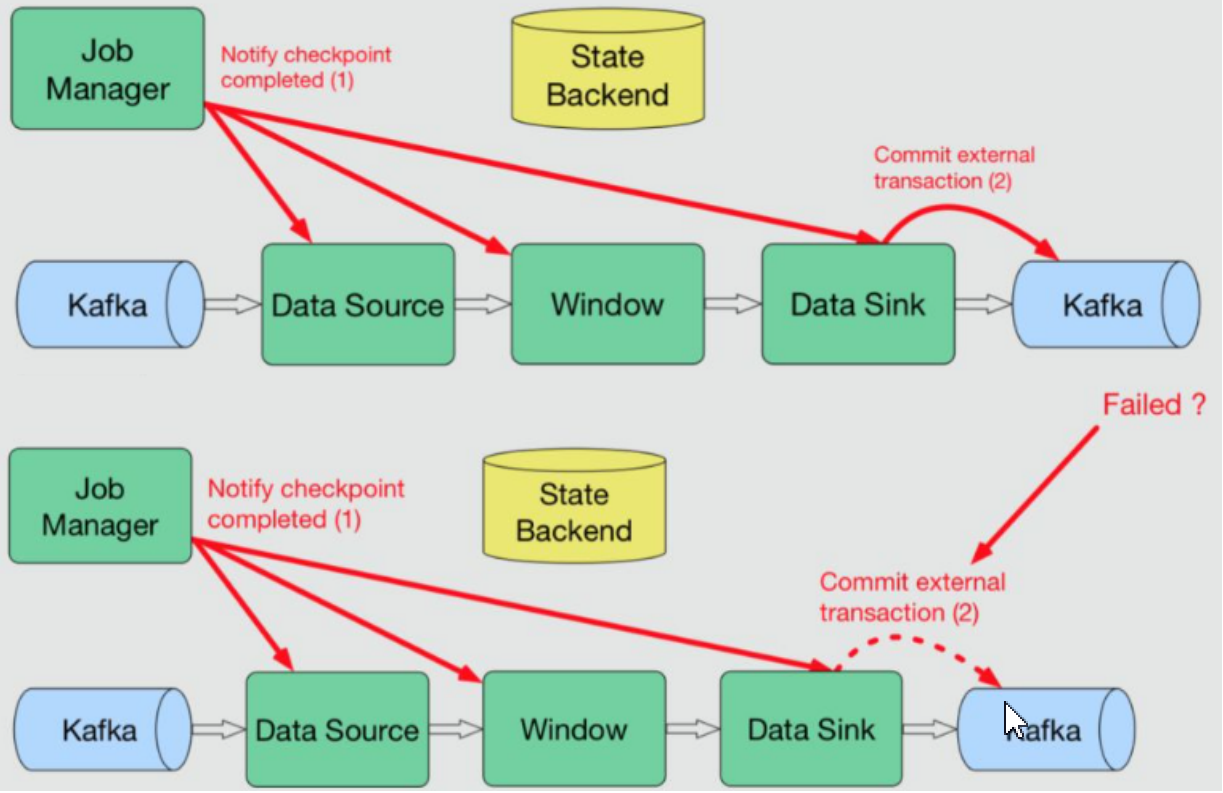

“水位线”就是用来度量事件时间。程序使用事件时间就需要水位线,水位线设置是为了解决"迟到数据",所谓”迟到数据“就是在先产生的数据(时间戳小)没有在后产生的数据(时间戳大)前面进行计算消费,也是为了统一flink系统时间,解决数据在网络延迟、IO传输过程中造成事件时间乱序问题。

"时间所剩不多了"-------->快迟到了! 先到先处理,先到时间戳越小!正常时间戳随着时间流逝,时间戳不断增加!

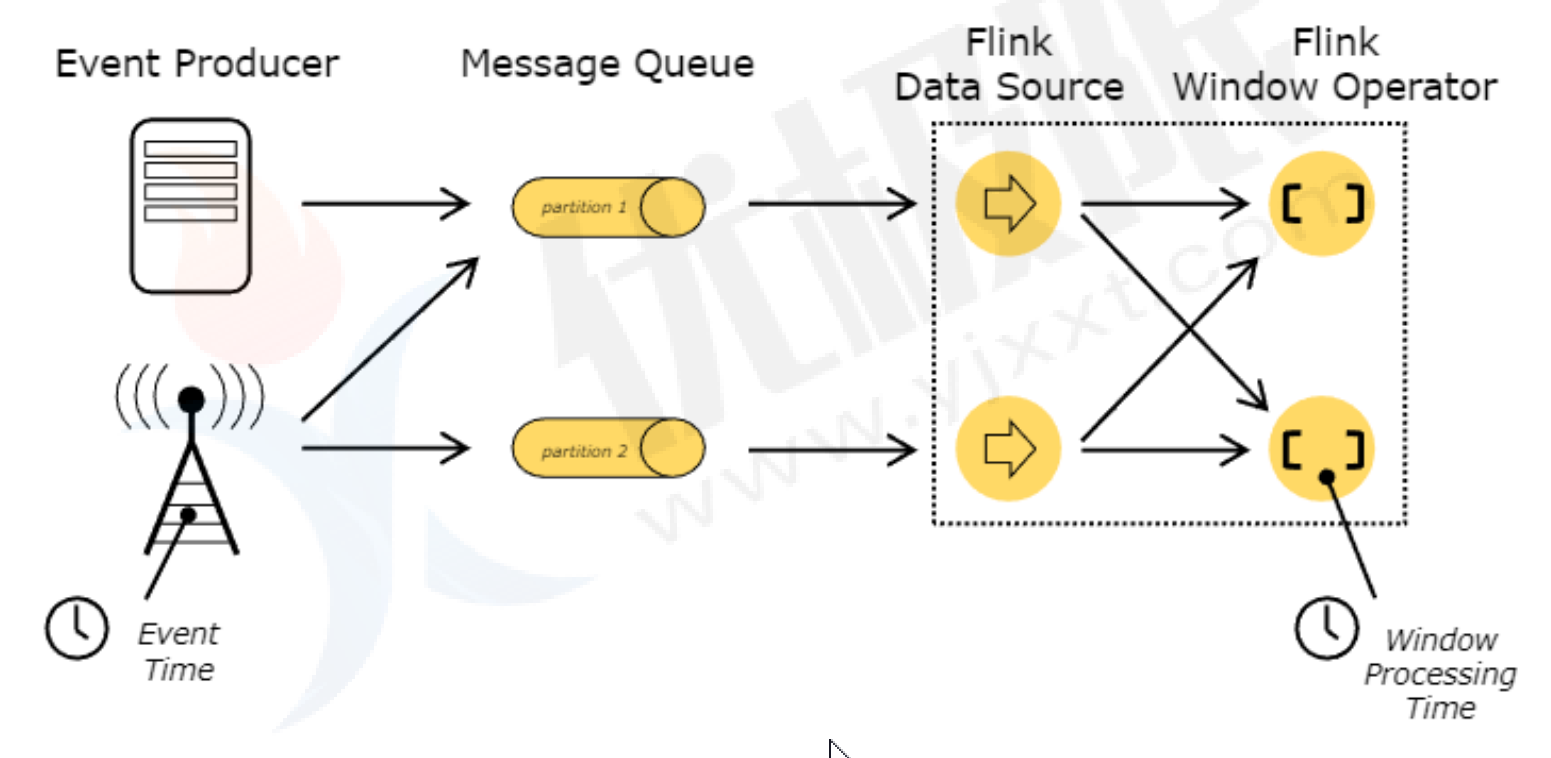

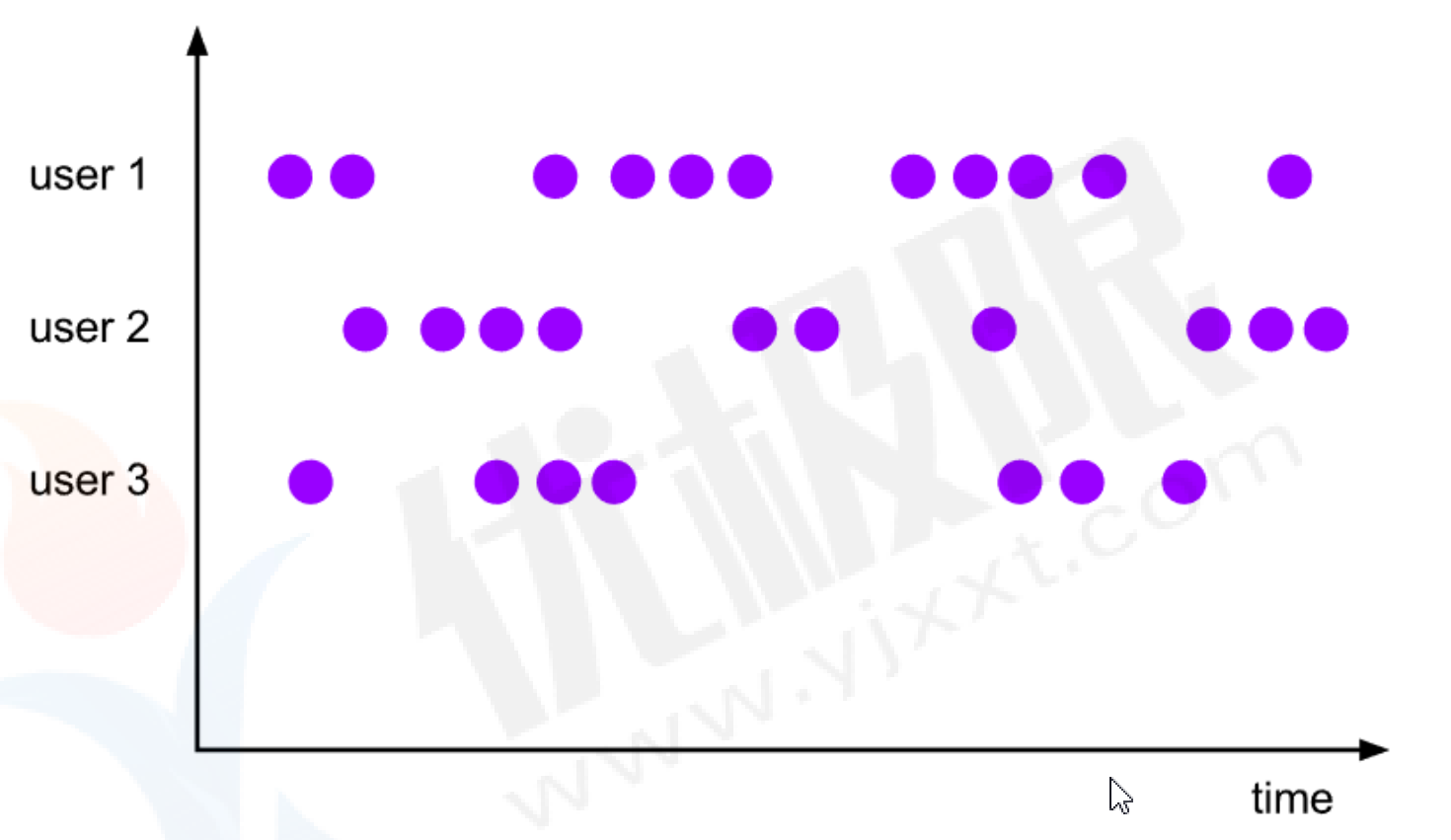

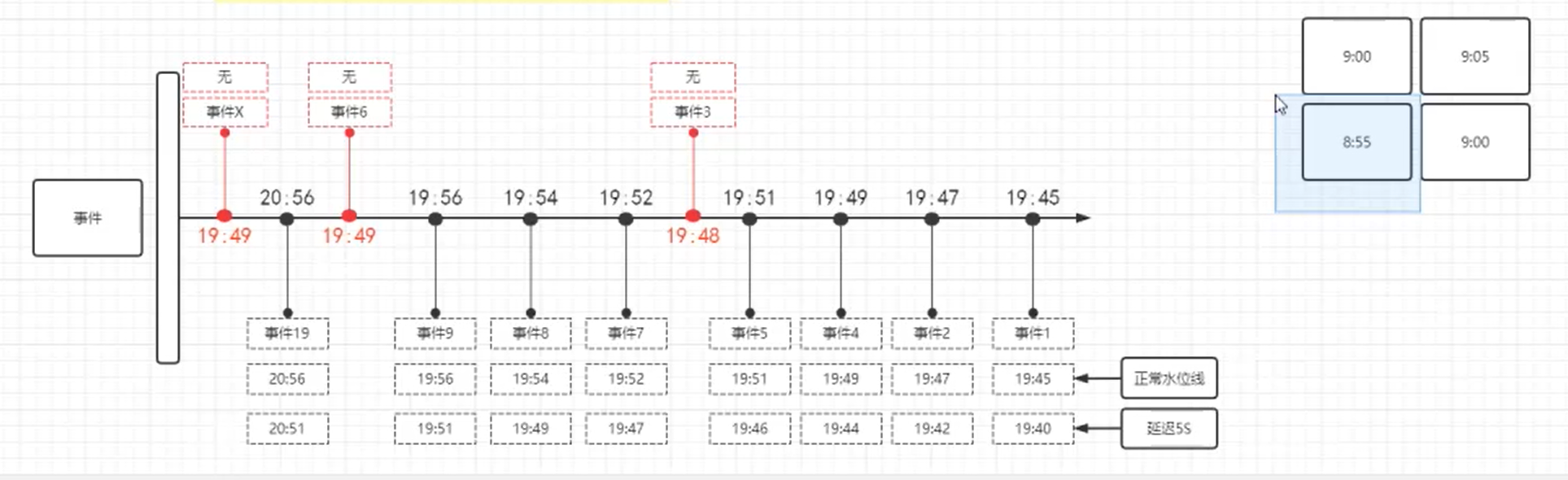

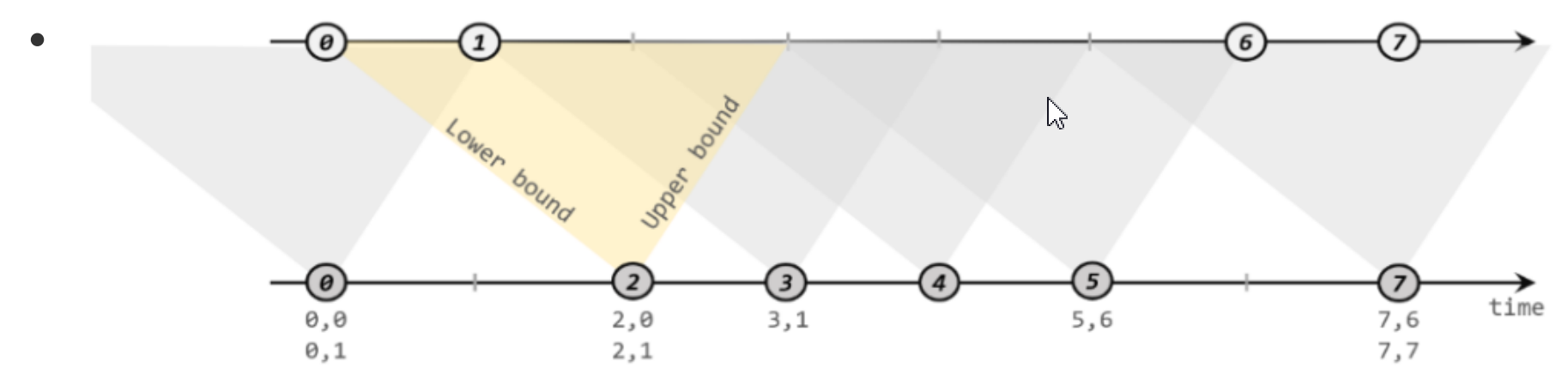

图中每个事件时间戳是距离处理时间(水位线)的毫秒数,事件数据从左往右时间戳越来越小,时间戳越小数据生成越早越先被处理,时间戳越大表示数据生成越晚处理越晚,意味着最理想状态是在最大时间戳事件前处理完所有小时间戳数据。比如:到了8:20进行数据计算处理,但是8:10事件数据还没到,为了等待8:10事件数据,设置水位线为8:30,也就是8:30再进行处理,把时间戳拉长(晚一点处理)。

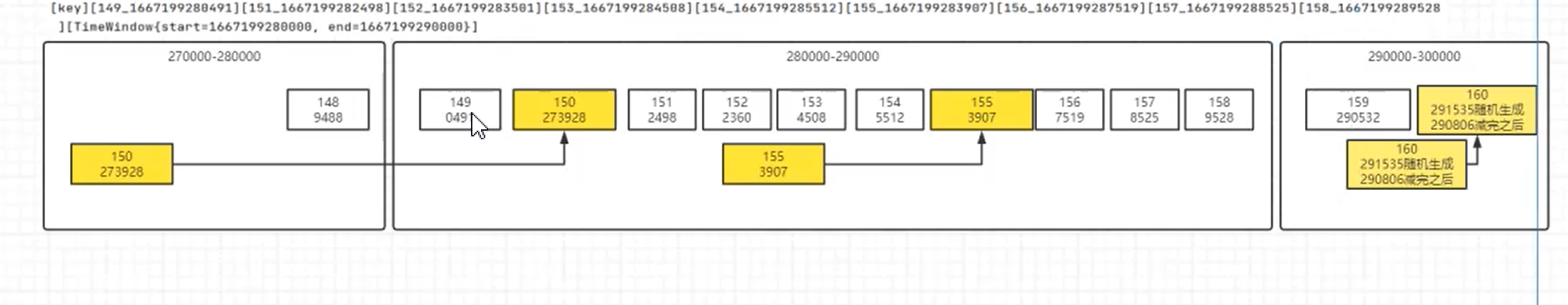

如果事件时间戳小于水位线并且比水位线时间戳还要晚处理就会造成数据迟到,此时需要设置水位线延迟时间(时间戳变小),把迟到的数据纳入窗口进行计算,如果迟到数据时间戳还是比延迟时间戳小并且在延迟时间后面处理,那么数据抛弃或者再设置允许迟到时间!

公式:事件时间 - 延迟时间 >= 窗口最大时间 + 允许迟到时间 (事件时间-延迟时间也是水位线时间)

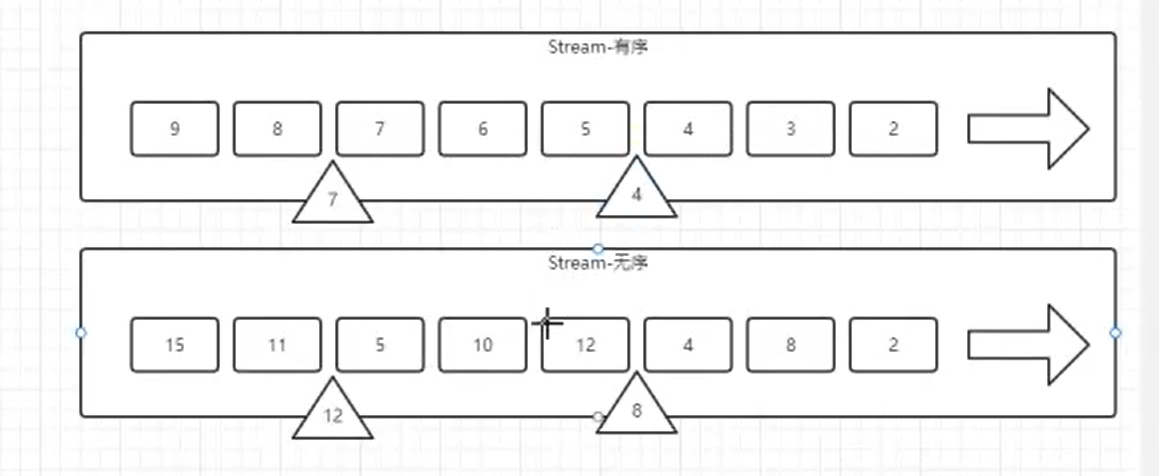

单并行度下,使用全量窗口函数等事件时间超过每个窗口的水位线时间才触发计算,每个窗口下水位线是窗口内事件最大时间戳(就是窗口内最晚的数据)。

多并行度下,多个并行度传输数据,会以最小时间戳并行度时间广播到下游窗口中设置为水位线。

- 案例(数据有序设置水位线案例)

对于有序流,主要特点就是时间戳单调增长(Monotonously Increasing Timestamps),所以永远不会出现迟到数据的问题。

直接调用WatermarkStrategy.forMonotonousTimestamps()方法就可以实现。

直接拿当前最大的时间戳作为水位线就可以了。

public static void main(String[] args) throws Exception {

//事件时间读取 代码没加水位线 无法计算

new Thread(()->{

//生成随机值发送到kafka中

for(int i=0;i<200;i++) {

String randDigest = RandomStringUtils.randomAlphabetic(8).toLowerCase(Locale.ROOT);

KafkaProducer<String, String> producer = KafkaUtils.getProducer();

//插入有序数据

String s = String.valueOf(System.currentTimeMillis());

ProducerRecord<String, String> record = new ProducerRecord<String, String>("event_data","eventData"+i,randDigest+i%2+":"+i+":"+s);

producer.send(record);

try {

Thread.sleep(500);

} catch (InterruptedException e) {

throw new RuntimeException(e);

}

}

}).start();

//从kafka中读取数据

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

environment.setParallelism(2);

KafkaSource<String> kafkaSource= KafkaSource.<String>builder()

.setBootstrapServers("node1:9092,master:9092,node2:9092")

.setTopics("event_data")

.setGroupId("event-group")

.setStartingOffsets(OffsetsInitializer.latest())

.setValueOnlyDeserializer(new SimpleStringSchema())

.build();

DataStreamSource<String> source = environment.fromSource(kafkaSource, WatermarkStrategy.noWatermarks(), "kafka_source");

source.map(word -> {

String[] split = word.split(":");

return Tuple3.of(split[0], Integer.parseInt(split[1]),Long.parseLong(split[2]));

}, Types.TUPLE(Types.STRING, Types.INT,

//在滑动窗口前设置水位线 有序数据使用 forMonotonousTimestamps

//WatermarkStrategy 水位线策略

Types.LONG)).assignTimestampsAndWatermarks(WatermarkStrategy.<Tuple3<String,Integer,Long>>forMonotonousTimestamps().withTimestampAssigner(new SerializableTimestampAssigner<Tuple3<String, Integer, Long>>() {

//把事件时间戳作为水位线

@Override

public long extractTimestamp(Tuple3<String, Integer, Long> element, long recordTimestamp) {

return element.f2;

}

}))

.keyBy(t -> t.f0).window(SlidingEventTimeWindows.of(Time.seconds(5),Time.seconds(2))).apply(new WindowFunction<Tuple3<String, Integer, Long>, Tuple2<String,Integer>, String, TimeWindow>() {

@Override

public void apply(String s, TimeWindow window, Iterable<Tuple3<String, Integer, Long>> input, Collector<Tuple2<String, Integer>> out) throws Exception {

int sum=0;

StringBuffer key=new StringBuffer();

key.append(s).append("[窗口信息]:").append(window.toString());

for (Tuple3<String, Integer, Long> item : input) {

sum+=item.f1;

key.append("[事件时间]:"+String.valueOf(item.f2));

}

out.collect(Tuple2.of(key.toString(),sum));

}

}).print("[WaterMark------>TimeWindows]");

environment.execute();

}

- 无序流

由于乱序流中需要等待迟到数据到齐,所以必须设置一个固定量的延迟时间(Fixed Amount of Lateness)。

调用 WatermarkStrategy. forBoundedOutOfOrderness()方法就可以实现。

这个方法需要传入一个 maxOutOfOrderness 参数,表示“最大乱序程度”。(延迟时间)

Tips:

当程序开始时,WaterMark会被设置为Long的最小值,以保证它不会丢数据。

当程序关闭时,WaterMark会被设置为Long的最大值,以保证它大到足以关闭所有已经开启的窗口。

- 案例(无序流处理)

//事件时间读取 代码没加水位线 无法计算

new Thread(()->{

//生成随机值发送到kafka中

String randDigest = RandomStringUtils.randomAlphabetic(8).toLowerCase(Locale.ROOT);

for(int i=200;i<400;i++) {

KafkaProducer<String, String> producer = KafkaUtils.getProducer();

//插入有序数据

if(i%5!=0) {

ProducerRecord<String, String> record = new ProducerRecord<String, String>("OutInOrder", "eventData" + i, randDigest + i % 2 + ":" + i + ":" + System.currentTimeMillis());

producer.send(record);

//能被5整除的迟到数据 迟到1到10s [0,10)s

}else {

ProducerRecord<String, String> record = new ProducerRecord<String, String>("OutInOrder", "eventData" + i, randDigest + i % 2 + ":" + i + ":" + (System.currentTimeMillis()-(long)(Math.random()*10000)));

producer.send(record);

}

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

throw new RuntimeException(e);

}

}

}).start();

//从kafka中读取数据

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

environment.setParallelism(1);

KafkaSource<String> kafkaSource= KafkaSource.<String>builder()

.setBootstrapServers("node1:9092,master:9092,node2:9092")

.setTopics("OutInOrder")

.setGroupId("event-group")

.setStartingOffsets(OffsetsInitializer.latest())

.setValueOnlyDeserializer(new SimpleStringSchema())

.build();

//读取数据进行消费

DataStreamSource<String> source = environment.fromSource(kafkaSource, WatermarkStrategy.noWatermarks(), "kafka_source");

//处理数据

source.map(x->{

String[] v = x.split(":");

Tuple3<String, String, Long> tuple3 = Tuple3.of(v[0], v[1], Long.parseLong(v[2]));

return tuple3;

},Types.TUPLE(Types.STRING,Types.STRING,Types.LONG))

//标记水位线 注意泛型 设置延迟时间为8s

.assignTimestampsAndWatermarks(WatermarkStrategy. <Tuple3<String,String,Long>>forBoundedOutOfOrderness(Duration.ofSeconds(8)).withTimestampAssigner(new SerializableTimestampAssigner<Tuple3<String,String,Long>>() {

@Override

public long extractTimestamp(Tuple3<String, String, Long> element, long recordTimestamp) {

return element.f2;

}

//滑动事件时间

})).keyBy(t3->t3.f0).window(SlidingEventTimeWindows.of(Time.seconds(5),Time.seconds(2)))

.apply(new WindowFunction<Tuple3<String, String, Long>, String, String, TimeWindow>() {

@Override

public void apply(String key, TimeWindow window, Iterable<Tuple3<String, String, Long>> input, Collector<String> out) throws Exception {

StringBuffer buffer=new StringBuffer();

buffer.append("[计算结果:]");

for (Tuple3<String, String, Long> vas : input) {

buffer.append(vas.f1).append("_");

}

buffer.append("[时间窗口]").append(window.toString());

out.collect(buffer.toString());

}

}).print("[水位线]---->[乱序流]");

environment.execute();

- 自定义水位线

自定义水位线有两种:

- 周期性(periodic):周期性调用的方法中发出水位线。

- 实现Periodic Generator接口生成实现类定义

- 通过onEvent()观察判断输入的事件,在OnPeriodicEmit()发出水位线。

- 定点式(Punctuated):在事件方法中发出水位线。

- 实现Punctuated Generator接口生成实现类定义

- 定点生成器不停检测onEvent()中事件,发现带有水位线信息的特殊事件就会立即发出

- 案例(周期性水位线 无序流)

package com.zwf.windowFunction;

import com.zwf.util.KafkaUtils;

import org.apache.commons.lang3.RandomStringUtils;

import org.apache.flink.api.common.eventtime.*;

import org.apache.flink.api.common.serialization.SimpleStringSchema;

import org.apache.flink.api.common.typeinfo.Types;

import org.apache.flink.api.java.tuple.Tuple2;

import org.apache.flink.api.java.tuple.Tuple3;

import org.apache.flink.connector.kafka.source.KafkaSource;

import org.apache.flink.connector.kafka.source.enumerator.initializer.OffsetsInitializer;

import org.apache.flink.streaming.api.datastream.DataStreamSource;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.functions.windowing.WindowFunction;

import org.apache.flink.streaming.api.windowing.assigners.SlidingEventTimeWindows;

import org.apache.flink.streaming.api.windowing.assigners.TumblingEventTimeWindows;

import org.apache.flink.streaming.api.windowing.time.Time;

import org.apache.flink.streaming.api.windowing.windows.TimeWindow;

import org.apache.flink.util.Collector;

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.ProducerRecord;

import javax.swing.plaf.basic.BasicSliderUI;

import java.util.Locale;

/**

* @author MrZeng

* @version 1.0

* @date 2024-01-04 10:38

*/

public class eventTimeWaterMark {

public static void main(String[] args) throws Exception {

new Thread(()->{

KafkaProducer<String, String> producer = KafkaUtils.getProducer();

String lowerCase = RandomStringUtils.randomAlphabetic(4).toLowerCase(Locale.ROOT);

for (int i=100;i<2000;i++){

if(i%5!=0) {

ProducerRecord<String, String> record = new ProducerRecord<String, String>("customer_watermark", lowerCase, lowerCase+i%2 + ":" + i + ":" + System.currentTimeMillis());

producer.send(record);

}else {

//模拟数据迟到0到10s

ProducerRecord<String, String> record = new ProducerRecord<String, String>("customer_watermark", lowerCase, lowerCase+i%2+ ":" + i + ":" + (System.currentTimeMillis()-(long)Math.random()*10000));

producer.send(record);

}

try {

Thread.sleep(100);

} catch (InterruptedException e) {

throw new RuntimeException(e);

}

}

}).start();

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

environment.setParallelism(1);

KafkaSource<String> kafkaSource= KafkaSource.<String>builder()

.setBootstrapServers("node1:9092,master:9092,node2:9092")

.setTopics("customer_watermark")

.setGroupId("event-group-id")

.setStartingOffsets(OffsetsInitializer.latest())

.setValueOnlyDeserializer(new SimpleStringSchema())

.build();

//连接kafka

DataStreamSource<String> source = environment.fromSource(kafkaSource, WatermarkStrategy.noWatermarks(), "kafkaSource");

//处理kafka数据源

source.map(x->{

String[] val = x.split(":");

return Tuple3.of(val[0],val[1],Long.parseLong(val[2]));

}, Types.TUPLE(Types.STRING,Types.STRING, Types.LONG)).assignTimestampsAndWatermarks(new CustomerWaterMark()).keyBy(x->x.f0).window(SlidingEventTimeWindows.of(Time.seconds(5),Time.seconds(3)))

.apply(new WindowFunction<Tuple3<String, String, Long>, String, String, TimeWindow>() {

@Override

public void apply(String s, TimeWindow window, Iterable<Tuple3<String, String, Long>> input, Collector<String> out) throws Exception {

StringBuffer buffer=new StringBuffer();

buffer.append("[数据计算]:");

for (Tuple3<String, String, Long> vals : input) {

buffer.append(vals.f1).append("_").append("[事件时间]:").append(vals.f2).append(",");

}

buffer.append("[窗口信息]:").append(window);

out.collect(buffer.toString());

}

}).print("自定义无序流周期性水位线:");

environment.execute();

}

}

//自定义水位线策略

class CustomerWaterMark implements WatermarkStrategy<Tuple3<String,String,Long>> {

@Override

public WatermarkGenerator<Tuple3<String,String,Long>> createWatermarkGenerator(WatermarkGeneratorSupplier.Context context) {

return new PeriodicWaterMark();

}

//设置参考时间戳时间

@Override

public TimestampAssigner<Tuple3<String, String, Long>> createTimestampAssigner(TimestampAssignerSupplier.Context context) {

return new SerializableTimestampAssigner<Tuple3<String, String, Long>>() {

@Override

public long extractTimestamp(Tuple3<String, String, Long> element, long recordTimestamp) {

return element.f2;

}

};

}

}

//自定义周期水位线生成器

class PeriodicWaterMark implements WatermarkGenerator<Tuple3<String,String,Long>>{

//初始化水位线

Long maxTimeStamp=Long.MIN_VALUE;

//设置延迟时间 防止丢失迟到数据

Long lateTime=8000L;

/**

*

* @param event 输入事件数据对象

* @param eventTimestamp 事件时间戳

* @param output 输出对象

*/

@Override

public void onEvent(Tuple3<String, String, Long> event, long eventTimestamp, WatermarkOutput output) {

//设置水位线

maxTimeStamp = Math.max(maxTimeStamp,event.f2);

}

//周期性发送

@Override

public void onPeriodicEmit(WatermarkOutput output) {

//周期性发送水位线 到一个事件就发射一个水位线

output.emitWatermark(new Watermark(maxTimeStamp-lateTime-1L));

}

}

- 案例(定点水位线)

package com.zwf.windowFunction;

import com.zwf.util.KafkaUtils;

import org.apache.commons.lang3.RandomStringUtils;

import org.apache.flink.api.common.eventtime.*;

import org.apache.flink.api.common.serialization.SimpleStringSchema;

import org.apache.flink.connector.kafka.source.KafkaSource;

import org.apache.flink.connector.kafka.source.enumerator.initializer.OffsetsInitializer;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.functions.windowing.WindowFunction;

import org.apache.flink.streaming.api.windowing.assigners.TumblingEventTimeWindows;

import org.apache.flink.streaming.api.windowing.time.Time;

import org.apache.flink.streaming.api.windowing.windows.TimeWindow;

import org.apache.flink.util.Collector;

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.ProducerRecord;

import java.util.Locale;

/**

* @author MrZeng

* @version 1.0

* @date 2024-01-04 14:20

*/

public class CustomPointWaterMark {

//自定义定点水位线

public static void main(String[] args) throws Exception {

new Thread(()->{

KafkaProducer<String, String> producer = KafkaUtils.getProducer();

String ranStr = RandomStringUtils.randomAlphabetic(5).toLowerCase(Locale.ROOT);

for (int i=1000;i<2000;i++) {

ProducerRecord<String, String> record = new ProducerRecord<>("customer_watermark", ranStr+i, ranStr+i%2+":"+i+":"+System.currentTimeMillis());

producer.send(record);

try {

Thread.sleep(100);

} catch (InterruptedException e) {

throw new RuntimeException(e);

}

}

}).start();

StreamExecutionEnvironment environment = StreamExecutionEnvironment.getExecutionEnvironment();

environment.setParallelism(1);

//读取kafka数据源

KafkaSource<String> source = KafkaSource.<String>builder()

.setBootstrapServers("node1:9092,master:9092,node2:9092")

.setGroupId("kafka_group")

.setValueOnlyDeserializer(new SimpleStringSchema())

.setTopics("customer_watermark")

.setStartingOffsets(OffsetsInitializer.latest())

.build();

environment.fromSource(source, WatermarkStrategy.noWatermarks(), "kafka_source")

.assignTimestampsAndWatermarks(new CusWaterMark()).keyBy(x -> x.split(":")[0]).window(TumblingEventTimeWindows.of(Time.seconds(5)))

.apply(new WindowFunction<String, String, String, TimeWindow>() {

@Override

public void apply(String key, TimeWindow window, Iterable<String> input, Collector<String> out) throws Exception {

StringBuffer buffer=new StringBuffer();

buffer.append("[计算结果]:");

for (String s : input) {

buffer.append(s.split(":")[1]).append("_").append(s.split(":")[2]);

}

buffer.append("[窗口信息]:").append(window);

out.collect(buffer.toString());

}

}).print();

environment.execute();

}

}

class CusWaterMark implements WatermarkStrategy<String>{

@Override

public WatermarkGenerator<String> createWatermarkGenerator(WatermarkGeneratorSupplier.Context context) {

return new CusWaterMarkDemo();

}

@Override

public TimestampAssigner<String> createTimestampAssigner(TimestampAssignerSupplier.Context context) {

return new SerializableTimestampAssigner<String>() {

@Override

public long extractTimestamp(String element, long recordTimestamp) {

return Long.parseLong(element.split(":")[2]);

}

} ;

}

}

class CusWaterMarkDemo implements WatermarkGenerator<String>{

//循环到整百数时 发送水位线 定点发送水位线

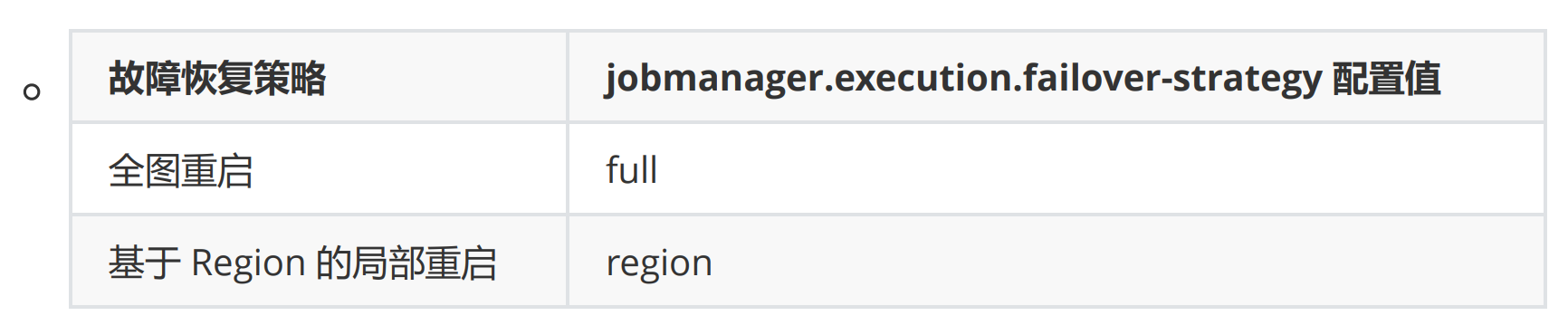

@Override