发表时间:2019(ICML 2019)

文章要点:这篇文章想说如果replay的经验和当前的policy差别很大的话,对更新是有害的。然后提出了Remember and Forget Experience Replay (ReF-ER)算法,(1)跳过那些和当前policy差别很大的experience的更新(2)用trust region来约束更新步长。

作者把experience分为“near-policy" or “far-policy",然后更新基于near-policy experience。区分的表征是计算当前policy和之前policy的ratio,然后设置一个阈值,落在范围内的就是near-policy experience

其中\(c_{max}>1\)。

更新的准则就是只有near-policy的experience提供梯度

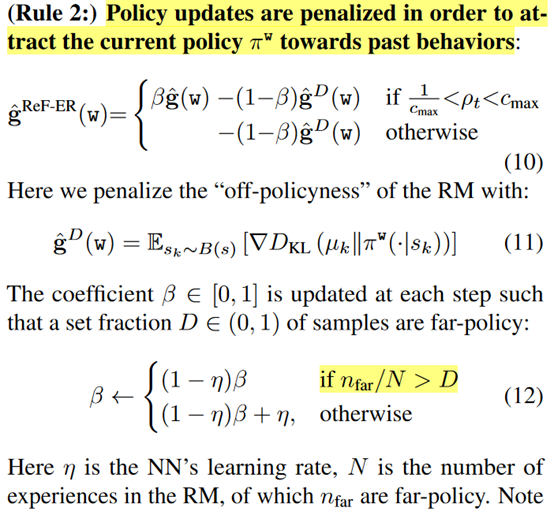

接着就是控制更新步长,让更新的policy离上一个policy不要差太远

然后作者就把这个方法用到各个算法上,DDPG,NAF,V-RACER,处理的问题都是连续动作空间。

总结:思路就是用最新的样本更新,然后控制更新幅度不要太大。感觉就是往on-policy的算法上靠。

疑问:无。

- Experience Remember Forget Replay andexperience remember forget replay replay conservative estimation experience experience efficient tables replay optimization experience replay experience framework reverb replay fundamentals revisiting experience replay prioritized experience sequence replay topological experience replay forget remember