RLChina

RLChina理论三:强化学习基础

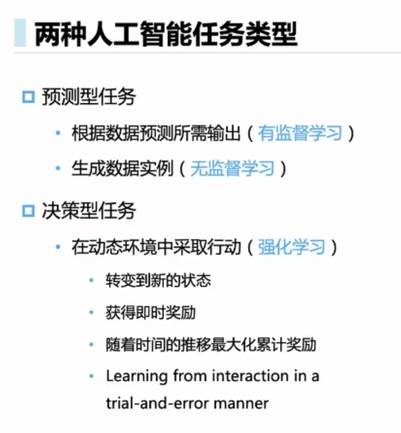

###强化学习基础  都不会提高自 ......

RLChina2022公开课-博弈搜索算法

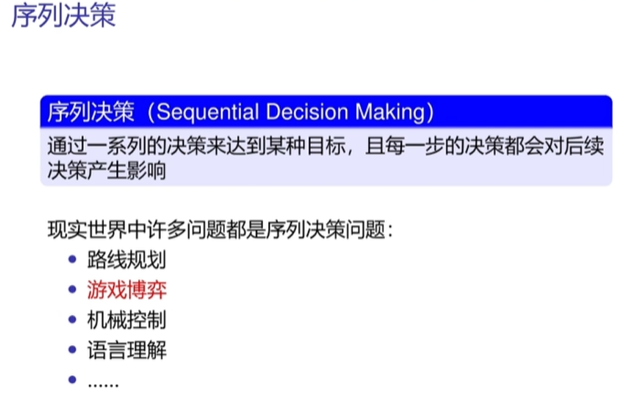

###序列决策  **序列决策问题一般用马尔可夫决策模型进行描述**  S:所有状态集合 A:在环境力里面智能体所作动作的集合 P:状态转移函数P(s'|s,a),智能体在当前s下,执行a之后,转移到是s'的概率 R:奖励函数R(s,a),表示在环境s下执行动作a之后获得的立即奖励,有时候还需要知道s'是多 ......