Temporally Grounding Natural Sentence in Video

摘要:我们引入了一种有效且高效的方法,可以在长的、未修剪的视频序列中建立(即本地化)自然句子。 具体来说,提出了一种新颖的时间地面网络(TGN)来暂时捕获视频和句子之间不断变化的细粒度逐字交互。 TGN 基于所利用的逐字交互,对每帧结束的一组时间候选序列进行顺序评分,最后为与句子相对应的片段奠定基础。 与以滑动窗口方式分别处理重叠片段的传统方法不同,TGN 聚合历史信息并一次性生成最终的接地结果。 我们在三个公共数据集上广泛评估了我们提出的 TGN,与最先进的技术相比有了显着的改进。 我们通过消融研究和运行时测试进一步展示了 TGN 的一致有效性和效率。

图 1:(a) 视频自然句基础 (NSGV) 任务。 (b)基于公共空间的匹配方法以滑动窗口方式执行。 (c) 我们提出的时间地面网络(TGN)在单个处理过程中以多个尺度定位候选视频片段。 视频中的帧和句子中的单词密切交互,进行细粒度的逐帧匹配,为视频中的句子奠定基础。

1 introduction

我们研究了视频自然句基础(NSGV)的任务。 给定一个未修剪的视频和一个自然句子,目标是确定视频中与给定句子相对应的片段的开始和结束时间戳,如图 1 (a) 所示。 与其他视频研究相比,例如双向视频句子检索、视频吸引力预测和视频字幕,NSGV 不仅需要对句子和视频的特征进行建模,还需要对两种模态之间的细粒度交互进行建模,这更具挑战性。

最近,一些相关工作(Gao et al., 2017; Hendricks et al., 2017)利用视频序列上的一种时间滑动窗口方法来生成视频片段候选,然后将其独立组合(Gao et al., 2017) 或与给定的句子进行比较(Hendricks et al., 2017)以做出接地预测。 尽管现有的工作取得了可喜的成果,但其效果和效率仍然较低。 首先,现有方法将视频片段和句子投影到一个公共空间中,如图1(b)所示,其中生成的两个嵌入向量用于执行视频片段和句子之间的匹配。 这种匹配仅在全局片段和句子级别进行,表达能力不够,忽略了视频帧与句子中单词之间的细粒度匹配关系。 其次,为了处理候选片段的不同时间尺度和位置,需要在大量重叠片段和句子之间进行详尽的匹配。 因此,滑动窗口方法的计算量非常大。

为了解决上述两个限制,我们引入了一种新颖的时态地面网络(TGN)模型,这是第一个用于 NSGV 任务的动态单流深度架构(dynamic single-stream deep archi- tecture),它充分利用了视频帧和单词之间的细粒度交互。 句,如图1(c)所示。 TGN 按顺序处理视频帧,在每个时间步骤,我们都依靠新颖的多模式交互器来利用不断发展的细粒度逐字交互。 然后,TGN 根据生成的交互状态同时对一组多个尺度的时间候选进行评分,并最终定位与该句子相对应的视频片段。 更重要的是,我们提出的 TGN 能够逐帧分析未修剪的视频,而无需处理重叠的时间视频片段。

2 related work

2.1 Grounding Natural Language in Image

2.2 Grounding Natural Language in Video

3 Approach

给定一个长且未修剪的视频序列 \(V\) 和一个自然句子 \(S\),NSGV 任务是从 \(V\) 定位视频片段 \(V_s = \{f_t\}^{t_e}_{t=t_b}\),从 \(t_b\) 开始,到 \(t_e\)结束,其对应于并表达与给定的句子S相同的语义。为了执行基础,每个视频表示为\(V = \{f_t\}^{T}_{t=1}\),其中\(T\)是帧总数,\(f_t\)表示第\(t\)个视频帧的特征表示。类似地,每个句子表示为 \(S = \{w_n\}^{N}_{n=1}\),其中 \(w_n\) 是句子中第 \(n\)个单词的嵌入向量,\(N\) 表示单词总数。

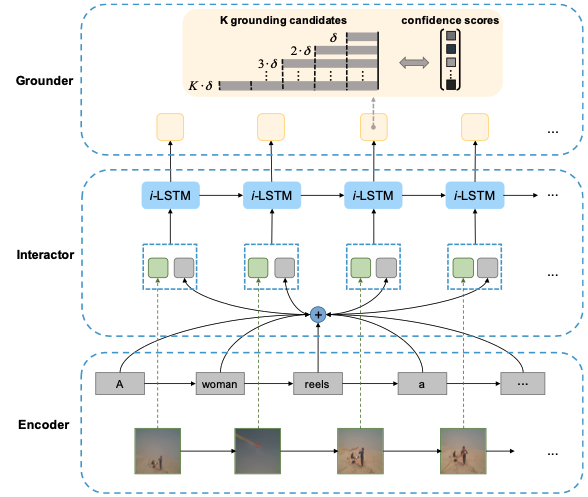

图 2:我们提出的 TGN 模型的架构。 TGN 由三个模块组成。 视觉和纹理编码器分别聚合来自连续视频帧表示和句子的单词嵌入的上下文证据。 多模态交互器学习视频和句子之间的细粒度逐词交互。 接地器通过一次传递即可产生视频序列中句子的时间接地。

我们提出了一种新颖的模型,即 Temporal GroundNet (TGN),来解决 NSGV 问题。 如图 2 所示,TGN 由三个模块组成。 1)编码器:视觉和文本编码器分别用于组成视频帧表示和词嵌入。 2)交互者:多模态交互者学习视频和句子之间的逐帧交互。 3)Grounder:grounder 在一次传递中生成时间定位。 三个模块完全耦合在一起,因此可以以端到端的方式进行训练。

3.1 encoder

我们采用两个(LSTM)来独立地顺序处理两种不同的模式,即视频和句子。具体来说,一个 LSTM 对视频 V 进行顺序建模,产生隐藏状态 \(\{h^v_t\}^T_{t=1}\),而另一个 LSTM 处理句子 S 中的顺序单词,产生其相应的隐藏状态 \(\{h^s_n\}^N_{n=1}\)。 由于 LSTM 的自然行为和特征,\({h^v_t}^T_{t=1}\) 和 \(\{h^s_n\}^N_{n=1}\)都可以分别编码和聚合来自顺序视频帧表示和句子的词嵌入的上下文证据,同时抛弃不相关的信息。

3.2 Interaction LSTM (i-LSTM)

基于杠杆编码器产生的视频和句子的隐藏状态,我们设计了一个多模态交互器来执行视频和句子之间的逐帧交互。 首先,通过考虑句子隐藏状态在每个时间步与特定视频帧的关系来总结句子隐藏状态,从而生成特定于帧的句子特征。 然后,执行交互 LSTM(称为 i-LSTM)来聚合逐字交互。

3.2.1 Frame-Specific Sentence Feature

直接对编码器生成的剪辑级和句子级特征进行操作不能很好地利用视频和句子之间随时间演变的逐字关系。 受(Wang and Jiang,2016a;Feng et al.,2018)的启发,我们引入了一种新颖的特定于框架的句子特征,它自适应地总结了句子 \(\{h^s_n\}^N_{n=1}\) 的隐藏状态 第 t 个视频帧:

其中 \(H^s_t\) 表示第 \(t\) 个视频帧指定的概括句子表示。 在每个时间步 \(t\),我们利用隐藏状态 \(h^v_t\) 选择性地关注单词并相应地总结它们。 注意力权重 \(α^n_t\) 编码句子中第 \(n\) 个单词与第 $t \(个视频帧的对齐程度。 随着视频帧处理的进行,注意力权重相对于当前视频帧动态变化。 这样,生成的特定于帧的句子特征\){Hs_t}T_{t=1}$ 考虑了所有视频帧和句子中所有单词之间的逐帧关系。

由于帧特定句子特征的生成与后面的交互LSTM深度耦合,我们将在后面解释注意力权重\(α^n_t\)的计算。

3.2.2 Interaction LSTM (i-LSTM)

为了准确地理解视频中的句子,需要对视频和句子之间的多模态交互行为进行全面建模。 以前的多模态交互方法仅限于串联(Zhu et al., 2016)、元素乘积或求和(Gao et al., 2017)和双线性池(Fukui et al., 2016)。 这些方法的表达能力不够,因为它们忽略了视频和句子之间不断发展的细粒度交互,特别是逐字交互。 在本文中,我们提出了一种新颖的多模态交互模型,由 LSTM 实现。 我们将其称为交互 LSTM (i-LSTM),它逐帧顺序处理视频序列,与句子中的单词进行深度交互。

为了很好地捕捉视频和句子之间复杂的时间交互,在每个时间步 t,i-LSTM 的输入是通过连接第 t 个视频隐藏状态 \(h^v_t\) 和第 t 个帧特定状态形成的。 句子特征\(H^s_t\)为:\(r_t = h^v_ \| H^s_t\)。 然后将 \(r_t\) 输入到 i-LSTM 单元以产生视频和句子之间的第 t 个中间交互状态:

其中 \(h^r_t\) 是产生的隐藏状态,对单词和视频帧之间的细粒度交互进行编码。 \(h^r_t\) 将进一步用于执行接地过程。 由于 LSTM 的固有属性和特点,与当前阶段相关的重要线索将被“记住”,而不重要的线索将被“遗忘”。

现在我们回到方程中注意力权重 \(α^t_n\) 的生成。 (1),基于上一步获得的视觉隐藏状态\(h^v_t\)和文本隐藏状态\(h^s_n\)以及产生的交互状态\(h^r_{t-1}\)。 广泛使用的软注意力机制(Xu et al., 2015a; Chen et al., 2017)用于以逐字方式生成注意力权重。 如前所述,i-LSTM 对句子和视频之间不断变化的逐字交互进行建模。 因此,第n个单词hsn和第t个视频帧hvt之间的注意力权重不仅取决于视频和句子的内容,还取决于它们的交互状态。 因此,我们设计一个网络来计算一个视频帧相对于每个单词的相关性得分:

其中向量\(w\)、矩阵\(W^*\)、偏置向量\(b\)和偏置\(c\)是要学习的网络参数。 hrt−1 是 i-LSTM 在 t − 1 时间步的隐藏状态。 最终的词级注意力权重通过以下方式获得:

获得的注意力权重\(α^t_n\)随后用于生成特定于帧的句子特征,如式(1)所示。

3.3 Grounder

在本节中,我们介绍了 grounder,它作用于 i-LSTM 生成的交互状态 hrt,以定位与句子相对应的视频片段。 我们提出的接地器在一次传递中工作,而不引入重叠的滑动窗口,从而导致快速的运行时间。 如图 2 所示,在每个时间步 t,接地者通过考虑在时间步 t 结束的多个时间尺度(Buch 等人,2017),有效地对一组 K 个接地候选者进行评分。 具体来说,我们对不同的数据集使用不同的 K,这是由某个数据集中所有真实基础的长度分布决定的。 为了简化下面的讨论,假设K个时间尺度的长度是一个具有公差δ的算术序列,并且所有时间候选都按长度递增排序。 换句话说,第k个候选的长度是kδ。 请注意,在时间 t 考虑的所有接地候选者都有固定的结束边界。

具体来说,在每个时间步 t,基础者将考虑将每个时间候选者分类为相对于给定句子的积极基础或消极基础。 考虑到多个时间尺度,接地者将生成与 K 个视觉接地候选集相对应的置信度分数 Ct = (c1t , c2t , ..., cKt ),全部在时间步 t 结束。 i-LSTM 在时间 t 生成的隐藏状态 hrt 表示句子和视频序列之间直到当前位置的交互状态,自然适合生成在时间步 t 结束的不同时间尺度的置信度得分。 在本文中,表示句子基础的置信度分数是由具有 sigmoid 非线性的全连接层生成的:

其中 \(W^K\) 和 \(b^r_t\) 是相应的参数,\(σ\) 表示非线性 sigmoid 函数。

3.4 Training

\(X\) 中收集的 NSGV 训练样本是视频-句子对。 具体来说,每个视频 $V \(在时间上与一组句子注释相关联:\)A = {(S_i, t^b_i , t^e_i )}^M_{i=1}$,其中 $M \(是视频注释句子的数量,\)S_i$ 是句子描述 视频剪辑的 \(t^b_i\) 和 \(t^e_i\) 指示视频中的开始和结束时间。 每个训练样本对应于一个具有二进制条目的真实矩阵 \(y ∈ \mathbb{R}^{T×K}\)。 我们使用 $y^t_k $表示真实矩阵的第 \((t, k)\) 个条目。 $y^t_k $ 被解释为时间步 \(t\) 处的第 \(k\) 个基础候选是否对应于给定的自然句子。 具体来说,条目 $y^t_k $ 设置为 1,表示相应的视频片段(在时间步长 \(t\) 结束,长度为 \(kδ\))具有时间交集(IoU),其中\((t^b,t^e)\)大于阈值 \(θ\) 。 否则 $y^t_k $ 设置为 0。

对于训练对 \((V, S) ∈ X\) ,时间步 t 的目标由加权二元交叉熵损失 \(L(t, V, S)\) 给出:

其中权重\(\omega^k_0\)和\(\omega^k_1\)是根据长度为kδ的训练集中正样本和负样本的频率计算的。\(y^k_t\)是真实值,\(c^k_t\) 表示我们提出的模型的预测结果。

我们的 TGN 在每个时间步 t 进行反向传播,以学习完全耦合的三个模块的所有参数:编码器、交互器和接地器。 所有训练视频-句子对X的目标定义为:

3.5 Inference

在推理阶段,给定一个测试视频 \(V\)和一个句子 \(S\),文本和视觉编码器首先分别为每个单词和视频帧生成隐藏状态。 然后,交互者按顺序逐帧浏览视频,以产生逐字交互状态。 在每个位置 \(t\),由接地者生成 \(K\) 维得分向量 \(C_t\)。 因此,在处理完视频中的最后一帧后,得到整个视频的\(T×K\)分数矩阵,矩阵中的第\((t,k)\)个条目表示视频片段结束于的概率 视频V中长度为\(kδ\)的位置\(t\)对应于句子\(S\)。最终,评估被简化为基于生成的分数对所有基础候选进行排序的问题。

4 Experiment

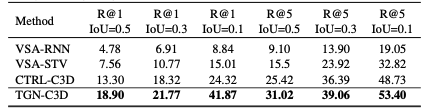

表 1:TACoS 上不同方法的性能比较。 每个指标条目的最佳性能以粗体突出显示。

表 2:ActivityNet Captions 上不同视觉特征的性能比较。 每个指标条目的最佳性能以粗体突出显示。

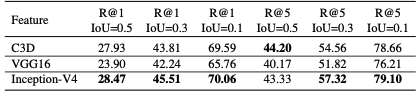

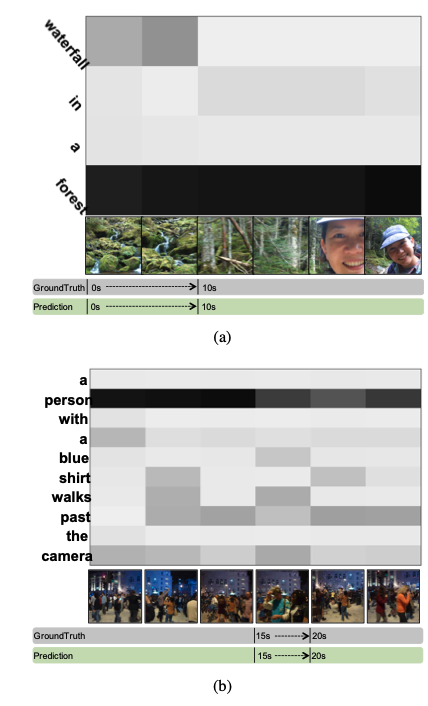

图 3:我们的 TGN 模型在具有不同视觉特征的 ActiveityNet Captions 数据集上的定性基础结果。

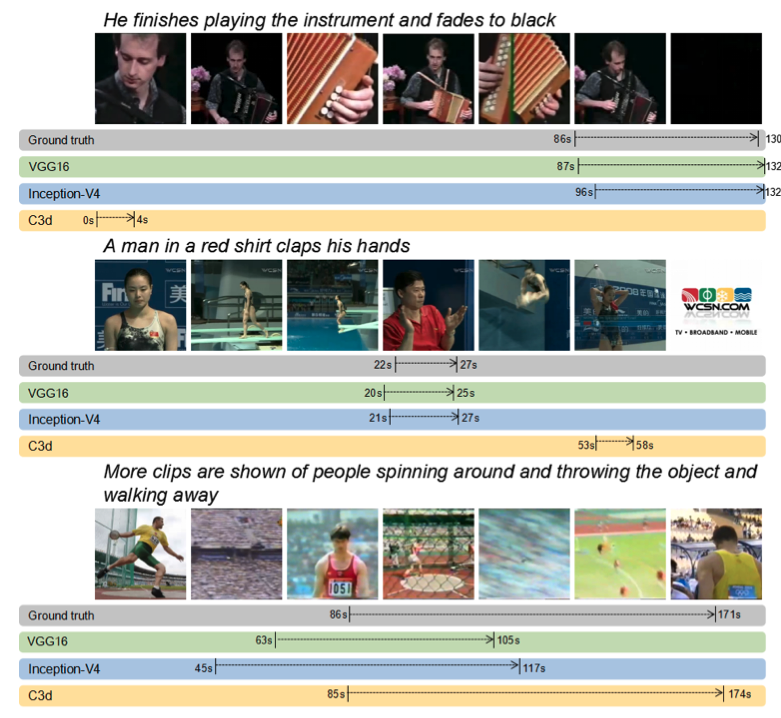

图 4:逐字注意力的可视化结果。 颜色越深,代表的注意力值越大。

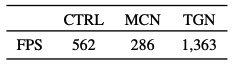

表 5:以每秒帧数为单位的效率比较。

5 conclusion

在本文中,我们重点关注视频中自然句子基础的任务,这被认为可以提供对桥接计算机视觉和自然语言处理的全面理解。 为了完成这项任务,我们提出了一种端到端的时间地面网络(TGN),通过结合视频句子模式中不断发展的细粒度逐字交互,生成适合每个给定自然句子的视觉基础。 。 此外,TGN 执行效率很高,只需一次处理视频序列。 对三个真实世界数据集的大量实验清楚地证明了所提出的 TGN 的有效性和效率。