狂神聊ElasticSearch

版本:ElasticSearch 7.6.1(全网最新了)!

6.X 和7.X的区别十分大,6.X的API(原生API,RestFul高级!)

我们要讲解什么?

SQL:like%狂神说%,如果是大数据,就十分慢!索引!

ElasticSearch:搜索!(百度、github、淘宝电商!)

内容:

-

聊一个人

-

货比三家

-

安装

-

生态圈

-

分词器ik

-

RestFul操作 ES

-

CRUD

-

SpringBoot集成ElasticSearch(从原理分析!)

-

爬虫爬取数据

-

实战,模拟全文检索!

以后如果需要用到搜索,就可以使用ES!(大数据量的情况下使用!)

聊聊Doug Cutting这个人

历史

1998年9月4日,Google公司在美国的硅谷成功。正如大家所知,它是一家做搜索引擎起来的公司。

无所有偶,一位名叫Doug Cutting的美国工程师,也迷上了搜索引擎,他做了一个用于文本搜索的函数库(姑且理解为软件的功能组件),命名为Lucene。

Lucene使用Java写成的,目标是为各种中小型应用软件加入全文检索功能,因为好用而且开源(代码公开),非常受程序员们的欢迎。

早期的时候,这个项目被发布在Doug Cutting的个人网站和SourceForge(一个开源软件网站),后来,2001年底,Lucene成为Apache软件基金会jakarta项目的子项目。

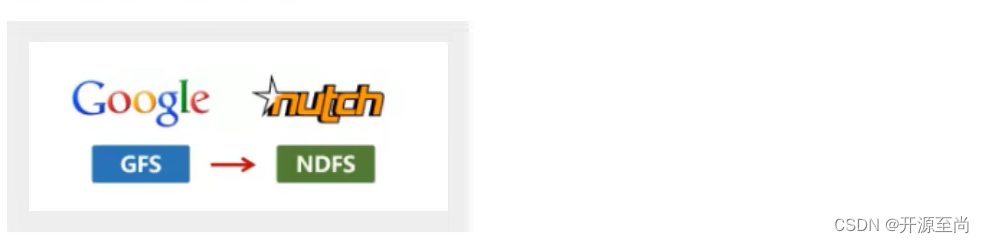

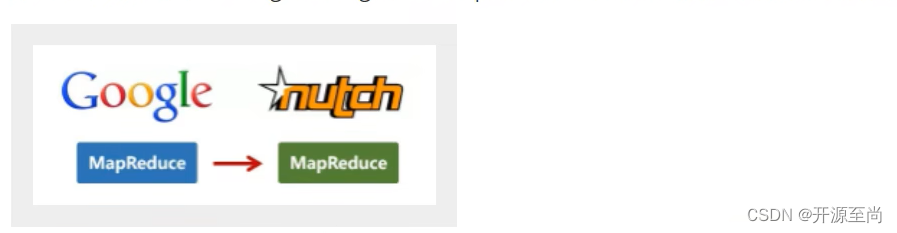

2004年,Doug Cutting再接再厉,在Lucene的基础上,和Apache开源伙伴Mike Cafarella合作,开发了一款可以替代当时的主流搜索的开源搜索引擎,命名为Nutch.

Nutch是一个建立在Lucene核心之上的网页搜索引用程序,可以下载下来直接使用,它在Lucene的基础上加了网络爬虫和一些网页相关的功能,目的就是从一个简单的站内搜索推广到全球网络的搜索上,就像Google一样。

Nutch在业界的影响力比Lucene更大。

大批网站采用了Nutch平台,大大降低了技术门槛,使低成本的普通计算机取代高价的Web服务器成为可能。甚至有一段时间。在硅谷有了一股用Nutch低成本创业的潮流(大数据!)

随着时间的推移,无论是Google还是Nutch,都面临搜索对象“体积”不断增大的问题

尤其是Google,作为互联网搜索引擎,需要存储大量的网页,并不断优化自己的搜索算法,提升搜索效率。

在这个过程中,Google确实找到了不少好办法,并且无私地分享了出来

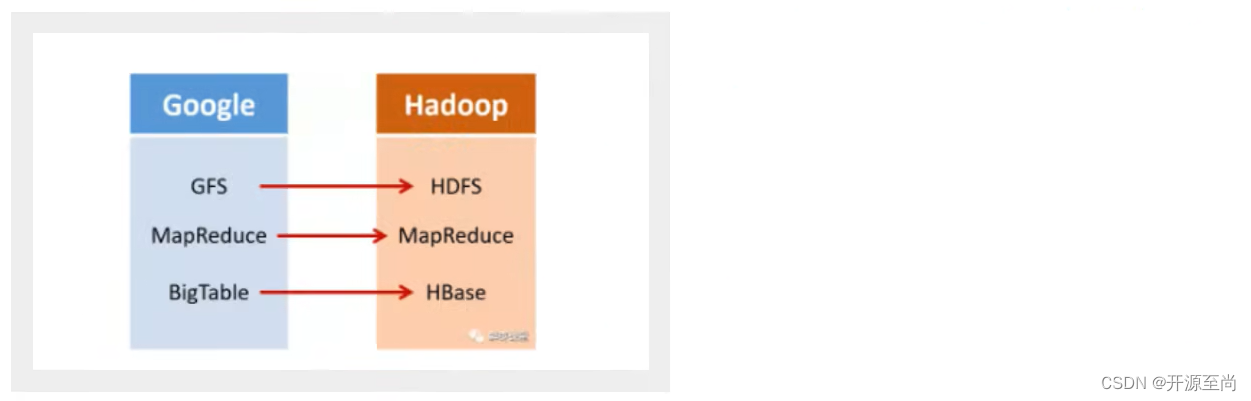

2003年,Google发表了一篇技术学术论文,公开介绍了自己的谷歌文件系统GFS(Google File System)。这是Google公司为了存储海量搜索数据而设计的专用文件系统。

第二年,也就是2004年,Doug Cutting基于Google的GFS论文,实现了分布式文件存储系统,并将它命令为NDFS(Nutch Distributed File System)。

还是2004年,Google又发表了一篇技术学术论文,介绍自己的MapReduce编程模型,这个编程模型用于大规模数据集(大于1TB)的并行分析运算。

第二年(2005年),Doug Cutting又基于MapReduce,在Nutch搜索引擎实现了该功能。

2006年,当时依然很厉害的Yahoo(雅虎)公司,招安了Doug Cutting。

加盟Yahoo之后,Doug Cutting将NDFS和MapReduce进行了升级改造,并重新命名为Hadoop(NDFS也改名为HDFS,Hadoop Distributed File System)。

这个就是后来大名鼎鼎的大数据框架系统——Hadoop的由来,而Doug Cutting,则被人们称为Hadoop之父。

Hadoop这个名字,实际上是Doug Cutting他儿子的黄色玩具大象的名字,所以,Hadoop的Logo,就是一只奔跑的黄色大象。

我们继续往下说。

还是2006年,Google又发论文了。

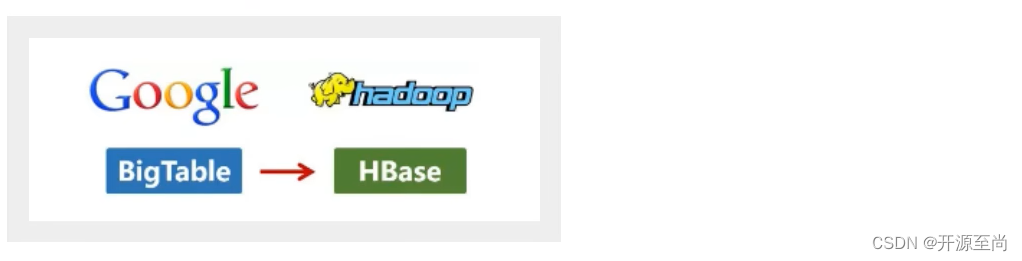

这次,他们介绍了自己的BigTable,这是一种分布式数据存储系统,一种用来处理海量数据的非关系型数据库。

Doug Cutting当然也没有放过,在自己的Hadoop系统里面,引入了BigTable,并命名为HBase。

好吧,反正就是紧跟Google时代步伐,你出什么,我学什么。

所以,Hadoop的核心部分,基本上都有Google的影子。

2008年1月,Hadoop成功上位,正是成为Apache基金会的顶级项目。

同年2月,Yahoo宣布建成了一个拥有1万个内核的Hadoop集群,并将自己的搜索引擎产品部署在上面。

7月,Hadoop打破世界纪录,成为最快排序1TB数据的系统,用时209秒。

回到主题

Lucene是一套信息检索工具包!jar包!不包含搜索引擎系统!

包含的:索引结构!读写索引的工具!排序,搜索规则…工具类!

Lucene和ElasticSearch关系:

- ElasticSearch是基于Lucene做了一些封装和增强(我们上手十分简单!)

ElasticSearch概述

Elasticsearch,简称为 es,es 是一个基于 json 的开源,高扩展的分布式全文检索引擎,它可以近乎实时的存储、检索数据,本身扩展性很好,可以扩展到上百台服务器,处理 pb 级别的数据,es 也使用 java 开发并使用 Lucene 作为其核心来实现所有索引和搜索的功能,但是它的目的是通过简单的 Restful API来隐藏 Lucene 的复杂性,从而让全文搜索变得简单。

据国际权威的数据库产品评测机构 DB Engines 的统计,在 2016 年 1 月,ElasticSearch 已超过 solr 等,成为排名第一的搜索引擎类应用;

历史

多年前,一个叫做 Shay Banon 的刚结婚不久的失业开发者,由于妻子要去伦敦学习厨师,他便跟着也去了。在他找工作的过程中,为了给妻子构建一个食谱的搜索引擎,他开始构建一个早期版本的Lucene。

直接基于Lucene工作会比较困难,所以 Shay 开始抽象 Lucene 代码以便 java 程序员可以在应用中添加搜索功能。他发布了他的第一个开源项目,叫做 Compass"。

后来 Shy 找到一份工作,这份工作处在高性能和内存数据网格的分布式环境中,因此高性能的、实时的、分布式的搜索引擎也是理所当然需要的,然后他决定重写 Compass 库使其成为一个独立的服务叫做 Elasticsearch。

第一个公开版本出现在 2010 年 2 月,在那之后 Elasticsearch 已经成为 Github 上最受欢迎的项目之一,代码贡献者超过300人。一家主营 Elasticsearch 的公司就此成立,他们一边提供商业支持一边开发新功能,不过 Elasticsearch 将永远开源目对所有人可用。

谁在使用

- 维基百科,类似百度百科,全文检索,高亮,搜索推荐(权重);

- The Guardian (国外新闻网站),类似搜孤新闻,用户行为日志(点击,浏览,收藏,评论)+ 社交网络数据数据分析,给到每篇新闻文章的作者,让他知道他的文章的公众反馈(好,坏,热门,垃圾,鄙视,崇拜)

- Stack Overflow (国外的程序异常讨论论坛),it 问题,程序的报错,提交上去,有人会跟你讨论和回答,全文检索,搜索相关问题和答案,程序报错了,就会将报错信息粘贴到里面去,搜索有没有对应的答案

- GitHub (开源代码管理),搜索上千亿行代码;

- 电商网站检索商品;

- 日志数据分析,logstash 采集日志,ES 进行复杂的数据分析,ELK 技术,elasticsearch + logstash + kibana;

- 商品价格监控网站,用户设定某商品的价格阈值,当低于该阈值的时候,发送通知消息给用户,比如说订阅牙膏的监控,如果高露洁牙膏的家庭套装低于 50 块钱,就通知我,我就去买;

- BI 系统,商业智能,Business Intelligence,比如说有个大型商场集团,分析一下某某区域最近 3 年的用户消费金额的趋势以及用户群体的组成构成,产出相关的数张报表;ES 执行数据分析和挖掘,Kibana 进行数据可视化;

- 国内:站内搜索(电商,招聘,门户,等等),it 系统搜索 (OA,CRM,ERP 等等),数据分析(ES 热门的一个使用场景);

ES与Solr的区别

ElasticSearch简介

ElasticSearch是一个实时分布式搜索和分析引擎,它让你以前所未有的速度处理大数据成为可能。

它用于全文搜索、结构化搜索、分析以及将这三者混合使用:

维基百科使用 Elasticsearch 提供全文搜索并高亮关键字,以及输入实时搜索 (search-asyou-type) 和搜索纠错 (did-you-mean) 等搜索;

建议功能:英国卫报使用 Elasticsearch 结合用户日志和社交网络数据提供给他们的编辑以实时的反馈,以便及时了解公众对新发表的文章的回应。

StackOverflow 结合全文搜索与地理位置查询,以及 more-like-this 功能来找到相关的问题和答案。

Github 使用 Elasticsearch 检索 1300 亿行的代码;

但是 Elasticsearch 不仅用于大型企业,它还让像 DataDog 以及 Klout 这样的创业公司将最初的想法变成可扩展的解决方案。

Elasticsearch 可以在你的笔记本上运行,也可以在数以百计的服务器上处理 PB 级别的数据。

Elasticsearch 是一个基于 Apache Lucene ™ 的开源搜索引擎,无论在开源还是专有领域,Lucene 可以被认为是迄今为止最先进、性能最好的、功能最全的搜索引擎库,但是,Lucene 只是一个库,想要使用它,你必须使用 java 来作为开发语言并将其直接集成到你的应用中,更糟糕的是 Lucene 非常复杂,你需要深入了解检索的相关知识来理解它是如何工作的,Elasticsearch 也使用 java 开发并使用 Lucene 作为其核心来实现所有索引和搜索的功能,但是它的目的是通过简单的Restful API (比如:http://localhost:81/app/zhangsan)来隐藏 Lucene 的复杂性,从而让全文搜索变得简单。

Solr简介

Solr是Apache下的一个顶级开源项目,采用Java开发,它是基于Lucene的全文搜索服务器。Solr提供了比Lucene更为丰富的查询语言,同时实现了可配置、可扩展,并对索引、搜索性能进行了优化

Solr可以独立运行,运行在Jetty、Tomcat等这些Servlet容器中,Solr索引的实现方法很简单,用POST方法向Solr服务器发送一个描述Field 及其内容的XML文档,Solr根据xml文档添加、删除、更新索引。Solr搜索只需要发送HTTPGET请求,然后对Solr返回Xml.json等格式的查询结果进行解析,组织页面布局。Solr不提供构建UI的功能,Solr提供了一个管理界面,通过管理界面可以查询Solr的配置和运行情况。

solr是基于lucene开发企业级搜索服务器,实际上就是封装了lucene。

Solr是一个独立的企业级搜索应用服务器,它对外提供类似于Web-service的APl接口(比如:http://localhost:81/app?name=zhangsan)。用户可以通过http请求,向搜索引擎服务器提交一定格式的文件,生成索引;也可以通过提出查找请求,并得到返回结果。

Lucene简介

Lucene是apache软件基金会 jakarta项目组的一个子项目,是一个开放源代码的全文检索引擎工具包,但它不是一个完整的全文检索引擎,而是一个全文检索引擎的架构,提供了完整的查询引擎和索引引擎,部分文本分析引擎(英文与德文两种西方语言)。Lucene的目的是为软件开发人员提供一个简单易用的工具包,以方便的在目标系统中实现全文检索的功能,或者是以此为基础建立起完整的全文检索引擎。Lucene是一套用于全文检索和搜寻的开源程式库,由Apache软件基金会支持和提供。Lucene提供了一个简单却强大的应用程式接口,能够做全文索引和搜寻。在Java开发环境里Lucene是一个成熟的免费开源工具。就其本身而言,Lucene是当前以及最近几年最受欢迎的免费Java信息检索程序库。人们经常提到信息检索程序库,虽然与搜索引擎有关,但不应该将信息检索程序库与搜索引擎相混淆。

ElasticSearch和Solr的比较

ES vs Solr 总结

- es基本是开箱即用(解压就可以用),非常简单。Solr安装略微复杂一丢丢!

- Solr利用Zookeeper进行分布式管理,而Elasticsearch自身带有分布式协调管理功能。

- Solr支持更多格式的数据,比如JSON、XML、CSV,而Elasticsearch仅支持json文件格式。

- Solr官方提供的功能更多,而Elasticsearch 本身更注重于核心功能,高级功能多有第三方插件提供,例如图形化界面需要kibana友好支撑

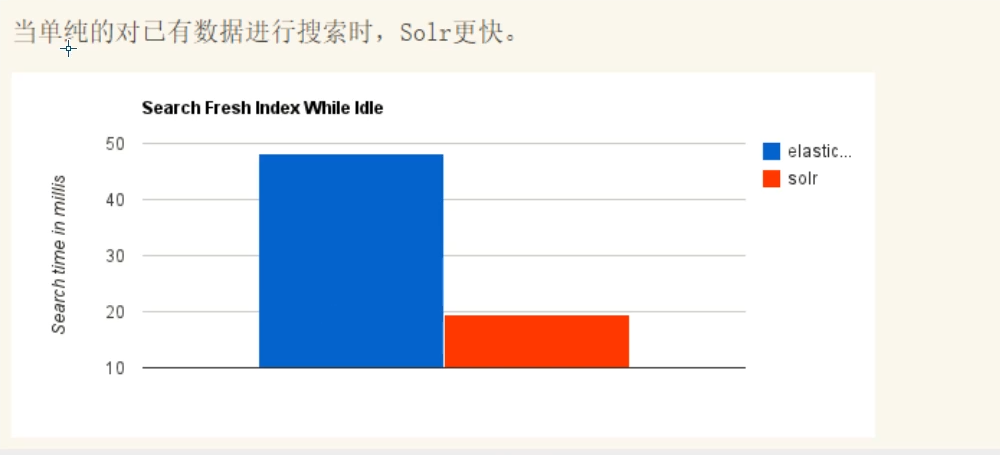

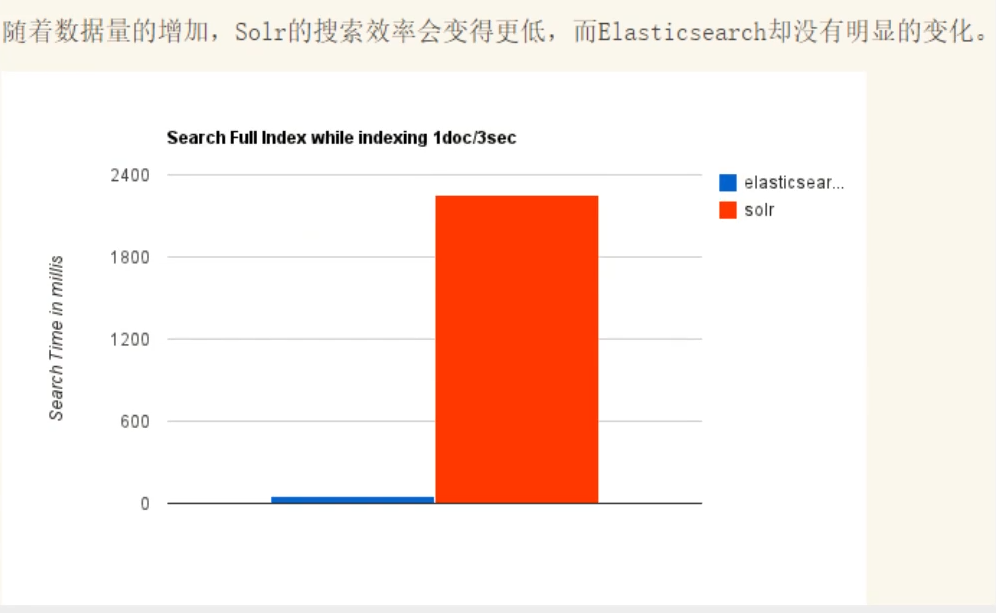

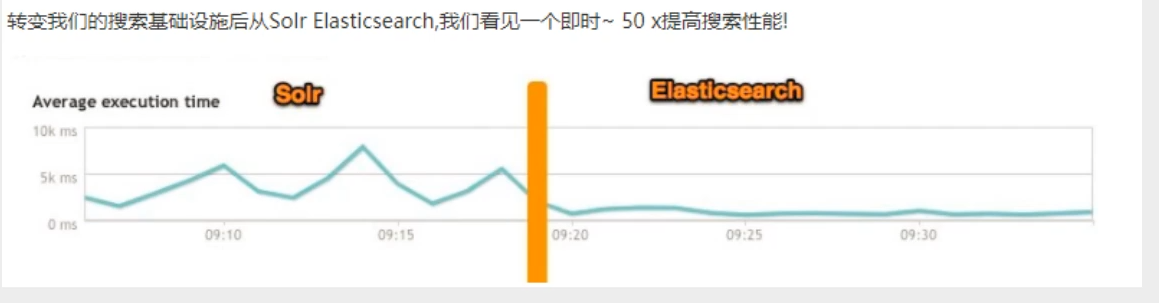

- Solr查询快,但更新索引时慢(即插入删除慢),用于电商等查询多的应用;

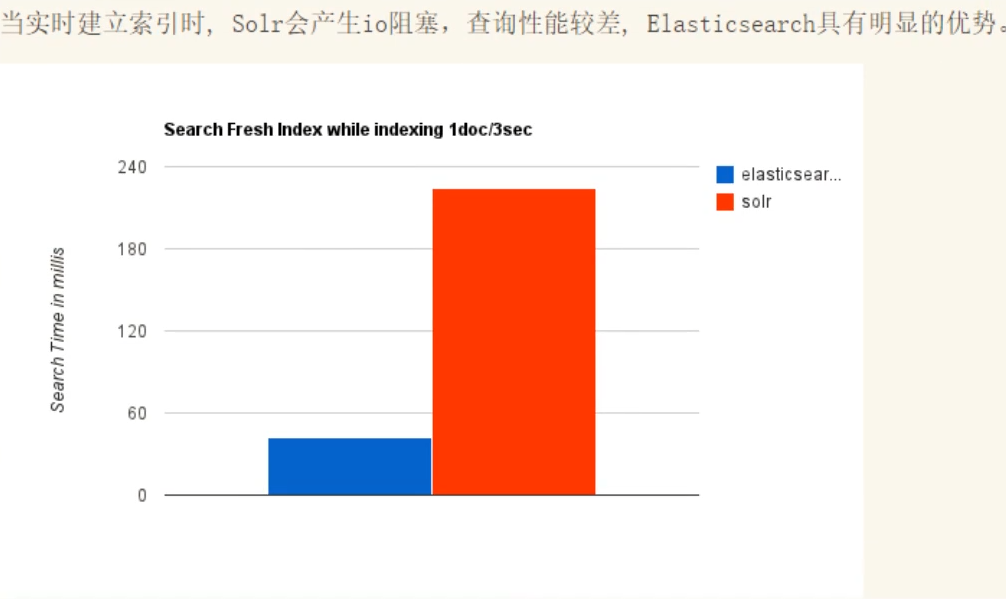

- ES建立索引快(即查询慢),即实时性查询快,用于facebook新浪等搜索。

- Solr是传统搜索应用的有力解决方案,但Elasticsearch更适用于新兴的实时搜索应用。

- Solr比较成熟,有一个更大,更成熟的用户、开发和贡献者社区,而Elasticsearch相对开发维护者较少,更新太快,学习使用成本较高

ElasticSearch安装

声明:JDK1.8,最低要求!ElasticSearch客户端,界面工具!

Java开发,ElasticSearch的版本和我们之后对应的java的核心jar包版本对应!JDK环境正常!

下载

ElasticSearch官网:https://www.elastic.co/cn/

![[]](https://img2023.cnblogs.com/blog/3369871/202401/3369871-20240108214706380-1378653203.png)

![[]](https://img2023.cnblogs.com/blog/3369871/202401/3369871-20240108214650945-1139566834.png)

点击即可下载!(Windows平台)

下载地址:https://www.elastic.co/cn/downloads/elasticsearch

我们这里先在Windows下学习!

ELK三剑客,解压即用!(web项目!前端环境!)

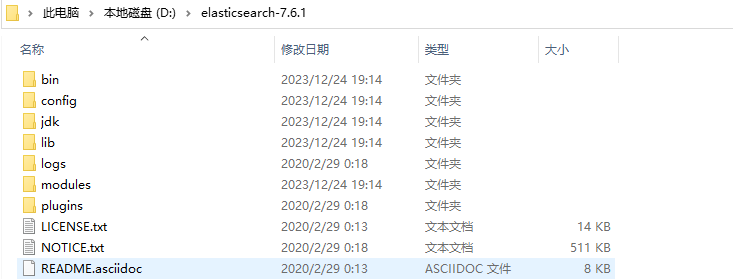

Windows下安装

解压

熟悉目录

- bin 启动文件

- config 配置文件

- log4j2 日志配置文件

- vm.options java虚拟机相关的配置(根据个人电脑内存大小设置,设置的越大,用起来越爽)

- elasticsearch.yml elasticsearch的配置文件! 默认 9200 端口!跨域!

- lib 相关jar包

- logs 日志!

- modules 功能模块

- plugins 插件!

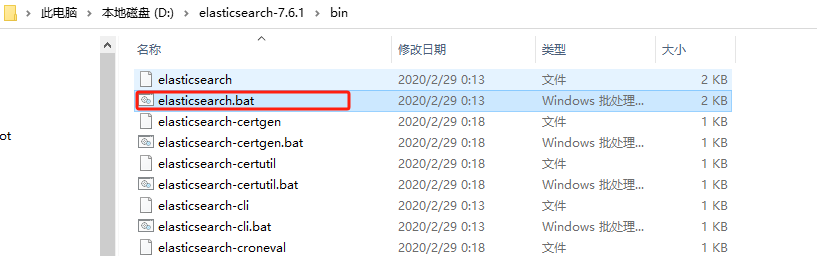

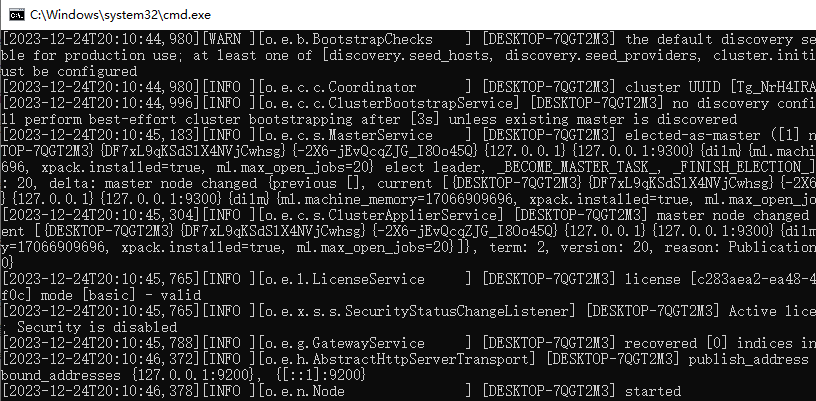

启动(以管理员身份运行)

打开bin目录,双击 elasticsearch.bat

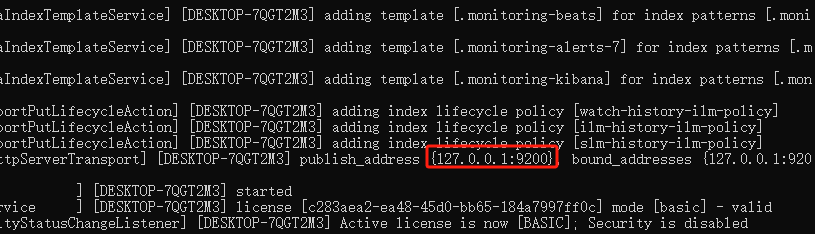

启动成功,可以看到端口号9200

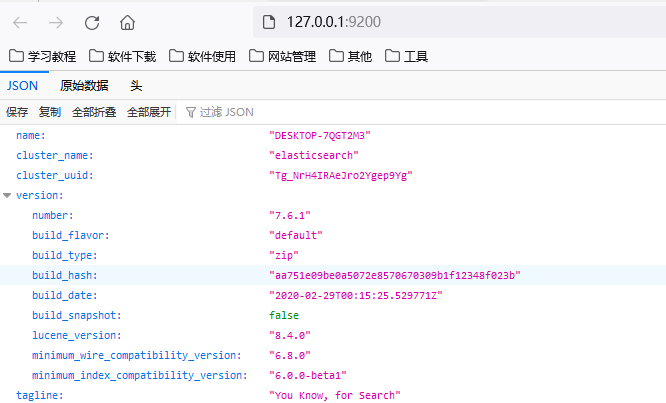

浏览器访问:9200

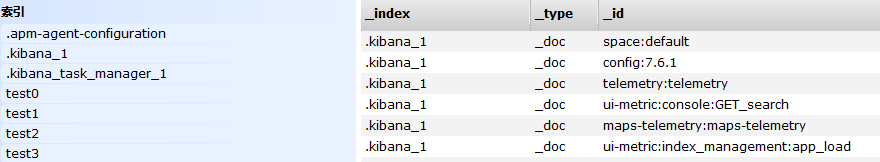

安装可视化界面es head插件

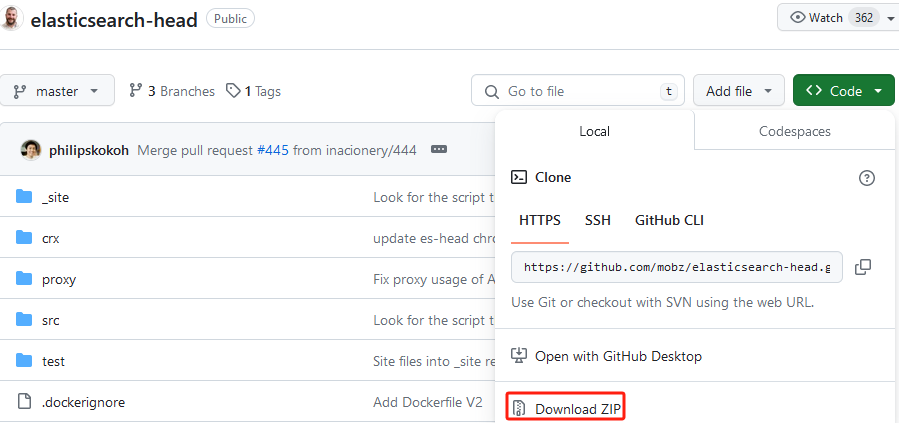

下载

下载地址:https://github.com/mobz/elasticsearch-head

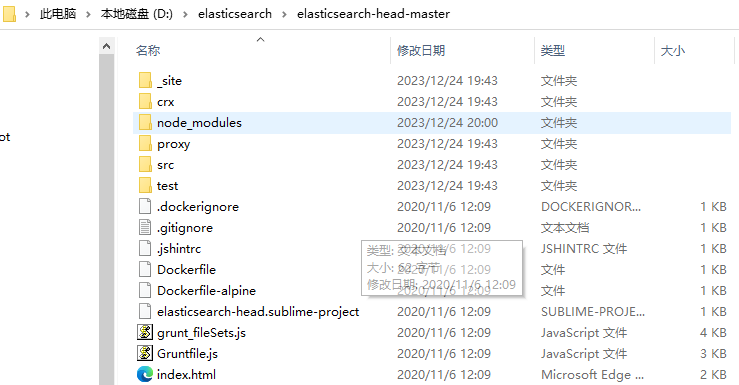

目录结构

使用npm install命令安装依赖

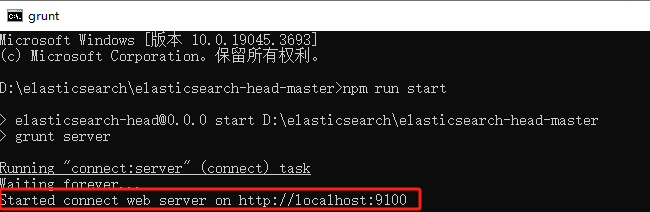

启动

npm run start

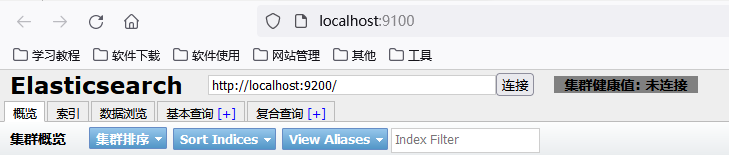

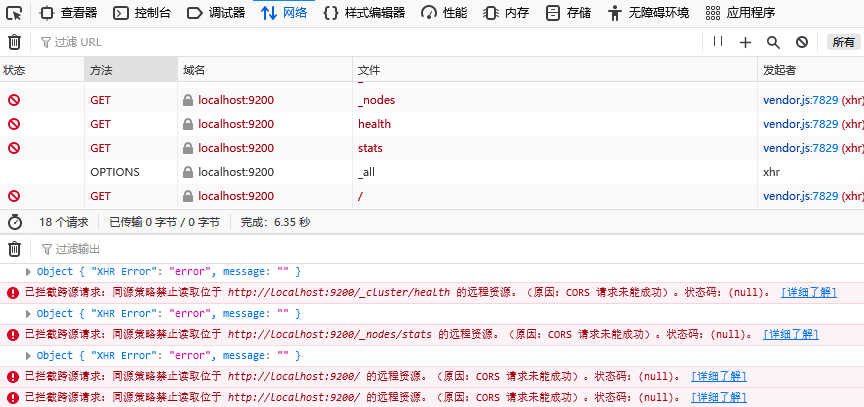

出现跨域问题

解决跨域问题

配置elasticsearch.yml文件

# 开启跨域支持

http.cors.enabled: true

# 允许所有人都能访问

http.cors.allow-origin: "*"

启动elasticsearch服务

启动可视化页面,成功,跨域解决

初学者,可以把ES中的索引当做MySQL中的库,文档当做库中的数据(一个文档即为一行数据)!

这个head我们就把它当做数据展示工具!我们后面所有的查看,用Kibana

Kibana

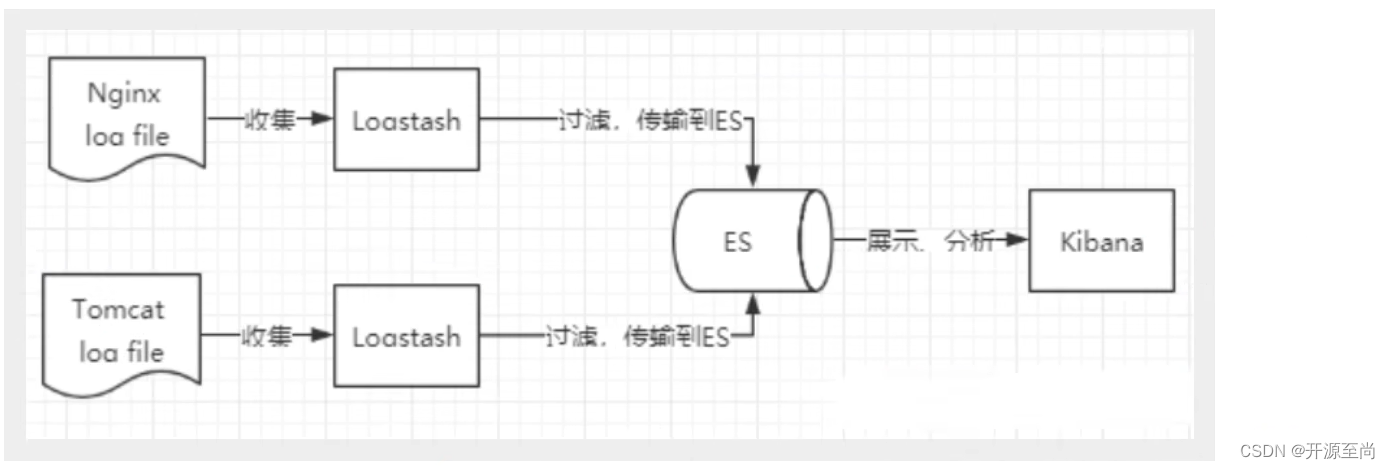

了解ELK

ELK是elastic公司提供的一套完整的日志收集以及展示的解决方案,是Elasticsearch,Logstash 和 Kibana三个产品的首字母缩写,这三款都是开源产品。

ElasticSearch(简称ES),是一个实时的分布式搜索和分析引擎,它可以用于全文搜索,结构化搜索以及分析。

Logstash,是一个数据收集引擎,主要用于进行数据收集、解析,并将数据发送给ES。支持的数据源包括本地文件、ElasticSearch、MySQL、Kafka等等。

Kibana,为 Elasticsearch 提供了分析和 Web 可视化界面,并生成各种维度表格、图形。

安装Kibana

Kibana是一个开源的分析和可视化平台,设计用于和Elasticsearch一起工作。

你用Kibana来搜索,查看,并和存储在Elasticsearch索引中的数据进行交互。

你可以轻松地执行高级数据分析,并且以各种图标、表格和地图的形式可视化数据。

Kibana使得理解大量数据变得很容易。它简单的、基于浏览器的界面使你能够快速创建和共享动态仪表板,实时显示Elasticsearch查询的变化。

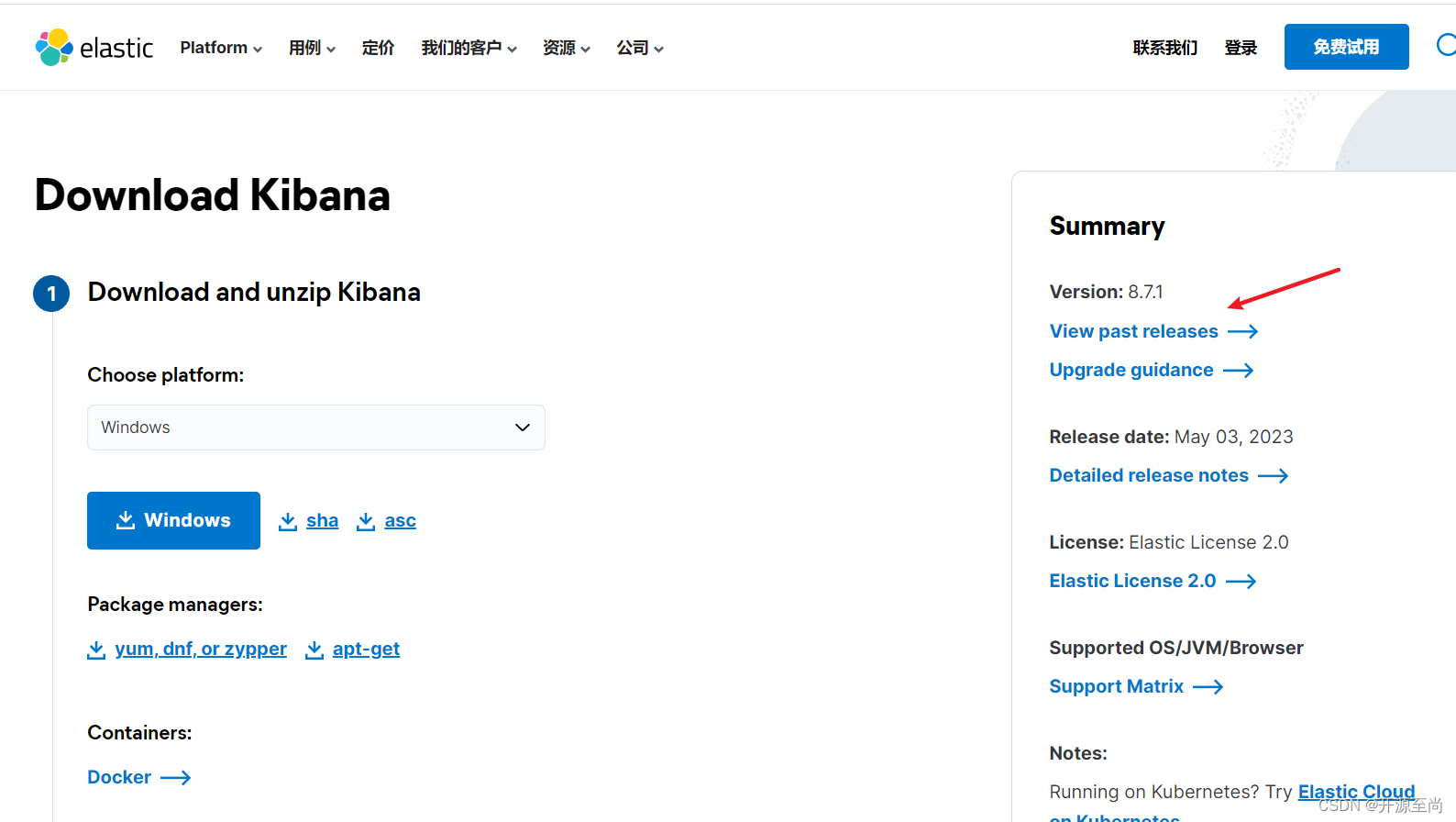

下载Kibana

Kibana的版本要和es的版本一致

官网:https://www.elastic.co/cn/kibana/

好处:ELK基本上都是是拆箱即用!

解压

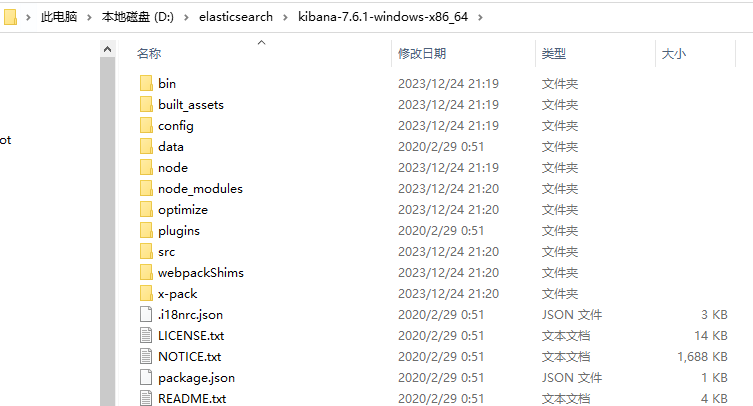

解压后的目录

启动测试

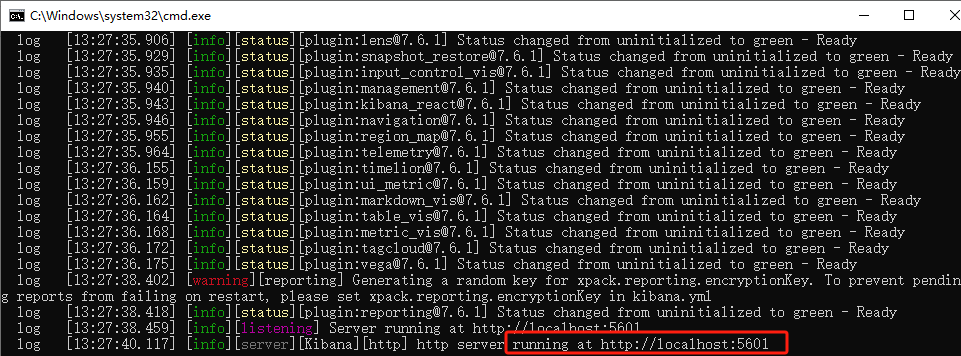

切换到bin目录下,双击kibana.bat启动

访问测试

访问http://localhost:5601

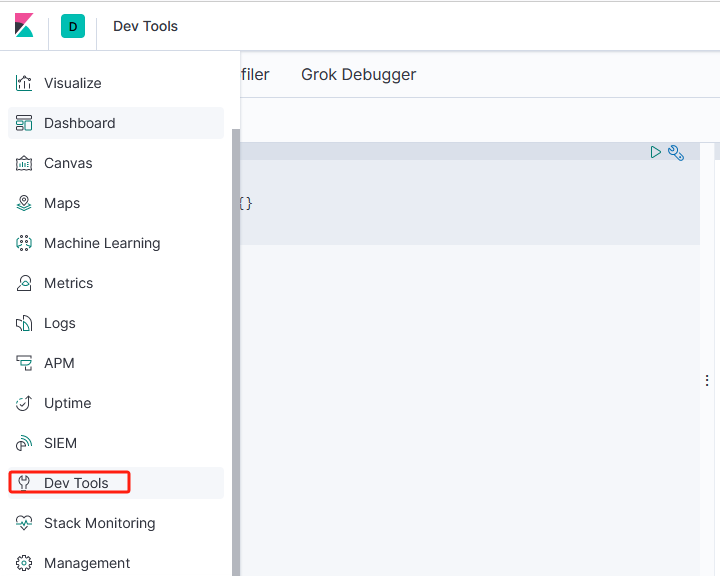

开发工具!(Post、curl、head、谷歌浏览器插件测试!)

我们之后的所有操作都在这里进行编写

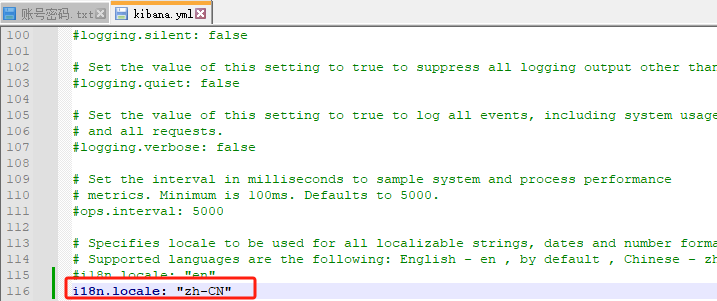

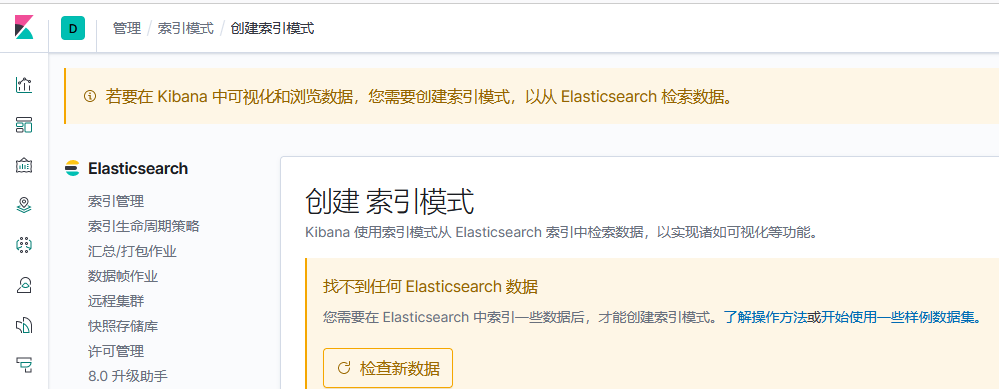

汉化

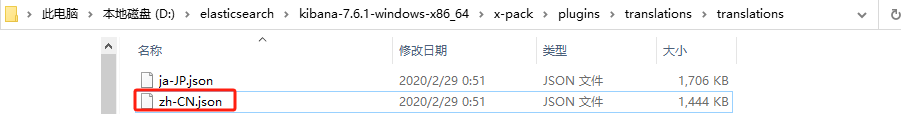

汉化!自己修改Kibana配置即可!zh-CN!

kibana.yml

zh-CN.json中文国际化文件的位置

重启Kibana测试,已经成为了中文

ES核心概念

概述

在前面的学习中,我们已经掌握的ES是什么,同时也把ES服务已经安装启动,那么ES是如何取存储数据,数据结构是什么,有事如何实现搜索的呢?我们先来聊聊ElasticSearch的相关概念吧!

集群、节点,索引、类型、文档、分片、映射是什么?

elasticsearch是面向文档的

关系行数据库和elasticsearch客观的对比!

| Relational DB | Elasticsearch |

|---|---|

| 数据库(database) | 索引(indices) |

| 表(table) | types |

| 行(rows) | documents |

| 字段(columns) | feilds |

ElasticSearch(集群)中可以包含多个索引(数据库),每个索引中可以包含多个类型(表),每个类型下又包含多个文档(行),每个文档中又包含多个字段(列)。

物理设计:

ElasticSearch在后台把每个索引划分成多个分片,每个分片可以在集群中的不同服务端间迁移;

逻辑设计:

一个索引类型中,包含多个文档,比如说文档1、文档2。当我们索引一篇文档时,可以通过这样的顺序找到它:索引>类型>文档id,通过这个组合我们就能索引到某个具体的文档,注意:id不必是整数,实际上它是字符串;

文档

之前说ElasticSearch是面向文档,那么就意味着索引和搜索数据的最小单位是文档,ElasticSearch中,文档有几个重要属性:

- 自我包含,一篇文档中同时包含字段和对应的值,也就是同时包含key-value;

- 可以是层次型的;

- 灵活的结构,文档不依赖预先定义的模式;

尽管我们可以随意的新增或者忽略某个字段,但是,每个字段的类型非常重要,比如一个年龄字段类型,可以是字符,也可以是整型,因为ES会包含字段和类型之间的映射及其他的设置,这种映射具体到每个映射的每种类型,这也是为什么在ES中,类型有时候也称为映射类型。

类型

类型是文档的逻辑容器,就像关系型数据库一样,表格是行的容器。类型中对于字段的定义称为映射,比如name映射为字符串类型,我们说文档是无模式的,他们不需要拥有映射中所定义的所有字段,比如新增一个字段,那么ES是怎么做的呢?ES会自动将新字段加入映射,但是这个字段不确定它是什么类型,ES就开始猜,如果这个值是18,那么ES就会认为它是整形,但是ES也可能猜不对,所以最安全的方式就是提前定义好所需要的映射,这点跟关系型数据库殊途同归了,先定义好字段,然后再使用。

索引

就是数据库!

索引是映射类型的容器,ES中的索引是一个非常大的文档集合,索引存储了映射类型的字段和其他设置,然后它们被存储到了各个分片上。

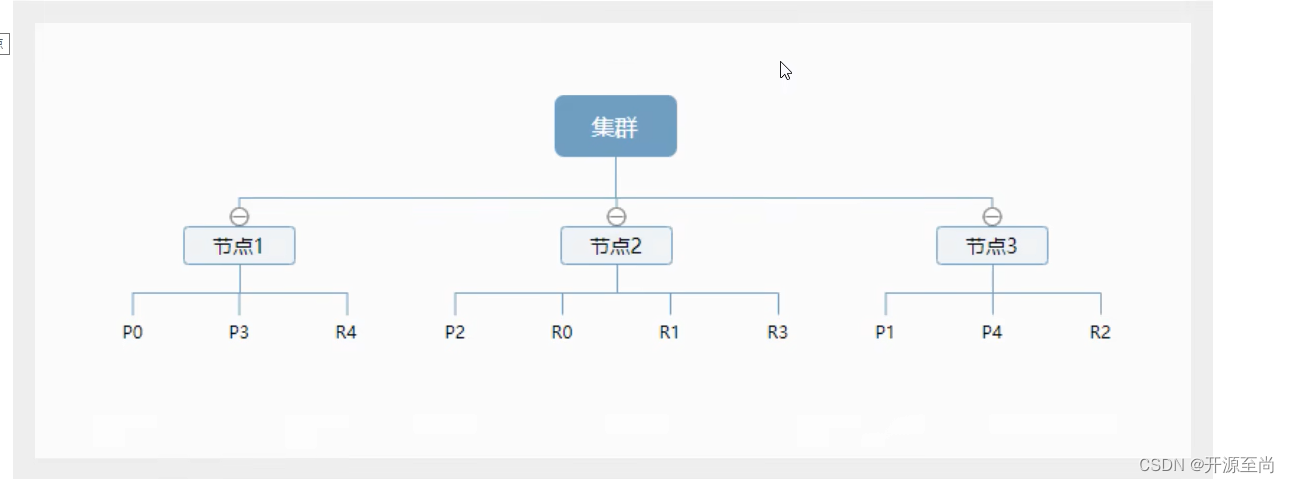

物理设计:节点与分片 如何工作

一个集群至少有一个节点,而一个节点就是一个ES进程,节点可以有多个索引。如果你创建索引,那么索引默认会有5个分片(primary shard,又称主分片)构成的,每一个主分片会有一个副本(又称复制分片)

上面是一个有3个节点的集群,可以看到主分片和对应的复制分片都不会在同一个节点内,这样有利于某个节点挂掉了,数据也不至于丢失,实际上,一个分片是一个Lucene索引,一个包含倒排索引的文件目录,倒排索引的结构使得ES在不扫描全部文档的情况下,就能告诉你哪些文档包含特定的关键字。

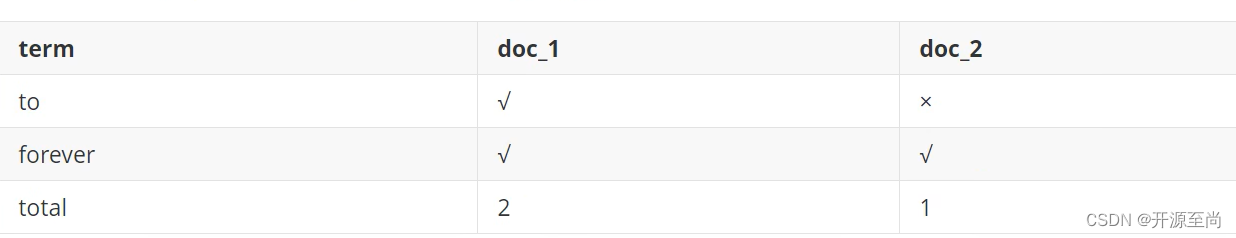

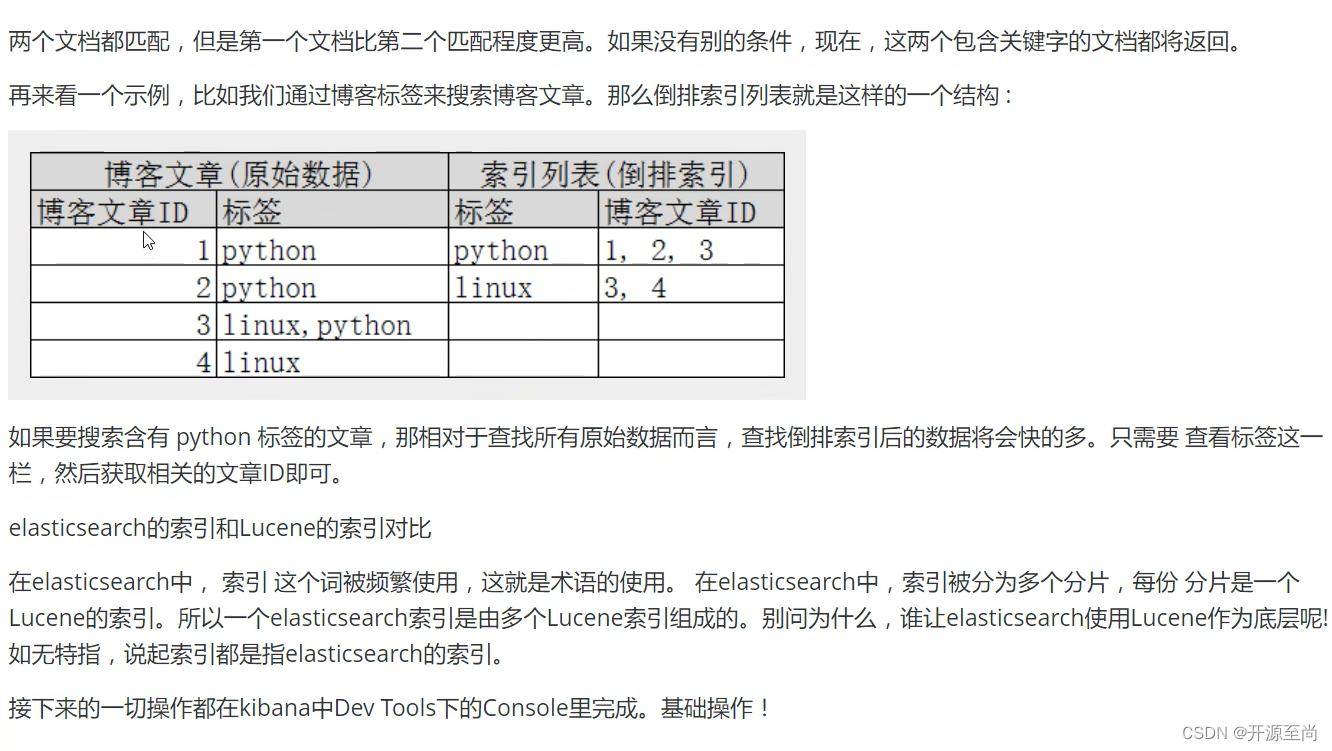

倒排索引

现在我们试图搜索to forever,只要查到包含每个词条的文档

IK分词器插件

什么是IK分词器

分词:即把一段中文或者别的划分成一个个的关键字,我们在搜索时候会把自己的信息进行分词,会把数据库中或者索引库中的数据进行分词,然后进行一个匹配操作,默认的中文分词是将每个字看成一个词,比如“我爱狂神”会被分为“我“,”爱“,”狂“”,“神”,这显然是不符合要求的,所以我们需要安装中文分词器ik来解决这个问题。

IK提供了两个分词算法:ik_smart和ik_max_word,其中ik_smart为最少切分,ik_max_word为最细粒度划分!一会我们测试!

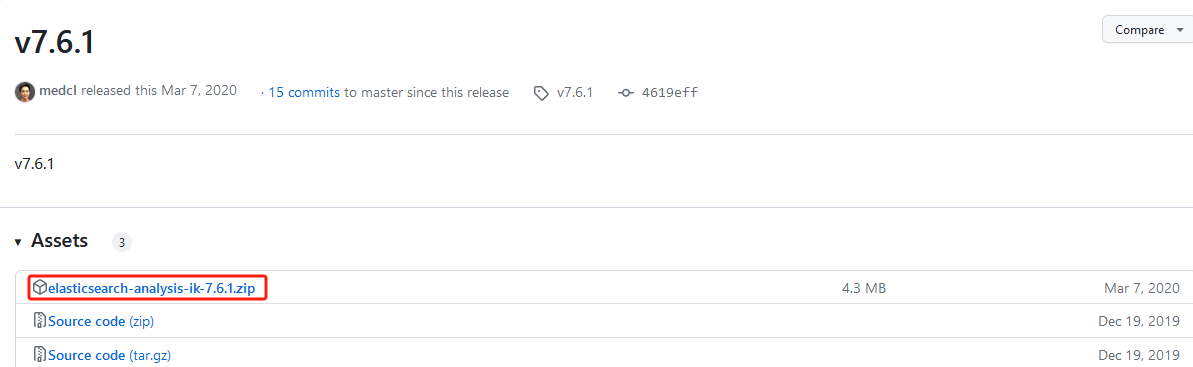

安装

下载

需要和Elasticsearch的版本相同

地址:https://github.com/medcl/elasticsearch-analysis-ik/releases/tag/v7.6.1

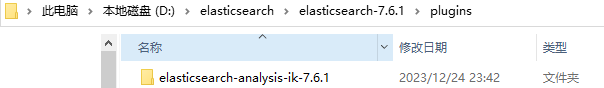

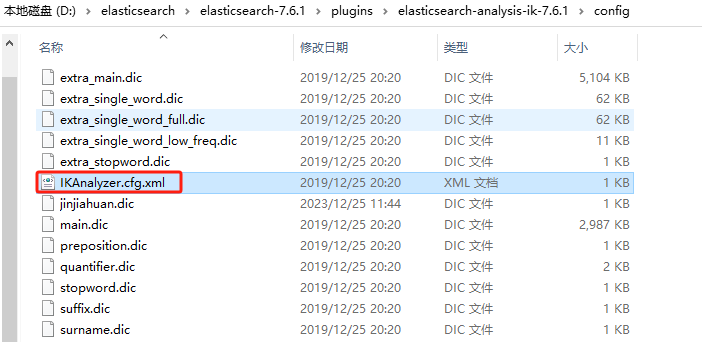

安装

放入到Elasticsearch中的插件目录下即可,本机的插件目录是D:\elasticsearch\elasticsearch-7.6.1\plugins

测试

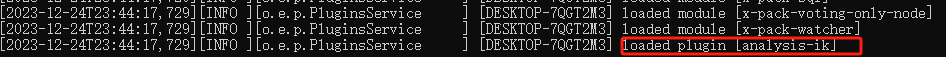

重启观察ES,可以看到IK分词被加载

访问Kibaba:http://localhost:5601

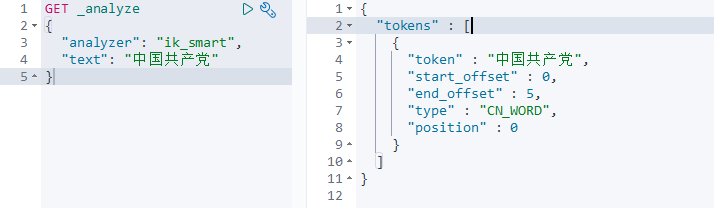

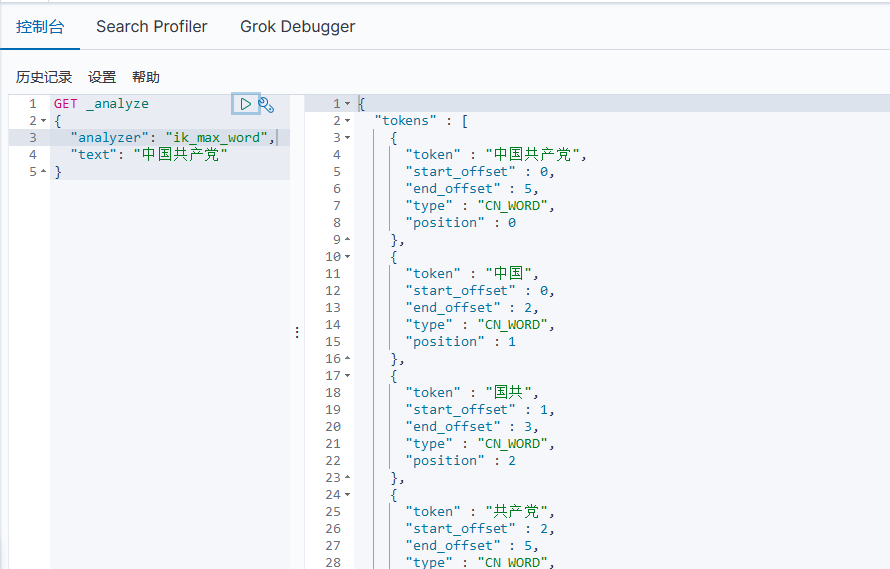

查看不同的分词效果

最小粒度划分

ik_smart

最大粒度划分

ik_max_word

使用

拓展字典

创建自定义字典

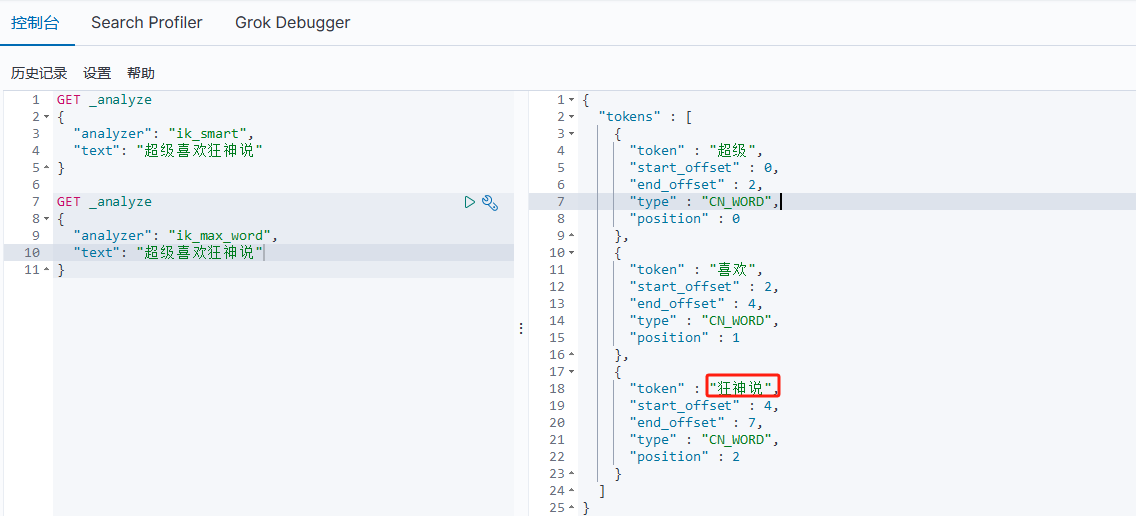

比如"超级喜欢狂神说",使用默认ik分词器的话,会把"狂神说"拆分成"狂"、"神"、"说"三个词,这并不是我们想要的结果,所以我们要把"狂神说"添加到字典中,将它作为一个词

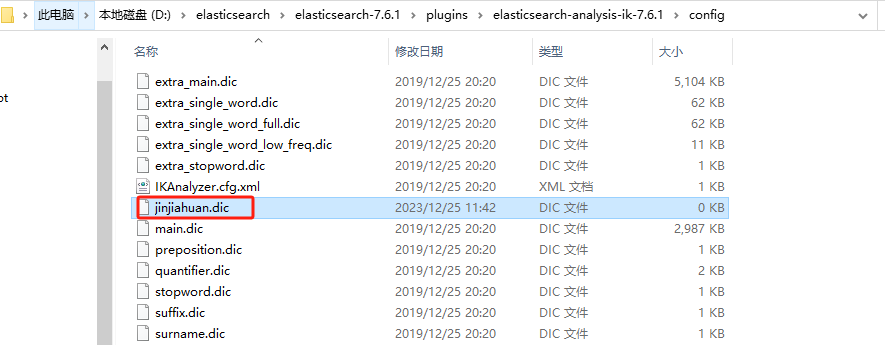

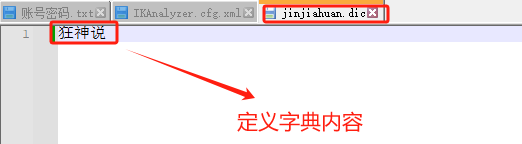

定义自己的字典

jinjiahuan.dic

编辑自定义字典

jinjiahuan.dic

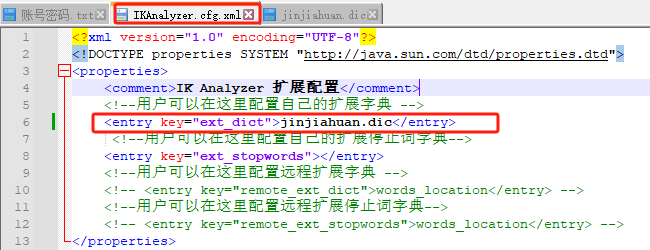

配置自定义字典

在拓展字典位置指定自定义字典

测试

重启es,测试,不管是最小粒度划分还是最大粒度划分,狂神说被分成了一个词

以后的话,我们需要自己配置分词,就在自己定的dic文件中进行配置即可!

Rest风格说明

一种软件架构封过,而不是标准,只是提供了一组设计原则和约束条件,它主要用于客户端和服务器交互类的软件,基于这个风格设计的软件可以简洁,更有层次,更易于实现缓存等机制;

基本Rest命令说明:

| method | url地址 | 描述 |

|---|---|---|

| PUT | localhost:9200/索引名称/类型名称/文档id | 创建文档(指定文档id) |

| POST | localhost:9200/索引名称/类型名称 | 创建文档(随机文档id) |

| POST | localhost:9200/索引名称/类型名称/文档id/_update | 修改文档 |

| DELETE | localhost:9200/索引名称/类型名称/文档id | 删除文档 |

| GET | localhost:9200/索引名称/类型名称/文档id | 查询文档通过文档id |

| POST | localhost:9200/索引名称/类型名称/_search | 查询所有数据 |

es类型

- 字符串类型

text、keyword - 数值类型

long、integer、short、byte、double、float、half float、scaled float - 日期类型

date - 布尔值类型

boolean - 二进制类型

binary - 等等…

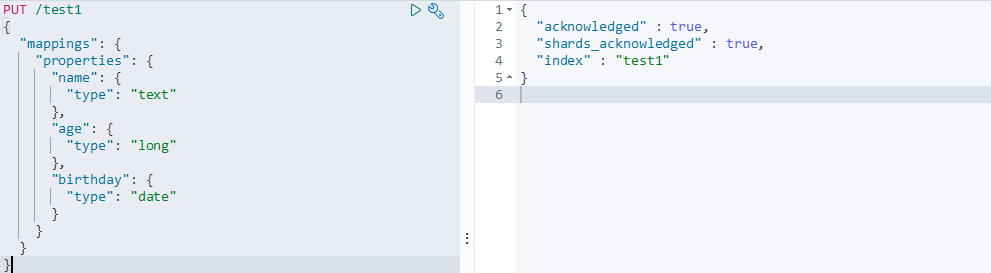

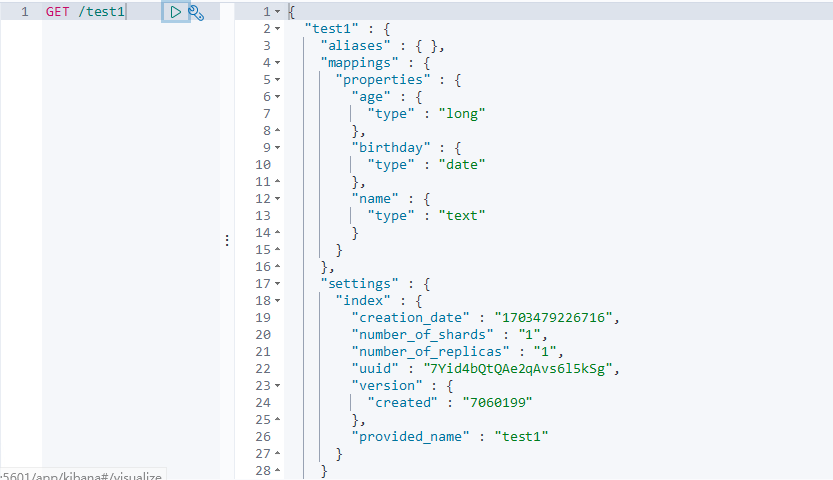

关于索引的基本操作

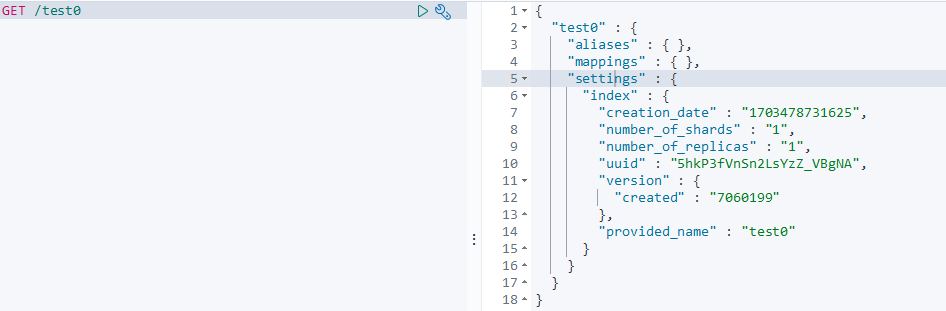

创建索引

指定映射规则

创建一个索引,指定映射规则(字段类型)

PUT /test1

{

"mappings": {

"properties": {

"name": {

"type": "text"

},

"age": {

"type": "long"

},

"birthday": {

"type": "date"

}

}

}

}

索引创建成功

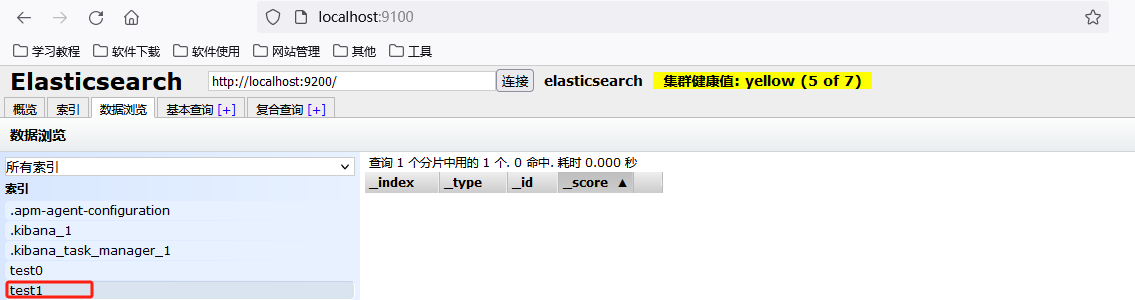

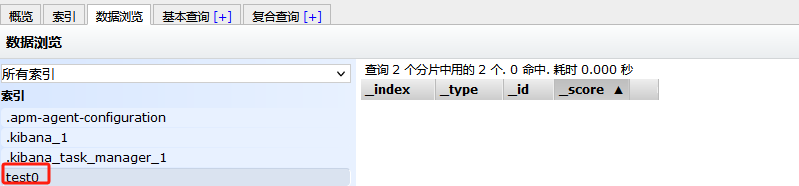

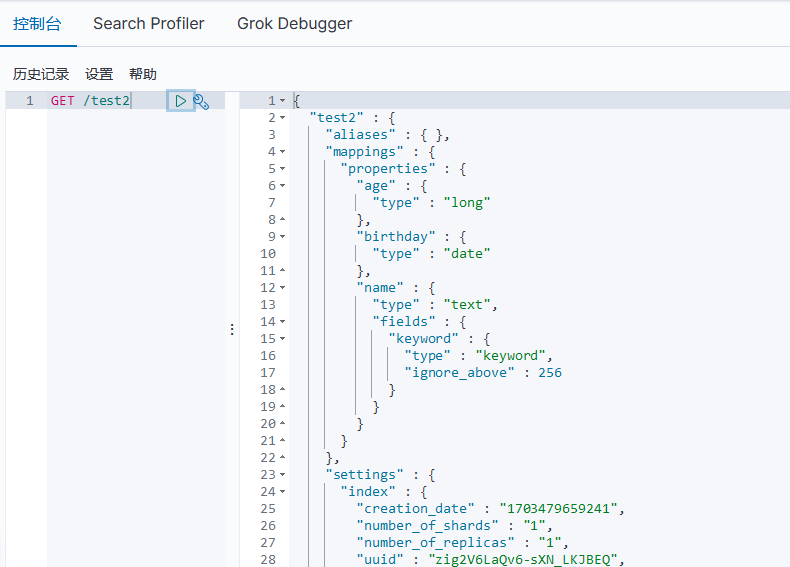

不指定映射规则

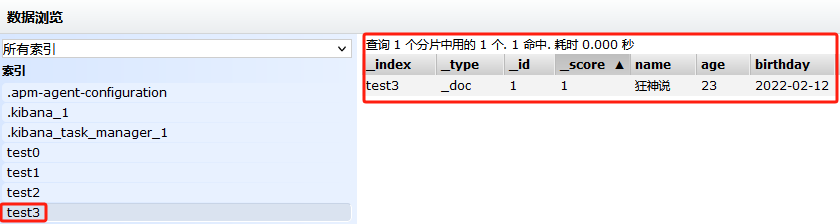

put /test0

查看索引创建成功

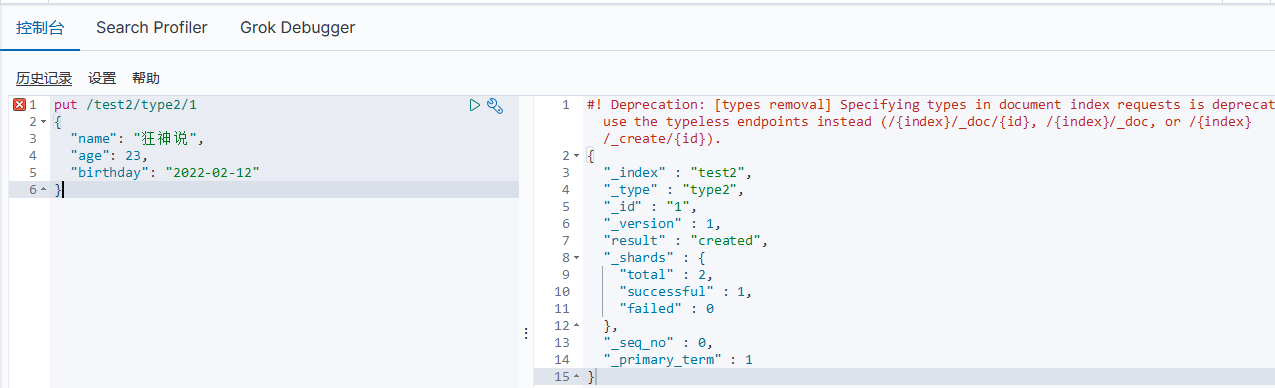

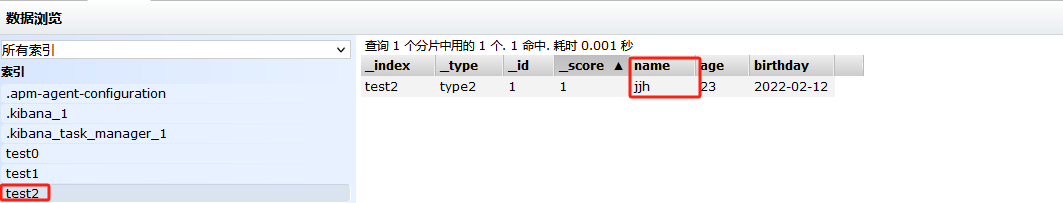

创建文档

指定类型名

PUT /索引名/~类型名~/文档id

{请求体}

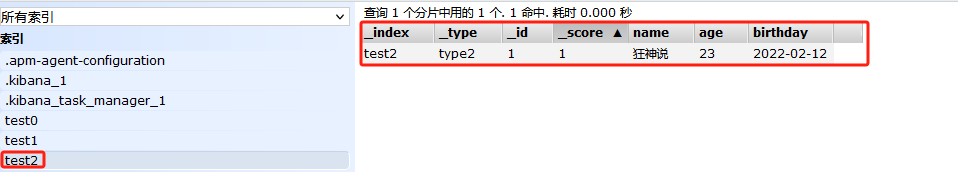

put /test2/type2/1

{

"name": "狂神说",

"age": 23,

"birthday": "2022-02-12"

}

索引创建成功

完成了自动增加了索引!数据也成功的添加了,这就是我说大家在初期可以把它当做数据库学习的原因!

使用默认的类型名

PUT /索引名/_doc/文档id

{请求体}

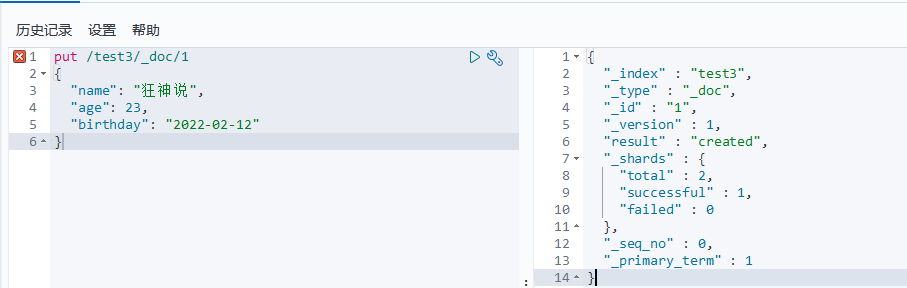

put /test3/_doc/1

{

"name": "狂神说",

"age": 23,

"birthday": "2022-02-12"

}

查看,数据创建成功

获取索引

获取索引

GET /索引名

获取未指定映射规则的索引

获取指定映射规则的索引

获取指定类型(test2指定的类型是type2)的文档索引

获取使用默认类型(默认类型是doc)的文档索引

发现一个索引如果没有指定映射规则,添加文档后,会有默认的字段类型

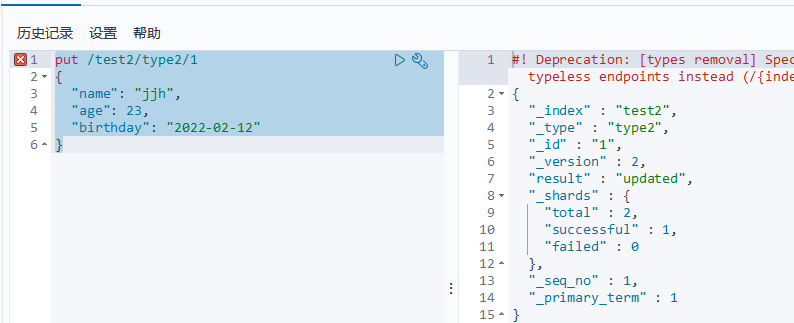

更新索引

put

使用put命令会进行覆盖

put /test2/type2/1

{

"name": "jjh",

"age": 23,

"birthday": "2022-02-12"

}

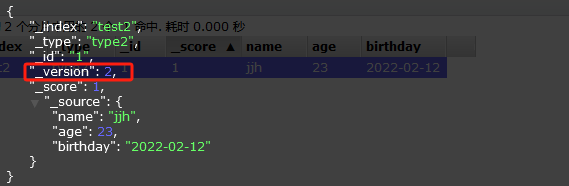

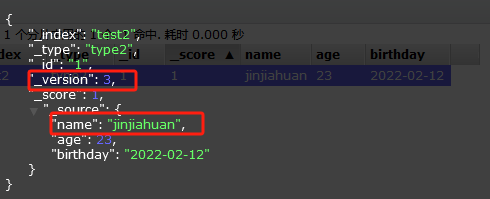

数据已经被修改了

数据的版本号加1

update

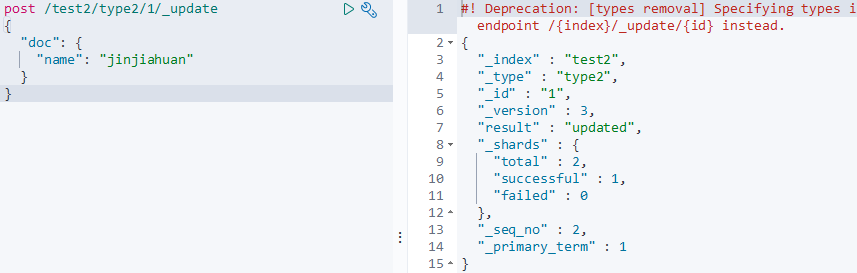

post /test2/type2/1/_update

{

"doc": {

"name": "jinjiahuan"

}

}

数据成功被修改

删除索引

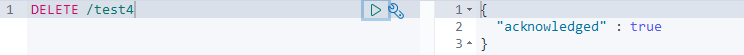

通过DELETE命令实现删除、根据你的请求来判断是删除索引还是删除文档记录、

DELETE /test1 # 请求到文档,就删除对应的文档;库就删除对应的库

索引test4成功被删除

关于文档的基本操作

基本操作

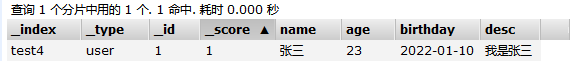

新增

put /test4/user/1

{

"name": "张三",

"age": 23,

"birthday": "2022-01-10",

"desc": "我是张三"

}

添加成功

修改

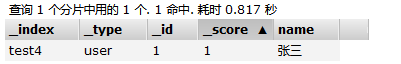

put

put方式会进行覆盖,相当于替换,不建议使用

put /test4/user/1

{

"name": "张三"

}

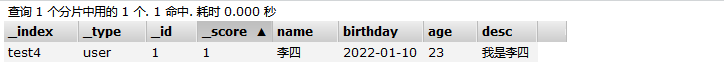

post

建议使用,灵活性更好

post /test4/user/1/_update

{

"doc": {

"name": "李四",

"age": 23,

"birthday": "2022-01-10",

"desc": "我是李四"

}

}

简单查询

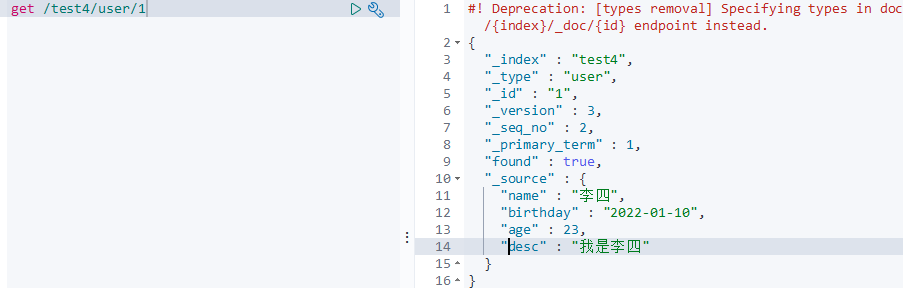

根据id查询

get /test4/user/1

根据条件查询

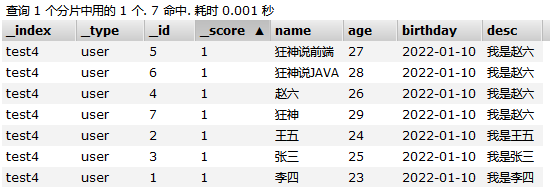

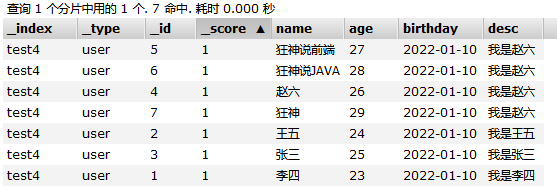

现在的数据

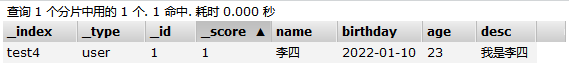

查询名字叫张三的数据

get /test4/user/_search?q=name:张三

没有查到数据

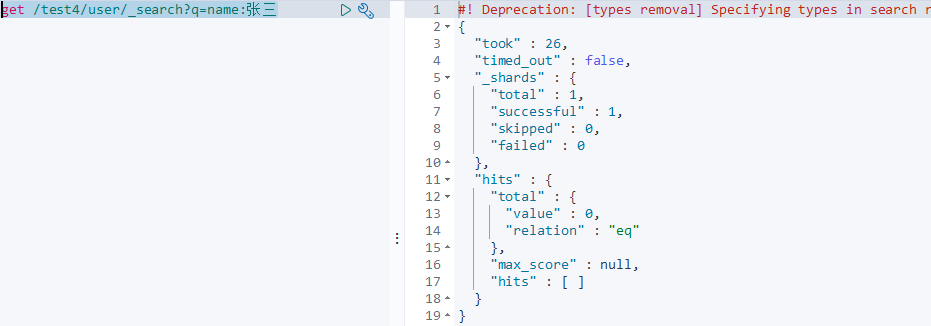

查询名字是李四的数据

get /test4/user/_search?q=name:李四

查到数据

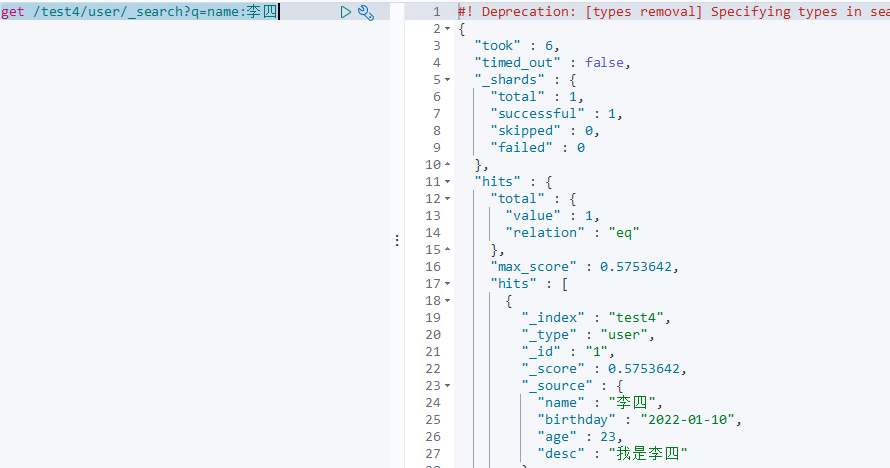

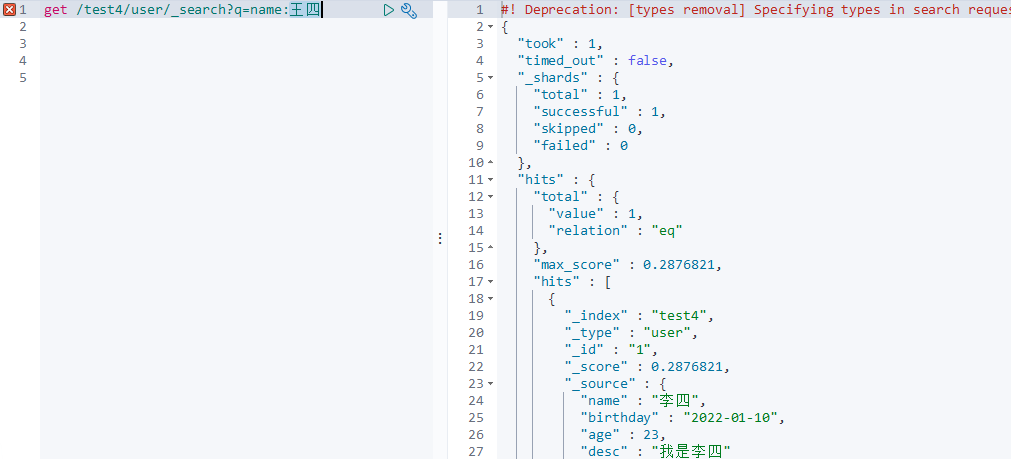

查询名字带"王四"的数据

get /test4/user/_search?q=name:王四

同样是找到了李四的数据,因为分词器的作用,将王四进行了拆分,在对"四"进行匹配的时候,将李四查询了出来

复杂操作

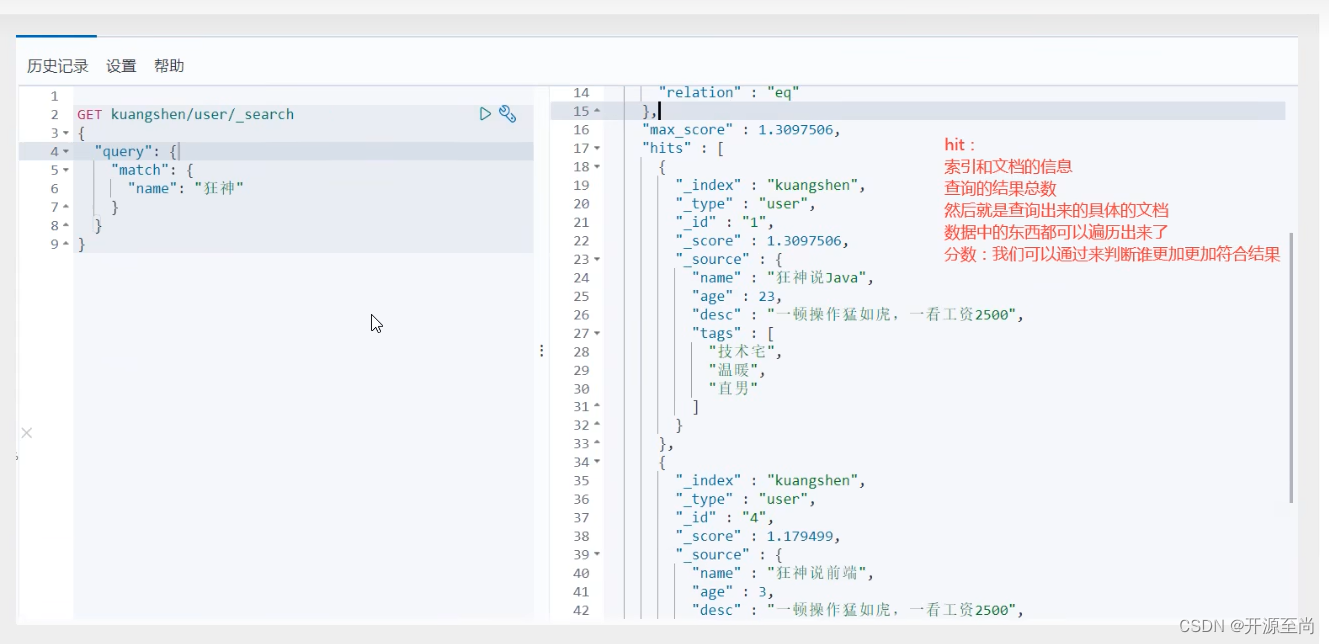

精确匹配

get /test4/user/_search

{

"query": {

"match": {

"name": "狂神说"

}

}

}

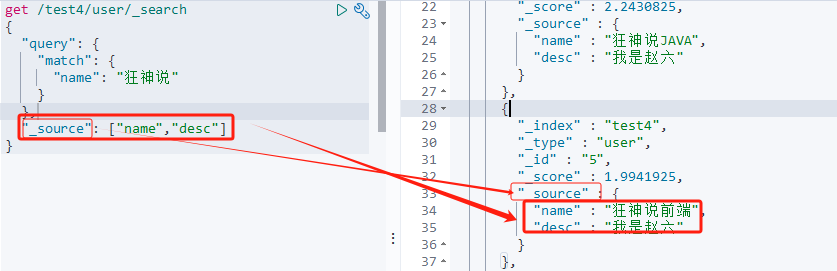

结果过滤

比如我们只要 name和desc的内容

get /test4/user/_search

{

"query": {

"match": {

"name": "狂神说"

}

},

"_source": ["name","desc"] # 只查询指定的字段

}

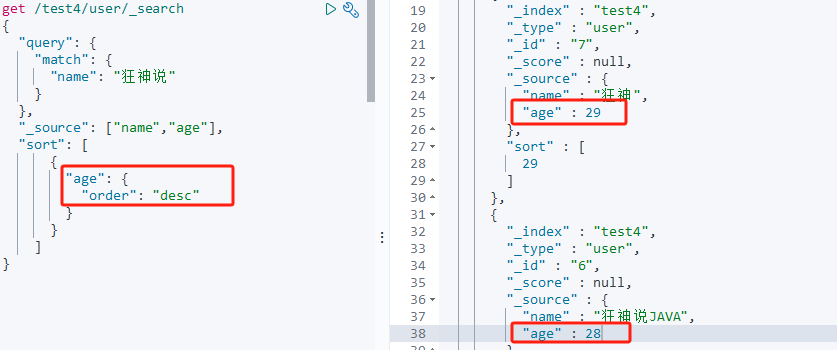

排序

现在的数据

get /test4/user/_search

{

"query": {

"match": {

"name": "狂神说"

}

},

"_source": ["name","desc"],

"sort": [

{

"age": {

"order": "desc" # 按照年龄进行倒序

}

}

]

}

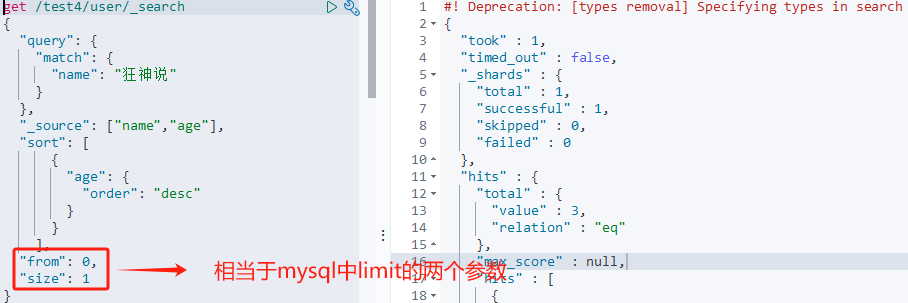

分页

get /test4/user/_search

{

"query": {

"match": {

"name": "狂神说"

}

},

"_source": ["name","age"],

"sort": [

{

"age": {

"order": "desc"

}

}

],

"from": 0,

"size": 1

}

根据分页,只查询出一条数据

数据的索引下标还是从0开始的,和学的所有的数据结构是一样的

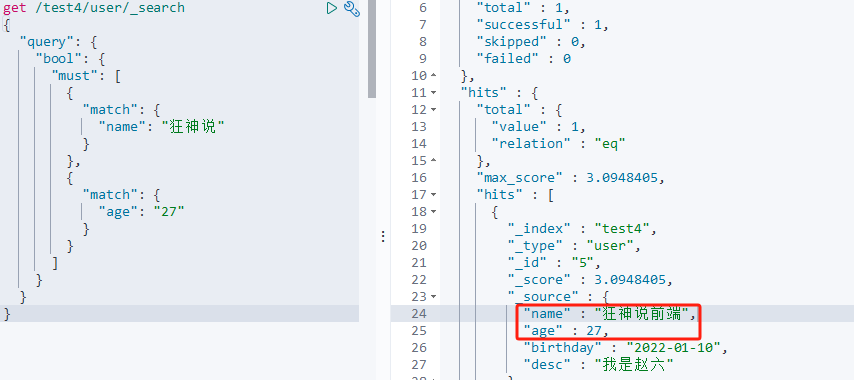

布尔值查询

must(and)

must(and),所有的条件都要符合,相当于:where id =1 and name = xxx

# 名字带"狂神说",age是27的数据

get /test4/user/_search

{

"query": {

"bool": {

"must": [

{

"match": {

"name": "狂神说"

}

},

{

"match": {

"age": "27"

}

}

]

}

}

}

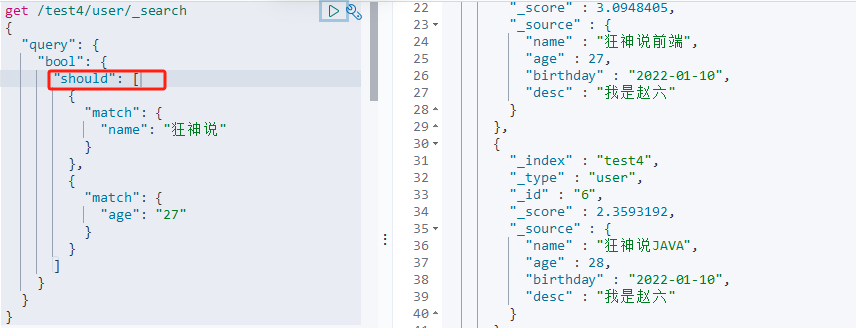

should(or)

should(or),只要其中一个满足条件即可,where id =1 or name = xxx

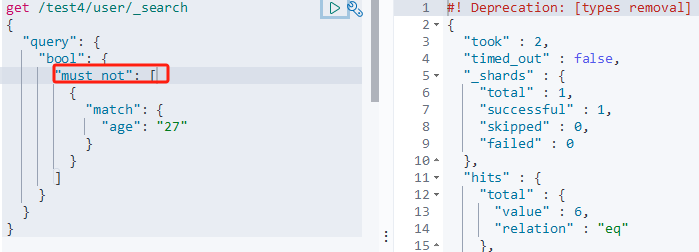

must_not (not)

查询年龄不是27岁的人

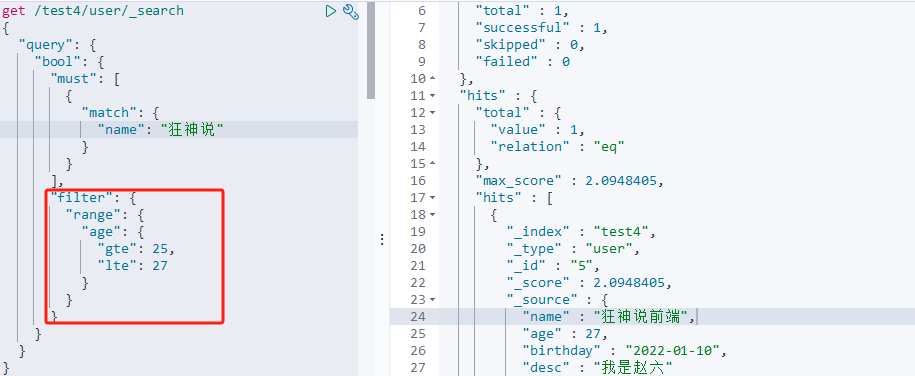

过滤器

年龄>=25 <=27岁的数据

get /test4/user/_search

{

"query": {

"bool": {

"must": [

{

"match": {

"name": "狂神说"

}

}

],

"filter": {

"range": {

"age": {

"gte": 25,

"lte": 27

}

}

}

}

}

}

- gt 大于

- gte 大于等于

- lt 小于

- lte 小于等于

多条件查询

get /test4/user/_search

{

"query": {

"match": {

"name": "三 四 五" # 如果想要匹配多个关键字,使用空格隔开

}

}

}

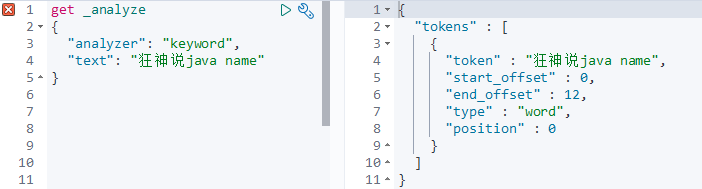

精确查询 term

关于分词

-

term查询是直接通过倒排索引指定的词条精确查找的!(效率高)

-

match:会使用分词器解析!(先分析文档,然后通过分析的文档进行查询!)

term不会对查询的数据进行分词

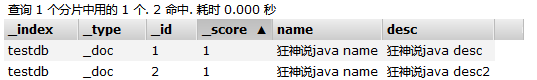

两个类型

- text类型可以被分词器解析

- keyword类型不能被分词器解析

keyword不会对存储该类型字段的数据进行分词

测试:

创建索引并添加映射规则,

put /testdb

{

"mappings": {

"properties": {

"name": {

"type": "text" # name字段的类型是text

},

"desc": {

"type": "keyword" # desc字段的类型是keyword

}

}

}

}

并添加文档数据

put /testdb/_doc/1

{

"name": "狂神说java name",

"desc": "狂神说java desc"

}

put /testdb/_doc/2

{

"name": "狂神说java name",

"desc": "狂神说java desc2"

}

查看数据

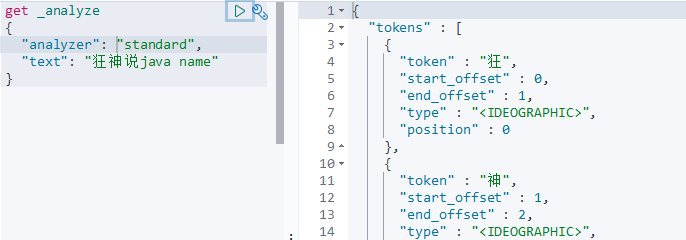

使用分词器进行分析

如果使用的数据类型是 keyword,没有进行分词

数据类型使用的是standard,进行了分词

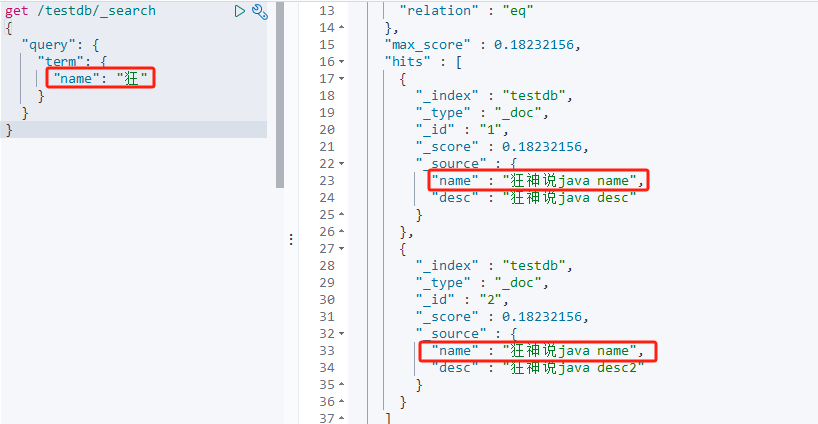

我们查询数据试试

查询的数据因为使用的是term,所以不会对查询的数据进行分词

存储的name字段的数据类型是text,所以会对存储的数据进行分词,比如数据1和数据2的name字段的数据都是"狂神说java name",就分成了 狂、神、说、java、name这几个词。符合查询条件,"狂"这个词能够匹配上

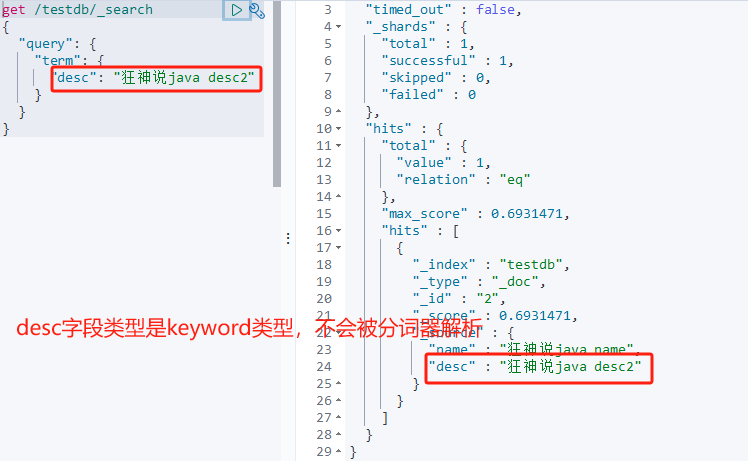

查询的数据使用的是term,不会进行分词

存储的数据类型使用的是keyword,所以也不会进行分词 ,所以查询出来一条数据

多条件查询

# 相当于 where age=22 or age=23

get /test5/_search

{

"query": {

"bool": {

"should": [

{

"term": {

"age": "22"

}

},

{

"term": {

"age": "23"

}

}

]

}

}

}

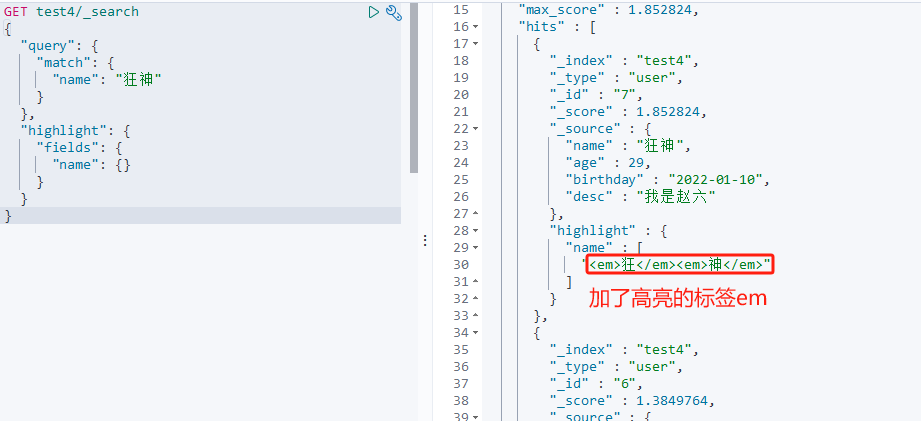

高亮搜索

test4索引的数据

高亮查询

GET test4/_search

{

"query": {

"match": {

"name": "狂神"

}

},

# 查询出来的数据中,name字段的数据进行高亮显示

"highlight": {

"fields": {

"name": {}

}

}

}

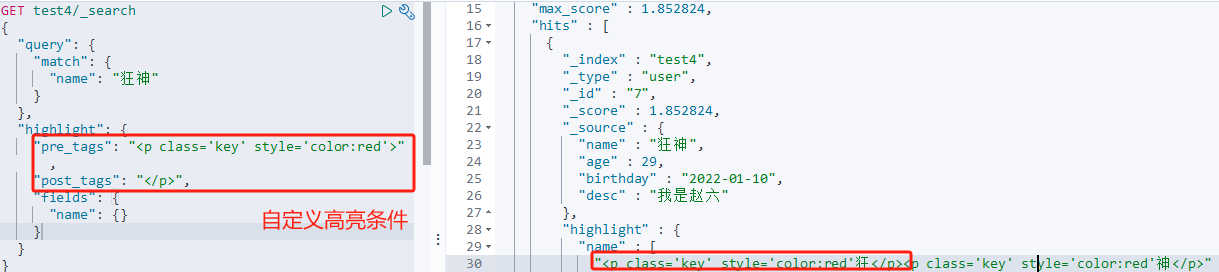

指定标签,让查询出来的数据显示成自己想要的样式

GET test4/_search

{

"query": {

"match": {

"name": "狂神"

}

},

"highlight": {

"pre_tags": "<p class='key' style='color:red'>",

"post_tags": "</p>",

"fields": {

"name": {}

}

}

}

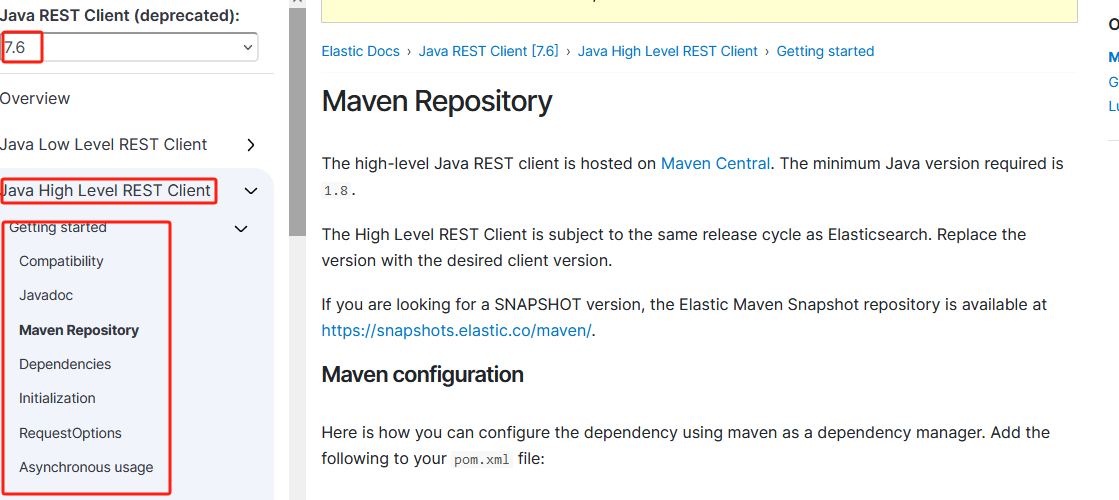

SpringBoot集成

学习方法

一个新的需要学习的东西,首先要找到官网的文档,通过官方文档再一点一点的进行学习(因为官方文档才是最权威的)

官方文档:https://www.elastic.co/guide/en/elasticsearch/client/java-rest/7.6/java-rest-high.html

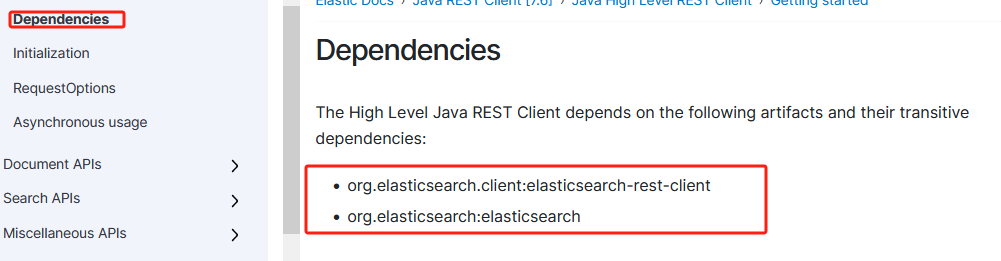

查看需要导入依赖

查看导入的这个依赖都需要哪些其他的依赖

查看需要使用的对象有哪些

官方文档就是这样一点一点的进行分析和学习

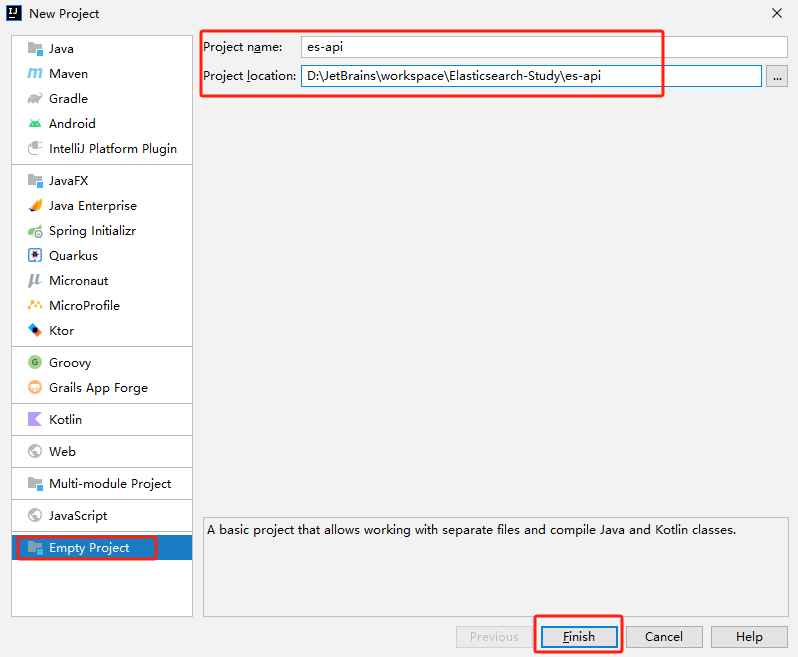

创建项目

创建一个名为es-api的空工程

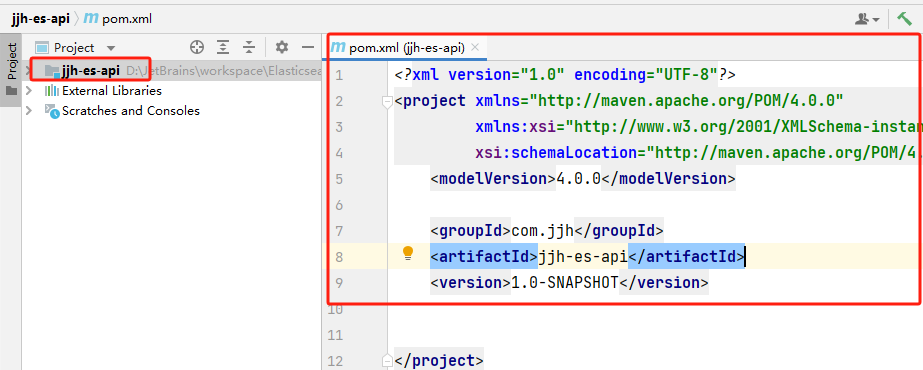

创建一个名为jjh-es-api的普通maven模块

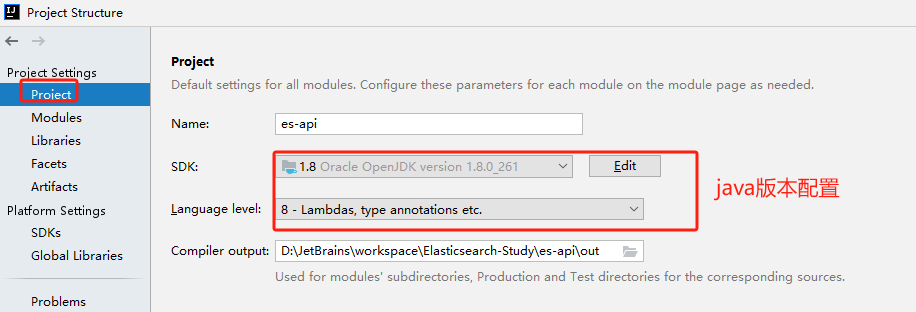

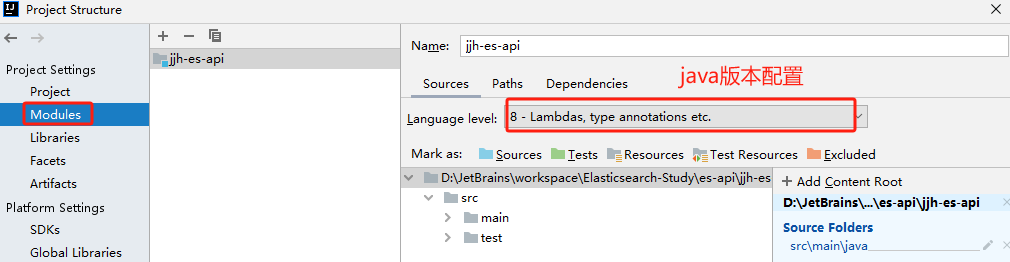

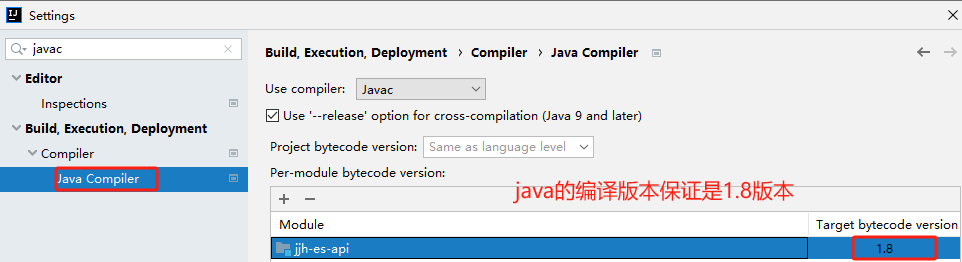

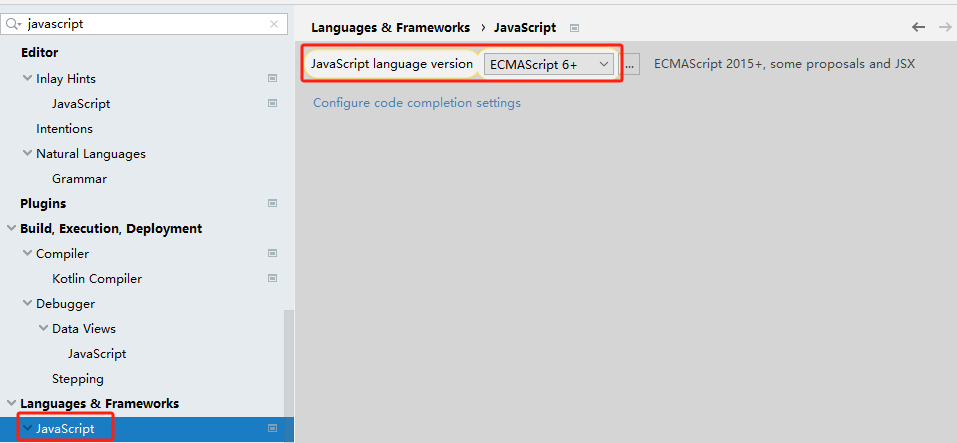

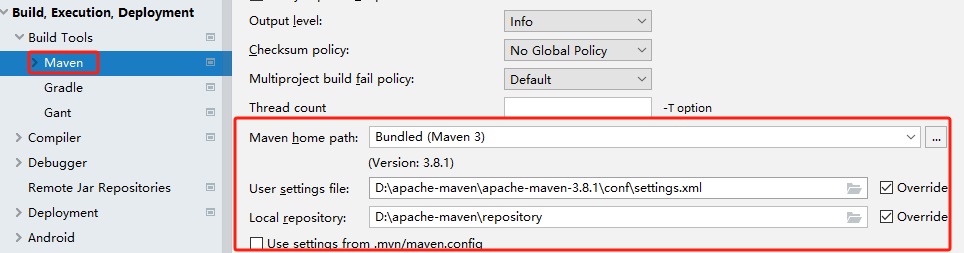

完善工程信息,java的版本配置、maven的配置、javascript版本改成es6规范

javascript使用es6规范支持

maven配置

导入依赖

springboot基本依赖

springboot的基本依赖

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<!--热部署-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-devtools</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

</dependency>

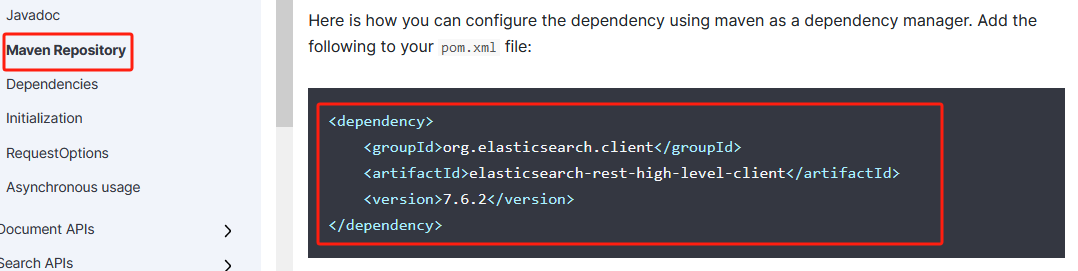

elasticsearch依赖

在springboot的项目中,所有和数据打交道的依赖都在springdata下。springdata和springboot是同级的一个项目,作用就是和所有的数据库打交道,比如mysql、redis...

elasticsearch的依赖

<!--导入了elasticsearch-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-data-elasticsearch</artifactId>

</dependency>

检查elasticsearch的依赖的版本

注意:保证java项目中依赖的版本必须和本地使用的elasticsearch的版本一致

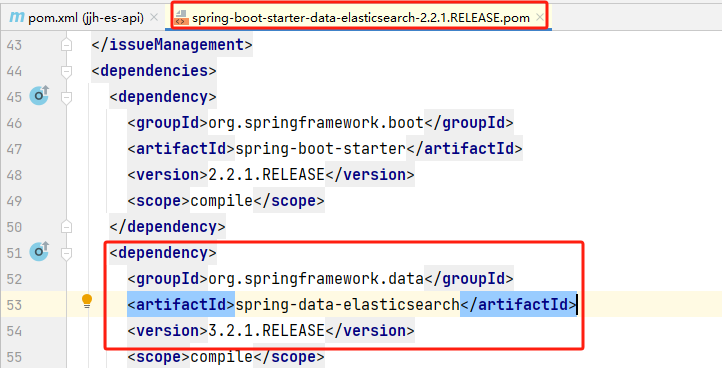

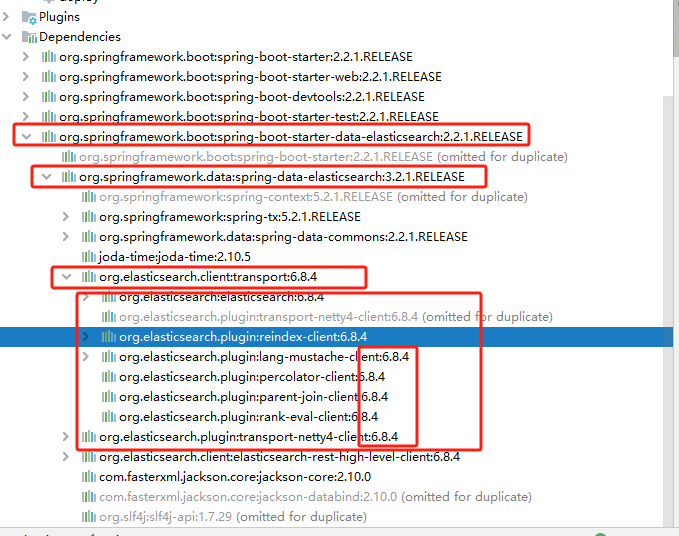

我们看一看spring-boot-starter-data-elasticsearch都依赖了关于elsticsearch的哪些jar包

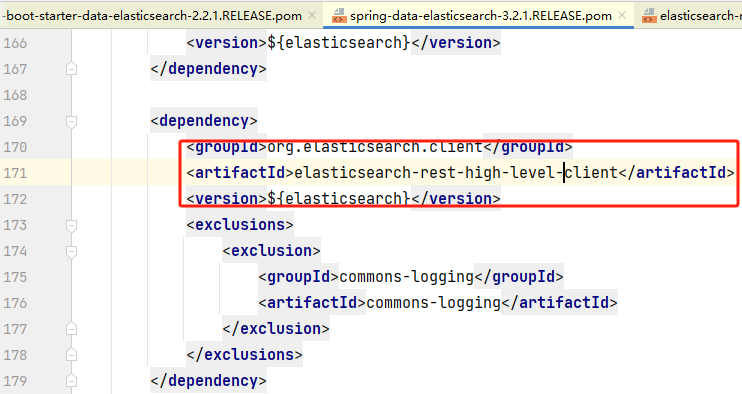

继续深入,查看spring-data-elasticsearch依赖的关于elsticsearch的jar包

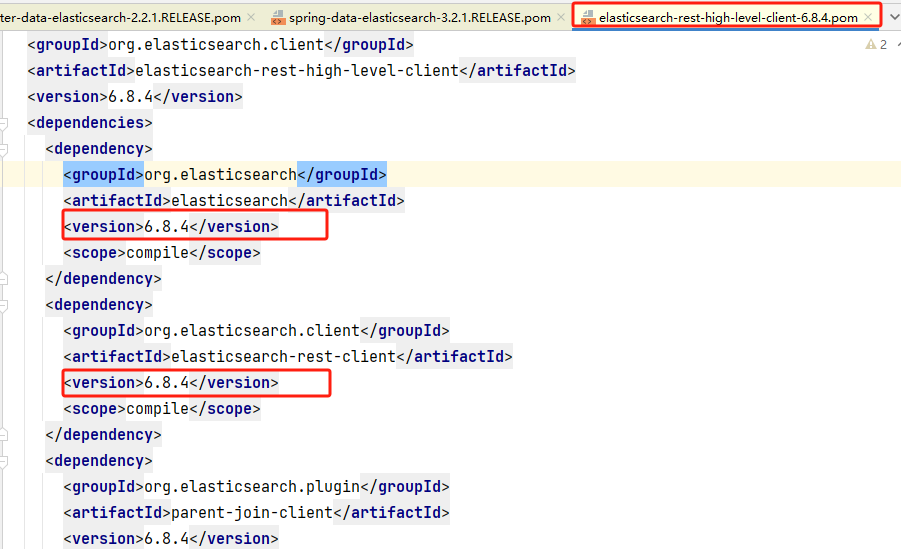

在继续查看elasticsearch-rest-high-level-client的依赖

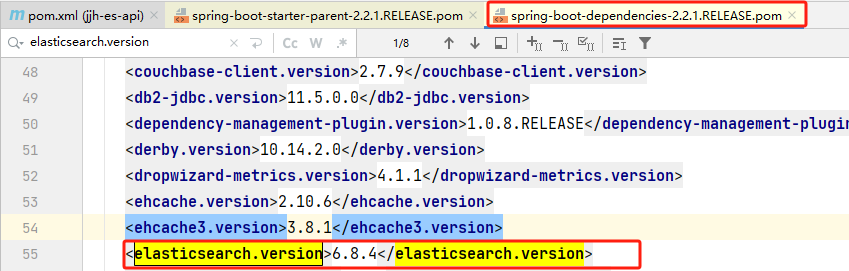

目前使用的springboot的版本是2.2.1,这个版本关于elasticsearch的依赖的版本是6.8.4,但是我们在本地下载的elasticsearch的版本是7.6.1,有版本不一致的问题

使用另外一种方式查看elasticsearch的版本

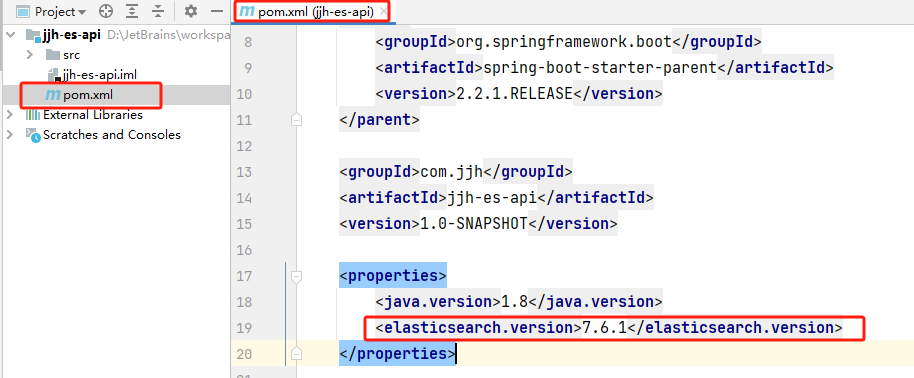

修改elasticsearch的依赖版本

如果elasticsearch的依赖版本和本地实际使用的版本不一致,需要更换依赖的版本

springboot的版本管理中使用的版本是6.8.4

我们在自己项目的pom文件中配置elsaticsearch的版本,就会替换父工程的依赖版本

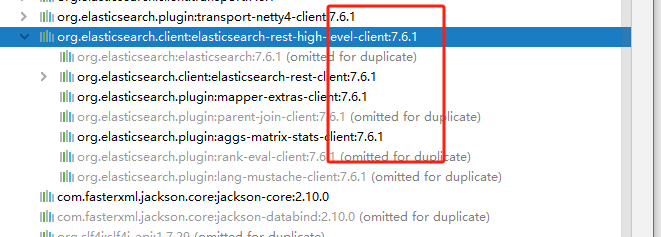

替换成功

模块配置

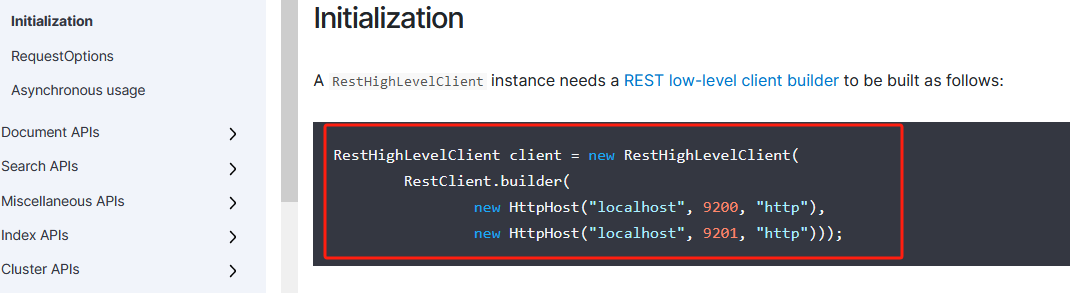

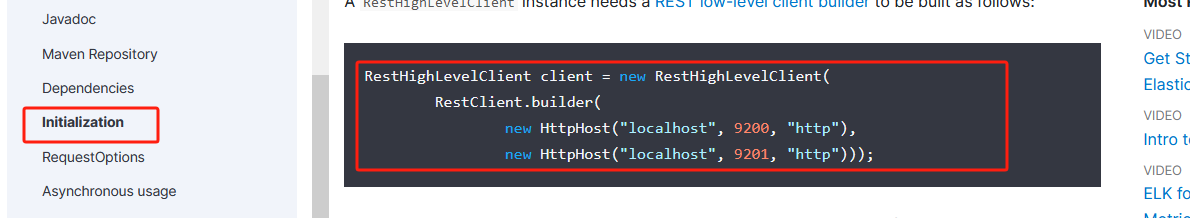

根据官方文档

我们知道需要一个RestHighLevelClient类的对象,所以在自定义的配置类中配置这个对象

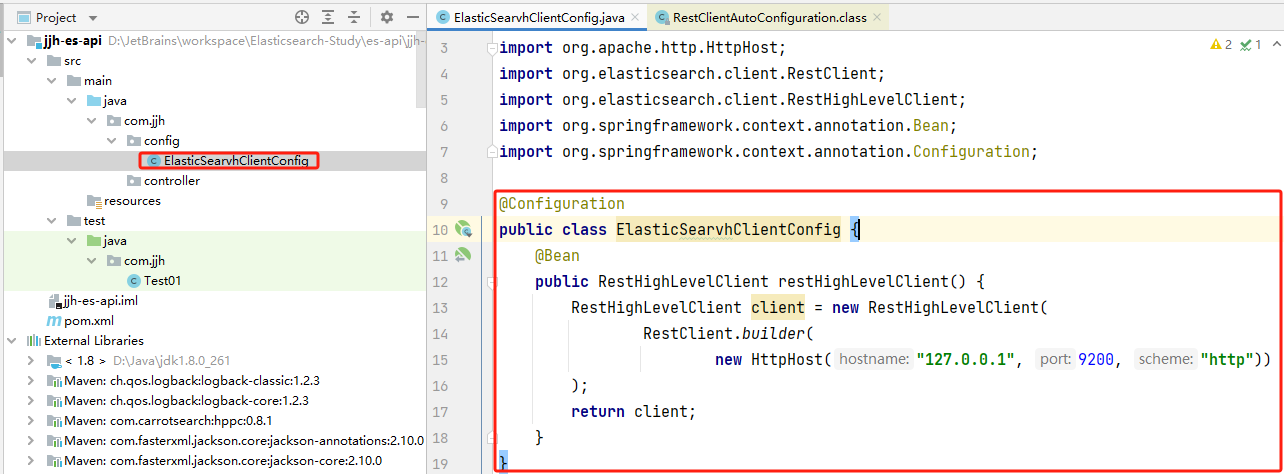

ElasticSearvhClientConfig

@Configuration

public class ElasticSearvhClientConfig {

@Bean

public RestHighLevelClient restHighLevelClient() {

RestHighLevelClient client = new RestHighLevelClient(

RestClient.builder(

new HttpHost("127.0.0.1", 9200, "http"))

);

return client;

}

}

源码分析

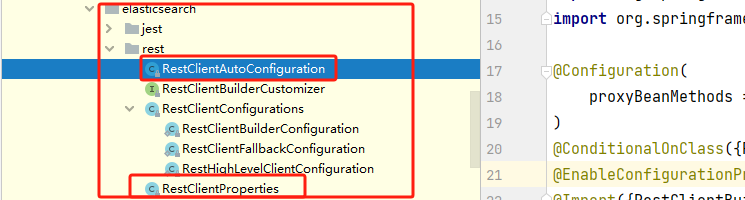

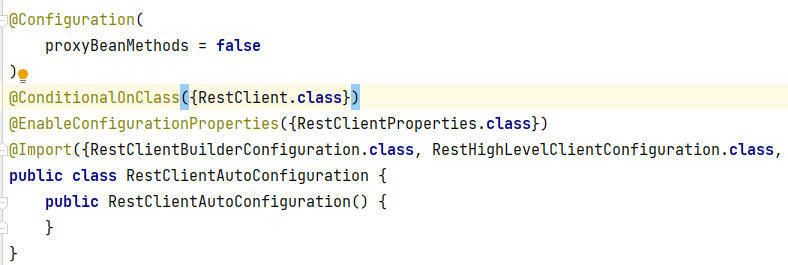

springboot项目,有xxxAutoConfiguration自动配置类和xxxProperties(可在配置文件中自定义自己的配置项)

RestClientAutoConfiguration自动配置类

可以知道自动配置类绑定的配置文件类是RestClientProperties,我们可以在配置文件中自定义配置项

自动配置类导入了RestClientBuilderConfiguration、RestHighLevelClientConfiguration...三个类的class对象

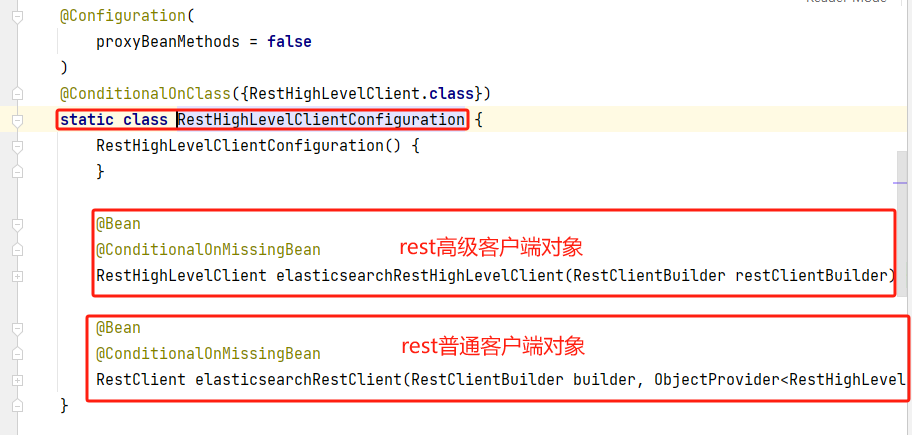

查看这三个类,这里以RestHighLevelClientConfiguration类为例

可以分析得出RestHighLevelClientConfiguration是静态内部类,而且还是一个配置类。

这个内部类配置了RestHighLevelClient和RestClient对象

RestHighLevelClient类的对象名字是elasticsearchRestHighLevelClient

在我们自己的配置类中也配置了RestHighLevelClient类的对象,名字是restHighLevelClient

这就是分析源码的方法....

具体的api测试

索引操作

创建索引

@Test

public void test01() throws IOException {

// 创建索引请求

CreateIndexRequest indexRequest = new CreateIndexRequest("jjh01");

// 执行索引请求

// 客户端执行请求IndicesClient,请求后获得响应

CreateIndexResponse response = restHighLevelClient.indices().create(indexRequest, RequestOptions.DEFAULT);

System.out.println(response);

}

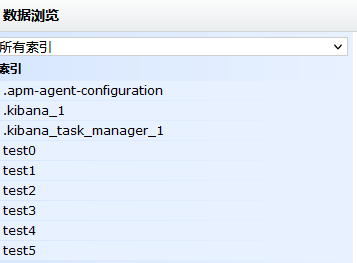

索引创建成功

获取索引

// 获取索引

@Test

public void test02() throws IOException {

// 获取指定索引请求

GetIndexRequest getIndexRequest = new GetIndexRequest("jjh01");

// 判断这个索引是否存在

boolean exists =

restHighLevelClient

.indices()

.exists(getIndexRequest, RequestOptions.DEFAULT);

// 如果索引存在,则获取

if(exists){

GetIndexResponse indexResponse = restHighLevelClient

.indices()

.get(getIndexRequest, RequestOptions.DEFAULT);

System.out.println(indexResponse);

// 如果索引不存在,打印

}else{

System.out.println("该索引不存在");

}

}

删除索引

// 删除索引

@Test

public void test03() throws IOException {

// 获取删除索引请求

DeleteIndexRequest deleteIndexRequest = new DeleteIndexRequest("jjh01");

// 执行请求

AcknowledgedResponse delete = restHighLevelClient

.indices()

.delete(deleteIndexRequest, RequestOptions.DEFAULT);

// delete.isAcknowledged() 获取删除状态。如果返回true,代表删除成功

System.out.println(delete.isAcknowledged());

}

索引删除成功

文档操作

添加文档

@Test

public void test01() throws IOException {

// 创建对象

User user = new User("狂神说", 3);

// 创建请求

IndexRequest indexRequest = new IndexRequest("jjh01");

// 规则 put /jjh01/_doc/1

// 文档id

indexRequest.id("1");

// 超时时间

indexRequest.timeout(TimeValue.timeValueSeconds(1));

indexRequest.timeout("1s");

// 将我们的数据放入到请求中,数据是json字符串,需要将对象转换为json字符串

indexRequest.source(JSON.toJSONString(user), XContentType.JSON);

// 客户端执行请求

IndexResponse response = restHighLevelClient

.index(indexRequest, RequestOptions.DEFAULT);

// 获取响应的结果

System.out.println(response);

// 响应结果的状态

System.out.println(response.status());

}

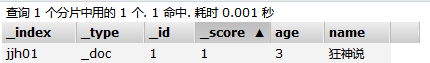

文档添加成功

获取文档

@Test

public void test02() throws IOException {

GetRequest getRequest = new GetRequest("jjh01", "1");

// 不获取返回的_source的上下文

// getRequest.fetchSourceContext(new FetchSourceContext(false));

// 获取哪些字段 _none_表示不获取任何的字段信息

// getRequest.storedFields("_none_");

// 判断文档是否存在

boolean exists = restHighLevelClient

.exists(getRequest, RequestOptions.DEFAULT);

// 存在就获取

if(exists){

GetResponse getResponse = restHighLevelClient

.get(getRequest, RequestOptions.DEFAULT);

// 打印文档的内容

System.out.println(getResponse.getSourceAsString());

}else{

System.out.println("文档不存在");

}

}

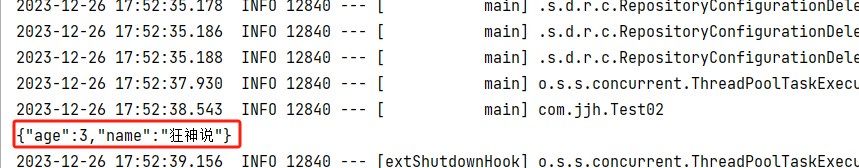

打印结果

修改文档

@Test

public void test03() throws IOException {

// 创建修改的对象

User user = new User("李四", 18);

UpdateRequest updateRequest = new UpdateRequest("jjh01","1");

// 超时限制

updateRequest.timeout("1s");

// 封装数据

updateRequest.doc(JSON.toJSONString(user),XContentType.JSON);

// 客户端执行请求

UpdateResponse update = restHighLevelClient

.update(updateRequest, RequestOptions.DEFAULT);

// 打印响应

System.out.println(update);

// 打印响应的状态

System.out.println(update.status());

}

文档修改成功

删除文档

@Test

public void test04() throws IOException {

// 获取删除文档的请求

DeleteRequest deleteRequest = new DeleteRequest("jjh01", "1");

// 执行请求

DeleteResponse response = restHighLevelClient

.delete(deleteRequest,RequestOptions.DEFAULT);

// 打印返回状态

System.out.println(response.status());

}

文档删除成功

特殊操作

批量插入数据

@Test

public void test01() throws IOException {

// 获取批量请求

BulkRequest bulkRequest = new BulkRequest();

// 设置超时时间

bulkRequest.timeout("10s");

// 对象集合

ArrayList<User> userList = new ArrayList<>();

userList.add(new User("张三",1));

userList.add(new User("李四",2));

userList.add(new User("王五",3));

userList.add(new User("赵六",4));

userList.add(new User("钱七",5));

userList.add(new User("孙八",6));

// 批处理请求

for (int i = 0; i < userList.size(); i++) {

// 批量更新和批量修改就在这里修改即可

bulkRequest.add(

new IndexRequest("jjh01").

id(i+1+"")

.source(JSON.toJSONString(userList.get(i)),XContentType.JSON)

);

}

// 执行批量请求

BulkResponse response = restHighLevelClient

.bulk(bulkRequest, RequestOptions.DEFAULT);

// response.hasFailures() 是否失败,返回false,代表成功

System.out.println(response.hasFailures());

}

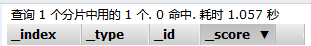

批量插入成功

查询操作

@Test

public void test02() throws IOException {

// 拿到搜索请求

SearchRequest searchRequest = new SearchRequest("jjh01");

// 构建搜索条件

SearchSourceBuilder searchSourceBuilder = new SearchSourceBuilder();

// 查询条件,我们可以使用QueryBuilders工具类来实现

// QueryBuilders.termQuery 精确查找,搜索数据不进行分词

TermQueryBuilder termQueryBuilder = QueryBuilders.termQuery("name", "张");

// QueryBuilders.matchAllQuery 匹配所有

// MatchAllQueryBuilder matchAllQueryBuilder = QueryBuilders.matchAllQuery();

searchSourceBuilder.query(termQueryBuilder);

searchSourceBuilder.timeout(new TimeValue(60, TimeUnit.SECONDS));

// 将构建的搜索条件放入到搜索请求中

searchRequest.source(searchSourceBuilder);

// 执行搜索请求

SearchResponse searchResponse = restHighLevelClient

.search(searchRequest,RequestOptions.DEFAULT);

// 打印响应的数据中的hits的内容(hits的内容存放着文档数据)

System.out.println(JSON.toJSONString(searchResponse.getHits()));

SearchHit[] hits = searchResponse.getHits().getHits();

for (SearchHit hit : hits) {

System.out.println(hit.getSourceAsMap());

}

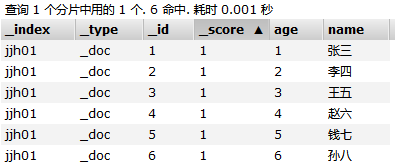

}

打印结果

实战

项目搭建

创建项目

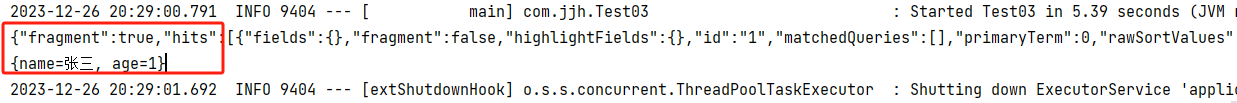

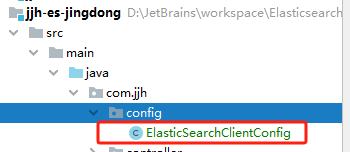

创建一个名为jjh-es-jingdong的普通maven项目

导入依赖

- springboot的相关依赖

- es依赖

- 其他需要使用的依赖

<dependencies>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-devtools</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-test</artifactId>

</dependency>

<dependency>

<groupId>org.projectlombok</groupId>

<artifactId>lombok</artifactId>

</dependency>

<!--导入了elasticsearch-->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-data-elasticsearch</artifactId>

</dependency>

<dependency>

<groupId>com.alibaba</groupId>

<artifactId>fastjson</artifactId>

<version>1.2.83</version>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-thymeleaf</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-configuration-processor</artifactId>

<optional>true</optional>

</dependency>

</dependencies>

模块配置

application.properties

# 关闭 thymeleaf 的缓存

spring.thymeleaf.cache=false

完善模块

导入静态资源

编写IndexController

@Controller

public class IndexController {

@GetMapping({"/","/index"})

public String index() {

return "index";

}

}

启动测试,完成

爬虫

数据问题?数据库获取,消息队列中获取,都可以成为数据源,爬虫!

爬取数据:(获取请求返回的页面信息,筛选出我们想要的数据就可以了!)

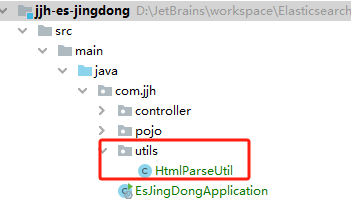

编写工具类

导入网页解析的依赖

<!--解析网页的依赖-->

<dependency>

<groupId>org.jsoup</groupId>

<artifactId>jsoup</artifactId>

<version>1.10.2</version>

</dependency>

工具类编写

HtmlParseUtil

@Component

public class HtmlParseUtil {

public List<Content> parseJD(String keywords) throws IOException {

// 前提:需要联网,不能获取ajax数据

String url = "https://search.jd.com/Search?keyword="+keywords;

// 设置cookie

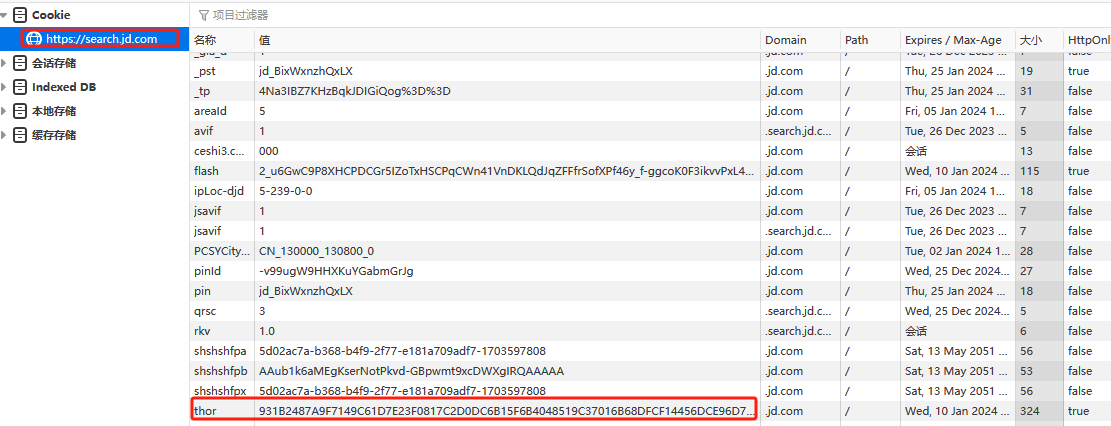

Map<String, String> cookies = new HashMap<String, String>();

// 这里要加身份认证

cookies.put("thor", "931B2487A9F7149C61D7E23F0817C2D0DC6B15F6B4048519C37016B68DFCF14456DCE96D735DC5F81DF55C4CB69A93732E083076C264CEB82F4076141A3B2BA24D396F3F93FB3FCA6BFF2BBD4373942ADC8448B8900A78781AA130281801712E5A2EDC83E6FD6F809AC5C5FD753F1BF28121278C6676BE0BB678F9F9570739CC63858D747570C10D5E382A44CE2B6AA636798F4203419658845FDB2AB75F8D83");

// 解析网页, document就代表网页界面

Document document = Jsoup.connect(url).cookies(cookies).get();

// 所有在js中可以使用的方法,这里都能用

Element j_goodslist = document.getElementById("J_goodsList");

// 获取所有的li元素

Elements li = j_goodslist.getElementsByTag("li");

List<Content> goodsList = new ArrayList<>();

// 获取所有的li元素

for (Element el : li) {

// 关于图片特别多的网站,所有的图片都是延迟加载的 source-data-lazy-img

String img = el.getElementsByTag("img").eq(0).attr("data-lazy-img");

String price = el.getElementsByClass("p-price").eq(0).text();

String title = el.getElementsByClass("p-name").eq(0).text();

Content content = new Content(img,price,title);

goodsList.add(content);

}

return goodsList;

}

}

需要在cookie中加上身份认证,有了这个身份认证,代表已经通过账号密码登录京东网站了

身份认证信息在浏览器的cookie中获取

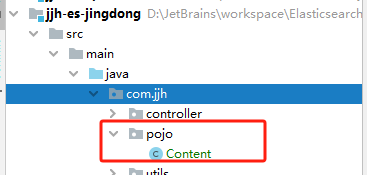

pojo层

Content

@NoArgsConstructor

@AllArgsConstructor

@Data

public class Content {

private String img;

private String price;

private String title;

}

config层

ElasticSearchClientConfig

// 1、找对象

// 2、放到spring中待用

// 3、如果是springboot 就先分析源码

@Configuration

public class ElasticSearchClientConfig {

@Bean

public RestHighLevelClient restHighLevelClient() {

RestHighLevelClient client = new RestHighLevelClient(

RestClient.builder(

new HttpHost("127.0.0.1", 9200, "http"))

);

return client;

}

}

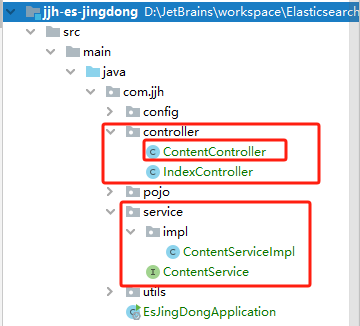

完善包结构

service层

ContentService

public interface ContentService {

Boolean parseContent(String keywords) throws IOException;

}

ContentServiceImpl

@Service

public class ContentServiceImpl implements ContentService {

@Autowired

private RestHighLevelClient restHighLevelClient;

@Autowired

private HtmlParseUtil htmlParseUtil;

public Boolean parseContent(String keywords) throws IOException {

// 1.解析数据放入es索引中

List<Content> contents = htmlParseUtil.parseJD(keywords);

// 把查询的数据放入 es 中

BulkRequest bulkRequest = new BulkRequest();

bulkRequest.timeout("2m");

for (int i = 0; i < contents.size(); i++) {

bulkRequest.add(

new IndexRequest("jd_goods")

.source(JSON.toJSONString(contents.get(i)), XContentType.JSON)

);

}

BulkResponse response = restHighLevelClient

.bulk(bulkRequest, RequestOptions.DEFAULT);

return !response.hasFailures();

}

}

controller层

ContentController

@RestController

public class ContentController {

@Autowired

private ContentService contentService;

@GetMapping("/parse/{keywords}")

public Boolean parse(@PathVariable("keywords") String keywords) throws IOException {

return contentService.parseContent(keywords);

}

}

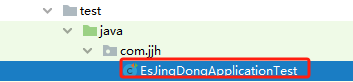

测试

@SpringBootTest

public class EsJingDongApplicationTest {

@Autowired

private ContentService contentService;

@Test

public void test01() throws IOException {

Boolean aBoolean = contentService.parseContent("java");

System.out.println(aBoolean);

}

}

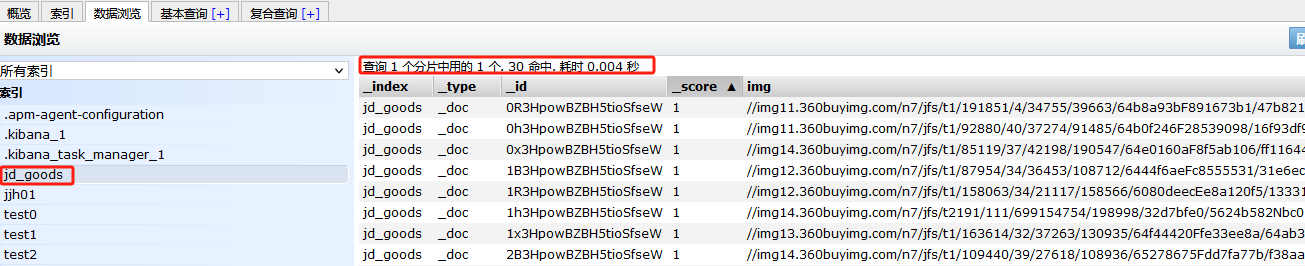

添加数据成功,30个数据只用了0.004秒

分页查询

ContentService

// 分页查询

List<Map<String,Object>> searchPage(String keyword, Integer pageNo, Integer pageSize ) throws IOException;

ContentServiceImpl

// 获取这些数据实现基本的搜索功能

public List<Map<String,Object>> searchPage(String keyword,Integer pageNo,Integer pageSize ) throws IOException {

if(pageNo<1){

pageNo=1;

}

// 创建查询请求

SearchRequest searchRequest = new SearchRequest("jd_goods");

// 创建查询构造器

SearchSourceBuilder searchSourceBuilder = new SearchSourceBuilder();

// 设置具体的查询

// 精确查询term

TermQueryBuilder termQueryBuilder = QueryBuilders.termQuery("title", keyword);

searchSourceBuilder.query(termQueryBuilder);

searchSourceBuilder.timeout(new TimeValue(60, TimeUnit.SECONDS));

// 分页查询

searchSourceBuilder.from(pageNo);

searchSourceBuilder.size(pageSize);

// 执行搜索

searchRequest.source(searchSourceBuilder);

SearchResponse searchResponse = restHighLevelClient.search(searchRequest, RequestOptions.DEFAULT);

// 处理返回的数据信息

ArrayList<Map<String, Object>> list = new ArrayList<Map<String, Object>>();

for(SearchHit searchHit:searchResponse.getHits().getHits()){

list.add(searchHit.getSourceAsMap());

}

return list;

}

ContentController

@GetMapping("/search/{keywords}/{pageNo}/{pageSize}")

public List<Map<String,Object>> searchPage(@PathVariable("keywords") String keywords,

@PathVariable("pageNo") Integer pageNo,

@PathVariable("pageSize") Integer pageSize) throws IOException

{

List<Map<String, Object>> maps = contentService.searchPage(

keywords,

pageNo,

pageSize);

System.out.println(maps);

return maps;

}

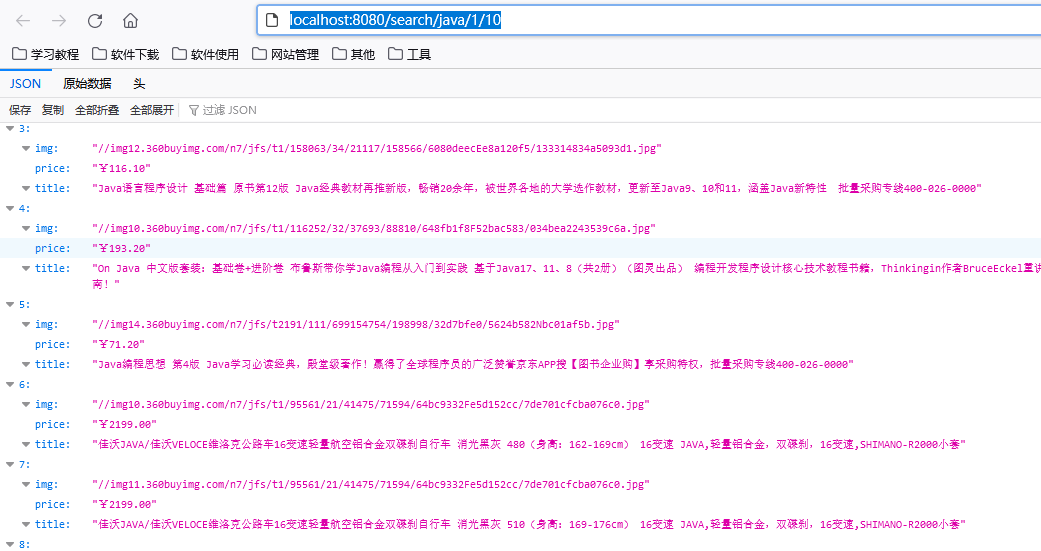

启动,测试。查询成功

http://localhost:8080/search/java/1/10

前后端分离

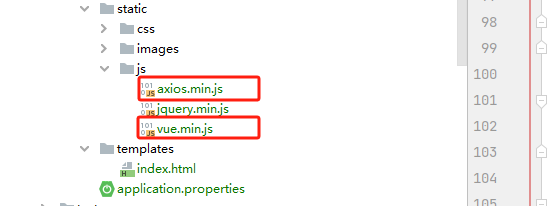

导入js资源

加载并引入Vue.min.js和axios.js

如果安装了nodejs,可以按如下步骤获取vue.min.js和axios.js

npm install vue

npm install axios

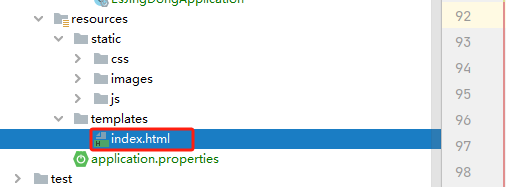

修改静态页面

index.html

1、引入vue.min.js和axios.js

<!--导入vue-->

<script th:src="@{/js/vue.min.js}"></script>

<!--导入axios-->

<script th:src="@{/js/axios.min.js}"></script>

2、创建vue对象,定义相关属性和方法

<script>

var vm=new Vue({

el: "#app",

data: {

keyword: '', // 搜索的关键字

results: [] // 搜索的结果

},

methods: {

searchKey(){

let keyword=this.keyword;

// console.log(keyword);

axios.get('search/'+keyword+'/1/10').then(res=>{

this.results=res.data; // 绑定数据

})

}

}

})

</script>

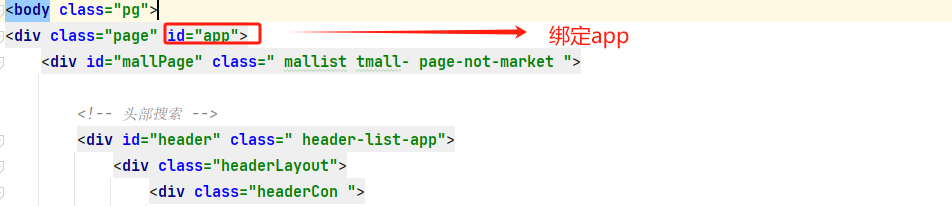

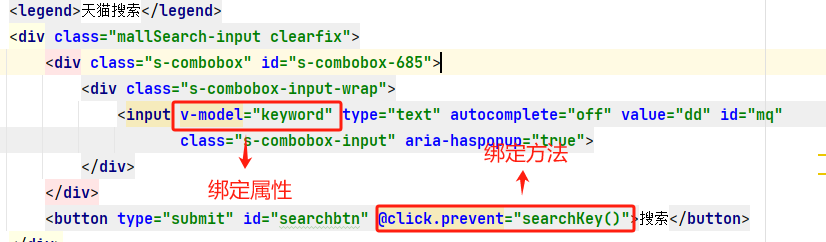

3、绑定document元素

4、绑定vue的属性和方法

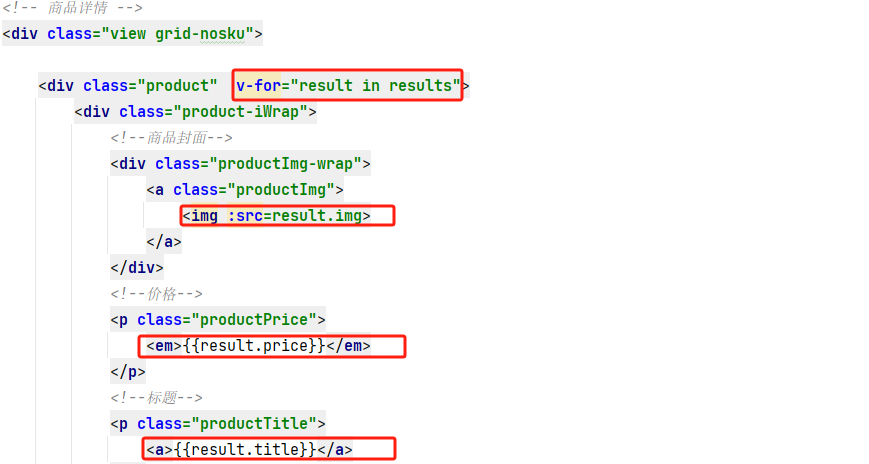

5、绑定访问后端接口后返回的数据

完整index.html页面

<!DOCTYPE html>

<html xmlns:th="http://www.thymeleaf.org">

<head>

<meta charset="utf-8"/>

<title>狂神说Java-ES仿京东实战</title>

<link rel="stylesheet" th:href="@{/css/style.css}"/>

<!--导入vue-->

<script th:src="@{/js/vue.min.js}"></script>

<!--导入axios-->

<script th:src="@{/js/axios.min.js}"></script>

</head>

<body class="pg">

<div class="page" id="app">

<div id="mallPage" class=" mallist tmall- page-not-market ">

<!-- 头部搜索 -->

<div id="header" class=" header-list-app">

<div class="headerLayout">

<div class="headerCon ">

<!-- Logo-->

<h1 id="mallLogo">

<img th:src="@{/images/jdlogo.png}" alt="">

</h1>

<div class="header-extra">

<!--搜索-->

<div id="mallSearch" class="mall-search">

<form name="searchTop" class="mallSearch-form clearfix">

<fieldset>

<legend>天猫搜索</legend>

<div class="mallSearch-input clearfix">

<div class="s-combobox" id="s-combobox-685">

<div class="s-combobox-input-wrap">

<input v-model="keyword" type="text" autocomplete="off" value="dd" id="mq"

class="s-combobox-input" aria-haspopup="true">

</div>

</div>

<button type="submit" id="searchbtn" @click.prevent="searchKey()">搜索</button>

</div>

</fieldset>

</form>

<ul class="relKeyTop">

<li><a>狂神说Java</a></li>

<li><a>狂神说前端</a></li>

<li><a>狂神说Linux</a></li>

<li><a>狂神说大数据</a></li>

<li><a>狂神聊理财</a></li>

</ul>

</div>

</div>

</div>

</div>

</div>

<!-- 商品详情页面 -->

<div id="content">

<div class="main">

<!-- 品牌分类 -->

<form class="navAttrsForm">

<div class="attrs j_NavAttrs" style="display:block">

<div class="brandAttr j_nav_brand">

<div class="j_Brand attr">

<div class="attrKey">

品牌

</div>

<div class="attrValues">

<ul class="av-collapse row-2">

<li><a href="#"> 狂神说 </a></li>

<li><a href="#"> Java </a></li>

</ul>

</div>

</div>

</div>

</div>

</form>

<!-- 排序规则 -->

<div class="filter clearfix">

<a class="fSort fSort-cur">综合<i class="f-ico-arrow-d"></i></a>

<a class="fSort">人气<i class="f-ico-arrow-d"></i></a>

<a class="fSort">新品<i class="f-ico-arrow-d"></i></a>

<a class="fSort">销量<i class="f-ico-arrow-d"></i></a>

<a class="fSort">价格<i class="f-ico-triangle-mt"></i><i class="f-ico-triangle-mb"></i></a>

</div>

<!-- 商品详情 -->

<div class="view grid-nosku">

<div class="product" v-for="result in results">

<div class="product-iWrap">

<!--商品封面-->

<div class="productImg-wrap">

<a class="productImg">

<img :src=result.img>

</a>

</div>

<!--价格-->

<p class="productPrice">

<em>{{result.price}}</em>

</p>

<!--标题-->

<p class="productTitle">

<a>{{result.title}}</a>

</p>

<!-- 店铺名 -->

<div class="productShop">

<span>店铺: 狂神说Java </span>

</div>

<!-- 成交信息 -->

<p class="productStatus">

<span>月成交<em>999笔</em></span>

<span>评价 <a>3</a></span>

</p>

</div>

</div>

</div>

</div>

</div>

</div>

</div>

<script>

var vm=new Vue({

el: "#app",

data: {

keyword: '', // 搜索的关键字

results: [] // 搜索的结果

},

methods: {

searchKey(){

let keyword=this.keyword;

// console.log(keyword);

axios.get('search/'+keyword+'/1/10').then(res=>{

this.results=res.data; // 绑定数据

})

}

}

})

</script>

</body>

</html>

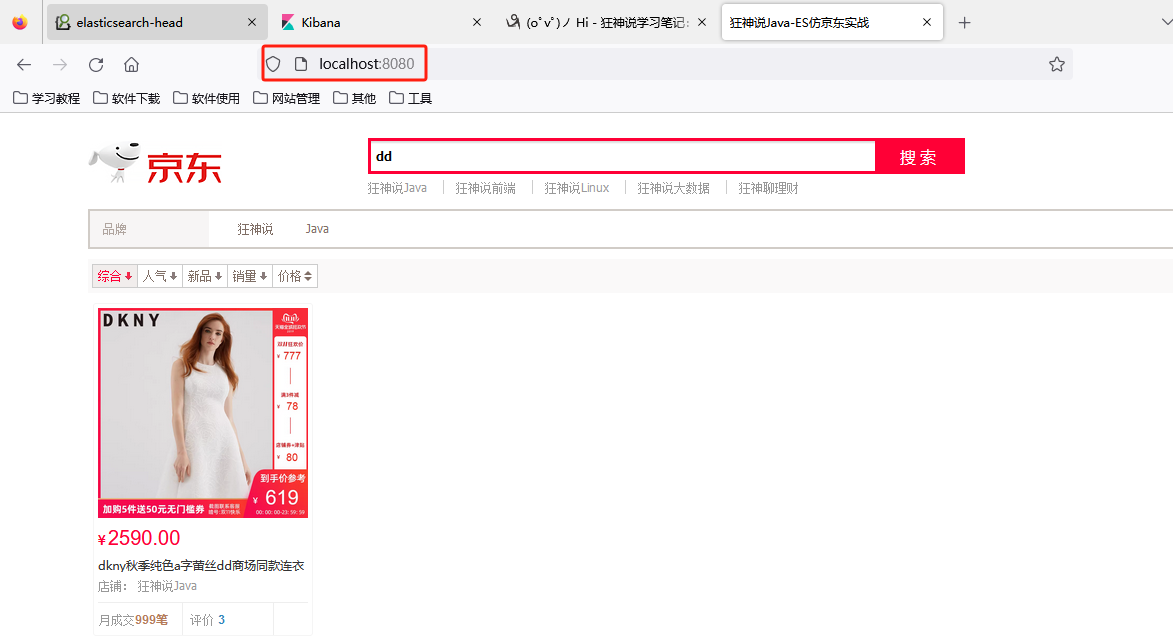

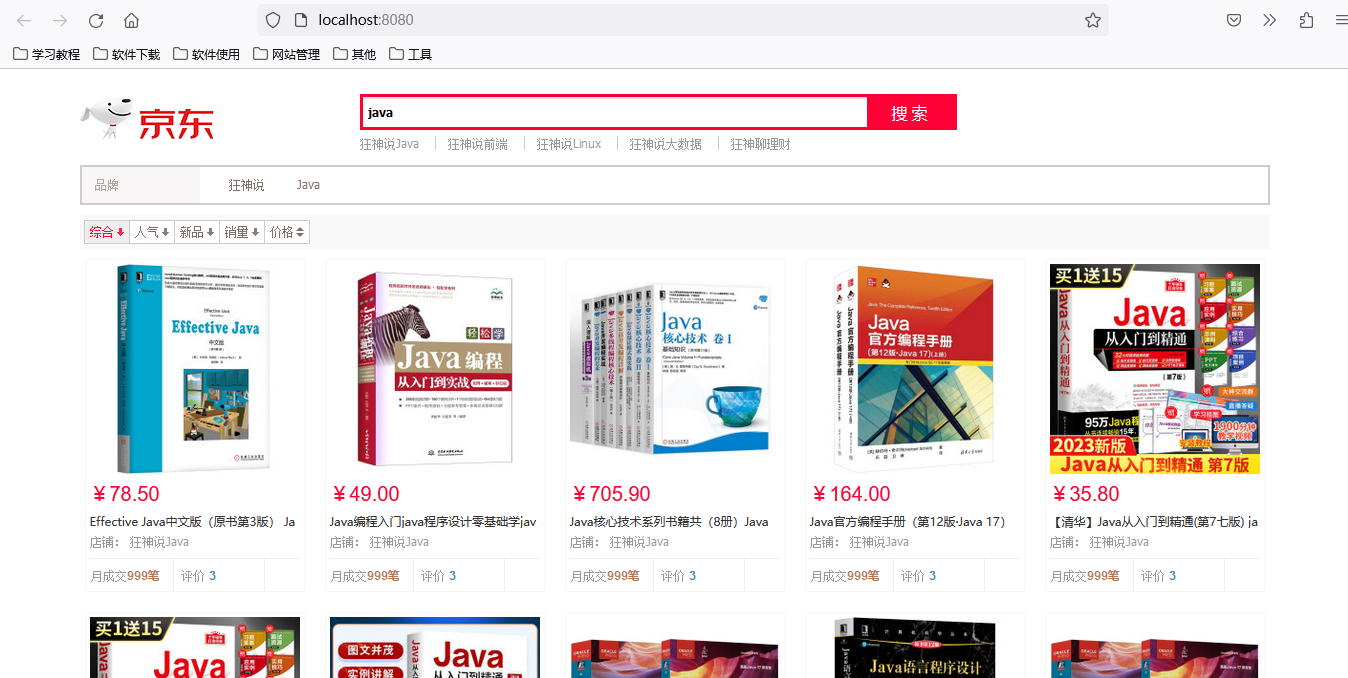

访问测试

关键字实现高亮

后端

ContentServiceImpl.searchPage

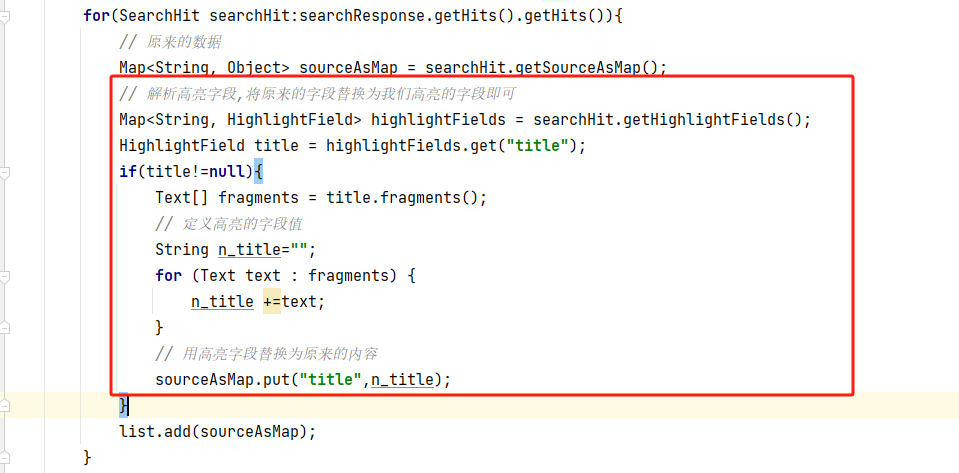

1、实现高亮

2、替换高亮字段

3、完整代码

// 获取这些数据实现基本的搜索功能

public List<Map<String,Object>> searchPage(String keyword,Integer pageNo,Integer pageSize ) throws IOException {

if(pageNo<1){

pageNo=1;

}

// 创建查询请求

SearchRequest searchRequest = new SearchRequest("jd_goods");

// 创建查询构造器

SearchSourceBuilder searchSourceBuilder = new SearchSourceBuilder();

// 设置具体的查询

// 精确查询term

TermQueryBuilder termQueryBuilder = QueryBuilders.termQuery("title", keyword);

searchSourceBuilder.query(termQueryBuilder);

searchSourceBuilder.timeout(new TimeValue(60, TimeUnit.SECONDS));

// 关键字高亮显示

HighlightBuilder highlightBuilder = new HighlightBuilder();

highlightBuilder.field("title");

highlightBuilder.preTags("<span style='color:red'>");

highlightBuilder.postTags("</span>");

highlightBuilder.requireFieldMatch(false);// 关闭多个高亮显示

searchSourceBuilder.highlighter(highlightBuilder);

// 分页查询

searchSourceBuilder.from(pageNo);

searchSourceBuilder.size(pageSize);

// 执行搜索

searchRequest.source(searchSourceBuilder);

SearchResponse searchResponse = restHighLevelClient.search(searchRequest, RequestOptions.DEFAULT);

// 处理返回的数据信息

ArrayList<Map<String, Object>> list = new ArrayList<Map<String, Object>>();

for(SearchHit searchHit:searchResponse.getHits().getHits()){

// 原来的数据

Map<String, Object> sourceAsMap = searchHit.getSourceAsMap();

// 解析高亮字段,将原来的字段替换为我们高亮的字段即可

Map<String, HighlightField> highlightFields = searchHit.getHighlightFields();

HighlightField title = highlightFields.get("title");

if(title!=null){

Text[] fragments = title.fragments();

// 定义高亮的字段值

String n_title="";

for (Text text : fragments) {

n_title +=text;

}

// 用高亮字段替换为原来的内容

sourceAsMap.put("title",n_title);

}

list.add(sourceAsMap);

}

return list;

}

访问测试

发现我们自定义的标签显示出来,但是没有生效

前端

让我们自定的标签生效

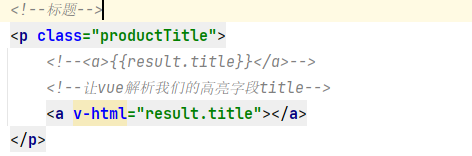

<!--标题-->

<p class="productTitle">

<!--<a>{{result.title}}</a>-->

<!--让vue解析我们的高亮字段title-->

<a v-html="result.title"></a>

</p>

访问测试,实现了高亮