线性回归中的梯度下降是一种优化算法,用于找到使线性回归模型拟合数据最好的参数值。下面是关于线性回归中梯度下降的详细解释:

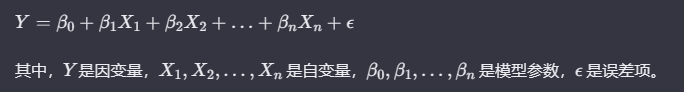

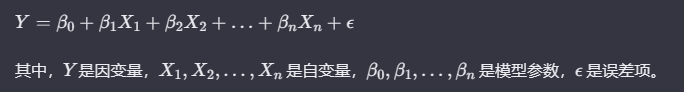

1. 线性回归模型:

线性回归模型的基本形式是:

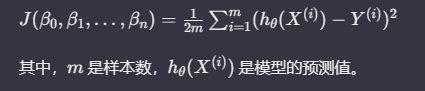

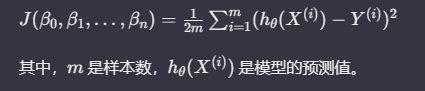

2. 梯度下降的目标:

梯度下降的目标是最小化损失函数,即观测值和模型预测值之间的差异。在线性回归中,通常采用均方误差(Mean Squared Error, MSE)作为损失函数:

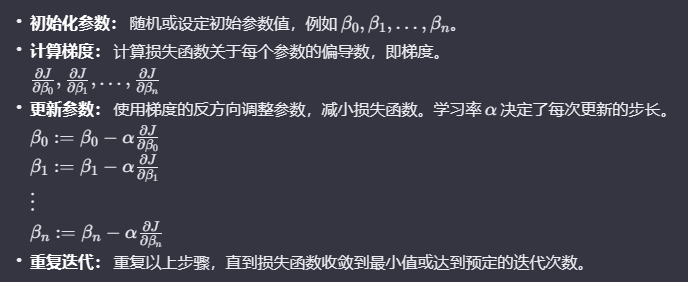

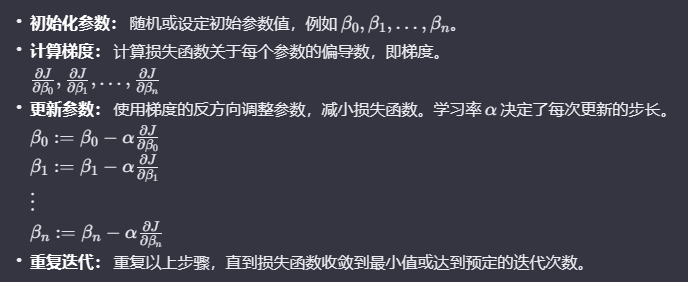

3. 梯度下降算法步骤:

梯度下降通过迭代调整模型参数来逐步减小损失函数。具体步骤如下:

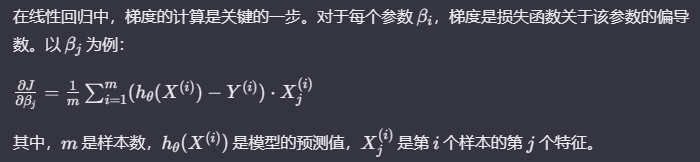

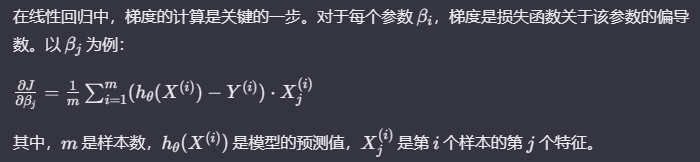

4. 梯度的计算:

线性回归中的梯度下降是一种优化算法,用于找到使线性回归模型拟合数据最好的参数值。下面是关于线性回归中梯度下降的详细解释:

线性回归模型的基本形式是:

梯度下降的目标是最小化损失函数,即观测值和模型预测值之间的差异。在线性回归中,通常采用均方误差(Mean Squared Error, MSE)作为损失函数:

梯度下降通过迭代调整模型参数来逐步减小损失函数。具体步骤如下: