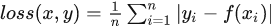

L1 Loss、L2 Loss、Smooth L1 Loss

L1 Loss

- L1 Loss别称:L1 范数损失、最小绝对值偏差(LAD)、最小绝对值误差(LAE)。最常看到的MAE也是指L1 Loss。它是把目标值与模型输出(估计值)做绝对值得到的误差。

- 什么时候使用?

回归任务简单的模型由于神经网络通常是解决复杂问题,所以很少使用。

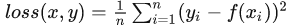

L2 Loss

- L2 Loss别称:L2 范数损失、最小均方值偏差(LSD)、最小均方值误差(LSE)。最常看到的MSE也是指L2 Loss,PyTorch中也将其命名

torch.nn.MSELoss。它是把目标值与模型输出(估计值)做差然后平方得到的误差。 - 什么时候使用?

回归任务数值特征不大问题维度不高。

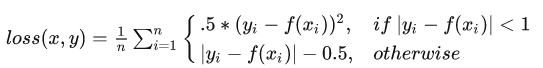

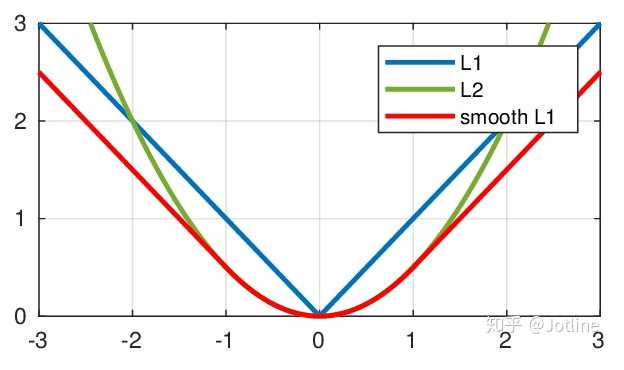

Smooth L1 Loss

平滑版的L1 Loss。仔细观察可以看到,当预测值和ground truth差别较小的时候(绝对值差小于1),其实使用的是L2 Loss;而当差别大的时候,是L1 Loss的平移。Smoooth L1 Loss其实是L2 Loss和L1 Loss的结合,它同时拥有L2 Loss和L1 Loss的部分优点。

- 当预测值和ground truth差别较小的时候(绝对值差小于1),梯度不至于太大。(损失函数相较L1 Loss比较圆滑)

- 当差别大的时候,梯度值足够小(较稳定,不容易梯度爆炸)。

什么时候使用?

- 回归

- 当特征中有较大的数值

- 适合大多数问题

- Loss Learning Smooth Deep L1loss learning smooth deep loss目标smooth giou deep-learning deep-learning-based learning deep nature-deep learning nature deep optimization learning deep for non-deep learning machine notes spatio-temporal-spectral deep-learning-based reinforcement introduction learning deep