transform mrctf 2020

Transformer速查宝典:模型、架构、训练方法的论文都在这里了

前言 论文大合集,一篇文章就搞定。 本文转载自机器之心 仅用于学术分享,若侵权请联系删除 欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。 CV各大方向专栏与各个部署框架最全教程整理 【CV技术指南】CV全栈指导班、基础入门班、论文指导班 全面上线! ......

带你上手基于Pytorch和Transformers的中文NLP训练框架

基于pytorch、transformers做中文领域的nlp开箱即用的训练框架,提供全套的训练、微调模型(包括大模型、文本转向量、文本生成、多模态等模型)的解决方案。 ......

CSP-J2020初赛易错题解析

一.5. 正解: 冒泡排序最少比较n-1次,即单调上升序列 10.5 个小朋友并排站成一列,其中有两个小朋友是双胞胎,如果要求这两个双胞胎必须相邻,则有( )种不同排列方法? A.24 B.36 C.72 D.48 错误原因:忘记乘上A(2,2)了 正解: 捆绑法,A(4,4)*A(2,2)=48 ......

【题解】 P7077 [CSP-S2020] 函数调用(拓扑排序)

## 题意 题目给定了一个长度为$n$序列$a$与$m$个操作,操作一共有3种: 1.给定$x,y$,使$a_x$增加$y$。 2.给定$x$,使$a$中所有数全部乘上$x$。 3.给出k个数$c_1,c_2,...,c_k$,表示这个操作的任务是按照先后顺序执行编号为$c_1,c_2,...,c_ ......

CSP-S2020初赛易错题解析

二.1.4.将第 14 行的 d[i] < d[j] 改为 d[i] != d[j],程序输出不会改变。( ) 答案:正确 解析:因为双层for会遍历所有情况,所以输出不会改变 2.4.当输入的 d[i]d[i] 是严格单调递减序列时,第 17 行的 swap 平均执行次数是( ) A.O(n^2) ......

聊聊HuggingFace Transformer

## 概述 参见:[聊聊HuggingFace](https://www.cnblogs.com/zhiyong-ITNote/p/17640835.html) ## 项目组件 一个完整的transformer模型主要包含三部分:Config、Tokenizer、Model。 ### Config ......

GPT之路(四) 神经网络架构Transformer工作原理

原文:What Are Transformer Models and How Do They Work? Transformer模型是机器学习中最令人兴奋的新发展之一。它们在论文Attention is All You Need中被介绍。Transformer可以用于写故事、文章、诗歌,回答问题,翻 ......

swin transformer

摘要核心1.本文提出一种可以适用于多种任务的backbone->swin transformer2.Transformer迁移到CV中有两点挑战->物体尺度不一,图像分辨率大3.为了解决尺度不一的问题,Swin Transformer使用了分层的结构(Pyramid)4.为了能够在高分辨率上运行,S ......

使用 AutoGPTQ 和 transformers 让大语言模型更轻量化

大语言模型在理解和生成人类水平的文字方面所展现出的非凡能力,正在许多领域带来应用上的革新。然而,在消费级硬件上训练和部署大语言模型的需求也变得越来越难以满足。 🤗 Hugging Face 的核心使命是 _让优秀的机器学习普惠化_ ,而这正包括了尽可能地让所有人都能够使用上大模型。本着 [与 bi ......

2020-2021 ACM-ICPC, Asia Nanjing Regional Contest KLMEFA

# [2020-2021 ACM-ICPC, Asia Nanjing Regional Contest (XXI Open Cup, Grand Prix of Nanjing)](https://codeforces.com/gym/102992)  的模型,这些模型横跨多个领域及任务。为了使这些模型能以最佳性能运行,我们需要优化其推理速度及内存使用。 🤗 Hugging Face 生态系统为满足上述需求提供了现成且易于使用的优化工具,这些工 ......

Transformer计算公式

## LLM inference workflow **Generative Inference**. A typical LLM generative inference task consists of two stages: i) the prefill stage which takes a ......

bert,Bidirectional Encoder Representation from Transformers

BERT的全称是Bidirectional Encoder Representation from Transformers,是Google2018年提出的预训练模型,即双向Transformer的Encoder,因为decoder是不能获要预测的信息的。模型的主要创新点都在pre-train方法上 ......

IPC-7093A-CN 中文 2020底部端子元器件(BTCs)设计和组装工艺的实施

IPC-7093A 标准为实施底部端子元器件(BTCs)提供了基本的设计和组装指南。具体而言,IPC-7093A 提供了与 BTCs 相关的关键设计、材料、组装、检查、维修、质量和可靠性问题的指南。 https://pan.baidu.com/s/1Xs3iAvQa_HmhefazZb_3fwhtt ......

transformer

masked mutil-head attetion mask 表示掩码,它对某些值进行掩盖,使其在参数更新时不产生效果。Transformer 模型里面涉及两种 mask,分别是 padding mask 和 sequence mask。其中,padding mask 在所有的 scaled do ......

Transformer历史揭秘及Transformer-DETR

Transformer历史揭秘及Transformer-DETR 揭秘创始八子:聚是一团火,散是满天星 Transformer创始八子深度揭秘:陈旧的身躯留不住年轻的心。 谁曾想过,引发人工智能革命的突破竟源自一个改进机器翻译的想法? 智东西8月21日消息,据英国《金融时报》报道,被称为“ChatG ......

transformer模型的历史

Transformer 模型在深度学习领域,尤其是自然语言处理(NLP)中,起到了革命性的作用。以下是其发展历程的简要概述: 1. **背景**: - 在 Transformer 出现之前,循环神经网络(RNN)及其更先进的版本,如长短时记忆网络(LSTM)和门控循环单元(GRU)是处理序列任务的主 ......

transformer小白入门

transformer库是huggingface发布的1个框架,非常好用,很多外行看起来高大上的问题,用它都可以轻松解决,先来看1个小例子: 一、情感分析 from transformers import pipeline classifier = pipeline('sentiment-analy ......

论文解读(CTDA)《Contrastive transformer based domain adaptation for multi-source cross-domain sentiment classification》

Note:[ wechat:Y466551 | 可加勿骚扰,付费咨询 ] 论文信息 论文标题:Contrastive transformer based domain adaptation for multi-source cross-domain sentiment classification论 ......

Transformers包使用记录

Transformers是著名的深度学习预训练模型集成库,包含NLP模型最多,CV等其他领域也有,支持预训练模型的快速使用和魔改,并且模型可以快速在不同的深度学习框架间(Pytorch/Tensorflow/Jax)无缝转移。以下记录基于HuggingFace官网教程:https://github. ......

P6772 [NOI2020] 美食家 题解(矩阵加速图上dp常用思路)

# P6772 [NOI2020] 美食家 题解(矩阵加速图上dp常用思路) ## 简要题面 给定一张 $n$ 个点 $m$ 条单向边的图,走这条边需要花费 $w_i$ 的时间(以天为单位),现在有一个人从 $1$ 号点出发,最后回到 $1$ 号点,要求走了 **恰好** 为 $T$ 天。 每经过一 ......

2020年12月英语六级翻译真题参考答案(3套)

2020年12月英语六级翻译真题参考答案(3套) 河北文都考研 微信公众号:考研EDU 1 人赞同了该文章 来源:文都教育 六级翻译(一) 港珠澳大桥( Hong Kong- Zhuhai-Macau Bridge)全长55公里,是我国一项不同寻常的工程壮举。大桥将三个城市连接起来,是世界上最长的跨 ......

[NPUCTF2020]Baby Obfuscation

## [NPUCTF2020]Baby Obfuscation 将该文件使用ida打开并直接查看main()函数  2020/11/6 上午: 书包里装了7瓶水+一堆零食,补了两道题,复习线段树合并,KMP和AC自动机,然后看之前的总结划水 下午: 复习了一下数论相关,家里人在外面,不能给教练发健康码,心态挺崩的,幸好他们及时 ......

聊聊Transformer和GPT模型

本文基于《生成式人工智能》一书阅读摘要。感兴趣的可以去看看原文。 可以说,Transformer已经成为深度学习和深度神经网络技术进步的最亮眼成果之一。Transformer能够催生出像ChatGPT这样的最新人工智能应用成果。 ## 序列到序列(seq2seq) Transformer能实现的核心 ......

洛谷 P6620 [省选联考 2020 A 卷] 组合数问题

## 前置知识 ### 二项式定理 $$ (x + y)^n = \sum_{i = 0}^n \binom nix^iy^{n - i} $$ ### 组合恒等式 $$ k \times \binom nk = n \times \binom{n - 1}{k - 1} $$ ## 题解 先不管取 ......

Apache Flink目录遍历漏洞复现CVE-2020-17519

# Apache Flink目录遍历漏洞复现CVE-2020-17519 ## 前置知识 `Apache Flink:` > Apache Flink 是一个框架和分布式处理引擎,用于在*无边界和有边界*数据流上进行有状态的计算。Flink 能在所有常见集群环境中运行,并能以内存速度和任意规模进行计 ......

[机器学习]对transformer使用padding mask

注:本文是对GPT4的回答的整理校正补充。 在处理序列数据时,由于不同的序列可能具有不同的长度,我们经常需要对较短的序列进行填充(padding)以使它们具有相同的长度。但是,在模型的计算过程中,这些填充值是没有实际意义的,因此我们需要一种方法来确保模型在其计算中忽略这些填充值。这就是padding ......

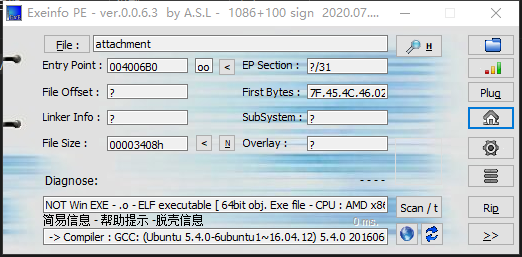

[WUSTCTF2020]level3

#查壳  ##64位下的ubuntu程序可以跑也可以进IDA(因为是练习,就不跑了,有兴趣的小伙伴可以跑跑) ## ......