信件

采集北京市政百姓信件内容的具体步骤

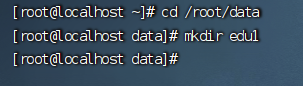

# 1、新建一个能够存储数据的文件夹  : url = url.format(page) request = urllib.request.Request(url, headers=headers) response = urllib.request.u ......

北京市政百姓信件可视化展示

这是原网站:https://www.beijing.gov.cn/hudong/hdjl/com.web.search.mailList.flow 点击查询后我们可以看到其中的相应信息,{page: {pageNo:'1', totalCount:'809', totalPages:'135', p ......

Python多协程异步爬取北京市政信件

采用单线程+多协程的方式爬取 import asyncio import json import re import aiofiles import requests from letter import Letter from bs4 import BeautifulSoup import os ......

WebMagic爬取北京市政信件内容

我采用创建了Letter类用来储存信件,重写了LetterFilePipeline使得爬取保存的文件名为信件Id,采用了多线程爬取,最后保存到letters目录下 Letter package org.example.crawler_letter; import lombok.AllArgsCons ......

北京市政百姓信件分析实战

[toc] # 北京市政百姓信件分析实战 ## 1.爬虫 ```python import json import requests import demjson from bs4 import BeautifulSoup import jieba import jieba.analyse as a ......

使用requests和BeautifulSoup对北京市政百姓信件进行爬取

一开始爬取的时候,没有加上请求头,所有导致会出现创宇盾进行防护,加上请求头即可 还有问题就是,这个网址的页号和网址是无关的,所以采用网上说的改变url来改变页号进行爬取是不可行的,使用 for page in range(start_page, end_page + 1): url = url.fo ......

北京市政百姓信件分析--数据清洗

-- 建表create table xingfang( kind string, `time` string, processingDepartment string, content string)row format delimited fields terminated by ','; -- ......

北京市政百姓信件分析---热词云以及存储关系图谱

使用neo4j数据库进行存储关系的展示 热词云 import json import matplotlib.pyplot as plt import re import jieba from py2neo import Graph,Node,Relationship,NodeMatcher from ......

北京市政百姓信件分析---使用selenium爬取信件信息

下载selenium 使用管理员打开cmd' pip install selenium 查看版本 pip show selenium 下载 WebDriver 驱动 谷歌浏览器 chromedrive:http://chromedriver.storage.googleapis.com/index. ......

一、 采集北京市政百姓信件内容

## letter.py ```python import scrapy from scrapy.linkextractors import LinkExtractor from scrapy.spiders import CrawlSpider, Rule from letterBeijing.i ......