CrawlSpider

scrapy中的CrawlSpider

CrawlSpider爬虫的创建 1. 创建项目 scrapy startproject 项目名例如:scrapy startproject circ 2. 创建CrawlSpider 爬虫 scrapy genspider -t crawl 爬虫名 网站名例如:scrapy genspider - ......

.CrawlSpider读书网练习

1.创建项目:scrapy startproject dushuproject 2.跳转到spiders路径 cd\dushuproject\dushuproject\spiders 3.创建爬虫类:scrapy genspider read www.dushu.com import scrapy ......

Scrapy-CrawlSpider爬虫类使用案例

CrawlSpider类型的爬虫会根据指定的rules规则自动找到url比自动爬取。 优点:适合整站爬取,自动翻页爬取 缺点:比较难以通过meta传参,只适合一个页面就能拿完数据的。 ```Python import scrapy from scrapy.http import HtmlRespon ......

Scrapy 中 CrawlSpider 使用(二)

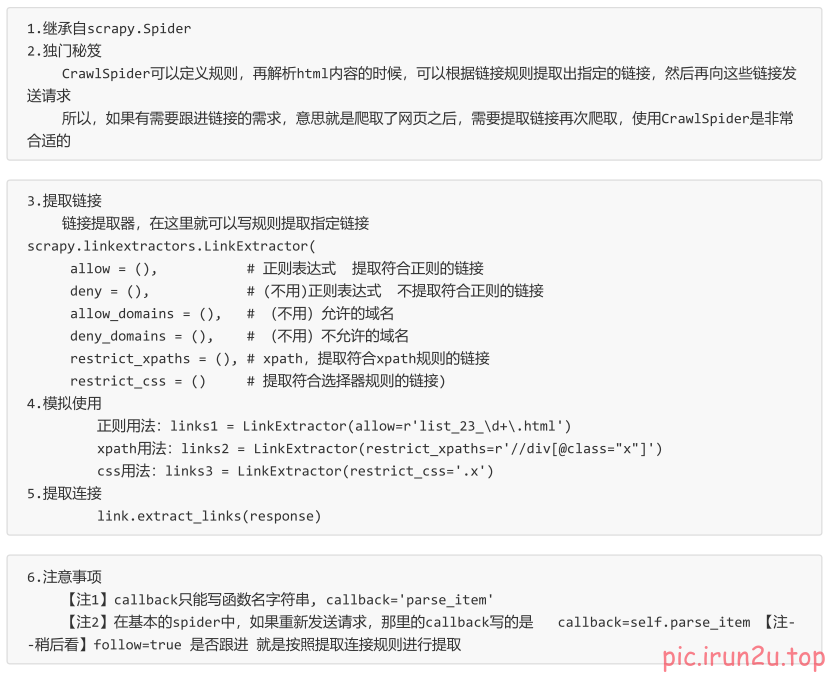

LinkExtractor提取链接 创建爬虫 scrapy genspider 爬虫名 域名 -t crawl spider from scrapy.linkextractors import LinkExtractor from scrapy.spiders import CrawlSpider, ......

Scrapy 中 CrawlSpider 使用(一)

创建CrawlSpider scrapy genspider -t crawl 爬虫名 (allowed_url) Rule对象 Rule类与CrawlSpider类都位于scrapy.contrib.spiders模块中 class scrapy.contrib.spiders.Rule( lin ......

scrapy:CrawlSpider及其案例

# 1. CrawSpider介绍  运行原理:

Scrapy框架之全站爬虫(CrawlSpider) 在之前 Scrapy 的基本使用当中,spider 如果要重新发送请求的话,就需要自己解析页面,然后发送请求。 而 CrawlSpider 则可以通过设置 url 条件自动发送请求。 LinkExtractors CrawlSpider 是 Sp ......