Paimon

聊聊流式数据湖Paimon(五)

从Demo入手,了解Paimon/Flink项目搭建的全过程。记录下采坑之旅。 创建Flink项目 在IDEA中创建Flink项目,由于没有Flink的archetype,因此需要手动创建一下。 参考:idea快速创建flink项目,至此Flink的项目框架就搭建起来了。 注意:必须注释掉pom文件 ......

聊聊流式数据湖Paimon(四)

Partial Update 数据打宽 通过不同的流写不同的字段,打宽了数据的维度,填充了数据内容;如下所示: --FlinkSQL参数设置 set `table.dynamic-table-options.enabled` = `true`; SET `env.state.backend` = ` ......

聊聊流式数据湖Paimon(三)

概述 如果表没有定义主键,则默认情况下它是仅追加 表类型(Append Only Table)。 根据桶(Bucket)的定义,我们有两种不同的仅追加模式:"Append For Scalable Table"和"Append For Queue";两种模式支持不同的场景,提供不同的功能。 只能向表 ......

聊聊流式数据湖Paimon(二)

当前的问题 Apache Paimon 最典型的场景是解决了 CDC (Change Data Capture) 数据的入湖;CDC 数据来自数据库。一般来说,分析需求是不会直接查询数据库的。 容易对业务造成影响,一般分析需求会查询全表,这可能导致数据库负载过高,影响业务 分析性能不太好,业务数据库 ......

聊聊流式数据湖Paimon(一)

翻译自 Apache Paimon官方文档 概览 概述 Apache Paimon (incubating) 是一项流式数据湖存储技术,可以为用户提供高吞吐、低延迟的数据摄入、流式订阅以及实时查询能力。 简单来说,Paimon的上游是各个CDC,即changlog数据流;而其自身支持实时sink与s ......

理解 Paimon changelog producer

介绍 目的 Chaneglog producer 的主要目的是为了在 Paimon 表上产生流读的 changelog, 所以如果只是批读的表是可以不用设置 Chaneglog producer 的. 一般对于数据库如 MySQL 来说, 当执行的语句涉及数据的修改例如插入、更新、删除时,MySQL ......

kafka数据入paimon(flink-sql)

1.创建CATALOG CREATE CATALOG paimon_hive WITH ( 'type' = 'paimon', 'metastore' = 'hive', 'uri' = 'thrift://hadoopm111:9083', 'warehouse' = 'hdfs:///apps ......

Apache Paimon流式湖仓学习交流群成立

Apache Paimon是一个流式数据湖平台。致力于构建一个实时、高效的流式数据湖平台。这个项目采用了先进的流式计算技术,使企业能够实时处理和分析大量数据。Apache Paimon 的核心优势在于它对于大数据生态系统中流式处理的支持,尤其是在高并发和低延迟方面表现出色。 目前业界主流数据湖存储格 ......

[题解]CFgym103470E Paimon Segment Tree

Paimon Segment Tree 区间加,求一段时间内的区间平方和。 \(n, m, q \le 5 \times 10^4\)。 对时间维差分一下,变成询问区间历史平方和。 离线下来扫描线,扫描线维护时间维,数据结构维护序列维。 考虑维护二元组 \((a, s)\) 表示当前位置值为 \(a ......

apache-paimon初体验 (hive用法待完善)

1.官网 https://paimon.apache.org/docs/master/engines/hive/ 2.安装flink 3.下载依赖包到flink lib目录下 4.运行yarnsession 创建Application-Name,并修改配置文件 ./bin/yarn-session. ......

新一代开源流数据湖平台Apache Paimon入门实操-下

上一篇对Apache Paimon有了基础了解,本身则主要通过实操方式进一步加深理解,具备沉淀后续投入使用的基础知识;进行数据插入和更新操作,基于批和流式多种查询方式如时间旅行和增量查询,并了解相关系统表的查看,最后MySQL和基于Kafka(通过Canal对MySQL数据库实现变更捕获)的CDC集... ......

「GYM103470G」Paimon's Tree

树上区间dp。 由于dp转移跟左右端点有关,考虑怎样转移端点。 左右端点只有被染色了才能被转移,那就多记个两维,表示左右端点是否已经被染色就好了。 $dp_{u,v,t,0/1,0/1}$ 表示左右端点 $u$,$v$ 当前已经染了 $t$ 个点,左右端点染色四种情况的路径长度。 ```cpp #i ......

新一代开源流数据湖平台Apache Paimon入门实操-上

本篇介绍一个强大的流数据湖平台,Flink官方开创,发展速度迅速,先了解其基本定义、适用场景和原理,然后基于yarn方式部署和测试,最后通过Catalog管理、创建表和修改多个示例了解基本使用 ......

Apache Paimon

Apache Paimon (incubating) 是一项流式数据湖存储技术,可以为用户提供高吞吐、低延迟的数据摄入、流式订阅以及实时查询能力。Paimon 采用开放的数据格式和技术理念,可以与 Apache Flink / Spark / Trino 等诸多业界主流计算引擎进行对接,共同推进 S ......

Paimon Compaction实现

Compact主要涉及以下几个组件 - CompactManager 管理Compact task - CompactRewriter 用于compact过程中数据的重写实现, 比如compact过程中产生changelog等 - CompactStrategy 决定哪些文件需要被compact # ......

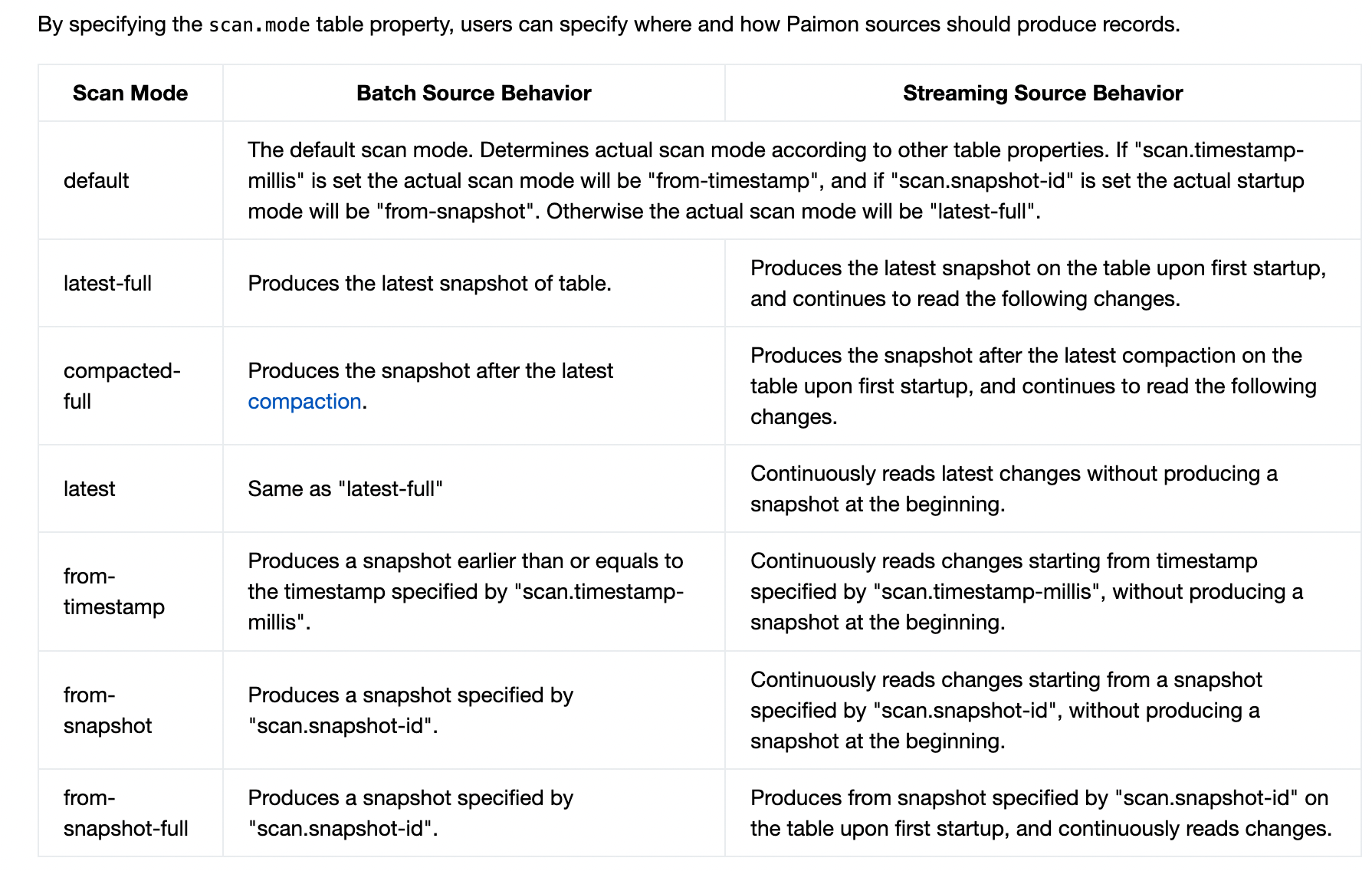

Paimon读取流程

# 查询模式 先来看看官网关于Paimon查询模式的说明  ![image.png](https:/ ......

Paimon的写入流程

> 基于Paimon 0.5版本 写入流程的构建`org.apache.paimon.flink.sink.FlinkSinkBuilder#build` 算子的流向 BucketingStreamPartitioner 分区 -> RowDataStoreWriteOperator 写入 -> C ......