chatGLM2

记Linux跑ChatGLM2的坑

记录一下踩过的坑… 0. 环境配置: 全程国内网 Ubuntu 20.04 with Python 3.8 and CUDA 12.2 RTX3060 Laptop (6G) 1. ChatGLM的下载: # clone 仓库 git clone https://gitclone.com/githu ......

ChatGLM2-6B模型的微调

概述 GLM模型底层还是基于Transformer,因此其设计、优化都是围绕Transformer的各个组件的。从注意力层的掩码、位置编码等方面优化与设计。 ChatGLM3/ChatGLM2的源码中,比如finetune、trainer等代码,其实是copy自HuggingFace,而且其使用流程 ......

ChatGLM2 源码解析:`ChatGLMTokenizer`

import os import torch from typing import List, Optional, Union, Dict from sentencepiece import SentencePieceProcessor from transformers import PreTra ......

使用单卡v100 32g或更低显存的卡,使用peft工具qlora或lora混合精度训练大模型chatGLM2-6b,torch混合精度加速稳定训练,解决qlora loss变成nan的问题!

最近新换了工作,以后的工作内容会和大模型相关,所以先抽空跑了一下chatGLM2-6b的demo,使用Qlora或lora微调模型 今天简单写个文档记录一下,顺便也是一个简单的教程,并且踩了qlora loss变成nan训练不稳定的问题 本教程并没有写lora的原理,需要的话自行查阅 1.chatG ......

python 部署chatglm2b

下载模型实现 然后手动下载模型 GIT_LFS_SKIP_SMUDGE=1 git clone https://huggingface.co/THUDM/chatglm2-6b cd ChatGLM2-6B mkdir modelsglm && cd modelsglm vim downs.py # ......

LLM探索:为ChatGLM2的gRPC后端增加连续对话功能

前言 之前我做 AIHub 的时候通过 gRPC 的方式接入了 ChatGLM 等开源大模型,对于大模型这块我搞了个 StarAI 框架,相当于简化版的 langchain ,可以比较方便的把各种大模型和相关配套组合在一起使用。 主要思路还是用的 OpenAI 接口的那套,降低学习成本,但之前为了快 ......

基于 P-Tuning v2 进行 ChatGLM2-6B 微调实践

微调类型简介 1. SFT监督微调:适用于在源任务中具有较高性能的模型进行微调,学习率较小。常见任务包括中文实体识别、语言模型训练、UIE模型微调。优点是可以快速适应目标任务,但缺点是可能需要较长的训练时间和大量数据。 2. LoRA微调:通过高阶矩阵秩的分解减少微调参数量,不改变预训练模型参数,新 ......

Langchain-Chatchat项目:1.1-ChatGLM2项目整体介绍

ChatGLM2-6B是开源中英双语对话模型ChatGLM-6B的第2代版本,引入新的特性包括更长的上下文(基于FlashAttention技术,将基座模型的上下文长度由ChatGLM-6B的2K扩展到了32K,并在对话阶段使用8K的上下文长度训练);更高效的推理(基于Multi-QueryAtte ......

ChatGLM2

下载chatglm2-6b print('开始加载分词器tokenizer...') tokenizer = AutoTokenizer.from_pretrained("THUDM/chatglm2-6b", trust_remote_code=True) print('开始加载语言模型model ......

使用Triton部署chatglm2-6b模型

一、技术介绍 NVIDIA Triton Inference Server是一个针对CPU和GPU进行优化的云端和推理的解决方案。 支持的模型类型包括TensorRT、TensorFlow、PyTorch(meta-llama/Llama-2-7b)、Python(chatglm)、ONNX Run ......

16G内存+CPU本地部署ChatGLM2/Baichuan2推理(Windows/Mac/Linux)

概述 本文使用chatglm.cpp对中文大语言模型(LLM)进行量化与推理,支持ChatGLM2-6B、Baichuan2-13B-Chat等模型在CPU环境16G内存的个人电脑上部署,实现类似ChatGPT的聊天功能。支持的操作系统包括Windows、Mac OS、Linux等。 其中,量化过程 ......

chatglm2-6b在P40上做LORA微调

目前,大模型的技术应用已经遍地开花。最快的应用方式无非是利用自有垂直领域的数据进行模型微调。chatglm2-6b在国内开源的大模型上,效果比较突出。本文章分享的内容是用chatglm2-6b模型在集团EA的P40机器上进行垂直领域的LORA微调。 ......

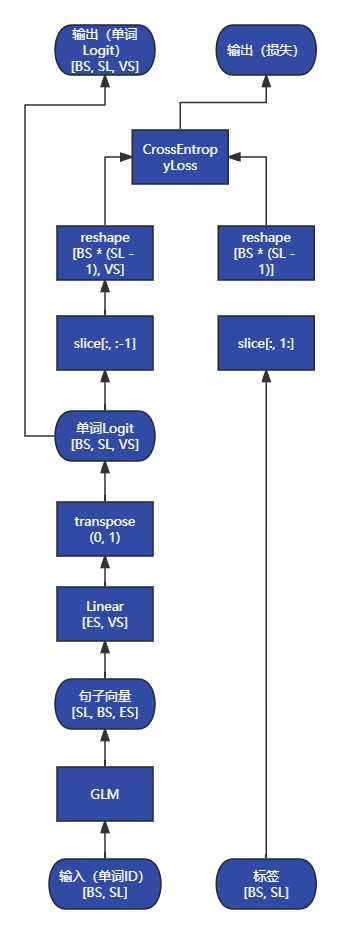

ChatGLM2 源码解析:`ChatGLMForConditionalGeneration.forward`

```py class ChatGLMForConditionalGeneration(ChatGLMPreTr ......

ChatGLM2 源码解析:`ChatGLMModel`

```py # 完整的 GLM 模型,包括嵌入层、编码器、输出层 class ChatGLMModel(ChatG ......

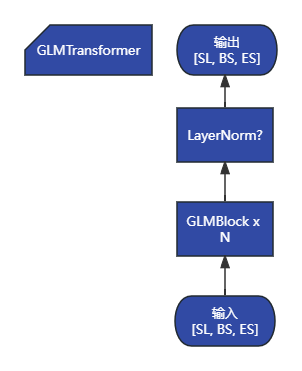

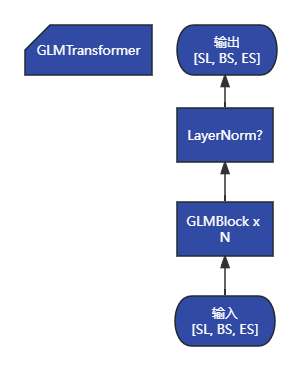

ChatGLM2 源码解析:`GLMTransformer`

```py # 编码器模块,包含所有 GLM 块 class GLMTransformer(torch.nn.Mo ......

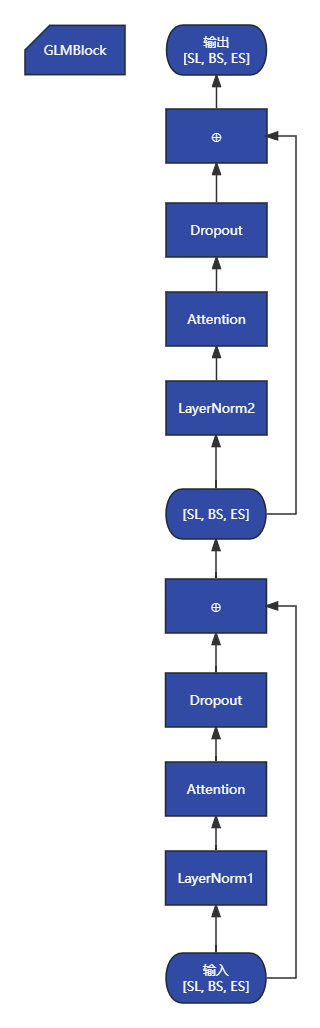

ChatGLM2 源码解析:`GLMBlock`

```py # GLM 块包括注意力层、FFN层和之间的残差 class GLMBlock(torch.nn.Mo ......

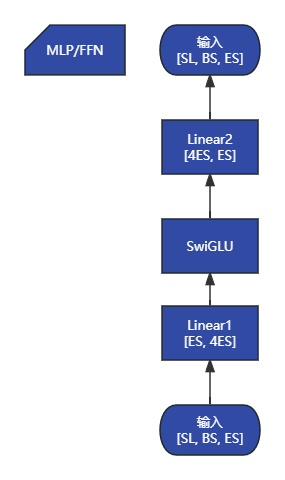

ChatGLM2 源码解析:`MLP`

```py class MLP(torch.nn.Module): """MLP. MLP will take ......

利用text-generation-webui快速搭建chatGLM2-6b/LLAMA2-7B-chat大模型运行环境

text-generation-webui 是一个基于Gradio的LLM Web UI开源项目,可以利用其快速搭建各种文本生成的大模型环境。 一、安装 text-generation-webui的readme其实已写得相当详细了,这里就不再重复,只说1个可能存在的坑: 安装 peft 安装卡住 r ......

chatglm2-6b模型在9n-triton中部署并集成至langchain实践

本文将介绍我利用集团9n-triton工具部署ChatGLM2-6B过程中踩过的一些坑,希望可以为有部署需求的同学提供一些帮助。 ......

CentOS7 上安装部署chatglm2-6b

按照说明文档,先按照了最新版本的Python,官网下载了最新的版本3.11后,一顿操作感觉分分钟就安装完了。 但是继续安装chatglm2-6b 所需的依赖包时,就遇到了N多坑点,为了解决这些坑点,耗时真的很长(按周计算的那种)。 第一个坑点:安装Python时,没有带SSL: 解决办法:详细可以参 ......

ChatGLM2-6B 微调改变AI自我认知

一、前言 上篇说到ChatGLM2-6B及百川大模型的本地部署实战,实际商业项目中可能还需要在此基础上对模型进行相关微调再进行应用。本篇文章带大家微调入门教学。 注意:当前为AI技术高速发展期,技术更新迭代快,本文章仅代表作者2023年8月的观点。 上篇文章:ChatGLM2-6B清华开源本地部署 ......

ChatGLM2-6B清华开源本地部署

一、前言 随着科技的不断发展,人工智能作为一项新兴技术,已逐渐渗透到各行各业。 AI 技术发展迅速、竞争激烈,需要保持对新技术的关注和学习。 ChatGPT的强大无需多说,各种因素国内无法商用,本文仅探讨:ChatGLM2 、百川13B大模型。两者都可以免费本地部署和商用。 ChatGLM官网体验地 ......

使用阿里云微调chatglm2

完整的代码可以参考:https://files.cnblogs.com/files/lijiale/chatglm2-6b.zip?t=1691571940&download=true ```python # %% [markdown] # # 微调前 # %% model_path = "/mnt ......

在矩池云使用ChatGLM-6B & ChatGLM2-6B

ChatGLM-6B 和 ChatGLM2-6B都是基于 General Language Model (GLM) 架构的对话语言模型,是清华大学 KEG 实验室和智谱 AI 公司于 2023 年共同发布的语言模型。模型有 62 亿参数,一经发布便受到了开源社区的欢迎,在中文语义理解和对话生成上有着 ......

阿里云部署 ChatGLM2-6B 与 langchain+chatGLM

# 1.ChatGLM2-6B 部署 - 更新系统 ``` apt-get update ``` - 安装git ``` apt-get install git-lfs git init git lfs install ``` - 克隆 ChatGLM2-6B 源码 ``` git clone ht ......

ubuntu上搭建ChatGLM2-6b环境及ptuing微调训练的坑

清华大学的chatGLM2-6B可以说是目前亚洲唯一能打的对中文支持不错的LLM大模型,网上已经有很多介绍如何在本机搭建环境的文章,就不再重复了,这里记录下最近踩的一些坑: 1、为啥要使用ubuntu? chatGLM2-6b项目里有很多.sh文件,在windows下要正常运行通常要折腾一番,最后能 ......

生成式人工智能体验[2]-ChatGLM2

## 摘要 在macOS(Apple Silicon M2)上运行ChatGLM2-6B大模型. ## ChatGLM2 在线体验(需要审核,手机收个验证码很快就通过了)[https://chatglm.cn] [https://github.com/THUDM/ChatGLM2-6B] [http ......

阿里云部署langchain+chatglm2-6b大模型

[https://mp.weixin.qq.com/s/uvKQUeL6bf2eNwKOLk7c0w](https://mp.weixin.qq.com/s/uvKQUeL6bf2eNwKOLk7c0w) * 基本上参考这篇文章就ok * 需要注意的点 1. git-lfs的安装 https://g ......

LangChain+ChatGLM2-6B搭建知识库

ChatGLM2-6B 介绍 ChatGLM2-6B 在保留了初代模型对话流畅、部署门槛较低等众多优秀特性的基础之上,引入了如下新特性: • 更强大的性能:基于 ChatGLM 初代模型的开发经验,全面升级了基座模型。ChatGLM2-6B 使用了 GLM 的混合目标函数,经过了 1.4T 中英标识 ......

ChatGLM2 部署全过程每一步超详细

打开autodl,创建实例Tesla T4 * 1卡使用miniconda镜像。 ## 方法一:从huggingface下载 这个步骤不稳定我们换种下载方式 ```bash apt-get update apt install git-lfs git lfs install git clone ht ......