前言

DP 与 DDP 均为GPU并行手段,目的是加快训练。

DP (Data parallelism)

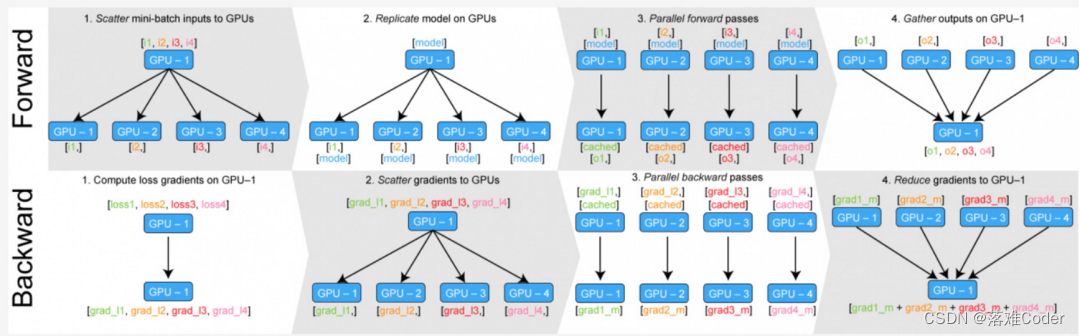

如上图所示:DP其实只开了一个线程,并行算法实在多个设备上都拷贝了一份完整的模型参数,彼此之间可以独立计算。所以叫数据并行

- 前向传播时,GPU-1 会首先把所有的数据拿到,然后分发给其他的GPU和自己,模型也拷贝4份给其他的GPU,每个GPU跑完自己的前向传播,跑完后将输出一起传给GPU-1

- 反向传播时,GPU-1 处理完所有的梯度后,将要反向传播的梯度分配给其他的GPU,然后其他的GPU又各自进行自己的反向计算,计算完后将最后的梯度交给GPU-1进行更新

DDP (Distributed Data Parallel) 支持多机多卡分布式训练

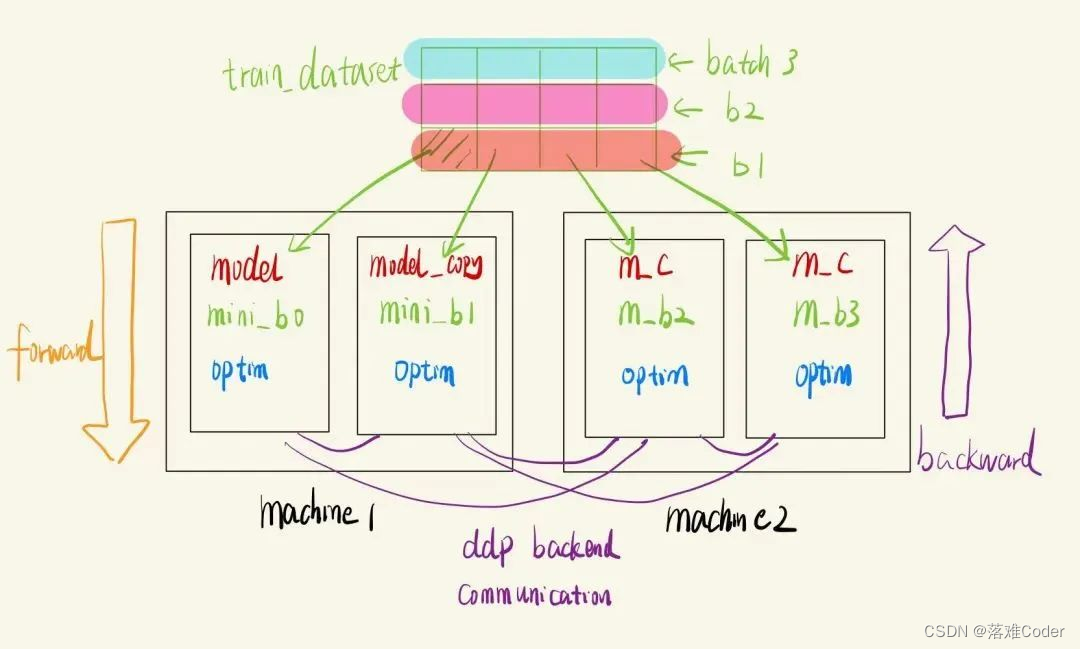

DDP是PyTorch中的一种模型并行方式。DDP使用multiprocessing为每个GPU创建一个进程,避免了Python解释器的GIL导致的性能开销。如上图:每个机器上都有两个GPU,每个GPU上都有一份模型,每次来一个batch的数据,都会让Distributed sampler去将数据分配好发给指定的GPU,然后每个GPU自己跑自己的,跑完前向和后向传播后,每个GPU通过DDP的后端通信可以知道其他GPU跑的结果,同步所有GPU的梯度,拿到所有信息后自己去反向传播更新梯度。

DDP相关概念

- rank: 用于表示进程的编号/序号(在一些结构图中rank指的是软节点,rank可以看成一个计算单位),每一个进程对应了一个rank的进程,整个分布式由许多rank完成。

- node: 物理节点,可以是一台机器也可以是一个容器,节点内部可以有多个GPU。

- rank 与 local_rank: rank是指在整个分布式任务中进程的序号;local_rank是指在一个node上进程的相对序号,local_rank在node之间相互独立。(注意:在代码中,会使用local_rank来指定GPU,并且local_rank和实际的gpu编号存在映射关系,比如,指定gpu 4,5进行训练,local_rank仍然是0,1,但前提是要先设置os.environ['CUDA_VISIBLE_DEVICES'] = "4,5")。

- nnodes、node_rank与nproc_per_node: nnodes是指物理节点数量,node_rank是物理节点的序号;nproc_per_node是指每个物理节点上面进程的数量。

- word size: 全局(一个分布式任务)中,rank的数量。

每个node包含16个GPU,且nproc_per_node=8,nnodes=3,机器的node_rank=5,请问word_size是多少?

答案:word_size = 3*8 = 24

代码示例

- 单GPU代码

## main.py文件

import torch

# 构造模型

model = nn.Linear(10, 10).to(local_rank)

# 前向传播

outputs = model(torch.randn(20, 10).to(rank))

labels = torch.randn(20, 10).to(rank)

loss_fn = nn.MSELoss()

loss_fn(outputs, labels).backward()

# 后向传播

optimizer = optim.SGD(model.parameters(), lr=0.001)

optimizer.step()

## Bash运行

python main.py

- DDP代码

################

## main.py文件

import argparse

from tqdm import tqdm

import torch

import torchvision

import torch.nn as nn

import torch.nn.functional as F

# 新增:

import torch.distributed as dist

from torch.nn.parallel import DistributedDataParallel as DDP

### 1. 基础模块 ###

# 假设我们的模型是这个,与DDP无关

class ToyModel(nn.Module):

def __init__(self):

super(ToyModel, self).__init__()

self.conv1 = nn.Conv2d(3, 6, 5)

self.pool = nn.MaxPool2d(2, 2)

self.conv2 = nn.Conv2d(6, 16, 5)

self.fc1 = nn.Linear(16 * 5 * 5, 120)

self.fc2 = nn.Linear(120, 84)

self.fc3 = nn.Linear(84, 10)

def forward(self, x):

x = self.pool(F.relu(self.conv1(x)))

x = self.pool(F.relu(self.conv2(x)))

x = x.view(-1, 16 * 5 * 5)

x = F.relu(self.fc1(x))

x = F.relu(self.fc2(x))

x = self.fc3(x)

return x

# 假设我们的数据是这个

def get_dataset():

transform = torchvision.transforms.Compose([

torchvision.transforms.ToTensor(),

torchvision.transforms.Normalize((0.5, 0.5, 0.5), (0.5, 0.5, 0.5))

])

my_trainset = torchvision.datasets.CIFAR10(root='./data', train=True,

download=True, transform=transform)

# DDP:使用DistributedSampler,DDP帮我们把细节都封装起来了。

# 用,就完事儿!sampler的原理,第二篇中有介绍。

train_sampler = torch.utils.data.distributed.DistributedSampler(my_trainset)

# DDP:需要注意的是,这里的batch_size指的是每个进程下的batch_size。

# 也就是说,总batch_size是这里的batch_size再乘以并行数(world_size)。

trainloader = torch.utils.data.DataLoader(my_trainset,

batch_size=16, num_workers=2, sampler=train_sampler)

return trainloader

### 2. 初始化我们的模型、数据、各种配置 ####

# DDP:从外部得到local_rank参数

parser = argparse.ArgumentParser()

parser.add_argument("--local_rank", default=-1, type=int)

FLAGS = parser.parse_args()

local_rank = FLAGS.local_rank

# DDP:DDP backend初始化

torch.cuda.set_device(local_rank)

dist.init_process_group(backend='nccl') # nccl是GPU设备上最快、最推荐的后端

# 准备数据,要在DDP初始化之后进行

trainloader = get_dataset()

# 构造模型

model = ToyModel().to(local_rank)

# DDP: Load模型要在构造DDP模型之前,且只需要在master上加载就行了。

ckpt_path = None

if dist.get_rank() == 0 and ckpt_path is not None:

model.load_state_dict(torch.load(ckpt_path))

# DDP: 构造DDP model

model = DDP(model, device_ids=[local_rank], output_device=local_rank)

# DDP: 要在构造DDP model之后,才能用model初始化optimizer。

optimizer = torch.optim.SGD(model.parameters(), lr=0.001)

# 假设我们的loss是这个

loss_func = nn.CrossEntropyLoss().to(local_rank)

### 3. 网络训练 ###

model.train()

iterator = tqdm(range(100))

for epoch in iterator:

# DDP:设置sampler的epoch,

# DistributedSampler需要这个来指定shuffle方式,

# 通过维持各个进程之间的相同随机数种子使不同进程能获得同样的shuffle效果。

trainloader.sampler.set_epoch(epoch)

# 后面这部分,则与原来完全一致了。

for data, label in trainloader:

data, label = data.to(local_rank), label.to(local_rank)

optimizer.zero_grad()

prediction = model(data)

loss = loss_func(prediction, label)

loss.backward()

iterator.desc = "loss = %0.3f" % loss

optimizer.step()

# DDP:

# 1. save模型的时候,和DP模式一样,有一个需要注意的点:保存的是model.module而不是model。

# 因为model其实是DDP model,参数是被`model=DDP(model)`包起来的。

# 2. 只需要在进程0上保存一次就行了,避免多次保存重复的东西。

if dist.get_rank() == 0:

torch.save(model.module.state_dict(), "%d.ckpt" % epoch)

################

## Bash运行

# DDP: 使用torch.distributed.launch启动DDP模式

# 使用CUDA_VISIBLE_DEVICES,来决定使用哪些GPU

# CUDA_VISIBLE_DEVICES="0,1" python -m torch.distributed.launch --nproc_per_node 2 main.py