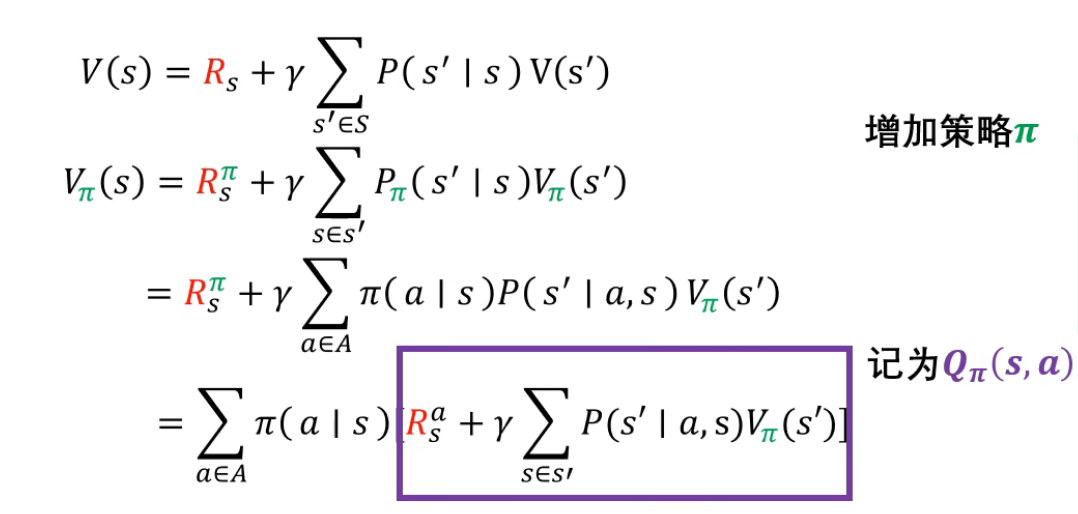

我第一次学贝尔曼方程的时候,是跟着一个大学教授博主,当时没有搞清楚VpaiS和Vs的区别,今天大概能理解了,那我讲一讲

先看Vs,就是他到达某个特定状态之后得到的奖励加上后面衰减常数乘上,一大串,一大串是什么呢,就是一个求和,求和的是什么呢,就是到达下一个状态的状态值(可以理解为预期奖励大小)乘上到达下一个状态的概率,类似于一个期望值

再看VpaiS,刚开始我只看到这个公式第一行,这是很抽象很难理解的,于是可以直接去看最后一行,有点恶心,求和嵌套求和,可以先不用那么复杂,可以先把最外面的求和符号拿掉方便理解,如果没有最后一行,我甚至不知道RpaiS是啥,它其实就是,状态S下,采用某个a(action)的概率乘上Rsa,就是在状态S下,采用a所得到的奖励,那么求和之后,就是你在状态S中,你做所有策略,就是你去行动,所有行动奖赏按比例分配的一个期望值,那么后面那一大串就是,你到达VpaiS'的一个pai型值乘上比例(到达的概率),也是一个求期望的方式

所以Vs可理解为,偏向结果

VpaiS更偏向过程action

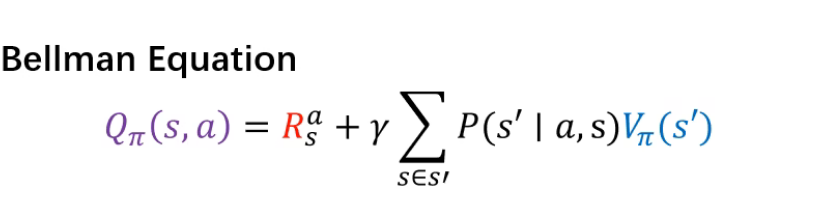

所以这个Qpai(Sa)与上面V(pai)的区别就是,上面的V(pai)是对所有的a(action)求期望,而Qpai(sa)是对某个特定的a进行分析,比如这个对Vpai(s')按照比例求期望,这个比例也是基于,action是某个特定的a