Spark

开发笔记-大数据技术栈-spark基础

Spark是一个快速、通用、可扩展的大数据分析引擎,是集批处理、实时流处理、交互式查询、机器学习与图计算为一体的大数据开源项目。 一、对比MapReduce 1.Hadoop中的job处理流程: 》从hdfs读取数据 》 在map阶段,执行mapper function,然后split到磁盘 》在r ......

Ubuntu部署Spark集群

## 前期准备 ### 系统及软件版本说明 本章操作中所使用的相关操作系统及软件版本如下: | 软件 | 版本 | | | | | 操作系统 | Ubuntu 14.04.1 | | JDK | 1.8.0 | | Hadoop | 2.7.3 | | Spark | 2.2.0 | ### JDK ......

CDC一键入湖:当 Apache Hudi DeltaStreamer 遇见 Serverless Spark

Apache Hudi的DeltaStreamer是一种以近实时方式摄取数据并写入Hudi表的工具类,它简化了流式数据入湖并存储为Hudi表的操作,自 `0.10.0` 版开始,Hudi又在DeltaStreamer的基础上增加了基于Debezium的CDC数据处理能力,这使得其可以直接将Debez ......

图解Spark Graphx基于connectedComponents函数实现连通图底层原理

原创/朱季谦 第一次写这么长的graphx源码解读,还是比较晦涩,有较多不足之处,争取改进。 ### 一 ......

图解Spark Graphx实现顶点关联邻接顶点的函数原理

## 一、场景案例 在一张社区网络里,可能需要查询出各个顶点邻接关联的顶点集合,类似查询某个人关系比较 ......

spark教程-1

# scala基本操作 ``` scala> val input=sc.textFile("C:\\Users\\gwj\\Desktop\\cont.txt") input: org.apache.spark.rdd.RDD[String] = C:\Users\gwj\Desktop\cont. ......

3.2.0 终极预告!云原生支持新增 Spark on k8S 支持

视频贡献者 | 王维饶 视频制作者 | 聂同学 编辑整理 | Debra Chen > Apache ......

8.21-8.27学习总结博客七:Spark机器学习与实时处理

博客题目:学习总结七:Spark机器学习与实时处理入门内容概要:学习使用Spark进行机器学习和实时数据处理的基本知识,了解Spark的机器学习库和实时处理框架。学习资源:推荐的Spark机器学习和实时处理教程、案例和学习资源。实践内容:通过编写Spark应用程序,实践使用Spark进行机器学习和实 ......

Spark任务提交到Yarn状态一直是Accepted

## 现象 今天提交 Spark 任务到 Yarn 集群,但是任务状态一直是 Accepted: ``` 23/08/25 14:59:55 INFO Client: Application report for application_1692971614101_0018 (state: ACCE ......

Hadoop 和 Spark 简介

# Hadoop 和 Spark 简介 Hadoop 是一个由 Apache 基金会所开发的分布式系统基础架构。用户可以在不了解分布式底层细节的情况下,开发分布式程序。充分利用集群的威力进行高速运算和存储。Hadoop 过去一直是大数据的经典解决方案,它包含两个部分:Hadoop HDFS 和 Ha ......

apache spark connect 试用

spark connect 3.4 开始就支持了connect 模式,3.4.1 比较稳定了 connect server 启动 实际上就是一个spark 引用,通过spark_submit 提交到spark 环境中 启动 ./sbin/start-connect-server.sh --packa ......

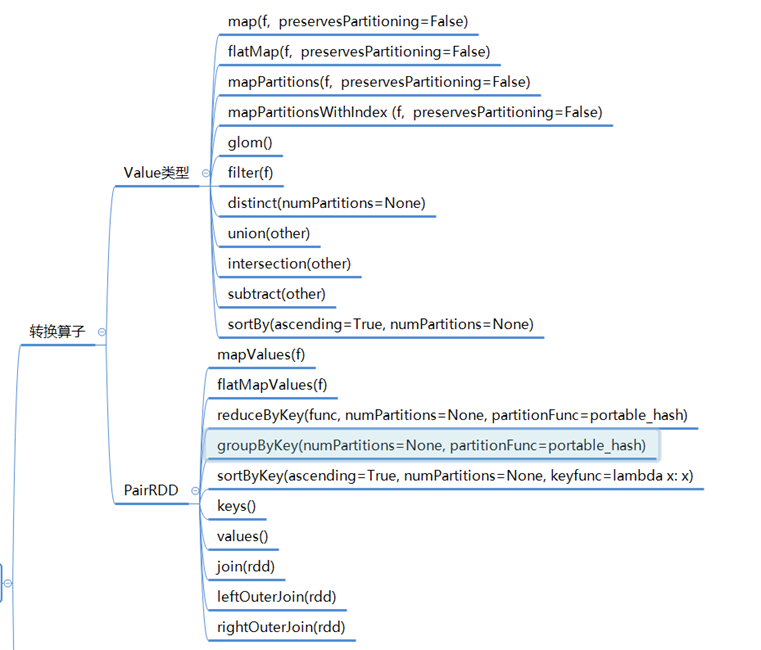

Spark RDD惰性计算的自主优化

原创/朱季谦 RDD(弹性分布式数据集)中的数据就如final定义一般,只可读而无法修改,若要对RDD进行转换或操作,那就需要创建一个新的RDD来保存结果。故而就需要用到转换和行动的算子。 Spark运行是惰性的,在RDD转换阶段,只会记录该转换逻辑而不会执行,只有在遇到行动算子时,才会触发真正的运 ......

spark on k8s 开发部署简单实践

实际上就是一个简单的实践,方便参考,对于开发以及运行,集成ci/cd 以及dophinscheduler 任务调度为了方便开发的spark 应用共享以及使用基于s3 进行文件存储(当然dophinscheduler 也是支持自己的资源库的) 参考图 玩法说明 基于gitlab 进行代码管理,通过ci ......

大数据技术Spark之RDD基础编程

# 大数据技术Spark之RDD基础编程 RDD(Resilient Distributed Dataset)叫做弹性分布式数据集,是 Spark 中最基本的数据 处理模型。代码中是一个抽象类,它代表一个弹性的、不可变、可分区、里面的元素可并行 计算的集合。 ### 一、RDD的两种创建方式 1. ......

Spark安装的配置相关步骤

# 1、Spark下载地址:https://archive.apache.org/dist/spark/ 选择自己适合的版本:  S ......

Spark异常总结

1、Spark读写同一张表报错问题Cannot overwrite a path that is also being read from 问题描述:Spark SQL在执行ORC和Parquet格式的文件解析时,默认使用Spark内置的解析器(Spark内置解析器效率更高),这些内置解析器不支持递 ......

spark中decode函数

decode函数 decode(bin, charset) - 使用第二个参数字符集解码第一个参数。 decode(expr, search, result [, search, result ] ... [, default]) - 解码比较 expr 对每个搜索值一一进行。如果 expr 等于搜 ......

spark3的bug

1.[SPARK-39936][SQL] Store schema in properties for Spark Views,spark视图保存到hive metastore时未清空tableschema导致解析失败 Hive DataType解析器主要发生在Hive的元数据存储(Hive Met ......

[42000][3] Error while processing statement: FAILED: Execution Error, return code 3 from org.apache.hadoop.hive.ql.exec.spark.SparkTask.

[42000][3] Error while processing statement: FAILED: Execution Error, return code 3 from org.apache.hadoop.hive.ql.exec.spark.SparkTask. Spark job fai ......

Spark概述

# Spark概述 ## 1.1认识Spark 背景:现有的计算框架有:批处理:MapReduce、Hive、Pig…,流式计算:Storm,交互式计算:Impala,Presto,但没有一种框架兼容以上所有的计算框架,spark应运而生 ### 1.1.1 Spark的发展 2009年由Berke ......

Spark编程

# Spark编程  ![image-2020042409271958 ......

Spark SQL

# Spark SQL ## 1.1Spark SQL简介 Spark SQL是一个用来处理结构化数据的Spark 组件。它可被视为一个分 布式的SQL查询引擎,并且提供了一个叫作DataFrame的可编程抽象数据模型。Spark SQL的前身是Shark,由于Shark需要依赖于Hive而制约了S ......

Spark提交程序到Yarn任务状态一直为Accepted

正在学习《Spark快速大数据分析》第七章-在集群上运行Spark,写了一个单词数量统计的Spark程序提及到Yarn,但是状态一直是Accepted,等待运行。 1、排查了Yarn资源调度器配置,配置的是公平配置,确认无问题 ```xml yarn.scheduler.fair.allocatio ......

spark社区bug

1.SPARK-26114repartitionAndSortWithinPartitions 后合并时 PartitionedPairBuffer 的内存泄漏 原因 这个Spark源码的issue描述了在使用coalesce操作合并分区时可能会导致PartitionedPairBuffer内存泄漏 ......

Spark安装(黑马程序员文档)

Spark Local环境部署 下载地址 Spark https://mirrors.tuna.tsinghua.edu.cn/apache/spark/spark-3.4.1/ Anaconda https://mirrors.tuna.tsinghua.edu.cn/anaconda/archi ......

Spark2.2快速入门

# 快速入门 通过 Spark 的交互式 shell 简单介绍一下 (Python 或 Scala) API,然后展示如何使用 Java、Scala 以及 Python 编写一个 Spark 应用程序。 >Spark 2.0 版本之前, Spark 的核心编程接口是弹性分布式数据集(RDD)。Spa ......

spark dataset dataframe 动态添加列

>需求 利用SparkSQL计算每一行数据的数据质量,如果数据不为NULL或者不为空字符串(或者符合正则表达式),那么该字段该行数据积一分 >网上解决方案 https://blog.csdn.net/Code_LT/article/details/87719115 https://blog.csdn ......

关于spark写clickhouse出现 too many parts(300)错误的最佳解决方式

出现这个问题的根本原因是clickhouse插入速度超过clickhouse的文件合并速度(默认300) 解决方式如下 觉得好用记得点个关注或者赞哈 ......